Google verhoogt zijn bod op AI-hardwaredominantie. Donderdag kondigde het bedrijf aan dat zijn krachtigste aangepaste chip, de Ironwood TPU, nu algemeen beschikbaar komt voor zijn cloudklanten.

Deze nieuwe processor is gebouwd om aan de stijgende vraag naar AI-inferentie te voldoen en pakt de realtime werken achter chatbots. Ter ondersteuning van deze AI-systemen heeft Google ook nieuwe, kosteneffectieve Axion-processors gelanceerd voor dagelijkse computertaken.

Deze strategische zet is gericht op belangrijke klanten als Anthropic en verscherpt de uitdaging van Google aan marktleider Nvidia in de cruciale strijd om de AI-infrastructuur.

Ironwood: een op maat gemaakte siliciumkrachtpatser voor het tijdperk van inferentie

Om de volgende generatie AI-modellen aan te drijven, zet Google in op een verticaal geïntegreerd Het middelpunt van deze inspanning is de Tensor Processing Unit van de zevende generatie, Ironwood, die voor het eerst werd onthuld in april.

De chip wordt nu algemeen verkrijgbaar en is speciaal gebouwd voor wat Google het’tijdperk van inferentie’noemt, de verschuiving van het trainen van enorme modellen naar het inzetten ervan voor nuttige, responsieve interacties op schaal.

Ironwood levert een aanzienlijke prestatiesprong, ontworpen om te voldoen aan de complexe eisen van zowel training als het bedienen van de grootste AI van vandaag. modellen.

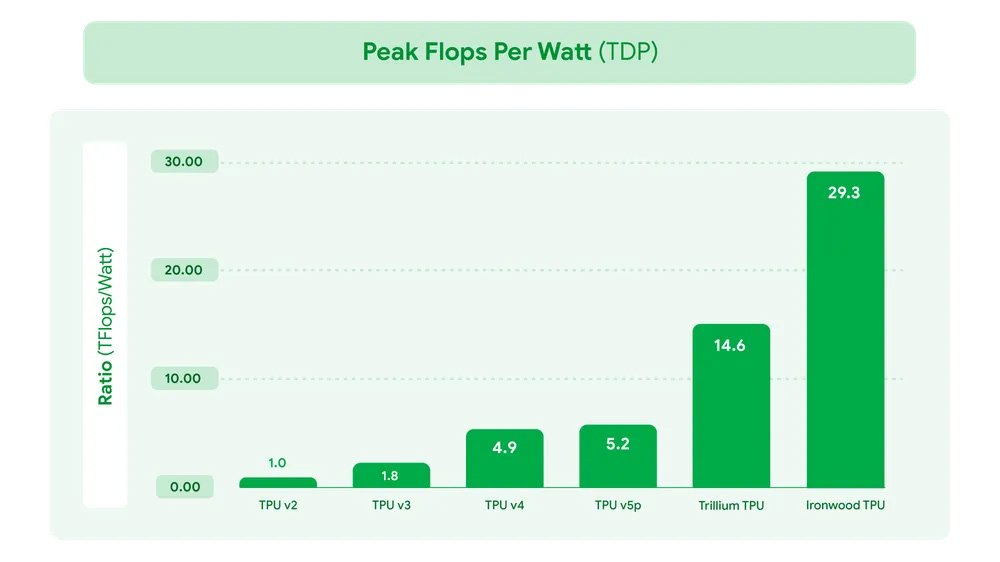

Volgens Google biedt de nieuwe architectuur een 10x piekprestatieverbetering ten opzichte van zijn TPU v5p-voorganger en meer dan vier keer betere prestaties per chip vergeleken met de vorige Trillium-generatie.

In de grootste configuratie kan een Ironwood-systeem maar liefst 42,5 exaFLOPS aan FP8-rekenkracht behalen, een maatstaf die essentieel is voor de laagnauwkeurige rekenkunde die moderne AI-workloads domineert.

Deze brute kracht gaat gepaard met een focus op efficiëntie; Ironwood beschikt over tweemaal de prestaties per watt van Trillium, waardoor het de meest energiezuinige chip van Google tot nu toe is.

Google TPU Peak Flops Per Watt (Bron: Google)

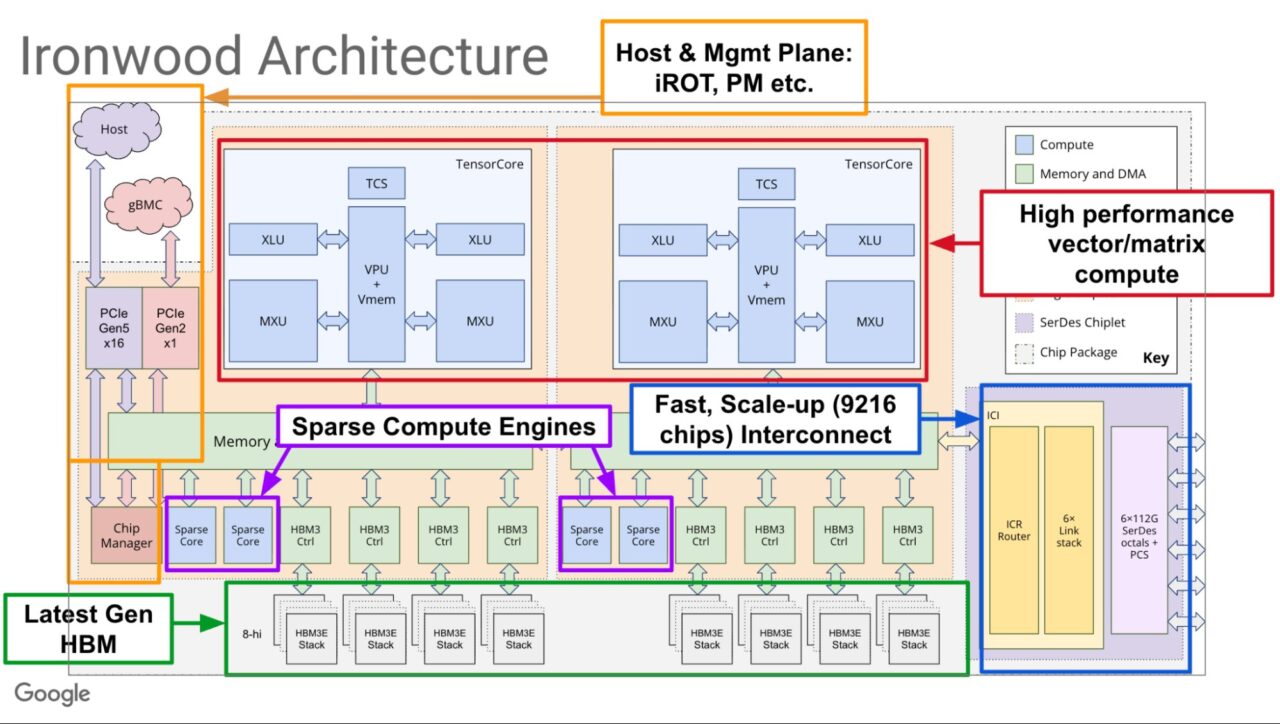

Dit prestatieniveau is alleen nuttig als het kan worden geschaald, en de architectuur van Ironwood is ontworpen voor een massieve, samenhangende werking.

Een enkele Ironwood’superpod’kan maximaal 9.216 individuele chips met elkaar verbinden, waardoor ze als één enkele, verenigde chip kunnen functioneren. supercomputer. De basis van dit systeem is een snelle Inter-Chip Interconnect (ICI)-structuur die tot 9,6 terabit per seconde aan bandbreedte tussen chips biedt, waardoor een dichte 3D Torus-topologie ontstaat.

Dit netwerk geeft de chips toegang tot een kolossale, gedeelde pool van 1,77 Petabytes aan High-Bandwidth Memory (HBM), waardoor de dataknelpunten worden geëlimineerd die grootschalige AI-taken kunnen verlammen.

Om verbinding te maken Voor deze clusters van chips maakt Google gebruik van een dynamisch Optical Circuit Switch (OCS)-netwerk. Deze herconfigureerbare structuur is de sleutel tot zowel schaal als veerkracht.

Zoals beschreven in het technische overzicht van het bedrijf, kan de OCS optisch alle falende hardware omzeilen en nieuwe, complete circuits tot stand brengen die alleen gezonde eenheden verbinden.

Google Ironwood TPU-architectuur (bron: Google)

Google Ironwood TPU-architectuur (bron: Google)

Voor klanten die trainingsopdrachten uitvoeren die weken kunnen duren, is deze dynamische fouttolerantie een cruciale functie die kostbare onderbrekingen voorkomt en de productieve uptime van het hele systeem maximaliseert.

Van cruciaal belang is dat deze geavanceerde hardware diep geïntegreerd is met een mede ontworpen softwarestack die is gebouwd op een filosofie van optimalisatie op systeemniveau. De kern is de Accelerated Linear Algebra (XLA)-compiler van Google, die code op hoog niveau van populaire frameworks zoals JAX en PyTorch vertaalt naar sterk geoptimaliseerde machine-instructies.

De compiler is expliciet ontworpen om zich te richten op de gespecialiseerde hardware van de TPU, inclusief de dichte Matrix Multiply Units (MXU’s) en Vector Processing Units (VPU’s). Door bewerkingen automatisch in efficiënte kernels samen te voegen, biedt XLA krachtige “out-of-the-box” prestaties.

Ter conclusie: het bedrijf heeft de stack verder geoptimaliseerd door het inschakelen van state-of-the-art services zoals vLLM op Ironwood via een nieuwe, uniforme backend, waardoor de enorme kracht ervan toegankelijker wordt voor ontwikkelaars die modellen in productie implementeren.

De hardware-push van Google is een onderdeel van een veel grotere, meervoudige infrastructuurstrategie.

In recente rapporten hebben we enkele ambitieuze plannen van Google belicht, van een geopolitiek strategisch AI-datacenter op het Australische Christmas Island tot het’moonshot’Project Suncatcher, dat tot doel heeft TPU-aangedreven datacenters in de ruimte te bouwen.

De initiatieven benadrukken de enorme middelen die nodig zijn om toonaangevend te blijven op het gebied van AI.

[embedded content]

De uitbreiding van Axion: een nieuwe definitie van rekenkracht voor algemeen gebruik

Naast de gespecialiseerde versnellers voor AI hebben moderne applicaties een krachtige en efficiënte ruggengraat nodig voor dagelijkse workloads.

Google pakt dit probleem aan met een uitbreiding van zijn aangepaste Arm-gebaseerde Axion CPU-portfolio. Het bedrijf heeft aangekondigd dat zijn nieuwe N4A virtuele machines nu in preview zijn, naast de komende preview van C4A metal, de eerste Arm-gebaseerde bare-metal instances.

Deze processors zijn ontworpen om superieure prijs-kwaliteitverhouding te leveren en voeren de algemene taken uit die AI-toepassingen ondersteunen, waaronder gegevensvoorbereiding, gecontaineriseerde microservices en webserving.

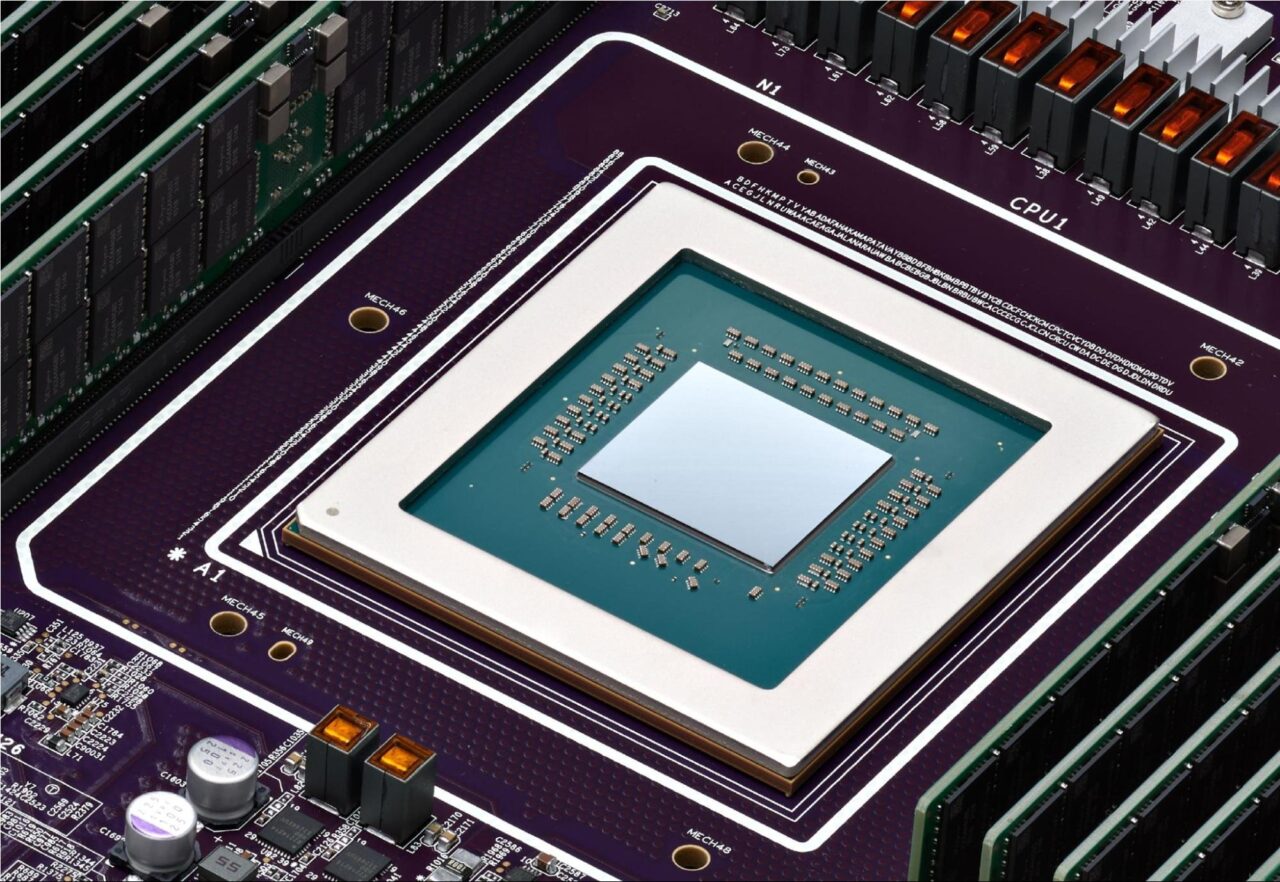

Google Axion CPU (bron: Google)

Google Axion CPU (bron: Google)

Eerste feedback van klanten wijst op aanzienlijke winsten. Sergei Koren, Chief Infrastructure Architect bij ZoomInfo, prees de nieuwe instances en zei:”In onze preview van de nieuwe N4A-instances hebben we een verbetering van de prijs-prestatieverhouding van 60% gemeten voor deze belangrijke workloads vergeleken met hun op x86 gebaseerde tegenhangers.”

Op dezelfde manier rapporteerde Vimeo een prestatieverbetering van 30% voor de kernworkload van videotranscodering in vergelijking met x86-gebaseerde VM’s.

Google positioneert Axion als een duidelijk en efficiënter alternatief voor traditionele processors.

Volgens Mark Lohmeyer, VP en GM van AI en computerinfrastructuur bij Google Cloud, “zullen ze 50% hogere prestaties leveren dan vergelijkbare processors van de x86-generatie en 60% betere energie-efficiëntie dan vergelijkbare x86-gebaseerde instances.”

Strategische adopties en de AI-wapenwedloop

De enorme inzet van Anthropic dient als een krachtige validatie voor het aangepaste silicium van Google. Het AI-lab, ontwikkelaar van de Claude-modellenfamilie, is van plan toegang te krijgen tot maximaal 1 miljoen TPU’s, wat een sterk vertrouwen aangeeft in de mogelijkheden van het platform voor zowel training als gevolgtrekking.

James Bradbury, Head of Compute van het bedrijf, legde het voordeel uit:”Ironwood’s verbeteringen in zowel de inferentieprestaties als de schaalbaarheid van trainingen zullen ons helpen efficiënt te schalen terwijl we de snelheid en betrouwbaarheid behouden die onze klanten verwachten.”

Toch bestaat deze belangrijke deal binnen een complexe, multi-cloud realiteit. Hoewel de samenwerking een belangrijke overwinning is voor Google, maken rapporten duidelijk dat Anthropic een gediversifieerde infrastructuurstrategie hanteert, waarbij Amazon Web Services zijn belangrijkste cloudprovider blijft.

Het weerspiegelt een bredere trend in de sector waarin grote AI-laboratoria de afhankelijkheid van één enkele leverancier vermijden, een strategie die eerder werd gezien toen OpenAI Google Cloud begon te gebruiken als aanvulling op de kerninfrastructuur van Microsoft Azure.

De op maat gemaakte siliciuminspanningen van Google, die zich ontvouwen te midden van een intense AI-wapenwedloop, zijn regelrecht gericht op het uitdagen van de markt van Nvidia. dominantie. Er zijn duizelingwekkende investeringen nodig om te kunnen concurreren.

Om aan de stijgende vraag te voldoen, heeft Google onlangs de bovenkant van zijn prognose voor de kapitaaluitgaven voor dit jaar verhoogd van $85 miljard naar $93 miljard.

Een dergelijke enorme financiële toezegging laat zien dat controle over de onderliggende hardware nu als een cruciaal concurrentievoordeel wordt gezien.

Door zowel de zeer gespecialiseerde Ironwood TPU’s als de efficiënte Axion CPU’s voor algemene doeleinden uit te rollen, presenteert Google een veelomvattend, mede ontworpen oplossing.

Het bedrijf gokt erop dat het aanbieden van een geoptimaliseerde en kosteneffectieve hardwarestack, van de chip tot het datacenter, de sleutel zal zijn tot het winnen van de volgende fase van de AI-revolutie.