Een nieuw academisch onderzoek doet ernstige twijfel rijzen over de betrouwbaarheid van AI-aangedreven zoeken van Google en OpenAI. Uit een onlangs gepubliceerd onderzoeksartikel blijkt dat generatieve zoekhulpmiddelen vaak minder of minder populaire bronnen gebruiken dan de traditionele Google Zoeken.

De AI-systemen worstelen ook met tijdgevoelige onderwerpen en vertonen binnen slechts een paar maanden grote inconsistenties. Deze bevindingen suggereren dat hoewel AI snelle antwoorden kan bieden, het vaak achterloopt op het gebied van nauwkeurigheid en bronkwaliteit, wat een uitdaging vormt voor gebruikers die afhankelijk zijn van zoeken naar actuele informatie.

AI Search gokt op minder, minder populaire bronnen

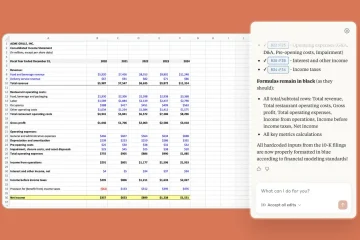

Het nieuwe paper gepubliceerd op arXiv onthult een fundamentele verschuiving in de manier waarop informatie wordt verkregen. Onderzoekers Elisabeth Kirsten en haar collega’s vergeleken traditionele Google Zoeken met vier generatieve AI-systemen: Google’s AI Overview, Gemini 2.5 Flash, GPT-4o Search en GPT-4o met een zoektool.

Uit hun analyse van meer dan 4.600 zoekopdrachten op het gebied van algemene kennis, politiek, wetenschap en winkelen bleek dat door AI gegenereerde resultaten vaak afkomstig zijn van een ander, en vaak minder prominent deel van het internet.

Een opvallende 53% van de websites waarnaar wordt gelinkt via het AI-overzicht van Google verscheen niet in de top 10 resultaten van een conventionele zoekopdracht. Dit duidt op een aanzienlijke afwijking van de gevestigde rangschikkingssignalen van traditioneel zoeken.

OpenAI’s GPT-4o met een zoektool citeerde veel minder bronnen dan zijn tegenhangers en vertrouwde op een gemiddelde van slechts 0,4 webpagina’s per zoekopdracht, waarbij hij zwaar leunde op de interne, voorgetrainde kennis.

In tegenstelling hiermee citeerden Google’s AI Overview en Gemini beide gemiddeld meer dan 8,5 pagina’s, waaruit blijkt dat er een grotere afhankelijkheid is van extern ophalen via internet. Voor dubbelzinnige zoekopdrachten merkte het onderzoek op dat traditioneel zoeken nog steeds een betere dekking van meerdere gezichtspunten bood.

Onstabiel en onbetrouwbaar: AI-antwoorden veranderen met de dag

Naast sourcing legt het onderzoek een kritieke tekortkoming in de consistentie bloot. Generatieve zoekmachines lijken zeer vluchtig te zijn, waarbij hun antwoorden en bronnen in korte perioden dramatisch veranderen.

Om dit te testen, herhaalden de onderzoekers hun zoekopdrachten met een tussenpoos van twee maanden en maten ze de stabiliteit van de resultaten. Voor gebruikers die betrouwbare en herhaalbare informatie verwachtten, was de uitkomst zorgwekkend.

De resultaten van de hertest waren teleurstellend. Traditioneel Google Zoeken behield een consistentie van 45% in de bronnen die het presenteerde. In een daling vertoonde het AI-overzicht van Google slechts 18% consistentie, wat betekent dat de onderliggende bronnen vrijwel geheel verschillend waren van test tot test.

Deze instabiliteit suggereert dat de gesynthetiseerde antwoorden die gebruikers ontvangen niet alleen verschillen van traditionele zoekopdrachten, maar ook van de ene op de andere dag onvoorspelbaar zijn, waardoor hun betrouwbaarheid voor serieuze onderzoeks-of verificatietaken wordt ondermijnd.

Worstelen met het ‘nu’: AI faalt bij tijdgevoelig nieuws

Voor tijdgevoelige vragen over recente gebeurtenissen bracht het onderzoek kritieke fouten aan het licht die het gevaar benadrukken van het vertrouwen op AI-modellen met verouderde interne kennis. Onderzoekers testten de systemen met behulp van populaire onderwerpen, waaronder een vraag over de ‘doodsoorzaak van Ricky Hatton’, een voormalig bokser die in september 2025 was overleden.

Beide GPT-modellen slaagden niet voor de test, ook al waren ze niet sterk afhankelijk van real-time internetherstel. Ze meldden ten onrechte dat Hatton nog leefde, een aanzienlijke feitelijke fout die voortkwam uit een gebrek aan toegang tot actuele informatie.

Deze specifieke mislukking toont een kernzwakte aan: zonder robuust, dynamisch ophalen kan AI-zoekopdrachten met vertrouwen gevaarlijk verouderde informatie als feit presenteren. Hoewel ophaalsystemen zoals Gemini beter presteerden, onderstreept het incident de risico’s van het laatste nieuws of evoluerende gebeurtenissen.

Een steeds groter vertrouwenskloof in de AI-informatieoorlog

Dergelijke patronen van onbetrouwbaarheid weerspiegelen recente bevindingen uit een baanbrekend BBC-onderzoek, waarin significante fouten werden aangetroffen in 45% van de nieuwsgerelateerde antwoorden van AI-assistenten. In dat rapport werd melding gemaakt van het gebruik van “ceremoniële citaten” – links die gezaghebbend lijken, maar de gemaakte beweringen niet daadwerkelijk ondersteunen.

Jean Philip De Tender, mediadirecteur bij de EBU, merkte de systemische aard van het probleem op.”Dit onderzoek toont onomstotelijk aan dat deze tekortkomingen geen geïsoleerde incidenten zijn. Ze zijn systemisch, grensoverschrijdend en meertalig, en wij zijn van mening dat dit het vertrouwen van het publiek in gevaar brengt.”

Een groeiend aantal bewijzen voedt een toch al gespannen conflict tussen technologieplatforms en nieuwsuitgevers. Uitgevers beweren dat AI-zoekmachines niet alleen onbetrouwbaar zijn, maar ook actief schade toebrengen aan hun bedrijven door inhoud te schrappen om directe antwoorden te bieden, waardoor gebruikers niet meer hoeven door te klikken naar de oorspronkelijke bron.

Deze trend, bevestigd door een onderzoek van het Pew Research Center waaruit blijkt dat klikken kelderen wanneer AI-overzichten verschijnen, doorbreekt de al lang bestaande waarde-uitwisseling van het open web.

Zoals Danielle Coffey, CEO van de News/Media Alliance stelde het als volgt:”Links waren de laatste verlossende zoekkwaliteit die uitgevers verkeer en inkomsten opleverde. Nu neemt Google inhoud met geweld en gebruikt deze zonder iets terug te geven.”

Uiteindelijk beweren de auteurs van het artikel dat het hele raamwerk voor het beoordelen van de zoekkwaliteit een herziening nodig heeft voor het AI-tijdperk. De huidige statistieken, ontworpen voor gerangschikte lijsten met links, zijn onvoldoende om deze nieuwe systemen te evalueren.

“Ons werk toont de behoefte aan aan nieuwe evaluatiemethoden die gezamenlijk rekening houden met brondiversiteit, conceptuele dekking en synthesegedrag in generatieve zoeksystemen.”

De auteurs benadrukken ook de behoefte aan betere mechanismen om met de snelle aard van online informatie om te gaan.

“Deze bevindingen onderstrepen het belang van het integreren van temporeel bewustzijn en dynamisch ophalen in generatieve zoekevaluatiekaders.”

Totdat dergelijke standaarden zijn ontwikkeld en aangenomen, blijft de belofte van een slimmere, snellere AI-zoekopdracht vertroebeld door aanhoudende problemen met betrouwbaarheid, consistentie en vertrouwen.