Het Chinese technologiebedrijf Meituan heeft maandag een nieuw AI-videomodel uitgebracht, LongCat-Video, waardoor het gratis beschikbaar is als open-sourcesoftware.

Het krachtige model van 13,6 miljard parameters genereert minutenlange video’s van hoge kwaliteit uit tekst of afbeeldingen, een aanzienlijke sprong voorwaarts voor open-sourcetechnologie. LongCat-Video, uitgebracht op platforms als GitHub, daagt direct de eigen modellen van OpenAI en Google uit.

Meituan positioneert de release als een belangrijke stap in de richting van de ontwikkeling van meer geavanceerde’wereldmodellen’door veelvoorkomende problemen op te lossen, zoals kwaliteitsverlies bij langdurige AI-video. De stap van Meituan maakt geavanceerde creatieve tools toegankelijker voor ontwikkelaars en onderzoekers over de hele wereld.

Een uniforme architectuur voor lange video

Als belangrijke stap voor de open-sourcegemeenschap heeft Meituan zijn geavanceerde AI-videogenerator, LongCat-Video, uitgebracht onder een permissieve MIT-licentie. Het 13.6B-parametermodel is gebouwd op een krachtige Diffusion Transformer (DiT)-architectuur en past de transformatortechnologie aan die een revolutie teweegbracht in taalmodellen voor de complexe taak van het genereren van video. De architectuur biedt een veelzijdig, uniform raamwerk voor makers.

Het kernontwerp van Meituan LongCat kan tekst-naar-video-, beeld-naar-video-en video-voortzettingstaken binnen één systeem verwerken. Voor gebruikers betekent dit een vloeiender en geïntegreerd creatief proces.

Een maker kan beginnen met een tekstprompt om een eerste scène te genereren, een referentieafbeelding gebruiken om een specifiek personage in die scène te animeren en vervolgens video-voortzetting gebruiken om de actie uit te breiden, allemaal zonder te schakelen tussen verschillende tools.

🤯 MIT-licentie + 5 minuten durende coherentie + 10x snelheidsboost. Meituan heeft zojuist LongCat-Video (13.6B) open source gemaakt, een SOTA-videobasismodel dat een serieuze kanshebber is voor de World Model-race.

🎥 De doorbraak: genereert native video’s van maximaal 5 minuten door vooraf te trainen op… pic.twitter.com/WuYPA9kuFV

— ModelScope (@ModelScope2022) 27 oktober 2025

Door taken te onderscheiden op basis van het aantal geleverde initiële frames, maakt de geïntegreerde aanpak van het model een naadloze overgang tussen verschillende creatieve modi mogelijk, waardoor de productieworkflow wordt gestroomlijnd.

Het duurzaamheidsprobleem oplossen: minutenlange video zonder degradatie

Terwijl eigen systemen zoals Sora 2 van OpenAI domineerden onlangs de krantenkoppen, de aanpak van Meituan richt zich op het oplossen van een van de meest hardnekkige uitdagingen van AI-video: de duur.

Veel modellen lijden aan een snel verval in kwaliteit, waarbij de temporele samenhang verloren gaat en visuele artefacten zich binnen slechts een paar seconden ophopen. De opvallende eigenschap van LongCat-Video is de mogelijkheid om stabiele, minutenlange video’s te genereren met een vloeiende resolutie van 720p en 30 frames per seconde.

De makers schrijven deze doorbraak toe aan het vooraf trainen van het model, specifiek op video-voortzettingstaken, waardoor het leert de consistentie in de loop van de tijd te behouden. Volgens het team is”LongCat-Video van nature voorgetraind op het gebied van Video-Continuation-taken, waardoor het minutenlange video’s kan produceren zonder kleurafwijkingen of kwaliteitsverlies.”

Door zich te concentreren op voortzetting, bestrijdt het model direct de kleurafwijkingen en beelddegradatie waar AI-video’s vaak last van hebben, waardoor langere verhalen van begin tot eind visueel coherent blijven.

Om dit te bereiken Het rekenintensieve proces is praktisch en het model maakt gebruik van verschillende op efficiëntie gerichte technieken. Zoals Meituan uitlegt:”LongCat-Video genereert binnen enkele minuten video’s van 720p en 30 fps door gebruik te maken van een strategie voor het genereren van grof naar fijn langs zowel de temporele als de ruimtelijke as.”

De strategie van grof naar fijn (C2F) bestaat uit twee fasen: het genereert eerst een’concept’van de video met een lagere resolutie en verfijnt en schaalt deze vervolgens op intelligente wijze, waarbij details worden toegevoegd en textuur.

Dit is vaak sneller en levert betere resultaten op dan proberen in één keer een volledige video met hoge resolutie te genereren. Bovendien maakt LongCat-Video gebruik van Block Sparse Attention, een slimme optimalisatie waarmee het model zijn rekenkracht kan richten op de meest relevante delen van de videoreeks in plaats van elke pixelrelatie te verwerken, waardoor de verwerkingslast aanzienlijk wordt verminderd.

Een open source-kandidaat in de AI Video Race

De release van Meituan op 27 oktober maakt LongCat-Video tot een Een onmiddellijke en geduchte concurrent voor open source in een veld dat wordt gedomineerd door gesloten systemen.

De mogelijkheden ervan plaatsen het in directe concurrentie met het onlangs bijgewerkte Veo 3.1-model van Google en Sora 2 van OpenAI. De lancering van Sora 2, hoewel technisch indrukwekkend, leidde ook tot een wijdverspreid debat over deepfakes en AI-veiligheid, waardoor er een opening ontstond voor een transparanter, op ontwikkelaars gericht alternatief.

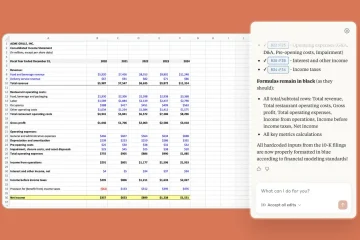

Prestatiestatistieken van de het technische rapport van het model laat zien dat het zijn mannetje staat. Op de VBench 2.0 benchmark behaalde LongCat-Video een totaalscore van 62,11%. Het overtrof met name alle geteste concurrenten in de dimensie’Gezond verstand’met een score van 70,94%, wat duidt op een sterk begrip van fysiek realisme en plausibele beweging.

Het bedrijf beschouwt het project als een strategische stap in de richting van ambitieuzere doelen. “Videogeneratie is een cruciale weg naar wereldmodellen, met efficiënte lange video-inferentie als sleutelvermogen,” merkte het Meituan LongCat-team op.

De visie van Meituan wijst in de richting van de ontwikkeling van ‘wereldmodellen’: AI-systemen met een fundamenteel begrip van natuurkunde, oorzaak-en-gevolg en objectduurzaamheid die de werkelijkheid kunnen simuleren. LongCat-Video vertegenwoordigt een cruciale stap in het visueel uitdrukken van die gesimuleerde kennis.

Naast de krachtige mogelijkheden vormt de grote omvang van het model een aanzienlijke hardwarebarrière voor individuele onderzoekers en hobbyisten. Er blijven ook vragen bestaan over de herkomst van de enorme videodataset die wordt gebruikt voor training, een gevoelig onderwerp in de generatieve AI-industrie.

De stap van Meiituan zal waarschijnlijk verdere innovatie in de open-sourcegemeenschap stimuleren en de druk op eigen ontwikkelaars vergroten om meer toegankelijke oplossingen aan te bieden.

Nu ontwikkelaars LongCat-Video beginnen te integreren in hun workflows, zal de reële impact ervan op de creatieve industrie en het vermogen om LongCat-Video te integreren in hun workflows toenemen. het verleggen van de grenzen van AI-gestuurde verhalen zal duidelijker worden.