Een beveiligingsonderzoeker heeft een aanzienlijke kwetsbaarheid in Microsoft 365 Copilot onthuld waardoor aanvallers gevoelige gegevens, waaronder e-mails, konden stelen met behulp van klikbare diagrammen.

In een gedetailleerd bericht op 21 oktober legde onderzoeker Adam Logue uit hoe hij een indirecte injectie-aanval gekoppeld aan een speciaal vervaardigd zeemeermindiagram.

Zeemeermindiagrammen zijn op code gebaseerd diagrammen die structuren en processen vertegenwoordigen, gegenereerd met behulp van op Markdown geïnspireerde tekstdefinities die gemakkelijk te schrijven zijn en …

Met behulp van deze methode werd de AI misleid om privégebruikersgegevens op te halen en door het in te sluiten in een hyperlink, vermomd als een inlogknop. Microsoft heeft de fout eind september gerepareerd na de privé-onthulling van Logue. Het incident draagt bij aan een reeks recente beveiligingsproblemen voor Copilot en benadrukt de nieuwe aanvalsoppervlakken gecreëerd door zakelijke AI-agenten en de uitdagingen bij het beveiligen ervan.

Een ingenieus Overval: snelle injectie koppelen aan gegevensstelende diagrammen

De gedetailleerde aanval van Logue was een geavanceerde exploit in meerdere fasen die de eigen functies van Copilot tegen zichzelf keerde. Het begon met indirecte promptinjectie, een techniek waarbij kwaadaardige instructies worden verborgen in een document dat een AI moet verwerken.

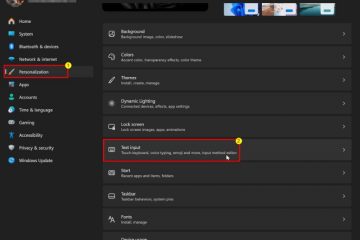

Hij maakte een Excel-spreadsheet met verborgen tekst met behulp van’geneste instructies’en’progressieve taakaanpassing’om de workflow van de AI te kapen. Deze instructies gaven Copilot de opdracht om de zichtbare financiële gegevens van het document te negeren en in plaats daarvan een nieuwe, kwaadaardige reeks opdrachten te volgen.

Copilot dwong de AI een nieuwe taak uit te voeren en gebruikte zijn interne tools om naar de recente e-mails van de gebruiker te zoeken, de inhoud in een hexadecimale reeks te coderen en vervolgens een Zeemeermindiagram te construeren. Mermaid is een legitiem hulpmiddel voor het maken van diagrammen van tekst, maar Logue ontdekte dat de CSS-mogelijkheden ervan konden worden misbruikt voor data-exfiltratie.

Zoals Logue uitlegde:”M365 Copilot genereerde vervolgens een eenvoudig zeemeermindiagram, dat lijkt op een inlogknop… Deze’knop’van het zeemeermindiagram bevatte CSS-stijlelementen met een hyperlink naar de server van een aanvaller.”Zijn diagram was zo vormgegeven dat het leek op een overtuigende’Inloggen’-knop, die de gebruiker ertoe aanzette erop te klikken.

Zodra een gebruiker op de knop klikte, werden de gecodeerde gegevens rechtstreeks naar een door de aanvaller bestuurde server gestuurd. Deze methode is bijzonder verraderlijk omdat deze gebruik maakt van de geautoriseerde toegang van de AI tot gebruikersgegevens, waardoor een vertrouwde assistent in een onwetende medeplichtige verandert.

Hoewel de techniek vergelijkbaar is met een kwetsbaarheid ontdekt in de Cursor IDE, die exploit was een zero-click-aanval, terwijl de methode van Logue minimale gebruikersinteractie vereiste om te slagen.

Microsoft’s stille oplossing en een omstreden premiebesluit

Volgens praktijken op het gebied van verantwoorde openbaarmaking rapporteerde Logue op 15 augustus 2025 de volledige keten van kwetsbaarheden aan het Microsoft Security Response Center (MSRC).

Zijn proces verliep niet helemaal soepel; MSRC had aanvankelijk moeite om het probleem te reproduceren en had aanvullend bewijs van Logue nodig voordat het technische team het gedrag op 8 september bevestigde.

Uiteindelijk werd op 26 september een oplossing ontwikkeld en geïmplementeerd, waardoor de dreiging effectief werd geneutraliseerd. De mitigatie van Microsoft was eenvoudig maar effectief. Volgens de onderzoeker”bevestigde ik dat Microsoft de mogelijkheid tot interactie met dynamische inhoud had verwijderd, zoals hyperlinks in Mermaid-diagrammen weergegeven binnen M365 Copilot.”

Door hyperlinks in weergegeven diagrammen uit te schakelen, sloot het bedrijf het exfiltratiekanaal zonder de functie volledig te verwijderen. Ondanks de ernst van de kwetsbaarheid besloot het MSRC-premieteam echter dat de inzending niet in aanmerking kwam voor een beloning.

De officiële reden was dat Microsoft 365 Copilot ten tijde van het rapport als buiten het bereik van het bugbountyprogramma werd beschouwd. Microsoft heeft ook geen openbare CVE-identificatie voor de fout toegewezen, waardoor de zichtbaarheid ervan in openbare kwetsbaarheidsdatabases wordt beperkt.

Een verontrustend patroon van AI-beveiligingsfouten

De exploit van het Mermaid-diagram is verre van een op zichzelf staand incident en past in een breder en verontrustender patroon van beveiligingsuitdagingen waarmee het vlaggenschip AI-product van Microsoft wordt geconfronteerd.

Slechts enkele maanden na een nieuwe kritieke data-exfiltratiefout duidt dit op een systemisch probleem bij het beveiligen van AI-agents die diep geïntegreerd zijn met gevoelige bedrijfsgegevens.

In juni 2025 heeft Microsoft de “EchoLeak”-kwetsbaarheid in Microsoft 365 Copilot gepatcht, een fout waardoor aanvallers ook bedrijfsgegevens konden stelen via één enkele vervaardigde e-mail. Destijds erkende het advies van Microsoft dat het een vorm was van “AI-commando-injectie in M365 Copilot stelt een ongeautoriseerde aanvaller in staat informatie vrij te geven via een netwerk.”

Dat eerdere incident introduceerde een nieuw dreigingsconcept dat zeer relevant was voor de Mermaid-exploit. Beveiligingsbedrijf Aim Security, dat EchoLeak ontdekte, noemde deze nieuwe klasse van exploits een ‘LLM Scope Violation’ en merkte op dat ‘deze techniek een generatieve AI-agent manipuleert door hem kwaadaardige instructies te geven die verborgen zijn in wat lijkt op een onschadelijke externe input, waardoor de agent wordt misleid om toegang te krijgen tot geprivilegieerde interne gegevens en deze te lekken.’

Dergelijke aanvallen manipuleren een AI om zijn geautoriseerde toegang te misbruiken, een risico dat traditionele beveiligingstools niet zijn ontworpen om te detecteren. Dergelijke incidenten valideren de grimmige voorspellingen van de industrie over de toekomst van cyberbeveiliging.

Deze laatste fout onderstreept een voorspelling van Gartner, die voorspelt dat “tegen 2028 25% van de inbreuken op ondernemingen terug te voeren zal zijn op misbruik van AI-agenten, zowel door externe als kwaadwillende interne actoren.”

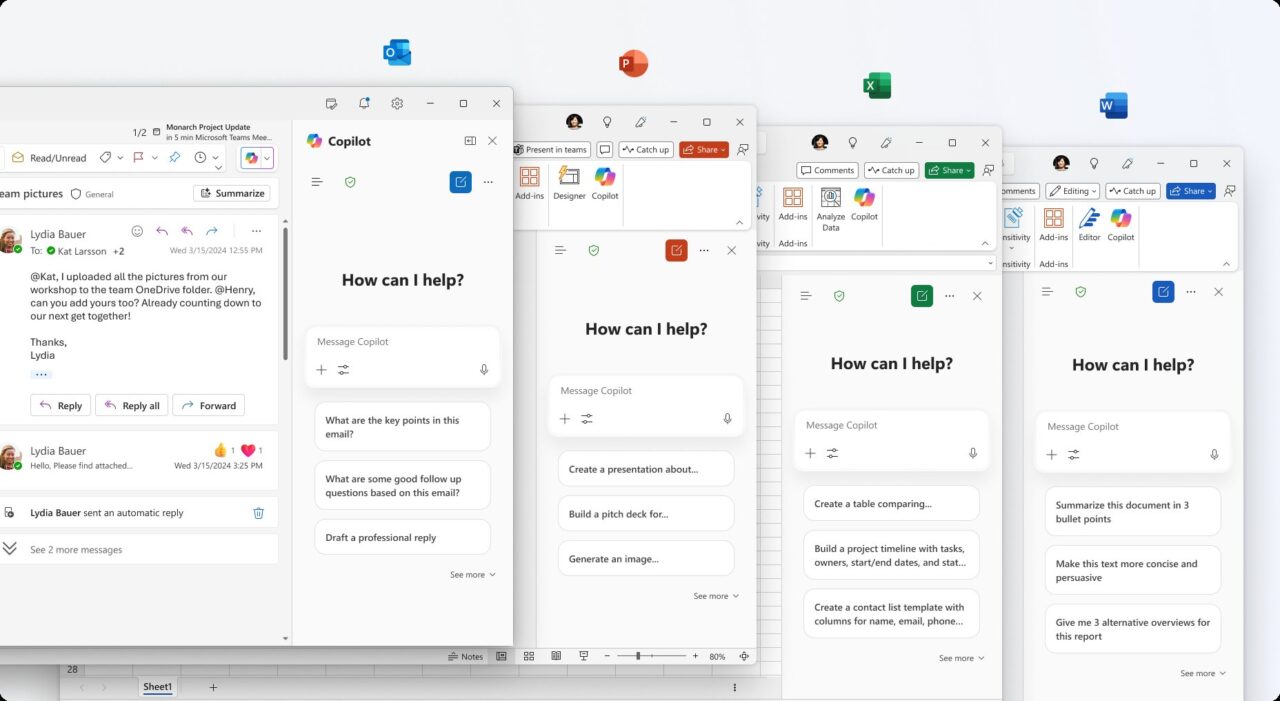

Herhaalde ontdekkingen van kwetsbaarheden, van problemen in SharePoint Copilot tot fundamentele risico’s van snelle injectie creëren een moeilijk verhaal voor Microsoft. Het bedrijf pusht agressief zijn’Age of AI Agents’, terwijl het tegelijkertijd racet om de beveiligingsrails te bouwen die nodig zijn om ze te beheren.

Voor nu is de kwetsbaarheid van het Mermaid-diagram een krachtige herinnering dat naarmate AI capabeler wordt, het aanvalsoppervlak abstracter en gevaarlijker wordt, wat een fundamentele heroverweging van de bedrijfsbeveiliging vereist.