In 2016 deed AI-pionier Geoffrey Hinton een gedurfde voorspelling en verklaarde dat”mensen nu moeten stoppen met het opleiden van radiologen.”Het was een keerpunt dat het einde van een medisch specialisme leek in te luiden. Maar bijna tien jaar later vertelt de realiteit ter plaatse een ander verhaal – althans tot nu toe.

De vraag naar menselijke radiologen neemt explosief toe. In 2025 boden residentieprogramma’s een recordaantal posities, en gemiddelde salarissen zijn sinds 2015 met bijna 50% gestegen.

Het beroep dat AI moest elimineren is belangrijker dan ooit, met leegstandspercentages op een recordhoogte ooit.

Deze paradox onthult een cruciale les over de impact van technologie in de echte wereld. Hoewel AI-modellen van giganten als Microsoft bovenmenselijke nauwkeurigheid kunnen bereiken in steriele laboratoriumomstandigheden, hebben ze moeite om door de complexiteit van de feitelijke klinische praktijk te navigeren. Het pad van algoritme naar adoptie is geplaveid met praktische, juridische en ethische hindernissen.

Van benchmarks tot bedside: AI’s reality check

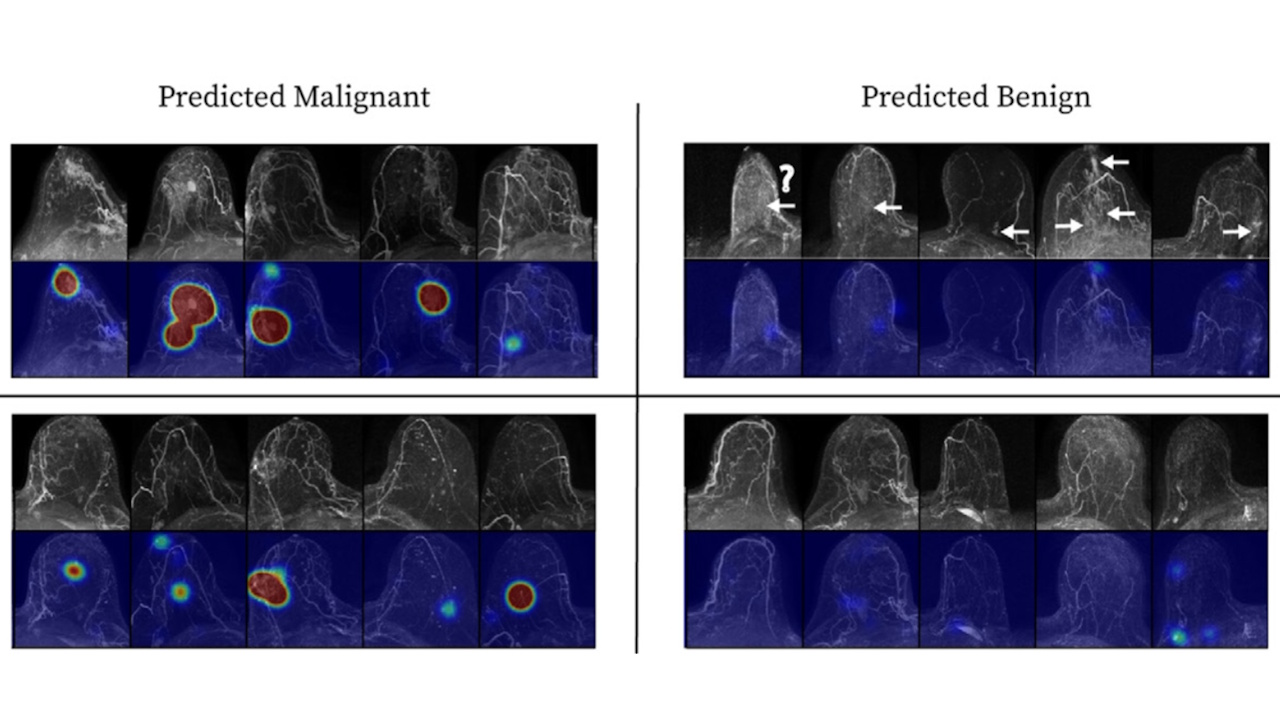

De kloof tussen de prestaties van een AI in gecontroleerde benchmarks en de doeltreffendheid ervan in de echte wereld is de eerste grote hindernis. Modellen worden vaak getraind op zeer zorgvuldig samengestelde, ondubbelzinnige beelden, waardoor hun prestaties in de richting van de gemakkelijkste gevallen verschuiven.

Ze haperen vaak wanneer ze worden geconfronteerd met subtiele ziektepresentaties, wazige scans of variaties in beeldapparatuur, een probleem dat bekend staat als out-of-distributiestoring.

Deze broosheid is goed gedocumenteerd. De nauwkeurigheid van een AI kan met maar liefst 20 procentpunten afnemen als deze wordt getest op gegevens van een nieuw ziekenhuis.

Het validatieproces zelf is vaak smal; uit een analyse uit 2024 bleek dat 38% van de beoordeelde modellen werd getest op gegevens van een één instelling. Dit gebrek aan context in de echte wereld kan tot absurde fouten leiden, zoals één model dat chirurgische nietjes herhaaldelijk ten onrechte identificeerde als hersenbloedingen.

Dit is geen nieuw probleem. In de jaren negentig werden systemen voor vroege computerondersteunde diagnose (CAD) voor mammografieën op grote schaal toegepast na goedkeuring door de FDA in 1998 en terugbetaling door Medicare in 2001.

Door In 2010 werden ze in bijna driekwart van alle vertoningen gebruikt. In de praktijk faalden ze echter spectaculair. Uit een mijlpaalonderzoek bleek dat CAD-ondersteunde klinieken 20% meer biopsieën uitvoerden zonder nog meer kanker aan het licht te brengen.

Een belangrijke reden voor dit falen was de voorkeur voor automatisering: artsen te veel aan de machine uitgesteld. Uit een klinisch onderzoek uit 2004 bleek dat specialisten, onder begeleiding van CAD, amper de helft van de maligniteiten identificeerden, terwijl hun collega’s zonder hulp 68% opmerkten. Deze ervaring bracht Medicare ertoe om in 2018 de extra vergoeding voor CAD in te trekken, een historische les die opdoemt over de hedendaagse, meer geavanceerde AI.

Een recente meta-analyse van de Osaka Metropolitan University bevestigt dat deze prestatiekloof blijft bestaan. Na beoordeling van 83 onderzoeken ontdekten onderzoekers dat, hoewel generatieve AI vergelijkbaar is met die van niet-specialisten, deze 15,8% achterblijft bij menselijke experts.

Zoals een bij het onderzoek betrokken arts opmerkte: “Dit onderzoek toont aan dat de diagnostische capaciteiten van generatieve AI vergelijkbaar zijn met die van niet-gespecialiseerde artsen.” Het onderzoek waarschuwde ook dat 76% van de geanalyseerde artikelen een hoog risico op vooringenomenheid vertoonde, vaak als gevolg van ondoorzichtige trainingsgegevens.

De menselijke firewall: regulering, aansprakelijkheid en de grenzen van autonomie

Zelfs als AI perfecte nauwkeurigheid zou kunnen bereiken, zou het met een muur van regelgevende en juridische barrières worden geconfronteerd. De FDA handhaaft een veel hogere goedkeuringsnorm voor volledig autonome AI vergeleken met hulpmiddelen die een mens op de hoogte houden. Dit is om te voorkomen dat één enkele softwarefout duizenden patiënten tegelijk schaadt.

Het voldoen aan deze norm is ongelooflijk moeilijk. IDx-DR, een van de weinige autonome tools die door de FDA zijn goedgekeurd, wordt bijvoorbeeld geleverd met strikte vangrails: het kan alleen worden gebruikt bij volwassenen met een specifieke beeldkwaliteit en zonder voorafgaande diagnose van de ziekte.

Als een aandoening niet optimaal is, moet de software de zaak afbreken en de zaak doorverwijzen naar een menselijke professional.

Een verzekering tegen wanpraktijken is een ander belangrijk obstakel. Verzekeraars, op hun hoede voor catastrofale uitbetalingen door een defect algoritme, nemen steeds vaker ‘Absolute AI Exclusion’-clausules op in hun polissen.

Dit dwingt ziekenhuizen om te vertrouwen op een gediplomeerde arts die de uiteindelijke verantwoordelijkheid voor een diagnose op zich neemt, waarbij de mens de leiding houdt.

Zonder een duidelijk pad door deze juridische en financiële mijnenvelden blijft de rol van AI stevig behulpzaam. Zoals een analist van Signify Research opmerkt, blijven vertrouwens-en terugbetalingsmodellen de autonome adoptie beperken.

Meer dan alleen pixels: de paradox van AI-gestuurde vraag

Een derde kritische factor is de werkelijke reikwijdte van het werk van een radioloog. Beeldinterpretatie is slechts een deel van hun rol. Uit een onderzoek uit 2012 bleek dat diagnostiek slechts 36% van hun tijd in beslag nam, terwijl de rest werd besteed aan patiëntconsultaties, procedureel toezicht en onderwijs.

Het automatiseren van één taak elimineert het beroep niet. In plaats daarvan kan het een Jevons-paradox veroorzaken, waarbij het goedkoper en sneller maken van een dienst de vraag dramatisch doet toenemen.

Net zoals de digitalisering in de jaren 2000 de doorlooptijden van rapporten verkortte en leidde tot een toename van 60% in beeldvorming volume zou AI radiologen drukker dan ooit kunnen maken.

Deze dynamiek wordt al besproken binnen de medische gemeenschap, met sommige radiologen AI zien als een’tweesnijdend zwaard’ dat burn-out kan verlichten of verergeren, afhankelijk van de implementatie ervan.

De fundamentele hindernis: gegevensprivacy en publiek vertrouwen

Aan al deze uitdagingen ligt het onopgeloste ethische dilemma van patiëntgegevens ten grondslag. Voor het trainen van effectieve medische AI zijn enorme datasets nodig, wat aanleiding geeft tot grote zorgen over de privacy.

De recente controverse over het Britse NHS ‘Foresight’-model, dat is getraind op basis van 57 miljoen patiëntendossiers, is daar een goed voorbeeld van.

Deskundigen en voorstanders van privacy waarschuwen dat zelfs ‘geanonimiseerde’ gegevens een aanhoudend risico op heridentificatie met zich meebrengen. Zoals een privacyvoorvechter van medConfidential betoogde: “Deze covid-only AI bevat vrijwel zeker patiëntgegevens die niet uit het laboratorium kunnen worden gelaten.”

Dit sentiment wordt weerspiegeld door onderzoekers die benadrukken dat “mensen doorgaans de controle over hun gegevens willen behouden en willen weten waar die naartoe gaan.”

Het opbouwen van vertrouwen bij het publiek is net zo belangrijk als het aantonen van klinische werkzaamheid. Zoals Vin Diwakar van NHS England stelde: “AI heeft het potentieel om de manier waarop we ziekten voorkomen en behandelen te veranderen, vooral als we trainen op grote datasets”, maar de weg naar het gebruik van die data is beladen met ethische verantwoordelijkheden.

Ondanks de hindernissen zet de technologie zijn meedogenloze vooruitgang voort. De CEO van Microsoft AI, Mustafa Suleyman, prees het MAI-DxO-systeem van zijn bedrijf als “Microsoft heeft ‘een echte stap gezet in de richting van medische superintelligentie.’

Ondertussen hebben Europese onderzoekers Delphi-2M ontwikkeld, een AI die tientallen jaren van tevoren risico’s voor meer dan 1.000 ziekten kan voorspellen.

De vraag is niet óf AI zal worden gebruikt, maar hoe. Zoals professor Savannah Partridge van de Universiteit van Washington het treffend verwoordde:”Het gaat er niet om dat je [AI] gebruikt, of niet, maar hoe gebruik je het? Hoe gebruik je het op de juiste en veilige manier?”

Het geval van radiologie laat zien dat voor complexe beroepen met hoge inzet de rol van AI evolueert naar die van een krachtige, onmisbare assistent – en niet naar een vervanging.