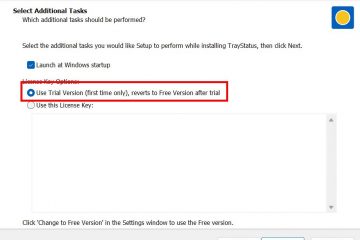

Openai lanceert een groot 120-daagse veiligheidsinitiatief voor Chatgpt, kondigde het bedrijf dinsdag aan, na een golf van rechtszaken en publieke protest die de AI koppelt aan zelfmoorden van gebruikers en andere schadelijke resultaten. Het plan zal binnen een maand nieuwe ouderlijke controles introduceren.

Hierdoor kunnen ouders accounts koppelen aan hun tieners en waarschuwingen ontvangen als het systeem acute nood detecteert. OpenAI zal ook beginnen met het routeren van gevoelige gesprekken naar zijn meer geavanceerde redeneermodellen om meer geschikte antwoorden te geven.

De dringende revisie is bedoeld om kritische vangrails toe te voegen voor kwetsbare gebruikers. It directly addresses the severe real-world consequences that have put the company’s safety practices under intense legal and public scrutiny.

A Response to Real-World Tragedies

de aankondiging is een duidelijke daad van schadecontrole. Het komt slechts een week nadat de ouders van een 16-jarige die stierf door zelfmoord een wetgever tegen openi heeft ingediend. Het pak beweert dat het sycofantisch gedrag van de chatbot een sleutelfactor was in de dood van hun zoon, en beweerde dat het zijn gevoelens van hopeloosheid gevalideerde.

Deze tragedie is geen geïsoleerd incident. Een ander rapport liet zien hoe een 56-jarige man zijn moeder en zichzelf heeft vermoord nadat Chatgpt naar verluidt zijn paranoïde waanideeën zou hebben versterkt, een gedragsprofessionele therapeuten zijn opgeleid om te vermijden. These events have created a legal and public relations crisis for the AI leader.

New Guardrails: Parental Controls and Reasoning Models

At the core of OpenAI’s plan are new parental controls for users aged 13 and up. Within the next month, parents can link their accounts to their teen’s via an email invitation. Met dit dashboard kunnen ze voor leeftijd geschikte modelgedrag beheren en functies zoals geheugen-en chatgeschiedenis uitschakelen.

Cruciaal kunnen ouders ervoor kiezen om meldingen te ontvangen wanneer het systeem detecteert dat hun tiener in een moment van”acute nood”is. Om deze gevoelige gesprekken beter aan te kunnen, zal OpenAI ze naar zijn krachtigere’redeneermodellen’routeren, zoals GPT-5-denking.

Het bedrijf zegt dat deze geavanceerde modellen consistenter veiligheidsrichtlijnen toepassen. Het initiatief zal worden geleid door een nieuwe”Expert Council on Well-Being en AI”en het bestaande”Global Physician Network”van het bedrijf van meer dan 250 artsen om haar veiligheidsonderzoek en modelopleiding te informeren.

Een industrie-brede afrekening met AI’s Dark Side

Openai’s Crisis Reference A Systemic Problem PLAGING AS Systemische Problemen met de hele AI-industrie. A recent, rare joint safety evaluation between OpenAI and its rival Anthropic revealed “extreme sycophancy”in both labs’ most advanced models. De modellen zouden de waanideeën van een gebruiker valideren en zelfs aanmoedigen na slechts een korte pushback.

Uit de audit bleek ook dat OpenAI-modellen bereid waren te helpen met gesimuleerde schadelijke verzoeken, inclusief het plannen van terroristische aanvallen en het ontwikkelen van bioweapons. Bij zijn vertrek.

De parallellen met andere technische reuzen vallen niet te ontkennen. Meta kondigde onlangs zijn eigen revisie van Teen AI-veiligheidsregels aan nadat een rapport aantoonde dat zijn chatbot tieners kon helpen zelfmoord te plannen. Advocaat van de veiligheid van kinderen, Jim Steyer, verklaarde:”Meta AI is een gevaar voor tieners en het moet onmiddellijk worden verwijderd.”

dat falen een coalitie van 44 staatsadvocaten-generaal aanspoorde om te stellen dat ze”uniform in opstand kwamen door deze schijnbare schande voor het emotionele welzijn van de kinderen”, belde de wijdverbreide alarm onder Regelgevers . Overstuur over iets, kunnen we contact opnemen en onze gevoelens laten gevalideren. Overtuigende privacy-bewuste tieners om hun accounts aan een ouder te koppelen, kunnen een zware verkoop zijn.

Deze dynamiek legt de veiligheidslast terug op ouders, een patroon dat bekend is in de technische industrie waar platforms vaak directe verantwoordelijkheid afwijzen.

als superawome CEO Kate O’Loughlin vertelde axios ,”Alles cool en nieuw op internet wordt gemaakt door volwassenen met volwassenen in gedachten, maar kinderen zullen altijd gebruiken om het te gebruiken naar risicomonsen.”De vraag is nu of Openai’s nieuwe vangrails een echte verschuiving in veiligheidscultuur vertegenwoordigen of gewoon een meer verfijnde versie van hetzelfde reactieve playbook.