in Parijs gevestigde Mistral AI heeft een geheugenfunctie gelanceerd voor zijn LE-chat-assistent, waardoor het de nieuwste grote speler is die concurreert in het steeds drukkerere veld van gepersonaliseerde AI.

De nieuwe”Memories”-functie stelt de chatbot in staat om details te roepen van eerdere gesprekken met meer op maat gemaakte reacties. a similar capability.

However, Mistral is differentiating itself by adopting a privacy-focused, opt-in approach, contrasting with the “always-on”memory systems of some concurrenten.

Deze lancering geeft een duidelijke trend aan voor meer persoonlijke, contextbewuste AI-assistenten naarmate de strijd om gebruikersloyaliteit intensiveert. Het komt ook aan als onderdeel van een dubbele strategie, in combinatie met de release van meer dan 20 enterprise-grade connectoren.

MILTRAL’s voorzichtige toegang tot AI-geheugen

Mistral frameert zijn nieuwe functie rond gebruikerscontrole en transparantie. De functie”herinneringen”is een opt-in bèta, waardoor gebruikers actief instemmen met hun gegevens die worden opgeslagen. Het bedrijf biedt gedetailleerde documentatie over zijn gegevensverwerkingspraktijken . opgeslagen. Dit positioneert Le Chat als een doordacht alternatief in een markt waar AI-terugroepactie zowel opwinding als aanzienlijke privacyproblemen heeft aangewakkerd.

[ingebedde inhoud]

Een verhaal over twee filosofieën: de AI Memory Arms Race

Mistral’s lancering belicht een groeiende kloof in de filosofie achter AI-geheugen. Aan de ene kant zijn Openai en Google, die een persistent,”altijd-on”model hebben omarmd. OpenAI heeft chatgpt in april 2025 geüpgraded om impliciet te verwijzen naar de hele chatgeschiedenis van een gebruiker.

Google volgde een soortgelijk pad, waarbij Gemini in augustus 2025 werd bijgewerkt met een automatisch geheugen op de definault. De senior directeur van Google voor de Gemini-app, Michael Siliski, zei dat het doel is dat”de Gemini-app nu naar je eerdere chats kan verwijzen om je voorkeuren te leren, waardoor meer gepersonaliseerde antwoorden worden geleverd, hoe meer je het gebruikt.”

Deze strategische divergentie weerspiegelt een fundamenteel debat in AI-ontwikkeling. De”altijd-on”kampweddenschappen bij het creëren van een diep geïntegreerde, proactieve assistent die anticipeert op de behoeften van de gebruikers. Het”door de gebruiker geïnitieerde”kamp prioriteit geeft prioriteit aan transparantie, wedden dat gebruikers voorspelbaarheid en controle waardeer over autonoom leren.

Google, van zijn deel, probeert deze kloof te overbruggen. Hoewel het geheugen volhardend is, zei woordvoerder Elia Lawal dat”even cruciaal je gemakkelijke controles geeft om de ervaring te kiezen die het beste voor je is, dus je kunt deze functie op elk gewenst moment in-en uitschakelen”, wijzend op zijn Als bewijs.

Aan de andere kant van de kloof zijn antropisch en nu mistral. Anthropic introduceerde een geheugenfunctie voor Claude in augustus 2025 die in staat is in tegenstelling tot de aanhoudende modellen.

Volgens woordvoerder Ryan Donegan,”Het is nog geen aanhoudende geheugenfunctie zoals Openai’s Chatgpt. Claude zal alleen uw openbare chats ophalen en verwijzen naar uw openbare veiligheidsveiligheid en het is geen gebruik van een gebruikersprofiel. framework. CEO Dario Amodei heeft deze op mens gerichte aanpak omlijst als essentieel en verklaart:”We gaan naar een wereld waar een menselijke ontwikkelaar een vloot van agenten kan beheren, maar ik denk dat voortdurende menselijke betrokkenheid belangrijk zal zijn voor de kwaliteitscontrole…”

Het concurrentielandschap is nu goed gedefinieerd. Microsoft Integrated Memory in Copilot in april 2025, en Elon Musk’s XAI deed hetzelfde voor GROK diezelfde maand, waardoor een markt werd gecreëerd waar geheugen nu een functie voor tafelkaarten is.

Enterprise Ambition en persistente beveiligingsrisico’s

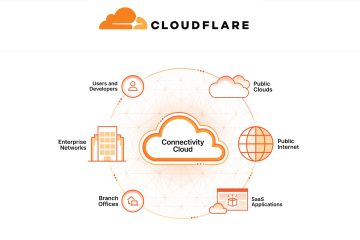

Mistral’s strategie is niet alleen over personalisatie; Het is ook een belangrijk bedrijfsspel. De gelijktijdige lancering van meer dan 20″MCP-aangedreven connectoren”voor tools zoals GitHub, Snowflake en Asana onderstreept deze ambitie. Deze connectoren veranderen LE-chat in een centrale hub voor zakelijke workflows.

De MCP-connectoren fungeren als beveiligde bruggen, waardoor LE-chat kan communiceren met services van derden zonder gevoelige referenties op te slaan. Deze agentachtige mogelijkheid is wat de AI in staat stelt om eenvoudig vragen te beantwoorden naar het actief uitvoeren van taken binnen het bestaande software-ecosysteem van een gebruiker.

[ingebedde inhoud]

, deze drang naar grotere capaciteiten introduceert ernstige beveiligingsuitdagingen. Het gemak van AI-geheugen creëert een waardevol en kwetsbaar doelwit voor kwaadaardige acteurs. Cybersecurity-onderzoekers hebben deze risico’s herhaaldelijk aangetoond.

Bijvoorbeeld, het geheugen van Google Gemini bleek kwetsbaar te zijn voor”uitgestelde”aanvallen van gereedschap. Onderzoeker Johann Rehberger legde uit dat door het inbedden van slapende opdrachten”wanneer de gebruiker later zegt \”x \”[voor de geprogrammeerde opdracht], Gemini, in de overtuiging dat het de directe instructie van de gebruiker volgt, de tool uitvoert”, die het geheugen van de AI zou kunnen corrumperen. Een kwetsbaarheid in het geheugen van Chatgpt liet eind 2024 de exfiltratie van vertrouwelijke gegevens toe.

Bovendien vormen de nieuwe MCP-connectoren zelf een risico. Uit een recent rapport van beveiligingsbedrijf PYNT bleek dat Een op de tien MCP-plug-ins is volledig exploiteerbaar Een aanval is niet alleen een eenmalige mislukking; Het kan de kennisbasis van de AI vergiftigen, wat leidt tot herhaalde fouten of subtiele gegevenslekken in de loop van de tijd. Dit maakt de integriteit van de opgeslagen ‘herinneringen’ tot een kritische beveiligingsgrens voor alle providers.

Als AI-bedrijven racen om intelligendere assistenten te bouwen, zal de spanning tussen functionaliteit en beveiliging alleen maar intensiveren. Het balanceren van innovatie met gebruikersvertrouwen blijft de cruciale uitdaging in dit nieuwe tijdperk van gepersonaliseerde ai.