Zelfs meta-platforms zijn niet immuun voor de verbluffende kosten van de AI-race. The company spent parts of the last year approaching competitors, including Microsoft, Amazon, and others, seeking financial help to train its flagship Llama large language models, according to four individuals briefed on the discussions reported by The Informatie .

Deze ouvertures, naar verluidt de”LLAMA Consortium”pitch, werden gedreven door vrees binnen meta over de escalerende middelen die nodig zijn voor de ontwikkeling van kunstmatige intelligentie, zeiden twee mensen. Als zoetstof heeft Meta blijkbaar besproken en potentiële financiële financiers inspraak gaf in de toekomstige functieontwikkeling van Lama. Still, the attempt reveals the intense financial burden involved in building leading AI systems, putting pressure even on companies with Meta’s deep pockets and signalling the high stakes in generative AI.

Llama 4-De nieuwste modellen van Meta

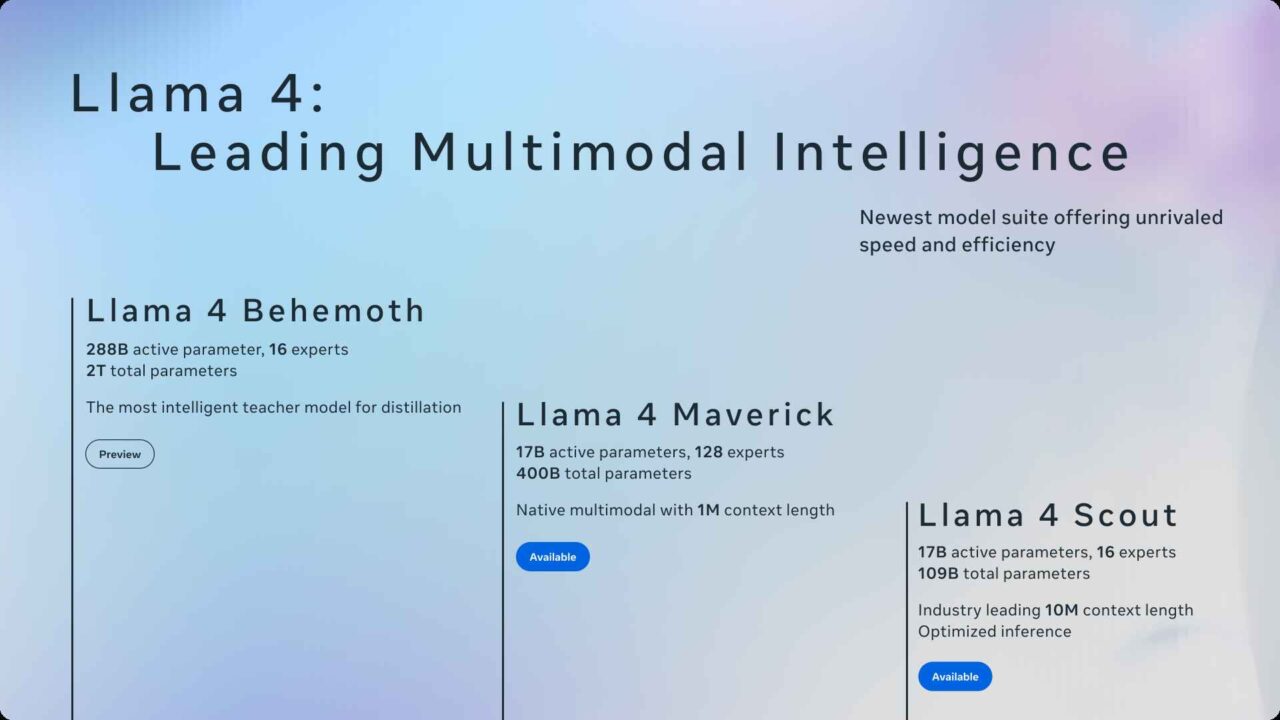

De zoektocht van Meta naar financieringspartners werpt zijn recente Lama 4-aankondiging uit in een nieuw licht. Die release introduceerde LLAMA 4 Scout (109B totale parameters, 17B actief) gericht op gebruik met één GPU met een uitzonderlijk groot 10 miljoen tokencontextvenster-in staat om ongeveer 7,5 miljoen woorden te verwerken.

Het onthulde ook de veel grotere LLAMA 4 MAVERICK (400B totaal parameters, 17B actief, 128 experts) voor grote werklast. Beide maken gebruik van een Mengsel-of-Experts (MOE)-architectuur, een techniek met gespecialiseerde subnetwerken (‘experts’) waarbij alleen de noodzakelijke worden geactiveerd per taak, gericht op een grotere efficiëntie tijdens de werking vergeleken met dichte modellen waar alle parameters altijd worden gebruikt.

Dit onderbouwt dit is de nog niet-uitgebreide Lama 4 kolos, een 2-biljoen parametermodel dat intern wordt gebruikt voor destillatie (kleinere modellen onderwijzen), waarvoor training tot 32.000 GPU’s nodig was. META-gebruikte technieken zoals FP8 Precision-een nummer met een lager-precisie-nummer dat berekeningen versnelt-en nieuwe architecturale componenten zoals interleaved Rotary Positional Embeddings (IROPE) om lange reeksen effectief te verwerken. Vereist enorme rekenkracht en technische inspanningen, waardoor de mogelijke behoefte aan gedeelde investeringen rechtstreeks wordt uitgelegd. Terwijl MOE potentiële inferentie-efficiëntie biedt, blijven de trainingskosten vooraf een belangrijke factor.

Ontwikkelingshindernissen en gegevensvragen

Naast ruwe reken, meta toegewijde middelen om LLAMA 4 te tunen voor specifieke outputs en veiligheid. Het bedrijf verklaarde publiekelijk dat het doel was tegenover waargenomen politieke vooroordelen in LLMS en merkte op:”Het is bekend dat alle toonaangevende LLM’s problemen hebben gehad met vooringenomenheid-met name hebben ze historisch naar links gelanceerd als het gaat om debatediseerde politieke en sociale onderwerpen… Dit is te wijten aan de soorten trainingsgegevens die beschikbaar zijn op internet. Naast het implementeren van veiligheidstools zoals LLAMA Guard en het Goat Red-Teaming System-een methode voor tegenstanders om kwetsbaarheden te vinden. Deze verfijnings-en veiligheidslagen voegen verder overhead over de ontwikkeling toe.

die mogelijk bijdragen aan de financiële calculus van Meta zijn aanhoudende juridische vragen over de trainingsgegevens, die een ander facet van ontwikkelingsuitdagingen en kosten vertegenwoordigen. Actieve rechtszaken, waaronder één waarbij cabaretier Sarah Silverman betrokken is, beweren dat het bedrijf LLAMA-modellen heeft getraind op massale datasets van pirated boeken afkomstig uit bibliotheken zoals Libgen via BitTorrent File-delen. Court documents reportedly revealed internal apprehension, with one engineer quoted as saying, “Torrenting from a [Meta-owned] corporate laptop doesn’t feel right.”

Allegations surfaced in late March 2025 that Meta might have also re-uploaded roughly 30% of this data, potentially weakening ‘fair use’ arguments and increasing potential legal liability or the future cost of sourcing alternative, licensed data. Dergelijke controverses kunnen een substantiële, indien minder zichtbare, bestuurder van de algemene AI-ontwikkelingskosten vertegenwoordigen.

Strategische speelt in een competitief veld

de financieringsbereik van Meta overeenkomstig zijn duidelijke strategie om LLAMA centraal te stellen in haar activiteiten. De modellen werden geïntegreerd in meta AI-functies in WhatsApp, Instagram en Facebook kort na de lancering. Ze werden ook beschikbaar gesteld voor download en via cloudpartners-waaronder Amazon Sagemaker Jumpstart en Microsoft’s -hoewel met name onder een aangepaste commerciële licentie, geen typische open-source. Deze gecontroleerde release-strategie houdt meta betrokken bij de inzet van Lama, waarbij openheid wordt in evenwicht met commerciële interesses.

De focus van META op zijn eigen AI verder onderstreept, was de stap, gerapporteerd om de systeembrede Apple Intelligence-functies van Apple te blokkeren binnen de iOS-apps van Meta. Dit voorkomt dat iPhone-gebruikers de AI-schrijfhulpmiddelen of genmoji van Apple gebruiken in Facebook of Instagram, waardoor ze in plaats daarvan op LLAMA-gebaseerde alternatieven op Lama worden geduwd. De aanpak van Meta verschilt ook van het meer op privacy gerichte, vaak on-device-model van Apple, een onderscheid dat wordt benadrukt door de publieke discussie van Meta over de politieke neiging van Tuning Lama 4 en de gelijktijdige, controversiële roll-back van derden Feit-controle in de VS Begin januari 2025.

META PLANTEN MEER DETA DETEN KIJKEN DETAAL DETADEN AT HET HET HET DE Llamacon-evenement gepland voor 29 april, mogelijk updates aanbieden over het massieve Behemoth-model of het komende LLAMA 4-V Vision Model.