Microsoft heeft snel de zojuist aangekondigde O3-en O4-Mini-kunstmatige intelligentiemodellen van Openai opgenomen in zijn kernwolk-en ontwikkelaarsplatforms, waardoor de geavanceerde redeneermogelijkheden beschikbaar zijn via Azure en GitHub. Deze snelle integratie onderstreept de strategie van Microsoft om de nieuwste technologie van OpenAI in te sluiten in zijn services, en biedt gebruikers toegang tot modellen die worden gekenmerkt door verbeterde prestaties en wat het bedrijf”vroeg agentisch gedrag”noemt.”

In tegenstelling tot vorige generaties, O3 en O4-Mini kan het gebruik van interne tools-instructies.

Deze”agentische”aanpak is een verschuiving naar AI-systemen die onafhankelijk kunnen plannen en handelen. These models also feature vision processing capabilities, enabling them to interpret images, and support for advanced functionalities like function calling, structured outputs, and long-context handling up to 200,000 tokens.

The rollout comes after OpenAI released the API only GPT-4.1 series of models and activated a “recall”Geheugenfunctie in Chatgpt eerder in april, waardoor context-persistentie tussen sessies mogelijk is. Naast de lancering van de O3-en O4-Mini-modellen heeft OpenAI ook Codex CLI uitgebracht, een gratis, open source-tool voor model-agnostische AI-codering waarmee ontwikkelaars AI direct kunnen gebruiken in de terminal.

agentische AI-landen op Microsoft-platforms

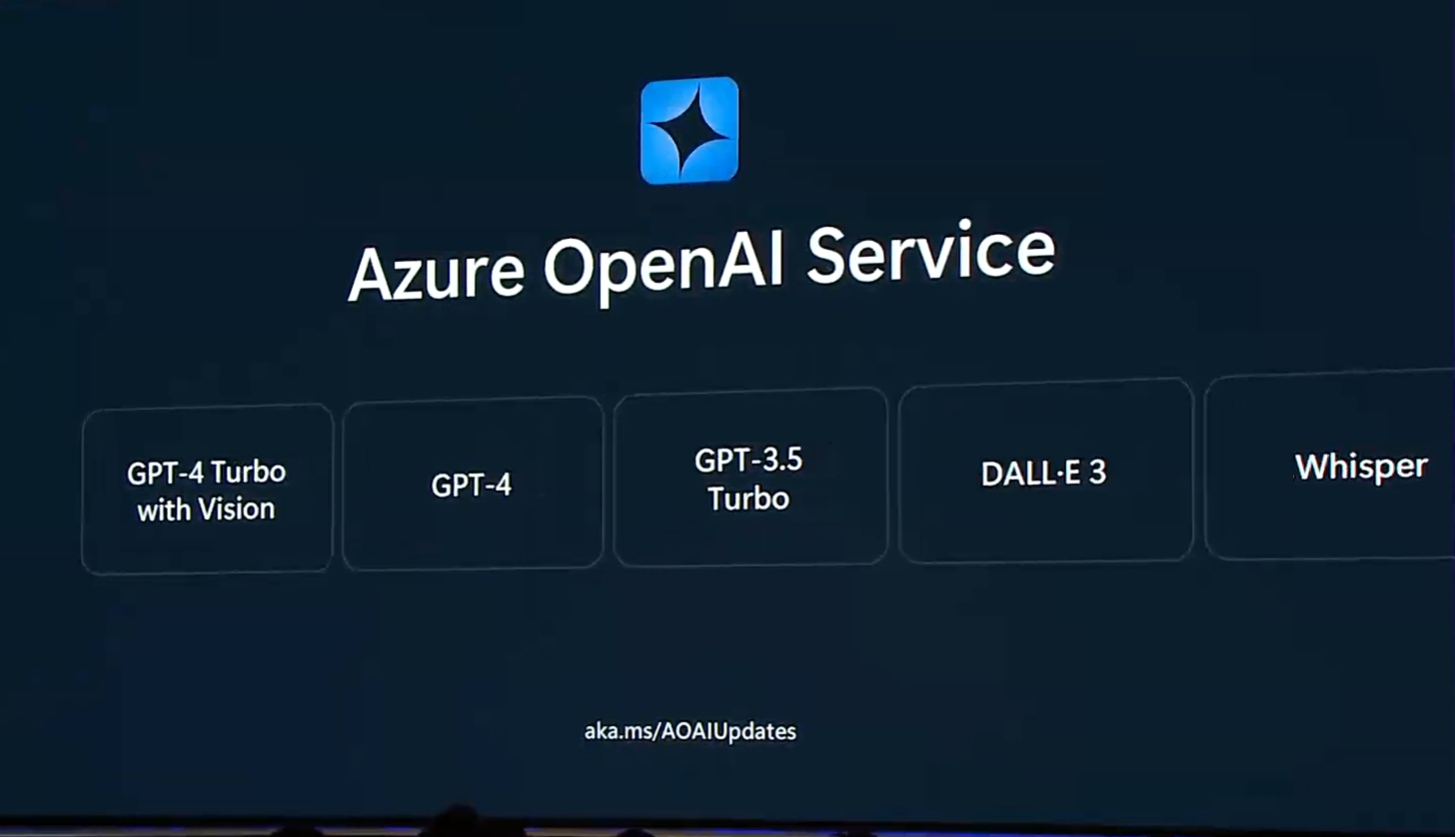

MicroSoft Bevestigde de modellen zijn levend in de Azure OpenAI Service via Azure AI Foundry, initially available in the East US2 and Zweden centrale Azure-regio’s. Naast deze debuteerden nieuwe audiomodellen (GPT-4O-transpricaties en mini-TT’s) ook op Azure Foundry in Oost-US2. Azure-prijzen weerspiegelen de verschillende posities van de modellen: O3 kost $ 10/miljoen input tokens ($ 2,50/m voor visie) en $ 40/miljoen output tokens, terwijl de efficiënte O4-mini $ 1,10/miljoen input tokens is ($ 0,275/m voor visie) en $ 4,40/miljoen outputtokens, volgens Openai.

Developer Tools and Access Controls

On the developer front, GitHub rolt openbare previews uit voor de nieuwe modellen op Github Copilot en GitHub-modellen. GitHub kadert O3 als zijnde”ideaal voor diepe coderende workflows en complexe technische probleemoplossing”, met O4-Mini die”lage latentie combineert met hoogwaardige uitvoer, ondersteuning van volledige gereedschappen en multimodale inputs.” toegang is : o4-mini bewerkt en Enterprese to Enterprise and o4-mini bonte copilot en o4-mini. Abonnees van het nieuwe Pro+ Plan.

Selectie vindt plaats via modelplukkers in Visual Studio Code of GitHub Copilot Chat online zodra de uitrol is voltooid, hoewel Copilot Enterprise admin-inschakelen vereist. GitHub also highlighted its data policies, assuring users of a zero data retention agreement with OpenAI en standaard niet-training over bedrijfsgegevens voor de integratie van de copilot. Within GitHub Models, developers can benchmark these newcomers against models from Meta, Cohere, Microsoft, and others in a shared playground.

Capabilities, Cost Efficiency, and Context

Benchmark data released by OpenAI suggests performance gains over the older o1 and o3-mini models in reasoning, coding, and multimodal tasks. Hoewel O3 vaak leidt in complexe operaties, vertoont O4-Mini sterke mogelijkheden, met name opmerkelijk gezien de lagere operationele kosten-een factor die wordt weerspiegeld in de Azure-prijzen.

Deze posities O4-Mini als een potentieel kosteneffectieve optie voor veel toepassingen. Naast Azure en GitHub verbreedt Openai ook de toegang via Chatgpt zelf; Gratis gebruikers kunnen O4-Mini proeven, terwijl gebruikers van Enterprise en EDU binnenkort volledige toegang krijgen, met een ‘O3-Pro’ variant die wordt verwacht voor de Pro Tier.

Veiligheidsdialoog gaat verder

Deze snelle implementatie volgt rapporten en discussies rond AI-veiligheidspraktijken. OpenAI gebruikte een aanzienlijk ingekortte interne veiligheidstestperiode voor O3 en OpenAI’s update naar het paraatheidskader dat mogelijk aanpassingen mogelijk maakt in veiligheidsprotocollen op basis van acties van concurrenten.

Een voormalige medewerker geciteerde bezorgdheid over het testen van intermediaire model checkpoints, waarin wordt gesteld:”Het is een slechte praktijk van de nadruk op de nadruk op de nadruk op de nadruk op de nadruk op de nadruk op de nadruk op de nadruk op de nadruk op de nadruk op de nadruk op de nadruk op de nadruk op de nadruk op de nadruk op de nadruk op de nadruk van de aangekondiging. Dat O3 en O4-mini”aanzienlijke verbeteringen in kwaliteit en veiligheid bieden”en bevatten”het volgende niveau van veiligheidsverbeteringen binnen de O-serie”, toegeschreven aan een trainingstrategie”Deliberative Apparation”. Microsoft had eerder het O3-Mini-High-model in maart geïntegreerd in zijn gratis Copilot-laag, wat duidt op een voortdurende push om de redeneerlijn van Openai te integreren.