NVIDIA is het herdefiniëren van AI Computing met de introductie van DGX Spark-en DGX-station, twee desktop AI-supercomputers gebouwd op de Grace Blackwell Platform . De nieuwe systemen zijn ontworpen om onderzoekers, ontwikkelaars en ondernemingen te bieden met AI-mogelijkheden voor werkstation-klasse zonder afhankelijkheid van cloud-of datacenterbronnen.

Naarmate AI-workloads steeds complexer worden, is de industrie sterk afhankelijk van cloudgebaseerde oplossingen. NVIDIA wil dat veranderen door persoonlijke AI-supercomputers aan te bieden die lokaal AI-training en inferenties geven. Door High-Speed Interconnects , uitgebreid geheugen en geoptimaliseerde hardware, kunnen deze systemen Professionals in staat om AI-modellen te ontwikkelen, en builds van hun werkplekken van hun werkplaten. De eerdere inspanningen van NVIDIA met Project Digits, een instap-AI-werkstation aangekondigd op CES 2025. Dat systeem, geprijsd op $ 3.000, werd ontworpen voor ontwikkelaars en studenten, met de GB10 Grace Blackwell Superchip en één petaflop van AI-prestaties. DGX Spark breidt dit concept uit met een aanzienlijk hogere geheugenbandbreedte en schaalbaarheid met meerdere eenheden, waardoor de strategische verschuiving van NVIDIA naar lokaal AI Computing wordt gemarkeerd.

DGX Spark: een kleine AI-krachtpatser voor ontwikkelaars

De DGX Spark is een compact AI-werkstation gebouwd rond de GB10 Grace Blackwell SuperChip, een hybride CPU-GPU-ontwerp ontworpen voor machine learning-efficiëntie. According to NVIDIA’s official announcement, the system is capable of delivering 1,000 trillion operations per second (TOPS) at FP4 precision, making it ideal for prototyping, fine-tuning, and running Inferentiemodellen lokaal.

Ondanks zijn Mini PC-vormfactor, omvat DGX Spark 128 GB LPDDR5X-geheugen en tot 4 TB NVME SSD-opslag, waardoor het grote AI-workloads onafhankelijk kan verwerken. Het systeem bevat ook nvlink-c2c , een ultra-high-bandwidth interconnect dat de gegevensoverdracht tussen verwerkingscomponenten en latency in ai-computers en latentie in ai-computers en latentie in ai-computers verhoogt. Toepassingen, NVIDIA heeft schaalbaarheid van multi-unit mogelijk gemaakt, waardoor twee DGX Spark-systemen aan elkaar kunnen worden gekoppeld. Deze configuratie ondersteunt AI-modellen met maximaal 405 miljard parameters, waardoor het een kosteneffectief alternatief is voor onderzoekers en teams die eerder vertrouwden op grote cloudgebaseerde clusters.

nvidia dgx vonk (imago: nvidia)

dgx station: werkstation-class-class-class-class-class voor een hoog-memory werk. Bandbreedte, NVIDIA’s DGX-station levert AI Computing van datacenter-grade AI Computing in een werkstation-vormfactor. Unlike the DGX Spark, this system is powered by the GB300 Grace Blackwell Ultra Superchip, an advanced iteration of NVIDIA’s Blackwell AI architecture designed for training and deploying large-scale machine learning models.

The DGX Station features 20 petaflops of AI performance and is equipped with 784GB of unified memory, making it well-suited for deep learning, natural language processing (NLP) en grootschalige transformatormodeltraining. Het systeem integreert nvidia’s cuda-x ai bibliotheken , pytorch frameworks, en nvidia’s dgx os , waarvoor compatibiliteit met moderne AI-workflows.

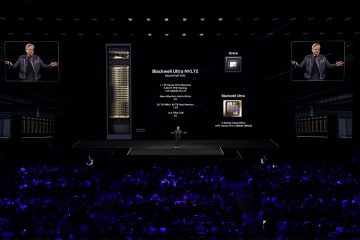

nvidia DGX Spark-en DGX-station (afbeelding: NVIDIA)

Het DGX-station heeft ook een 72-core Grace CPU (Neoverse V2-architectuur), tot 288 GB HBM3E GPU-geheugen en 496 GB van LPDDR5X CPU-geheugen, waardoor het een van de meest krachtige AI-werkstaten beschikbaar is. NVIDIA’s high-speed networking solutions further enable efficient multi-GPU processing, making this system a practical choice for researchers who require direct access to high-performance AI hardware.

Availability and Industry Adoption

NVIDIA has partnered with OEM manufacturers including ASUS, Dell, HP, Boxx, Lambda, and Supermicro to produce various Configuraties van het DGX Spark-en DGX-station. PREOORDERS VOOR DE DGX Spark begon op 18 maart 2025, met zendingen die naar verwachting in de zomer van 2025 zullen beginnen.

NVIDIA CEO Jensen Huang benadrukte de visie van het bedrijf voor gelokaliseerde AI Computing, waarin staat: “AI heeft elke laag van de computertack getransformeerd. Toepassingen.”

De introductie van DGX Spark-en DGX-station weerspiegelt een groeiende vraag naar AI Computing op on-premises. Door AI-workloads van de cloud naar lokale werkstations te verplaatsen, vermindert de nieuwste hardware van NVIDIA de latentie, gegevensprivacyproblemen en voortdurende cloudservicekosten. Het energieverbruik van dergelijke systemen blijft echter een open vraag.

met AI-modellen die steeds meer krachtige hardware vereisen, zorgen over warmtedissipatie en krachtefficiëntie zullen waarschijnlijk vormgeven aan de acceptatie van de echte wereld. Hoewel NVIDIA nog niet gedetailleerde benchmarks voor stroomverbruik heeft vrijgegeven, suggereren de hoge geheugenbandbreedte en verwerkingsbehoeften van deze systemen dat ze geavanceerde koeloplossingen en aanzienlijke energiebronnen vereisen.