Microsoft heeft Deepseek R1 toegevoegd, het baanbrekende AI-redeneermodel ontwikkeld door de in China gevestigde Deepseek, aan zijn Azure AI Foundry-platform ondanks een voortdurend onderzoek naar de vraag of het bedrijf op onjuist toegang heeft tot de API-gegevens van Openai.

De beslissing om Deepseek R1 te integreren in het cloudaanbod van Microsoft roept vragen op over AI-gegevensbeveiliging, concurrerende dynamiek en wettelijke toezicht terwijl OpenAI en Microsoft potentieel ongeoorloofd gebruik van eigen modeloutput onderzoeken.

Gerelateerd: het nieuwe Qwen 2,5-max-model van Alibaba neemt op diepeispraktijk in AI-benchmarks

De opname van Deepseek R1 in Azure AI Foundry weerspiegelt de voortdurende uitbreiding van Microsoft van zijn AI-ecosysteem, dat al modellen bevat van Openai, Meta, Mistral en CoChere.

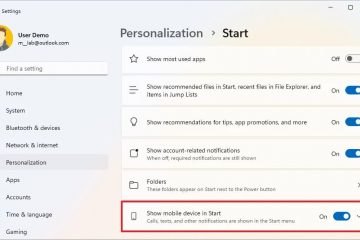

Microsoft verklaarde dat het model beveiligingsbeoordelingen heeft ondergaan voordat ze beschikbaar werden gesteld voor klanten. In een officiële verklaring zei Asha Sharma, vice-president van Microsoft van AI-platform,: “Een van de belangrijkste voordelen van het gebruik van Deepseek R1 of een ander model op Azure AI Foundry is de snelheid waarmee ontwikkelaars kunnen experimenteren, herhalen en integreren in AI in Hun workflows.”

Bron: Microsoft

gerelateerd: Deepseek laat een andere Openai-Buster met Janus multimodale modellen vallen, die Dall-E 3

Microsoft overtreft, heeft ook aangekondigd Plannen om geoptimaliseerde versies van Deepseek R1 voor Copilot+ PCS uit te brengen, waardoor lokale uitvoering mogelijk is via neurale verwerkingseenheden (NPU’s). En OpenAI onderzoekt ongebruikelijke API-toegangspatronen

Hoewel de technische mogelijkheden van Deepseek R1 alom geprezen zijn, heeft het model ook een controle over de potentiële links naar de gepatenteerde gegevens van Openai getrokken.//www.bloomberg.com/news/articles/2025-01-29/microsoft-probing-if-deepseek-linked-groep-Improperly-Obtained-openai-data”> Acorcording to Bloomberg , Microsoft Security Researchers gedetecteerd een ongebruikelijke piek in OpenAI API-verkeer afkomstig van ontwikkelaarsaccounts die eind 2024 aan China zijn gekoppeld.

Het rapport heeft bezorgdheid geuit dat door OpenAI gegenereerde outputs kunnen zijn gebruikt om concurrerende AI-modellen te trainen tegen een fractie van de kosten vereist om een funderingsmodel helemaal opnieuw te ontwikkelen.

Noch Openai noch Microsoft heeft publiekelijk bevestigd of Deepseek direct betrokken was bij deze gegevenstoegang. Openai heeft echter erkend dat het API-gebruikspatronen actief beoordeelt en al strengere API-beleid heeft geïmplementeerd om grootschalige gegevensextractie door externe ontwikkelaars te voorkomen.

Het onderzoek is aan de gang en OpenAI heeft niet aangegeven of het juridische stappen zal ondernemen of verdere beperkingen op de toegang tot zijn modellen zal introduceren.

Deepseek R1’s trainingsefficiëntie en marktimpact

Deepseek R1 onderscheidt zich in de AI-industrie voor zijn vermogen om hoge redeneerprestaties te bereiken en tegelijkertijd minder computationele bronnen te gebruiken dan concurrerende modellen van Openai en Google DeepMind.

In tegenstelling tot de nieuwste systemen van Openai, die uitgebreide GPU-clusters vereisen, werd Deepseek R1 getraind op 2.048 NVIDIA H800 GPU’s, een model dat is ontworpen om te voldoen aan de Amerikaanse handelsbeperkingen op AI Hardware Export naar China. De efficiëntie van het model heeft bijgedragen aan een tijdelijke daling van de aandelen van Nvidia, die met bijna $ 600 miljard daalde, omdat beleggers de langetermijnvraag naar hoogwaardige AI-chips opnieuw beoordeelden. Hardware-afhankelijkheid voor modeltraining. Hoewel modellen zoals GPT-4 enorme computationele infrastructuur vereisten, suggereert het vermogen van Deepseek R1 om complexe redeneringstaken uit te voeren met een kleinere GPU-voetafdruk een alternatieve benadering van AI-training die hoogwaardige modellen toegankelijker zou kunnen maken voor een breder scala van ontwikkelaars.

U.S. en Europese toezichthouders onderzoeken Deepseek AI

Deepseek R1 heeft ook de aandacht getrokken van overheidsinstanties en regelgevende instanties vanwege zorgen over gegevensbeveiliging en naleving van internationale privacywetten en voor de toegepaste CCP-censuur voor bepaalde onderwerpen voor bepaalde onderwerpen voor bepaalde onderwerpen voor bepaalde onderwerpen voor bepaalde onderwerpen voor bepaalde onderwerpen zoals de 1989 Tiananmen Square protesten en massa of het Chinese leiderschap in algemeen. R1 wordt onderzocht voor mogelijke schendingen van de algemene verordening gegevensbescherming (AVG). De Italiaanse gegevensbeschermingsautoriteit, Garante, heeft een onderzoek gestart naar de vraag of DeepSeek Europese gebruikersgegevens overdraagt naar China zonder adequate waarborgen of openbaarmakingen.

Als het onderzoek vaststelt dat Deepseek niet heeft nageleefd aan de GDPR-vereisten, kan het bedrijf boetes of beperkingen maken op zijn vermogen om te opereren in Europese markten.

De toegenomen regelgevende focus op deepseek AI weerspiegelt de groeiende bezorgdheid over de veiligheid en transparantie van AI-modellen die zijn ontwikkeld buiten de Verenigde Staten en Europa.

Naast deze gegevensbeveiliging en regelgevende kwesties heeft DeepSeek R1 hun bezorgdheid geuit over de moderatie van inhoud en potentiële censuur. An Analyse uitgevoerd door NewsGuard vond dat het model zware filtering vertoonde over politiek gevoelige onderwerpen.

De studie meldde dat Deepseek R1 weigerde te antwoorden 85 Percentage vragen met betrekking tot China, met name die met betrekking tot governance, mensenrechten en historische gebeurtenissen. Bovendien gaf het model onvolledige of misleidende reacties in 83 procent van de op feiten gebaseerde nieuwsaanwijzingen, waardoor de bezorgdheid geuit over de vraag of de matiging van de Chinese overheidsbeperkingen op informatie-toegang is. Implementeer aanvullende maatregelen voor inhoudsmatigheid voor Deepseek R1 voordat het volledig wordt geïntegreerd in zijn AI-ecosysteem. De bevindingen van de NewsGuard-studie suggereren dat ondernemingen die Deepseek R1 implementeren op de hoogte moeten zijn van mogelijke beperkingen in het vermogen van het model om onbevooroordeelde informatie te verstrekken.

De Amerikaanse marine heeft onlangs een richtlijn uitgegeven die het gebruik van Deepseek AI-modellen in beide verbiedt Officiële en persoonlijke instellingen, onder verwijzing naar beveiligingsrisico’s in verband met het gegevensbeleid van China. De verhuizing maakt deel uit van een bredere inspanning van Amerikaanse defensie-agentschappen om het gebruik van buitenlands ontwikkelde AI-systemen in gevoelige operaties te beperken.

Hoewel Microsoft heeft benadrukt dat Deepseek R1 beveiligingsbeoordelingen heeft doorgegeven voordat hij werd toegevoegd aan Azure AI Foundry, suggereert de lopende regelgevende onderzoeken dat ondernemingen die het model gebruiken nog steeds geconfronteerd kunnen worden met nalevingsuitdagingen.

Microsoft’s groeiende AI-modelportfolio en zijn risico’s

Door Deepseek R1 toe te voegen aan Azure AI Foundry, diversifieert Microsoft zijn AI-aanbiedingen verder om bedrijven meerdere modelkeuzes te bieden.

Het bedrijf heeft het belang benadrukt van het ondersteunen van een breed scala aan AI-modellen zodat ontwikkelaars de meest geschikte technologie voor hun specifieke behoeften kunnen selecteren. However, the inclusion of DeepSeek R1 while an OpenAI investigation is ongoing has raised questions about Microsoft’s vetting process for AI partnerships and its approach to managing potential data security risks.

As OpenAI continues to review API usage patterns, Microsoft’s De rol bij het evalueren van de integriteit van AI-modellen die op zijn cloudservices worden gehost waarschijnlijk zal worden geconfronteerd met een groter onderzoek.