Nvidia heeft een reeks tools aangekondigd om tegemoet te komen aan de groeiende behoefte aan vertrouwen, beveiliging en betrouwbaarheid in agentische AI-systemen.

Bekend als Nvidia Inference Microservices (NIMs), het nieuwe aanbod zijn ontworpen om bedrijven te helpen AI-toepassingen te implementeren die voldoen aan de veiligheidsrichtlijnen en onbedoelde resultaten voorkomen.

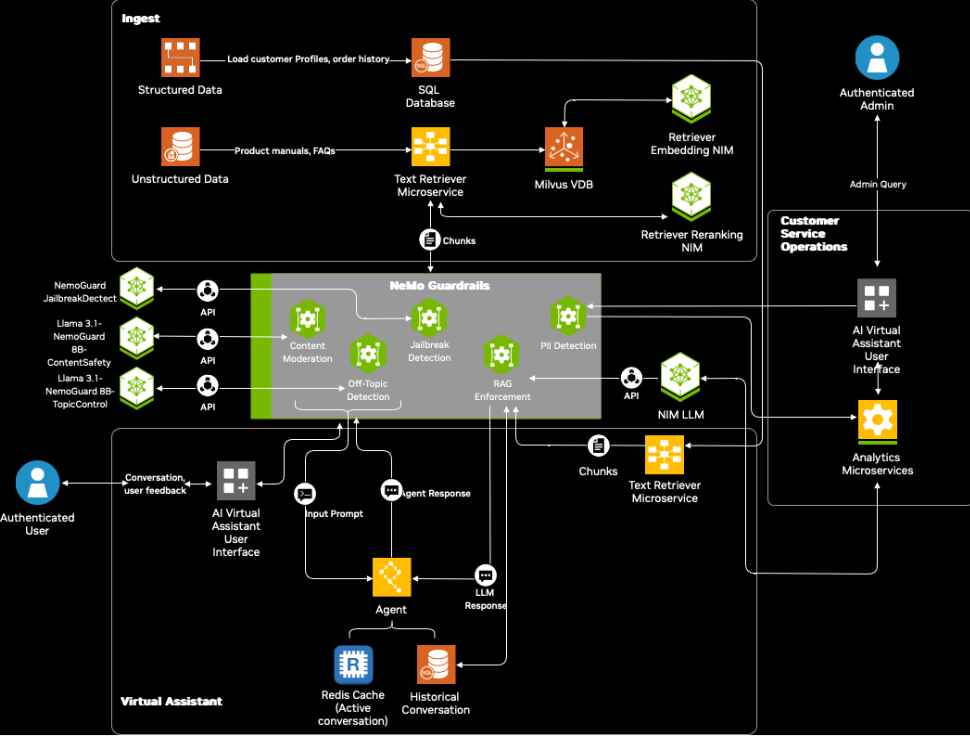

Als onderdeel van het NeMo Guardrails-framework bieden deze microservices gespecialiseerde oplossingen voor het modereren van inhoud, het onderhouden gespreksgrenzen en het detecteren van pogingen om beveiligingsmaatregelen te omzeilen.

Kari Briski, Vice President voor Enterprise AI Models bij Nvidia, benadrukte het belang van het garanderen van AI-veiligheid in de hedendaagse toepassingen. “AI-agenten transformeren industrieën snel door interacties te automatiseren, maar het garanderen van de veiligheid en betrouwbaarheid ervan is van cruciaal belang”, verklaarde ze in de officiële aankondiging.

[embedded content]

AI-veiligheidsuitdagingen aanpakken met gespecialiseerde microservices

Agentic AI, een vorm van kunstmatige intelligentie die autonoom taken uitvoert, wordt steeds vaker toegepast in sectoren als de detailhandel, de gezondheidszorg en de automobielsector.

Terwijl deze systemen de efficiëntie vergroten En op het gebied van klantbetrokkenheid uiten ze ook zorgen over schadelijke resultaten, gegevensprivacy en vijandige kwetsbaarheden. Ze streven ernaar deze risico’s te beperken met drie gerichte oplossingen:

De Content Safety NIM, getraind op de eigen Aegis Content Safety Dataset, is ontworpen om ongepaste content te detecteren en te blokkeren of schadelijke resultaten van AI-systemen. Deze dataset, die bestaat uit meer dan 35.000 door mensen geannoteerde monsters, stelt modellen in staat om giftige inhoud effectief te identificeren en erop te reageren.

Gerelateerd: NVIDIA bevordert Agentic AI met Llama-en Cosmos Nemotron-modellen

Nvidia is van plan de dataset later dit jaar openbaar beschikbaar te maken via Hugging Face, waarmee toegankelijkheid voor ontwikkelaars en onderzoekers.

Het Onderwerpbeheer NIM zorgt ervoor dat door AI gegenereerde interacties binnen gedefinieerde grenzen blijven, waardoor wordt voorkomen dat systemen afglijden naar irrelevante of ongeautoriseerde onderwerpen. Deze tool is vooral handig in klantenservicescenario’s waarbij consistente en contextueel relevante reacties essentieel zijn.

De Jailbreak Detection NIM pakt de groeiende bezorgdheid over vijandige aanvallen aan. Door invoer te analyseren op basis van een dataset van 17.000 bekende jailbreakpogingen, identificeert en blokkeert de microservice kwaadaardige aanwijzingen die zijn ontworpen om systeembeveiligingen te omzeilen.

Stroomdiagram van beveilig intelligente virtuele AI-assistenten voor klantenservice met NeMo Guardrails (Afbeelding: Nvidia)

Stroomdiagram van beveilig intelligente virtuele AI-assistenten voor klantenservice met NeMo Guardrails (Afbeelding: Nvidia)

Briski benadrukte de efficiëntie van deze tools en zei: “Kleine modellen zoals die in de NeMo Guardrails-verzameling biedt een lagere latentie, waardoor naadloze integratie mogelijk is in omgevingen met beperkte middelen, zoals magazijnen of ziekenhuizen.”

De balans tussen AI-veiligheid en prestaties

Een cruciaal aspect van Nvidia’s aanpak is het balanceren van de behoefte aan veiligheid met de vraag naar hoge prestaties. Nvidia zegt dat vroege tests aantonen dat de nieuwe microservices slechts ongeveer een halve seconde latentie toevoegen terwijl de veiligheidsmaatregelen met 50% worden verbeterd.

Gerelateerd: NVIDIA onthult Fugatto AI-model voor muziek, stemmen en geluidseffecten

Dit optimalisatieniveau pakt een van de meest voorkomende problemen bij zakelijke AI aan —waarborgen van snelle reactietijden zonder de veiligheid in gevaar te brengen.

“Afhankelijk van de gebruikersinteractie kunnen er veel verschillende LLM’s of interacties worden uitgevoerd, en je moet ze allemaal bewaken”, zegt Kari Briski.

>

Gebruiksscenario’s voor bedrijven en acceptatie door de industrie

Verschillende grote ondernemingen hebben NeMo Guardrails al in hun AI-workflows opgenomen om de veiligheid en betrouwbaarheid te verbeteren, bijvoorbeeld Lowe’s, de woningverbeteringswinkel , gebruikt deze tools om klantinteracties te verbeteren en de nauwkeurigheid van door AI gegenereerde reacties te garanderen.

Cerence AI, een leider op het gebied van AI in de auto-industrie, maakt gebruik van de microservices om assistent-technologieën in de auto aan te drijven. “NeMo Guardrails helpt ons betrouwbare, bewuste en hallucinatievrije reacties te leveren, waardoor onze modellen worden beschermd tegen schadelijke resultaten”, legt Nils Schanz, Executive Vice President of Product and Technology bij Cerence AI uit.

Gerelateerd: Microsoft schrapt Nvidia GB200-bestellingen, geeft prioriteit aan GB300 te midden van productievertragingen

Bovendien gebruiken bedrijven als Amdocs en Taskus deze tools om veiliger en betrouwbaarder te creëren AI-systemen voor klantbetrokkenheid en ondersteuning. Amdocs, een wereldwijde leverancier van software voor communicatie en media, gebruikt NeMo Guardrails om AI-gestuurde klantinteracties te verbeteren.

Open-source initiatieven en bredere implicaties

Om ontwikkelaars te ondersteunen bij het testen en verbeteren van de AI-veiligheid heeft Nvidia Garak geïntroduceerd, een open-source toolkit voor het identificeren kwetsbaarheden in AI-systemen.

Garak simuleert vijandige scenario’s, inclusief snelle injecties en jailbreakpogingen, waardoor organisaties hun AI-modellen kunnen versterken tegen potentiële bedreigingen.

Ontwikkelaars hebben ook toegang tot gedetailleerde tutorials en referentieblauwdrukken om de implementatie van NeMo Guardrails en microservices te stroomlijnen. Deze bronnen bestrijken een verscheidenheid aan gebruiksscenario’s, van chatbots voor de klantenservice tot geautomatiseerde assistenten in de detailhandel en de gezondheidszorg.