Een door GitHub gehost project biedt een samengesteld robots.txt-bestand dat is ontworpen om te voorkomen dat bekende AI-crawlers toegang krijgen tot website-inhoud.

Het initiatief genaamd ai.robots.txt is bedoeld om online materiaal te beschermen niet worden gebruikt om zonder toestemming grote taalmodellen (LLM’s) te trainen.

Door een eenvoudig bestand aan te bieden met een lijst van bekende AI-crawlers die zijn geconfigureerd voor blokkering, nodigt het project ontwikkelaars uit om meer controle over hun gegevens uit te oefenen en moedigt het AI-bedrijven aan om zich aan ethische praktijken te houden.

Het project weerspiegelt de groeiende frustratie onder ontwikkelaars en uitgevers over de ondoorzichtige methoden die AI-systemen gebruiken om trainingsgegevens. Hoewel het de naleving niet kan afdwingen, plaatst hun samengestelde robots.txt de schijnwerpers op de ethische verantwoordelijkheden van AI-bedrijven terwijl hun technologieën het internet opnieuw vormgeven.

Hoe de samengestelde Robots.txt werkt

Het aangeboden robots.txt-bestand bevat een open-sourcelijst met namen van gebruikersagenten die zijn gekoppeld aan AI-crawlers, deels afkomstig van Dark Visitors, een initiatief dat botactiviteit bijhoudt.

Ontwikkelaars worden aangemoedigd updates bij te dragen door pull-aanvragen in te dienen op GitHub, zodat de lijst actueel blijft als er nieuwe bots verschijnen. Hoewel het afhankelijk is van de vrijwillige medewerking van AI-bedrijven, biedt het project een broodnodige tool voor site-eigenaren die willen beheren hoe hun inhoud wordt benaderd en gebruikt.

Terwijl het samengestelde robots.txt-bestand een waardevol hulpmiddel biedt voor ontwikkelaars wordt de effectiviteit ervan beperkt door de afhankelijkheid van vrijwillige naleving. Veel AI-crawlers opereren buiten de ethische grenzen die worden gerespecteerd door traditionele webcrawlers zoals Googlebot.

Geavanceerde technieken zoals headless browsen, waarmee bots menselijk gedrag kunnen nabootsen, maken het moeilijker om ongeautoriseerde toegang te identificeren en te blokkeren.

Maatregelen aan de serverzijde, zoals IP-blokkering en aangepaste firewallregels bieden extra bescherming, maar zijn niet onfeilbaar.

Steeds meer crawlers oogsten AI

Microsoft’s Bing-crawler respecteert naar verluidt robots.txt voor zijn zoekindex, zoals duidelijk werd toen Reddit zijn inhoud exclusief aan Google begon aan te bieden en andere zoekmachines zoals Bing en DuckDuckGo blokkeerde. Dit ging echter vooral over het crawlen van pagina’s voor zoeken en niet over het trainen van Large Language Models (LLM’s).

Zoals het geval van Meta laat zien, schrikken grote technologiebedrijven er niet voor terug om duistere tactieken te gebruiken om gegevens te verkrijgen hun AI-training. Het bedrijf heeft naar verluidt ongeautoriseerde datasets met illegale boeken en wetenschappelijke artikelen gebruikt.

YouTube-makers worden op een vergelijkbare manier getroffen, zoals blijkt uit rechtszaken die zijn aangespannen tegen de Google-dochtermaatschappij en Nvidia, waarin wordt beweerd dat ze zonder toestemming video’s hebben gebruikt voor AI-training.

Perplexity AI: Een geval met nalevingsproblemen

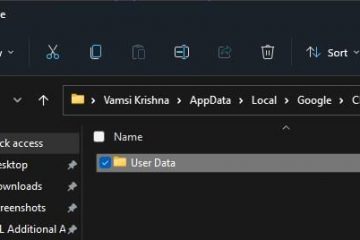

De behoefte aan geavanceerde crawling-botblokkering werd vorig jaar vooral duidelijk door incidenten waarbij Perplexity AI betrokken was. Ontwikkelaar Robb Knight ontdekte dat Perplexity AI toegang kreeg tot inhoud van zijn websites, Radweb en MacStories, ondanks expliciete robots.txt-richtlijnen en server-side blocks die waren geconfigureerd om’403 Forbidden’-reacties te retourneren.

Een analyse van serverlogboeken onthulde dat PerplexityBot misleidende technieken gebruikte om de beperkingen te omzeilen, zoals het werken via headless browsers en het maskeren van de identiteit met veelgebruikte user-agent-strings zoals Google Chrome op Windows het om detectie te omzeilen tijdens het scrapen van beperkte inhoud. Aanvankelijk ontkende Perplexity AI de mogelijkheid om deze beperkingen te omzeilen. Later gaven ze echter toe dat ze ethische fouten hadden gemaakt en verklaarden:”Het samenvatten van beperkte inhoud had niet mogen gebeuren.”

MacStories.’Federico Viticci bevestigde de bevindingen van Knight en legde uit dat er aanvullende maatregelen op serverniveau waren geïmplementeerd om PerplexityBot te blokkeren. Zelfs deze geavanceerde beveiligingen waren echter niet onfeilbaar, wat de moeilijkheid benadrukt om de naleving van ethische normen bij het webcrawlen te garanderen.

In het geval van Perplexity AI merkte Knight op dat zijn IP-bereiken niet overeenkwamen met enig publiek bekend bedrijfseigendom adressen, waardoor de handhavingsinspanningen nog ingewikkelder worden. Dit benadrukt de behoefte aan robuustere tools en regelgevingskaders om de uitdagingen van steeds geavanceerdere AI-bots aan te pakken.

Verbijstering is echter niet de enige in deze praktijk, zoals blijkt uit het toenemende aantal auteursrechtzaken tegen AI-ontwikkelaars. De New York Times is verwikkeld in een dure rechtszaak tegen Microsoft en OpenAI wegens diefstal van inhoud.

De zaak is slechts één voorbeeld van een grotere golf van ontevredenheid onder de media, die hebben opgeroepen tot strengere normen voor het beheer van AI gegevensverzameling.