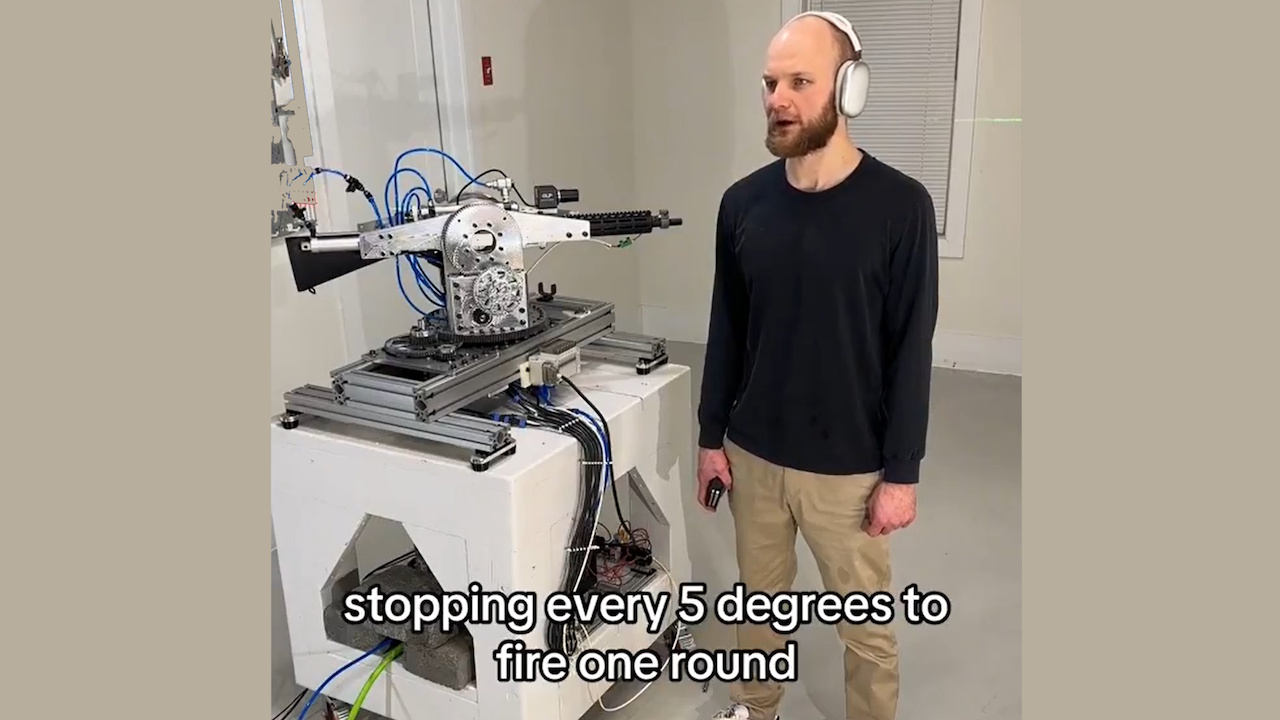

OpenAI heeft de API-toegang ingetrokken voor een ontwikkelaar die de Realtime API gebruikte om een autonoom geweersysteem aan te drijven. Het project, waarbij een robotkoepel was uitgerust met een geweer, kon verbale commando’s interpreteren en gesimuleerde schietacties uitvoeren.

Het incident onderstreept de groeiende bezorgdheid over het potentiële misbruik van kunstmatige intelligentie bij de ontwikkeling van autonome wapens, waardoor ethische en veiligheidsvragen rijzen.

De ontwikkelaar, online bekend als “STS Innovations LLC,” deelde online video’s van het systeem, waarin de functionaliteit ervan werd gedemonstreerd. In één clip gaf de ontwikkelaar het commando:”ChatGPT, we worden aangevallen door de linksvoor en rechtsvoor”, waarop de De koepel reageerde onmiddellijk, draaide en vuurde losse flodders af in specifieke richtingen.

Richt/vuur-simulatie met laser #robotics #electronics

Een gesynthetiseerde stem toegevoegd: “Als je Als u meer hulp nodig heeft, laat het me dan weten.”De huiveringwekkende demonstratie benadrukte hoe AI-tools van consumentenkwaliteit eenvoudig kunnen worden aangepast voor potentieel schadelijk gebruik.

Update over het trackingsysteem #robotics #vision #electronics

OpenAI’s snelle beleidshandhaving

OpenAI, bekend om zijn strikte beleid tegen het gebruik van zijn technologie bij bewapening, reageerde onmiddellijk. Een woordvoerder legde uit:”We hebben deze schending van ons beleid proactief geïdentificeerd en de ontwikkelaar op de hoogte gebracht om deze activiteit te staken voordat we uw verzoek ontvingen.”

Het bedrijf benadrukte zijn verbod op het gebruik van zijn tools om wapens te maken of te bedienen of automatiseer systemen die risico’s kunnen opleveren voor de persoonlijke veiligheid.

Terugslagbeheersysteem, snelle demo #robotics #electronics #cnc

De Realtime API, een hulpmiddel ontworpen voor interactieve toepassingen, stelde de ontwikkelaar in staat natuurlijke taalopdrachten om te zetten in bruikbare input voor de robottoren.

Hoewel de API bedoeld is voor nuttige gebruiksscenario’s, zoals het verbeteren van de toegankelijkheid of het verbeteren van klantinteracties, demonstreert dit misbruik de uitdagingen van het reguleren van technologieën voor tweeërlei gebruik.

Gerelateerd: OpenAI en Anduril Forge-partnerschap voor Amerikaanse militaire drone-verdediging

Bredere implicaties voor AI en bewapening

Deze zaak heeft de debatten over de ethiek van autonome wapens. Deze systemen, die in staat zijn doelwitten te selecteren en aan te vallen zonder menselijk toezicht, brengen complexe juridische en morele uitdagingen met zich mee.

De Verenigde Naties pleiten al lang voor strengere regels voor AI in oorlogsvoering, waarbij ze waarschuwen dat autonome systemen internationale wetten zouden kunnen schenden en de verantwoordelijkheid zouden kunnen verminderen.

Gerelateerd: Antropisch Partners met Palantir, AWS voor AI in de Amerikaanse inlichtingen-en militaire dienst

Een rapport uit de Washington Post bevatte onlangs verontrustende voorbeelden van de inzet van AI in het leger operaties, waaronder beweringen dat Israël AI gebruikte om bombardementsdoelen te selecteren.

Het rapport merkte op: “Op bepaalde momenten was de enige vereiste bevestiging dat het doelwit een man was.” Dergelijke gevallen benadrukken de risico’s van het vertrouwen op AI bij beslissingen over leven of dood en het potentieel voor willekeurige geweld.

Gerelateerd: Groene Beret gebruikte ChatGPT voor Cybertruck Blast, politie geeft chatlogs vrij

De rol van OpenAI in de verdediging Technologieën

Terwijl OpenAI beleid handhaaft dat bewapening verbiedt, roept de samenwerking met Anduril Industries – een bedrijf dat gespecialiseerd is in AI-gestuurde defensieoplossingen – vragen op over zijn standpunt heeft tot doel de intelligentie op het slagveld te verbeteren en de verdedigingssystemen van drones te verbeteren. OpenAI beschrijft deze inspanningen als defensief, maar critici beweren dat ze bijdragen aan de bredere militarisering van AI-technologieën.

De Amerikaanse defensiesector, ondersteund door een jaarlijkse begroting. bijna $1 biljoen dollar, vertrouwt steeds meer op geavanceerde technologieën om een strategische voorsprong te verwerven. Dit groeiende kruispunt tussen AI-bedrijven en militaire toepassingen benadrukt de uitdagingen van het balanceren van technologische innovatie met ethische overwegingen.

Gerelateerd: Nieuw AI-consortium van Palantir-Anduril om gaten in Amerikaanse defensiegegevens aan te pakken

DIY-bewapenings-en toegankelijkheidsrisico’s

Het gemak waarmee individuen AI-hulpmiddelen kunnen misbruiken en Andere technologieën zoals 3D-printen verergeren het probleem. Wetshandhavers zijn al gevallen tegengekomen van doe-het-zelf-bewapening, zoals de vermeende acties van Luigi Mangione, die heeft naar verluidt 3D-geprinte onderdelen gebruikt om vuurwapens in elkaar te zetten. Deze technologieën verlagen de barrières voor individuen om autonome systemen met dodelijk potentieel te creëren.

Het project van STS 3D laat zien hoe toegankelijke AI-tools kunnen worden aangepast voor onbedoelde doeleinden. De beslissende actie van OpenAI in dit geval demonstreert zijn toewijding aan het voorkomen van misbruik, maar onderstreept ook de moeilijkheid om volledig te controleren hoe zijn technologieën worden ingezet zodra ze het publieke domein betreden.

Het incident roept bredere vragen op over het bestuur van OpenAI AI-technologieën. Voorstanders van regulering benadrukken de noodzaak van duidelijke mondiale normen om ervoor te zorgen dat de ontwikkeling van AI in lijn ligt met ethische principes. Het bereiken van consensus tussen landen met verschillende belangen en prioriteiten blijft echter een enorme opgave.