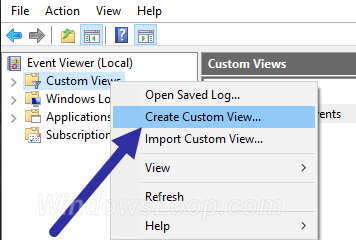

OpenAI kelihatan bersiap untuk memperkenalkan halangan baru yang penting bagi pemaju yang ingin mengakses model AI masa depan yang paling berkuasa melalui API: keperluan yang berpotensi untuk organisasi untuk menjalani pengesahan identiti menggunakan ID yang dikeluarkan oleh kerajaan. Target=”_ Blank”> Page Sokongan Terbuka Minggu lepas Huraikan proses”organisasi yang disahkan”, yang dibingkai oleh syarikat sebagai langkah yang perlu untuk mengatasi penyalahgunaan dan mempromosikan penggunaan AI yang bertanggungjawab. Openai mencadangkan ini mensasarkan”minoriti kecil”dengan sengaja melanggar dasar penggunaannya, yang bertujuan untuk”mengurangkan penggunaan AI yang tidak selamat sambil terus membuat model maju yang tersedia untuk komuniti pemaju yang lebih luas. mengenai kriteria tertentu.

Sistem yang dicadangkan telah menghasilkan perbincangan di kalangan pemaju dalam talian. Pusat kebimbangan mengenai geseran operasi tambahan, pertimbangan privasi untuk mengemukakan pengenalan kerajaan, potensi pengecualian pengguna di kawasan di luar

Metodologi ujian khusus juga dibakar. Pengkritik menunjuk kepada kekurangan hasil yang diterbitkan untuk penyalahgunaan ujian potensi menggunakan penalaan halus-latihan selanjutnya mengenai data khusus untuk meneliti keupayaan muncul yang berbahaya-pada model terbaru yang paling berkemampuan seperti O1 atau O3-Mini. href=”https://aisafety.substack.com/p/customized-models-catastrophic-rissks”target=”_ blank”> Dalam post blog Geseran yang jelas antara halaju pembangunan dan berhati-hati bukan wilayah baru untuk OpenAI. Perselisihan dalaman telah ditegaskan oleh pemergian Jan Leike Mei 2024, kemudian memimpin bersama pasukan superalignment yang berpusatkan risiko jangka panjang, yang secara umum menyatakan bahawa”budaya dan proses keselamatan telah mengambil alih produk yang dibuka oleh syarikat.”Ringkasnya membantah pergeseran terbuka ke arah struktur untung yang dihadkan menyimpang dari misi bukan keuntungan yang menubuhkan, yang berpotensi memberi kesan kepada komitmen keselamatan dan peruntukan sumber. struktur keselamatan AGI global. Ini berlaku terhadap latar belakang peraturan yang baru muncul seperti Akta AI EU, penemuan kelemahan model dan teknik-teknik Openai yang berpengaruh, dan”kestabilan semasa pelancaran baru.