bytedance telah melancarkan omnihuman-1, sistem yang dapat mencipta kandungan video manusia yang boleh dipercayai dari satu imej rujukan dan audio yang disertakan.

mensintesis pelbagai output video. Penulis menerangkan pendekatan mereka dalam kertas penyelidikan omnihuman-1: Memikirkan semula model animasi manusia yang dikondisikan satu peringkat !

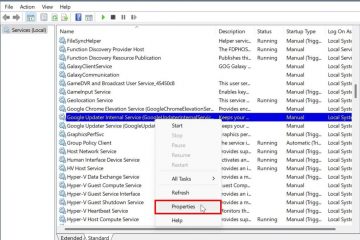

Data pencampuran dan contoh yang ketara

omnihuman-1 dibina di atas arsitektur pengubah penyebaran (DIT), model yang menggabungkan keupayaan penyebaran model penyebaran dengan kecekapan pengendalian urutan transformer.

3d variasi autoencoder (3d vae) untuk mengodkan urutan video ke dalam ruang laten yang dimampatkan, yang membolehkan pemprosesan yang efisien sambil mengekalkan koheren temporal.

Model mengintegrasikan pelbagai isyarat penyaman-teks, audio, dan pose-leveraging Classifier-Panduan Percuma (CFG) Untuk mengimbangi realisme dan kepatuhan kepada isyarat input. Seni bina juga termasuk guider pose yang menyandarkan heatmaps gerakan untuk kawalan halus, sementara encoder penampilan mengekstrak identiti dan butiran latar belakang dari imej rujukan menggunakan MMDIT yang diubahsuai (pengubah penyebaran pemodelan bertopeng).

Omnihuman mengamalkan”strategi latihan omni-conditions”untuk meld, audio, dan menimbulkan isyarat ke dalam aliran kerja tunggal./P>

Di dalam kertas, penulis menyatakan,”Omnihuman menghasilkan video yang sangat realistik dengan sebarang nisbah aspek dan perkadaran badan, dan dengan ketara meningkatkan penjanaan isyarat dan interaksi objek ke atas kaedah yang sedia ada, disebabkan oleh data yang diaktifkan oleh OMNI Latihan Syarat.”

Ujian menguatkan tuntutan tersebut, termasuk demonstrasi yang menarik seperti Prestasi Taylor Swift fiksyen dan klip mendedahkan gerak isyarat ganjil di sekitar kaca wain , yang menunjukkan sifat yang meyakinkan dan output kebiasaan yang timbul dengan pose tertentu.

[Kandungan tertanam]

penanda aras dan penunjuk prestasi

model utama

terkemuka dalam kedua-dua tugas animasi potret dan badan menggunakan model tunggal”, menurut penyelidik yang berkongsi jadual perbandingan berikut. sadtalker dan Hallo-3 -Dalam beberapa metrik, termasuk FID, FVD, IQA, dan Sync-C.

source: bytedance

nisbah seimbang 50% untuk kedua Berfungsi: Terlalu banyak audio sahaja menyempitkan pelbagai pergerakan, sedangkan overemphasis pada pose membawa kepada gerak isyarat tegar. Berikut adalah contoh lain.

[Kandungan Terbenam]

Kelebihan ini dalam mewujudkan urutan dinamik sesuai dengan perdebatan yang berterusan mengenai penjanaan video AI dan DeepFake, terutamanya kerana orang awam meneliti visual yang dihasilkan secara sintetik. Trumporbiden2024 perdebatan yang tidak terkenal dari tahun lepas menggariskan bagaimana kandungan tersebut dapat mencetuskan rasa ingin tahu dan kebimbangan mengenai keaslian.

P> Omnihuman-1 tanah dalam iklim di mana media sintetik menarik perhatian dari penggubal dasar dan syarikat. The Komitmen keselamatan White House mencerminkan pemacu yang lebih luas untuk menangani penyalahgunaan DeepFake, sementara pelabelan mandatori Meta AI isyarat utama platform utama dengan masalah.

tahun lepas, Pihak berkuasa diperluas FTC untuk meminta dokumen yang berkaitan dengan AI menaikkan kepentingan untuk ketelusan. Google telah memperluaskan teknologi watermarking AI, sintetik, untuk memasukkan teks dan video yang dihasilkan AI. Dan Disember lalu, Meta mengumumkan Meta Video Seal, alat sumber terbuka baru yang direka untuk melayari video AI-Generated. Meterai video menyematkan tanda air yang tidak dapat dilihat namun teguh yang berterusan melalui pengeditan, pemampatan, dan perkongsian, menjadikannya dapat mengesan dan mengesahkan kandungan.

Watermark menggariskan tumpuan yang semakin meningkat pada keaslian.

meta sudah label imej yang dihasilkan AI dengan”dibayangkan dengan AI”untuk mengekang maklumat salah, tetapi ini hanya berfungsi jika mekanisme pengesanan asas berfungsi atau jika AI menghasilkan video imej adalah video Watermarked. v=v_zjvrmhzoi”> Ted talk yang berpura-pura dan Kuliah Einstein Deepfake Kapasiti gerakan yang luas-dan kebiasaan sekali-sekala apabila mengendalikan tangan atau alat peraga.

[Kandungan tertanam]

pemerhati mengatakan ini menggariskan mengapa perbincangan yang lebih luas mengenai tanda air dan alat pengesanan AI adalah penting untuk memastikan Ciptaan sintetik daripada menyebabkan kemudaratan yang tidak diingini.

Dengan menawarkan gerakan kesetiaan tinggi dan nisbah aspek fleksibel, Omnihuman-1 berdiri terpisah daripada pergantungan awal pada dataset yang ditapis sempit. Eksperimen nisbah latihannya mengesahkan bahawa mencampurkan isyarat yang kuat dan lemah-prestasi, audio, dan teks teks yang lebih baik, yang terbukti dalam skor Lower FID dan FVD daripada yang Sadtalker atau Hallo-3.

Sadtalker adalah Alat yang didorong oleh AI yang direka untuk menghidupkan imej statik dengan menghasilkan pekali gerakan 3D yang realistik dari input audio. Dengan menganalisis audio yang disediakan, ia meramalkan pergerakan muka yang sepadan, membolehkan penciptaan animasi bercakap seperti hidup dari satu imej. Pendekatan ini membolehkan penjanaan animasi muka bercakap yang digerakkan, yang didorong oleh audio, meningkatkan realisme dan ekspresi output. animasi dinamik dan realistik. Ia menggunakan model generatif video berasaskan transformer yang pretrained, yang menunjukkan keupayaan generalisasi yang kuat di pelbagai senario. Alat yang dapat dengan cepat beralih antara hiburan, pendidikan, dan kandungan yang berpotensi sensitif, semua sementara pengawal selia dan pemain teknologi tetap berjaga-jaga perkembangan DeepFake.

tahun lepas, Pihak berkuasa diperluas FTC untuk meminta dokumen yang berkaitan dengan AI menaikkan kepentingan untuk ketelusan. Google telah memperluaskan teknologi watermarking AI, sintetik, untuk memasukkan teks dan video yang dihasilkan AI. Dan Disember lalu, Meta mengumumkan Meta Video Seal, alat sumber terbuka baru yang direka untuk melayari video AI-Generated. Meterai video menyematkan tanda air yang tidak dapat dilihat namun teguh yang berterusan melalui pengeditan, pemampatan, dan perkongsian, menjadikannya dapat mengesan dan mengesahkan kandungan.

Watermark menggariskan tumpuan yang semakin meningkat pada keaslian.

meta sudah label imej yang dihasilkan AI dengan”dibayangkan dengan AI”untuk mengekang maklumat salah, tetapi ini hanya berfungsi jika mekanisme pengesanan asas berfungsi atau jika AI menghasilkan video imej adalah video Watermarked. v=v_zjvrmhzoi”> Ted talk yang berpura-pura dan Kuliah Einstein Deepfake Kapasiti gerakan yang luas-dan kebiasaan sekali-sekala apabila mengendalikan tangan atau alat peraga.

[Kandungan tertanam]

pemerhati mengatakan ini menggariskan mengapa perbincangan yang lebih luas mengenai tanda air dan alat pengesanan AI adalah penting untuk memastikan Ciptaan sintetik daripada menyebabkan kemudaratan yang tidak diingini.

Dengan menawarkan gerakan kesetiaan tinggi dan nisbah aspek fleksibel, Omnihuman-1 berdiri terpisah daripada pergantungan awal pada dataset yang ditapis sempit. Eksperimen nisbah latihannya mengesahkan bahawa mencampurkan isyarat yang kuat dan lemah-prestasi, audio, dan teks teks yang lebih baik, yang terbukti dalam skor Lower FID dan FVD daripada yang Sadtalker atau Hallo-3.

Sadtalker adalah Alat yang didorong oleh AI yang direka untuk menghidupkan imej statik dengan menghasilkan pekali gerakan 3D yang realistik dari input audio. Dengan menganalisis audio yang disediakan, ia meramalkan pergerakan muka yang sepadan, membolehkan penciptaan animasi bercakap seperti hidup dari satu imej. Pendekatan ini membolehkan penjanaan animasi muka bercakap yang digerakkan, yang didorong oleh audio, meningkatkan realisme dan ekspresi output. animasi dinamik dan realistik. Ia menggunakan model generatif video berasaskan transformer yang pretrained, yang menunjukkan keupayaan generalisasi yang kuat di pelbagai senario. Alat yang dapat dengan cepat beralih antara hiburan, pendidikan, dan kandungan yang berpotensi sensitif, semua sementara pengawal selia dan pemain teknologi tetap berjaga-jaga perkembangan DeepFake.