Anthropic telah memperkenalkan sistem keselamatan baru untuk model Claude AInya, mengurangkan kadar kejayaan serangan jailbreak dari 86% kepada hanya 4.4%.

Perlindungan baru syarikat, yang dipanggil pengelas perlembagaan , direka untuk menapis kedua-dua arahan masuk dan Respons AI-Generated untuk mencegah percubaan manipulasi.

Walaupun sistem ini mewakili salah satu pertahanan keselamatan AI yang paling berkesan yang digunakan setakat ini, ia juga membawa perdagangan, termasuk kenaikan 23.7% dalam kos pengkomputeran dan kadang-kadang positif palsu yang menghalang pertanyaan yang sah.

Teknik kreatif untuk memintas sekatan terbina dalam. Penyerang telah berjaya mengeksploitasi kelemahan AI melalui kaedah seperti senario peranan dan helah pemformatan yang mengelirukan penapis kesederhanaan kandungan.

Berkaitan: Indeks Keselamatan AI 2024 Keputusan: Openai, Google, Meta, Xai Fall Short; Anthropic di atas

manakala pemaju AI secara konsisten menampal eksploitasi khusus, penyelidik telah memberi amaran bahawa tiada model AI Setakat ini telah tahan sepenuhnya terhadap jailbreaks.

Anthropic telah menjadi salah satu syarikat yang lebih vokal dalam keselamatan AI, meletakkan dirinya sebagai peguam bela untuk langkah-langkah keselamatan yang lebih ketat. Syarikat itu menduduki tempat tertinggi dalam Indeks Keselamatan AI 2024, melebihi pesaing seperti OpenAI, Google, dan Meta.

Walau bagaimanapun, apabila keupayaan AI berkembang, risiko yang berkaitan dengan jailbreaks terus berkembang, menjadikan strategi keselamatan preemptive lebih kritikal berbanding sebelum ini. Bandit Masa’Eksploitasi memintas Safeguard OpenAI Menggunakan Kekeliruan Masa

Mengapa jailbreaking AI Models adalah kebimbangan yang semakin meningkat

kebanyakan model AI mempunyai sekatan terbina dalam untuk mencegahnya Dari menghasilkan kandungan yang berkaitan dengan senjata, jenayah siber, atau topik terhad yang lain. Walau bagaimanapun, pengguna telah berulang kali mencari cara untuk mengelakkan perlindungan ini. Teknik Jailbreak Biasa termasuk:

Kejuruteraan Prompt , di mana penyerang mengarahkan AI untuk memainkan peranan sebagai watak fiksyen tanpa kekangan etika.

Memformat manipulasi , seperti memasukkan aksara khas atau mengubah struktur ayat untuk memintas penapis kandungan.Obfuscation berasaskan cipher , di mana teks dikodkan dengan cara yang model AI masih boleh mentafsir sementara lapisan keselamatan gagal mengesan permintaan itu.

Serangan jailbreak telah menjadi isu yang diketahui sejak sekurang-kurangnya 2013, ketika rangkaian saraf awal didapati terdedah kepada pertentangan. Walaupun penambahbaikan yang berterusan dalam keselamatan AI, para penyelidik masih belum membangunkan sistem yang sepenuhnya tahan terhadap teknik-teknik ini. Kelemahan

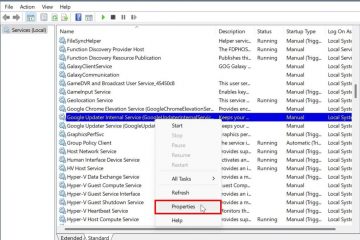

Pendekatan Anthropic berbeza dari usaha keselamatan AI sebelumnya dengan memperkenalkan penapis luaran dan bukannya mengubah model AI itu sendiri.

Dasar skala yang bertanggungjawab syarikat menggariskan keperluan untuk perlindungan yang dipertingkatkan sebelum menggunakan model yang lebih maju. Pengelas Perlembagaan adalah contoh bagaimana syarikat mengutamakan keselamatan kerana AI menjadi lebih canggih. Senibina model, antropik membangunkan pengelas perlembagaan sebagai sistem luaran yang memintas dan menilai kedua-dua input pengguna dan output AI-dihasilkan.

Pengelas bertindak sebagai penapis, menganalisis permintaan untuk corak yang menunjukkan percubaan jailbreak. Sekiranya pertanyaan dianggap mencurigakan, ia disekat sebelum mencapai model AI, menghalang respons yang tidak diingini. P>

Sistem ini dilatih menggunakan data sintetik, menggunakan contoh-contoh interaksi yang dihasilkan dan tidak dapat diterima, AI. Anthropic menggunakan pendekatan ini untuk mendedahkan pengelas kepada pelbagai teknik adversarial, termasuk variasi bahasa, sintaks, dan pemformatan.

Dataset ini diterjemahkan ke dalam pelbagai bahasa dan ditapis berdasarkan gaya eksploit yang diketahui, memastikan keberkesanan yang lebih luas. Sistem ini, ditekankan untuk

“Terdapat jailbreaks yang mendapat sedikit perkara yang berbahaya daripada model, seperti, mungkin mereka mendapat model untuk bersumpah,”kata Sharma.”Kemudian ada jailbreaks yang hanya mengubah mekanisme keselamatan Mati sepenuhnya.”

Menguji sistem: cabaran Jailbreak $ 15,000

Untuk mengesahkan keberkesanannya, antropik melancarkan program karunia bug, yang menawarkan $ 15,000 kepada sesiapa sahaja yang Boleh memaksa Claude untuk menjawab sepuluh soalan terhad. Cabaran itu menarik penyertaan dari 183 penguji, termasuk jailbreakers AI yang berpengalaman dan penyelidik keselamatan, yang secara kolektif menghabiskan lebih dari 3,000 jam untuk memintas sistem.

soalan terhad. Sesiapa yang paling dekat datang berjaya memintas penapis pada lima daripada sepuluh pertanyaan. Di samping itu, dalam ujian automatik yang berasingan, antropik menjalankan 10,000 percubaan Jailbreak AI yang dihasilkan AI terhadap pengelasnya.

Berkaitan: y0u ha5ε tu wr1tε l1ke thl5 untuk memecahkan Gpt-4o, Gemini Pro dan Claude 3.5 Sonnet Ai Safety Measures

tanpa lapisan pertahanan, Model gagal dalam 86% kes, memberikan respons yang sepatutnya disekat. Dengan pengelas di tempat, kadar kegagalan menurun kepada 4.4%.

Peningkatan kos

Walaupun pengelas perlembagaan antropik mewakili kemajuan utama dalam keselamatan AI, ia juga memperkenalkan beberapa isu utama.

Sesetengah pengguna melaporkan bahawa pengelas kadang-kadang menandakan soalan yang tidak berbahaya, terutamanya dalam bidang teknikal seperti biologi dan kimia. Maksudnya beberapa permintaan yang sah mungkin ditolak.

Satu lagi kebimbangan penting ialah permintaan pengiraan yang meningkat. Akibatnya, melaksanakan sistem menaikkan kos operasi sebanyak 23.7%. Ini boleh membuat penempatan lebih mahal, terutamanya untuk perusahaan yang menjalankan aplikasi AI berskala besar.

Walaupun kelemahan ini, antropik berpendapat bahawa peningkatan manfaat keselamatan melebihi perdagangan. Komitmen syarikat terhadap keselamatan AI telah menjadi ciri yang menentukan pendekatannya, seperti yang digariskan dalam dasar skala yang bertanggungjawab, yang mengarahkan penilaian keselamatan yang ketat sebelum melancarkan model AI yang lebih maju. Walau bagaimanapun, mengimbangi keselamatan dan kebolehgunaan kekal sebagai cabaran yang berterusan. dan badan pengawalseliaan meningkatkan pengawasan model AI mereka. Dengan kebimbangan mengenai maklumat salah maklumat AI, ancaman siber, dan kes penggunaan yang tidak dibenarkan, pengawal selia menolak untuk ketelusan dan protokol keselamatan yang lebih ketat. seperti Akta EU AI, yang bertujuan untuk mewujudkan garis panduan yang jelas untuk pengurusan risiko AI. Walau bagaimanapun, syarikat itu juga menghadapi pengawasan atas sebab-sebab lain, terutamanya mengenai perkongsian korporatnya. Pelaburan $ 2 bilion dari Google kini sedang disiasat oleh Pihak Berkuasa Pertandingan dan Pasaran UK (CMA), yang menilai sama ada sokongan kewangan tersebut memberikan pengaruh Google yang tidak wajar terhadap pembangunan AI.

Usaha pengawalseliaan ini mencerminkan kebimbangan yang semakin meningkat yang Sejumlah firma teknologi besar mungkin mendapat terlalu banyak kawalan ke atas inovasi AI. Walaupun Anthropic telah meletakkan dirinya sebagai peguam bela untuk AI yang bertanggungjawab, sumber pembiayaan dan perkongsiannya tetap menjadi topik perdebatan dalam kalangan industri dan dasar. Strong>

Walaupun kejayaannya menyekat jailbreaks yang paling terkenal, pengelas perlembagaan bukanlah masalah mutlak. Jailbreakers sentiasa membangunkan teknik-teknik baru untuk memanipulasi model AI, dan para penyelidik memberi amaran bahawa serangan masa depan mungkin menjadi lebih canggih. Itu membolehkan AI mentafsir mereka sementara lapisan keselamatan gagal mengesan manipulasi.

Yuekang Li, seorang penyelidik di University of New South Wales, memberi amaran bahawa kaedah sedemikian boleh menimbulkan masalah yang serius.”Pengguna boleh berkomunikasi dengan model menggunakan teks yang disulitkan jika model itu cukup pintar dan mudah memintas jenis pertahanan ini,”kata Li mengulas kajian teknologi MIT.

Anthropic telah mengakui kebimbangan ini dan telah membuka Pengelas Perlembagaan untuk ujian selanjutnya. Cari kelemahan dalam sistem.

Kami mencabar anda untuk memecahkan pertahanan jailbreak baru kami! https://t.co/9y0fit79pn

-Jan Leike (@janleike) 3 Februari 2025

.

Keberkesanan jangka panjang pendekatannya bergantung pada seberapa cepat ia dapat menyesuaikan diri dengan ancaman baru. Dengan penelitian pengawalseliaan yang semakin meningkat dan rangka kerja tadbir urus AI yang berkembang, syarikat-syarikat yang mengerahkan sistem AI akan menghadapi tekanan yang semakin meningkat untuk melaksanakan langkah-langkah keselamatan yang boleh dipercayai dan telus. perlumbaan senjata yang berterusan. Pengelas perlembagaan Anthropic mewakili langkah yang bermakna ke arah sistem AI yang lebih selamat, tetapi ia juga menyoroti cabaran mengimbangi keselamatan, kebolehgunaan, dan kos.