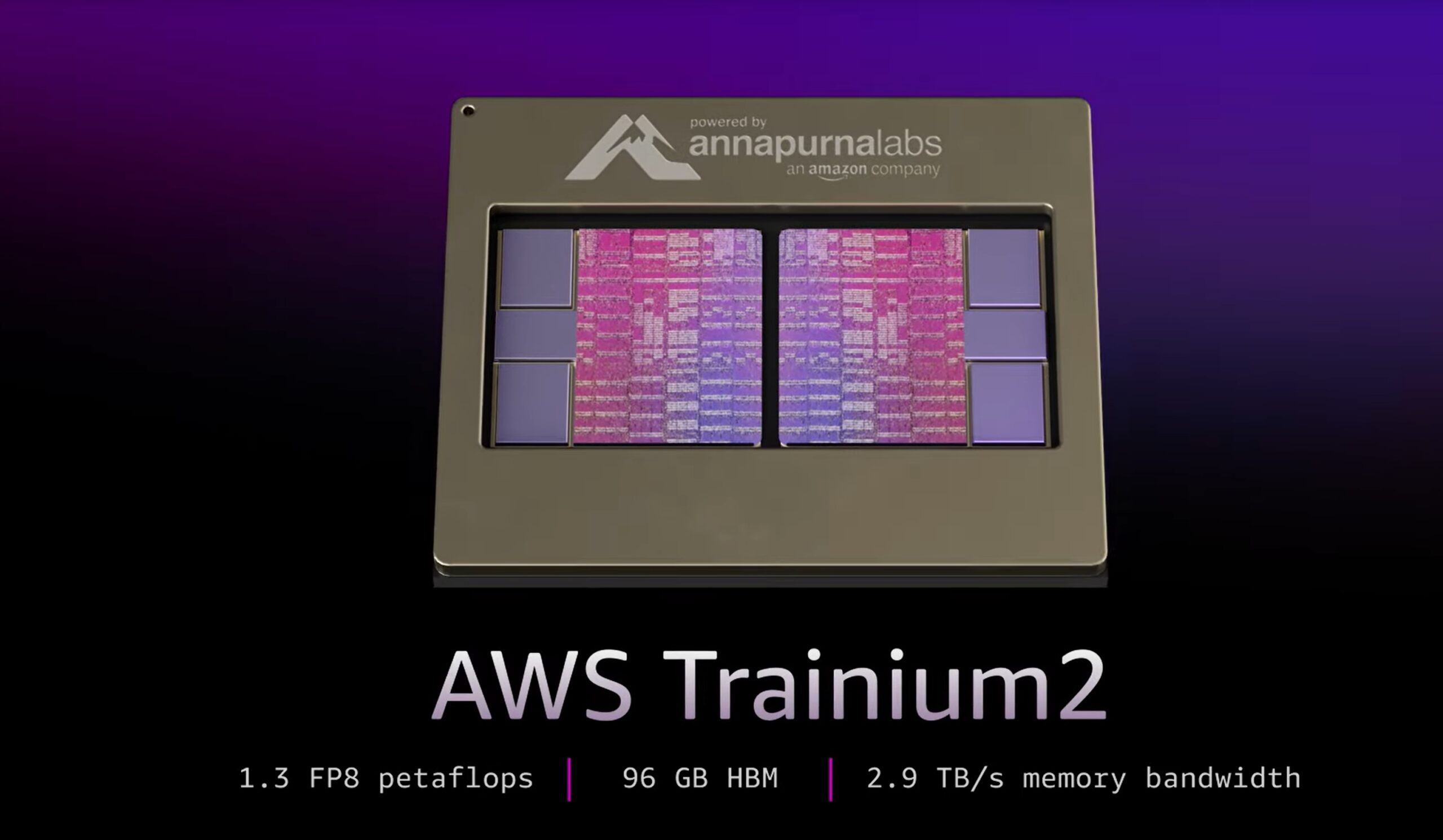

AWS telah mengambil satu lonjakan ketara dalam infrastruktur AI dengan memperkenalkan cip Trainium2 generasi kedua dan memperkenalkan Trn2 UltraServers, yang direka untuk menolak sempadan prestasi model bahasa besar (LLM).

Diumumkan pada majlis semula: Cipta persidangan, perkembangan ini meletakkan AWS sebagai pemain yang hebat dalam landskap AI yang berkembang pesat. AWS turut mempratonton Trainium3, sebuah cip generasi seterusnya yang menjanjikan peningkatan prestasi empat kali ganda, yang dijadualkan untuk dikeluarkan pada akhir 2025.

David Brown, Naib Presiden Pengiraan dan Rangkaian di AWS, menerangkan kepentingan inovasi ini:

“Trainium2 ialah cip AWS berprestasi tertinggi yang dibuat setakat ini. Dan dengan model yang menghampiri bertrilion parameter, kami tahu pelanggan memerlukan pendekatan baru untuk melatih dan menjalankan model besar tersebut. Trn2 UltraServers baharu menawarkan latihan terpantas dan prestasi inferens pada AWS untuk model terbesar di dunia.”

Trainium2: Membuka Kunci Pengiraan Belum Pernah Terjadi Kuasa

Cip Trainium2 direka bentuk untuk memenuhi permintaan pengiraan yang semakin meningkat bagi model AI moden, menawarkan sehingga 20.8 petaflop pengiraan FP8 padat setiap contoh.

Setiap tika EC2 Trn2 menyepadukan 16 cip Trainium2 yang disambungkan melalui sambungan NeuronLink proprietari AWS, yang memastikan komunikasi berkependaman rendah dan lebar jalur tinggi seni bina membolehkan kebolehskalaan yang lancar, kritikal untuk latihan dan menggunakan LLM yang luas.

AWS mempamerkan keupayaan Trainium2 dengan model Llama 405B Meta, yang mencapai “tiga kali lebih tinggi daya pemprosesan penjanaan token berbanding tawaran lain yang tersedia oleh penyedia awan utama ,”menurut syarikat itu.

Peningkatan ini dengan ketara mempercepatkan tugas seperti penjanaan teks, ringkasan dan inferens masa nyata, menangani permintaan perniagaan yang bergantung pada AI generatif.

[kandungan terbenam]

UltraServers: Penskalaan Melebihi Had

Untuk perusahaan yang menangani model trilion parameter, AWS memperkenalkan Trn2 UltraServers, yang menggabungkan 64 cip Trainium2 untuk menyampaikan sehingga 83.2 petaflops prestasi FP8 yang jarang.

Pelayan membolehkan masa latihan yang lebih pantas dan inferens masa nyata untuk model AI ultra-besar, yang mewakili kemajuan kritikal untuk perniagaan yang bertujuan untuk menggunakan sistem yang sangat kompleks.

Gadi Hutt, Pengarah Kanan di Annapurna Labs, menerangkan keupayaan UltraServers:

“Seterusnya, kami memecahkan sempadan [16-cip] itu dan menyediakan 64 cip dalam UltraServer, dan itu adalah untuk model yang sangat besar. Jadi, jika anda mempunyai model 7 bilion parameter, yang dahulunya besar, tetapi tidak lagi—atau model yang sangat besar, sebut saja 200 bilion atau 400 bilion. Anda mahu berkhidmat pada kependaman terpantas yang mungkin. Jadi, anda menggunakan UltraServer.”

Kerjasama dengan Anthropic: Membina Kluster AI Terbesar

AWS telah bekerjasama dengan Anthropic untuk membangunkan Project Ranier, sebuah pengiraan kluster yang akan menampilkan ratusan ribu cip Trainium2.

AWS menyifatkan ia sebagai Lima kali lebih berkuasa daripada sistem semasa Anthropic, dan kluster pengiraan AI terbesar di dunia dilaporkan sehingga kini. Kerjasama ini menggariskan komitmen AWS untuk memperkasakan rakan kongsinya dengan teknologi termaju.

Anthropic, yang terkenal dengan Claude 3.5 Sonnet LLM, bergantung pada infrastruktur AWS untuk mengekalkan kelebihan daya saing terhadap saingan seperti OpenAI dan Google baru-baru ini menggandakan pelaburannya dalam Anthropic kepada $8 bilion, mengukuhkan fokus strategiknya pada AI generatif.

Trainium3: Membentuk Masa Depan Pengiraan AI

AWS turut mengumumkan Trainium3, cipnya yang akan datang dibina pada proses tiga nanometer, yang menjanjikan untuk menyampaikan prestasi empat kali ganda UltraServers. Dijangka dilancarkan pada akhir 2025, Trainium3 akan membolehkan latihan dan inferens yang lebih pantas untuk model AI generasi akan datang, seterusnya mengukuhkan kepimpinan AWS dalam pengiraan AI.

David Brown menggariskan visi AWS untuk cip baharu: “Dengan kami cip Trainium3 generasi ketiga, kami akan membolehkan pelanggan membina model yang lebih besar dengan lebih pantas dan memberikan prestasi masa nyata yang unggul apabila menggunakannya.”

Strategi AWS dengan Trainium3 bertujuan untuk mencabar penguasaan Nvidia dalam pasaran perkakasan AI Sementara GPU Blackwell Nvidia yang akan datang menawarkan sehingga 720 petaflop prestasi FP8, penyelesaian Trainium bersepadu AWS menawarkan alternatif yang kos efektif dan berskala yang disesuaikan untuk AI skala perusahaan. beban kerja.

Sokongan Ekosistem: Alat untuk Penyepaduan Lancar

Untuk melengkapkan inovasi perkakasannya, AWS menyediakan Neuron SDK, kit alat pembangunan yang dioptimumkan untuk rangka kerja seperti PyTorch dan JAX.

SDK termasuk alatan untuk latihan dan inferens yang diedarkan, membolehkan pembangun memanfaatkan cip Trainium tanpa konfigurasi semula yang meluas.

AWS juga menawarkan AMI Pembelajaran Dalam yang telah diprakonfigurasikan, memastikan pembangun boleh menggunakan AI mereka dengan pantas aplikasi.