OpenAI telah memperkenalkan model AI terbaharunya, GPT-4o, yang meningkatkan keupayaan pendahulunya dengan menyepadukan pengecaman suara ke dalam pemprosesan teks dan penglihatannya yang sudah mantap. Diumumkan semasa strim langsung pada hari Isnin, model itu diterangkan oleh OpenAI CTO Mira Murati sebagai kemajuan ketara dalam interaksi AI, menawarkan responsif masa nyata dan pengiktirafan emosi dalam komunikasi suara. Pelancaran akan berlaku secara berulang di seluruh rangkaian produk OpenAI, menyasarkan kedua-dua pembangun dan pengguna dalam beberapa minggu akan datang. GPT-4o (“o”untuk “omni”) direka bentuk untuk menerima sebarang gabungan input teks, audio dan imej serta menjana sebarang gabungan output teks, audio dan imej.

Interaksi Multimodal di Teras GPT-4o

Membina di atas asas yang ditetapkan oleh GPT-4, yang mahir memproses imej dan teks, GPT-4o memperkenalkan suara sebagai elemen baharu, menjadikan ia merupakan platform multimodal asli. Peningkatan ini bukan sahaja meningkatkan pengalaman pengguna dengan ChatGPT, bot sembang AI popular OpenAI, tetapi juga memperluaskan fungsinya.

Pengguna kini boleh berinteraksi dengan ChatGPT dengan cara yang lebih dinamik, mengganggu dan menerima respons dalam masa nyata, dengan model yang mampu mengesan nuansa dalam emosi pengguna dan bertindak balas dalam pelbagai nada emotif. Model ini boleh bertindak balas kepada input audio dalam masa seawal 232 milisaat, dengan purata masa tindak balas 320 milisaat, yang setanding dengan masa respons manusia dalam perbualan.

Fungsi Dipertingkatkan Merentas Platform

Penyepaduan keupayaan suara meningkatkan fungsi ChatGPT dengan ketara. Contohnya, apabila diberikan foto atau imej skrin desktop, ChatGPT kini boleh menjawab pertanyaan yang berkaitan dengan kandungan yang dipaparkan dengan pantas, seperti mengenal pasti spesifik kod perisian atau mengenali jenama dan objek.

Kemas kini adalah sebahagian daripada Strategi OpenAI yang lebih luas untuk menjadikan interaksi AI lebih intuitif dan kurang tertumpu pada antara muka pengguna asas. GPT-4o sepadan dengan prestasi GPT-4 Turbo pada teks dalam bahasa Inggeris dan kod, dan menunjukkan peningkatan ketara pada teks dalam bahasa bukan bahasa Inggeris. Ia juga jauh lebih pantas dan 50% lebih murah dalam API, terutamanya cemerlang dalam pemahaman penglihatan dan audio berbanding model sedia ada.

[kandungan terbenam]

Akses Lebih Luas dan Prestasi yang Dipertingkatkan

Selain keupayaannya yang dipertingkatkan, GPT-4o akan tersedia secara percuma kepada semua pengguna, dengan pengguna berbayar mendapat manfaat sehingga lima kali ganda had kapasiti. Model ini juga mempunyai kelajuan yang lebih baik, memastikan tindak balas yang lebih cepat dan interaksi yang lebih cekap. Ketua Pegawai Eksekutif OpenAI Sam Altman menekankan reka bentuk model itu bersifat multimodal, yang sejajar dengan visi syarikat untuk mencipta alat AI yang lebih semula jadi dan mudah diakses.

“Seperti yang diukur pada penanda aras tradisional, GPT-4o mencapai GPT-4 Turbo prestasi tahap pada teks, penaakulan dan kecerdasan pengekodan, sambil menetapkan tera air tinggi baharu pada keupayaan berbilang bahasa, audio dan penglihatan“, kata OpenAI

Penaakulan Dipertingkat

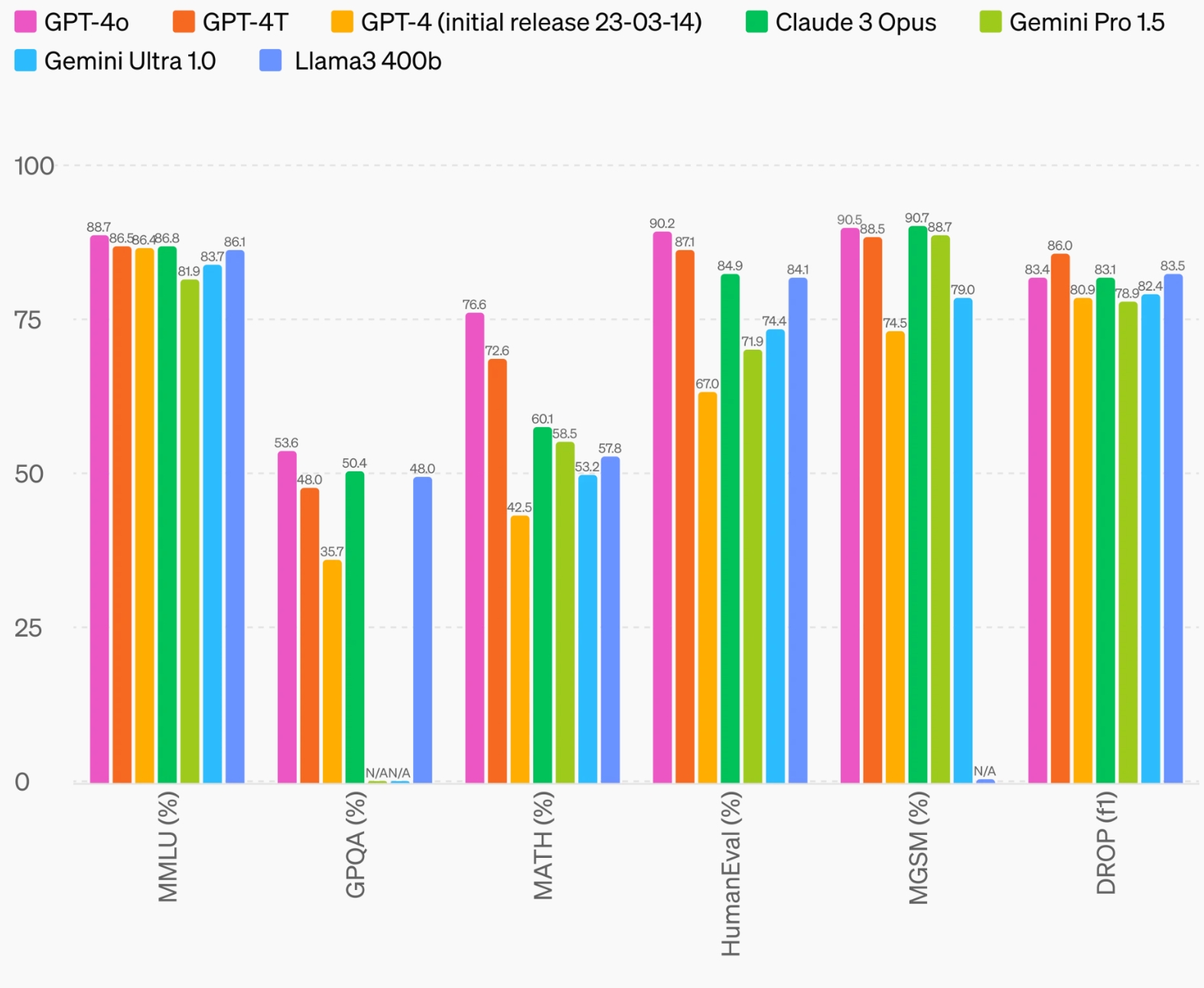

GPT-4o mencapai markah rekod baharu sebanyak 87.2% pada MMLU 5 pukulan (soalan pengetahuan am). (Nota: Llama3 400b sedang dalam latihan)

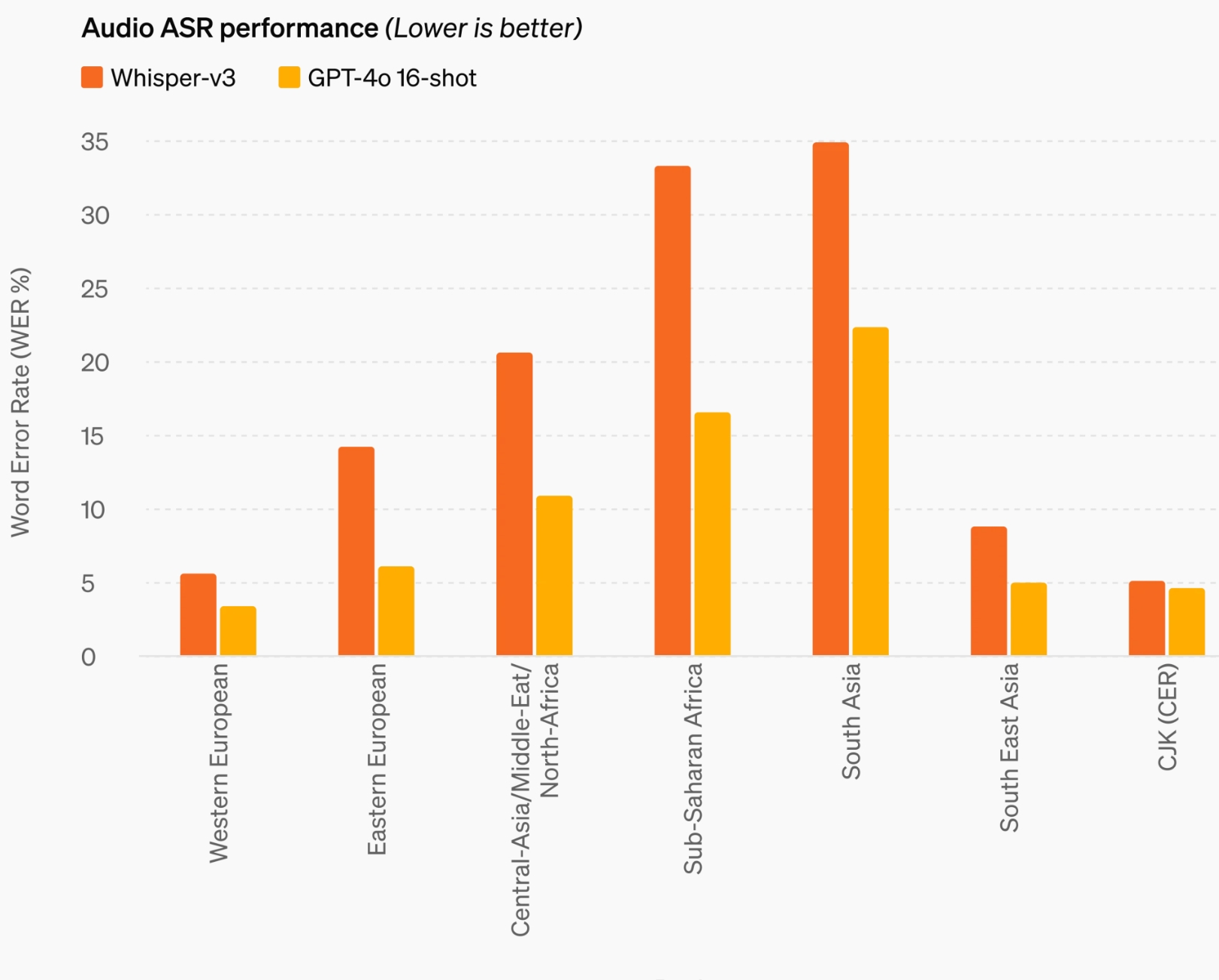

Prestasi Audio ASR

GPT-4o meningkatkan keupayaan pengecaman pertuturan dengan ketara berbanding Whisper-v3 merentas pelbagai bahasa, terutamanya bahasa yang mempunyai sumber yang lebih sedikit.

Prestasi terjemahan audio

GPT-4o menetapkan penanda aras baharu dalam prestasi terjemahan audio , mengatasi Whisper-v3 dalam penanda aras MLS.

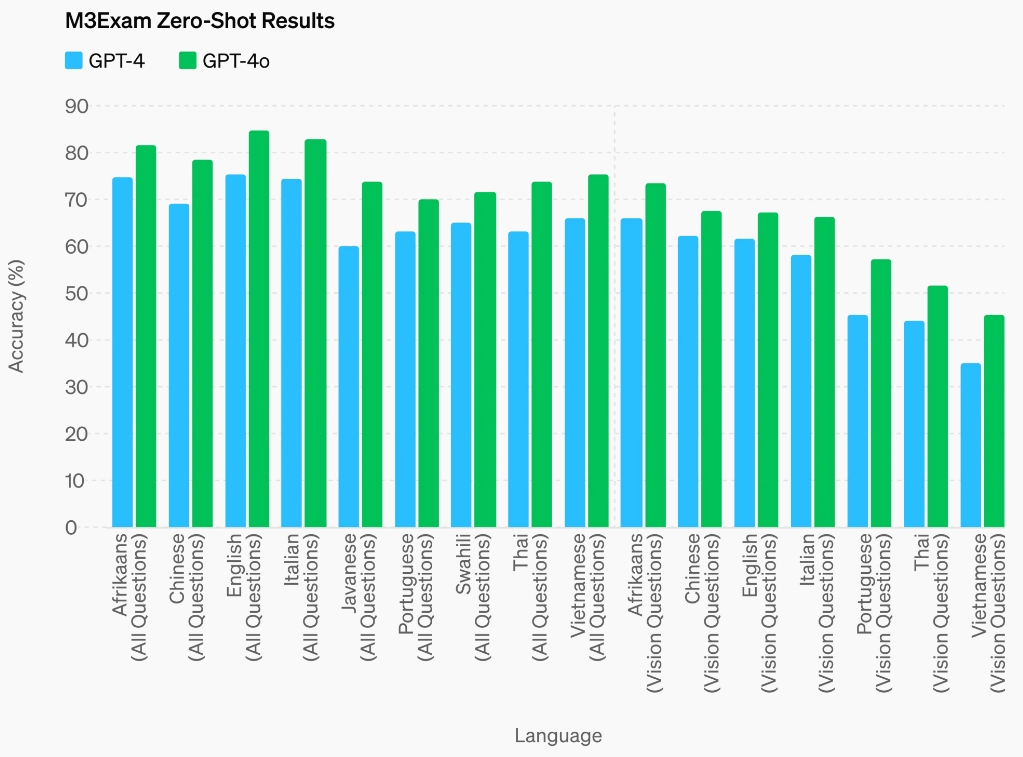

Keputusan Penanda Aras M3Exam

Penanda aras M3Exam berfungsi sebagai penilaian berbilang bahasa dan visual, yang terdiri daripada soalan berbilang pilihan daripada ujian piawai pelbagai negara, yang mungkin termasuk angka dan rajah. GPT-4o mengatasi GPT-4 dalam penanda aras ini merentas semua bahasa. Keputusan penglihatan untuk bahasa Swahili dan Jawa ditinggalkan kerana terdapat lima atau kurang soalan penglihatan untuk bahasa ini.

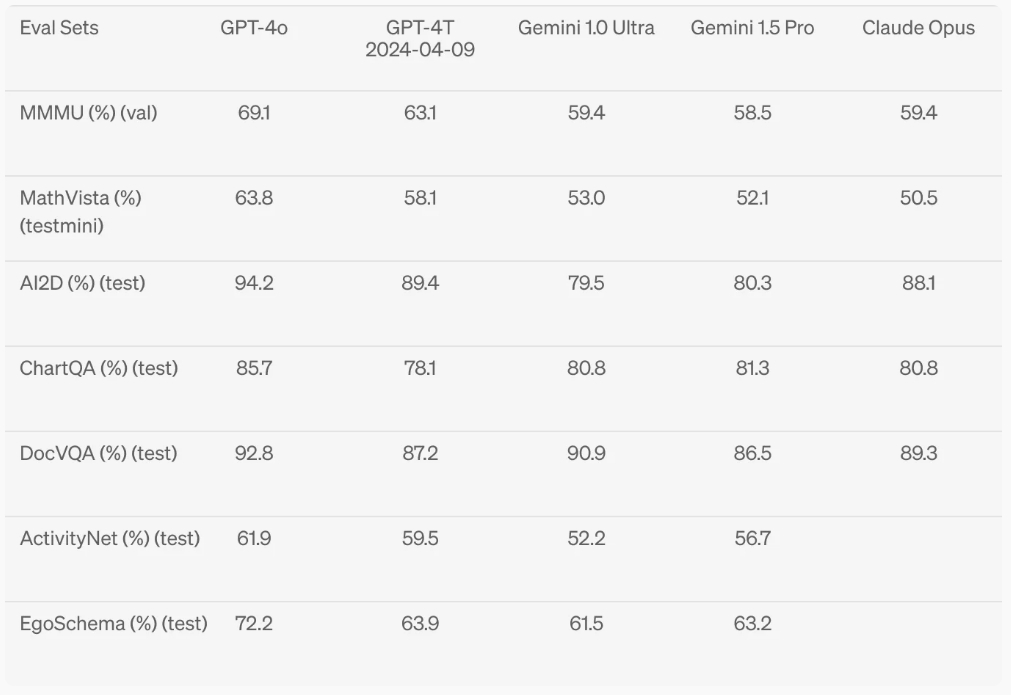

Pemahaman Visi

GPT-4o mencapai prestasi terkini pada penanda aras persepsi visual.

Masa Strategik untuk Pelancaran

Masa pengumuman GPT-4o, sejurus sebelum Google I/O, persidangan utama Google, kelihatan strategik, meletakkan OpenAI untuk menarik perhatian dalam landskap AI yang kompetitif. Pelancaran ini mengikuti tempoh spekulasi dengan pelbagai ramalan tentang perkembangan baharu OpenAI, yang menekankan pengaruh berterusan syarikat dalam industri teknologi.