Kuaishou, sebuah platform video pendek yang terkemuka di Beijing, memperkenalkan model bahasa besar yang dibangunkan sendiri bernama KwaiYii kepada orang ramai minggu lepas, menurut laporan daripada TechNode. Tambahan pula, syarikat itu turut melancarkan penyelidikannya ke dalam Rangkaian Neural Spiking dan pembangunan SpikeGPT.

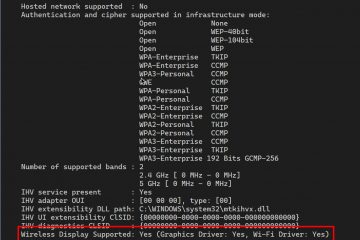

Keluaran ini datang selepas fasa ujian beta untuk perkhidmatan seperti ChatGPT untuk peranti Android yang bermula pada 18 Ogos. Perkhidmatan dialog, yang mempunyai 13 bilion parameter yang berakar pada KwaiYii, menyaingi OpenAI GPT-3.5 dalam kapasitinya untuk penciptaan kandungan, perundingan dan penyelesaian masalah.

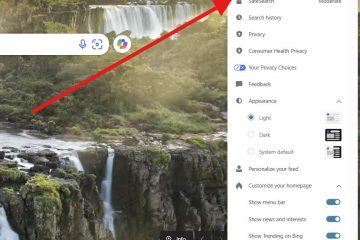

LLM diperincikan pada Halaman GitHub KwaiYii. Aplikasi utama untuk chatbot AI Kuaishou ialah carian, menggunakan kandungan asal daripada platform untuk menangani”halusinasi”AI – ketidaktepatan akibat latihan data yang tidak mencukupi.

SpikeGPT: Lonjakan dalam Kecekapan Tenaga

Kuaishou sedang meletakkan dirinya sebagai kuasa utama dalam Penyelidikan dan pembangunan AI, kedua-duanya dalam produk arus perdana awam dan projek R&D. KwaiYii ialah contoh AI awam arus perdana, manakala Kuaishou juga minggu ini membincangkan SpikeGPT, contoh usaha penyelidikan AInya.

Tuntutan pengiraan model bahasa besar (LLM) kontemporari adalah besar. Walau bagaimanapun, Rangkaian Neural Spiking (SNN) telah dikenal pasti sebagai lebih tenaga-alternatif yang cekap kepada rangkaian saraf tiruan konvensional, walaupun keberkesanannya dalam tugas penjanaan bahasa masih belum dipetakan.

Satu usaha sama penyelidikan antara Universiti California dan Teknologi Kuaishou telah memperkenalkan SpikeGPT (melalui Semakan Disegerakkan), yang julung kali diadakan model bahasa rangkaian neural spiking generatif (SNN). Model ini, dengan versi parameter 260Mnya, sepadan dengan prestasi rangkaian saraf dalam (DNN ) sambil mengekalkan faedah penjimatan tenaga pengiraan berasaskan spike.

SpikeGPT ialah model bahasa generatif yang dicirikan oleh unit pengaktifan spike binari tulen, dipacu peristiwa. Ia menyepadukan pengulangan ke dalam blok pengubah, menjadikannya serasi dengan SNN. Penyepaduan ini bukan sahaja menghapuskan kerumitan pengiraan kuadratik tetapi juga memudahkan perwakilan perkataan sebagai pancang yang didorong oleh peristiwa.

Model boleh memproses data penstriman perkataan demi perkataan, memulakan pengiraan walaupun sebelum pembentukan ayat yang lengkap, sambil masih menangkap kebergantungan jarak jauh dalam struktur sintaksis yang rumit. Pasukan penyelidik juga telah menggabungkan pelbagai teknik untuk meningkatkan prestasi SpikeGPT, seperti langkah pembenaman binari, pengendali anjakan token dan RWKV vanila untuk menggantikan mekanisme perhatian kendiri tradisional.

Memahami Spiking Rangkaian Neural

Rangkaian neural spiking (SNN) ialah sejenis rangkaian saraf tiruan yang diilhamkan oleh cara neuron biologi berfungsi. Dalam SNN, neuron berkomunikasi antara satu sama lain dengan menghantar pancang, yang merupakan letusan pendek aktiviti elektrik. Pancang tidak berterusan, tetapi berlaku pada selang masa yang diskret. Ini berbeza dengan rangkaian saraf tiruan tradisional, yang menggunakan nilai berterusan untuk mewakili pengaktifan neuron.

SNN mempunyai beberapa potensi kelebihan berbanding rangkaian saraf tiruan tradisional. Pertama, mereka lebih cekap tenaga. Ini kerana pancang hanya dihantar apabila perlu, bukannya secara berterusan. Kedua, SNN lebih realistik secara biologi. Ini menjadikan mereka pilihan yang baik untuk aplikasi yang memerlukan tahap realisme yang tinggi, seperti robotik dan pengimejan perubatan.

Walau bagaimanapun, SNN juga mempunyai beberapa cabaran. Satu cabaran ialah mereka lebih sukar untuk dilatih daripada rangkaian neural buatan tradisional. Ini kerana pancang adalah peristiwa diskret, yang menyukarkan untuk menyebarkan semula ralat melalui rangkaian. Cabaran lain ialah SNN tidak begitu difahami seperti rangkaian neural buatan tradisional. Ini menyukarkan untuk mereka bentuk dan mengoptimumkan SNN untuk tugasan tertentu.

Cara SpikeGPT Berprestasi

Dalam kajian empirikal, SpikeGPT telah dilatih dengan tiga skala parameter berbeza (parameter 45M, 125M dan 260M) dan telah ditanda aras terhadap garis dasar pengubah seperti Reformer, Synthesizer, Linear Transformer dan Performer menggunakan set data Enwik8. Keputusan menunjukkan bahawa SpikeGPT menyampaikan hasil yang setanding dengan 22 kali lebih sedikit operasi sinaptik (SynOps).

Penyelidikan ini menggariskan potensi melatih SNN besar untuk memanfaatkan kemajuan dalam transformer, mencadangkan pengurangan ketara dalam permintaan pengiraan LLM. dengan menggunakan pengaktifan spiking yang didorong oleh peristiwa pada penjanaan bahasa. Para penyelidik telah menyatakan hasrat mereka untuk terus memperhalusi model mereka dan akan mengemas kini kertas pracetak mereka dengan sewajarnya. Kod untuk SpikeGPT ialah tersedia pada GitHub projek dan kertas yang memperincikan model boleh diakses pada arXiv.