Hugging Face は、小規模 AI 開発チームの経済的負担を軽減することを目的として、1,000 万ドル相当の GPU コンピューティングを一般に提供する取り組みを開始しました。 ZeroGPU という名前のこのプログラムは、CEO Clem Delangue によって X で導入されました。

リソース格差への対処

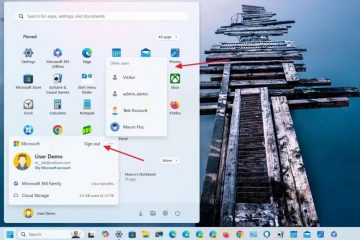

Delangue 氏は、AI モデルのトレーニングとデプロイに必要なインフラストラクチャが不足していることが多い、大手テクノロジー企業とオープンソース コミュニティとの間のリソース格差を強調しました。この差異が、ChatGPT のようなアプリケーションの優位性に貢献しています。 ZeroGPU は、独立系および学術機関の AI 開発者が Hugging Face Spaces で AI デモを実行できる共有インフラストラクチャを提供することで、このギャップを埋めることを目指しています。これにより、経済的負担を軽減できます。

GPU はもう必要ありません。本日、正式に ZeroGPU ベータ版をリリースします。 @victormustar とチームの皆さん、リリースおめでとうございます!

過去数か月間、オープンソース AI コミュニティは繁栄してきました。 Meta だけでなく、Apple、NVIDIA、Bytedance、Snowflake、Databricks、Microsoft など… pic.twitter.com/6UzWvYhmpw

— クレム 🤗 (@ClementDelangue) 2024 年 5 月 16 日

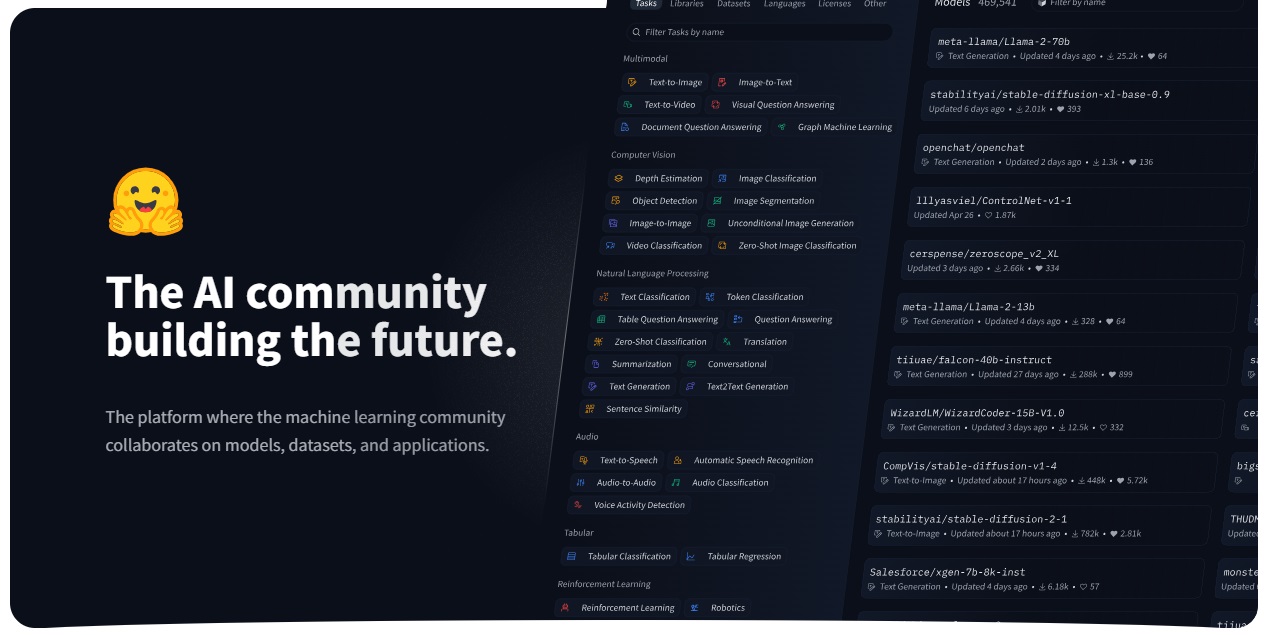

2016 年に設立された Hugging Face は、Nvidia、Intel、AMD などの業界大手とのパートナーシップのおかげで、さまざまなハードウェア プラットフォームに最適化されたオープンソース AI モデルの大手プロバイダーになりました。 Delangue 氏は、オープンソースが AI のイノベーションと導入の未来であると考えており、ZeroGPU イニシアチブは、重要なリソースへのアクセスの民主化に向けた一歩となります。

共有 GPU インフラストラクチャ

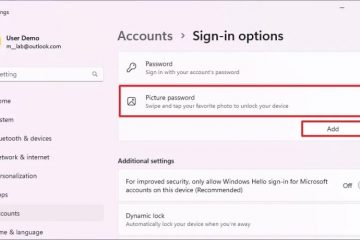

ZeroGPU は、Hugging Face のアプリケーション ホスティング サービスを通じてアクセスでき、Nvidia の古い A100 アクセラレータを共有ベースで利用します。費用対効果の高い GPU レンタルに長期契約が必要なことが多い従来のクラウド プロバイダーとは異なり、Hugging Face のアプローチではより柔軟な使用が可能となり、モデルの成功を事前に予測できない小規模な開発者にとって有益です。この共有インフラストラクチャは、小さなモデルであってもトレーニングに必要な大量の計算リソースのため、当初はトレーニングではなく AI 推論に限定されています。

サポート ドキュメントによると、GPU 機能の上限は 120 秒であり、これでは不十分です。トレーニング目的。ハギング フェイスの広報担当者は、主に推論に重点を置いていると認めましたが、将来的には他のアプリケーションも検討する予定です。

技術実装

Hugging Face がどのように GPU リソースを効率的に共有するかについての技術的な詳細は、まだ不明瞭です。 Delangue 氏は、システムが「必要に応じて GPU を効率的に保持および解放できる」と述べていますが、正確なメカニズムについては詳しく説明されていません。考えられる方法には、複数のワークロードを同時に実行するためのタイム スライスが含まれます。Nvidia のマルチインスタンス GPU (MIG) テクノロジー および Kubernetes によって調整された GPU 高速化コンテナ。これらの技術は、GPU コンピューティングをよりアクセスしやすくするために他のクラウド プロバイダーによって使用されています。

使用されている A100 GPU には 40 GB のメモリが搭載されていますZeroGPU は、アプリを公開するためのホスティング プラットフォームである Hugging Face の Spaces 経由で利用できるようになり、これまでに CPU または有料 GPU で 300,000 を超える AI デモが作成されています。

資金とビジョン

ハギング フェイスのこの取り組みへの取り組みは、同社が「黒字か黒字に近い」財務安定性によって可能となり、最近 2 億 3,500 万ドルの資金を調達しました。その評価額は45億ドルです。デラング氏は、人工知能の大幅な進歩を独占的に保ち、膨大な計算リソースを保有するハイテク大手と競合する人工知能新興企業の能力について懸念を表明した。 Hugging Face は、大手テクノロジー企業だけでなく、誰もが高度な AI テクノロジーにアクセスできるようにすることを目指しています。

コミュニティへの影響

コンピューティングへのアクセスは、大規模なシステムを構築する上で大きな課題となっています。言語モデルは、多くの場合、OpenAI や Anthropic などの企業に有利です。 Hugging Face の機械学習エンジニアである Andrew Reed は、プロプライエタリ LLM とオープンソース LLM の時間の経過に伴う進歩を視覚化し、両者の差が徐々に近づいていることを示すアプリを作成しました。 1 年前の Meta の最初のバージョン以来、Meta のオープンソース AI モデル Llama の 35,000 以上のバリエーションが Hugging Face で共有されています。