最近発表された MLPerf Inference v3.1 により、大規模向けの新しいベンチマークが誕生しました。 AI テストの大幅な進歩を示す言語モデル (LLM) と推奨事項。 MLPerf ベンチマークは、学術 AI リーダーのコンソーシアムである MLCommons、研究機関、および業界全体によって開発され、公平な評価を提供するように設計されています。

新しいバージョンでは、前例のないレベルの参加があり、13,500 を超えるパフォーマンス結果が得られ、パフォーマンスが最大 40% 向上しました。参加者の多様性は、Google、Intel、NVIDIA などの大手テクノロジー企業だけでなく、Connect Tech、Nutanix、Oracle、TTA などの初参加者を含む 26 社の異なる提出者からも明らかです。

David MLCommons のエグゼクティブ ディレクターである Kanter 氏は、この貢献の重要性を強調し、次のように述べています。 AI、顧客、ML に対する提出者の取り組みに反映されます。」

@MLCommons をリリースしました! 新しい @MLPerf 推論とストレージの結果。MLPerf Inference v3.1 への参加記録と MLPerf Storage v0.5 の初回結果は、GenAI の重要性の増大を浮き彫りにしています。すべての結果を確認して詳細を確認してください https://t.co/7eycrrmOdw

— MLCommons (@ MLCommons) 2023 年 9 月 11 日

ベンチマーク結果

MLPerf Inference の主な目的は、AI システムがさまざまな導入シナリオでモデルを実行できる速度を測定することです。これらは、高度な生成 AI チャットボットから、自動車線維持や音声テキスト変換インターフェイスなどの車両安全機能まで多岐にわたります。このバージョンでは、2 つのベンチマークの導入に焦点を当てています。

GPT-J 参照モデルを使用して CNN ニュース記事を要約する LLM は、15 人の参加者による生成 AI の迅速な導入を反映しています。 DLRM-DCNv2 参照モデルと大規模なデータセットを利用し、業界標準との整合性を高めた、更新されたレコメンダー ベンチマーク。9 件の提出を受けました。

MLPerf Inference v3.1 および MLPerf Storage v0.5 の結果を表示し、ベンチマークに関する追加情報を見つけるには、次のサイトにアクセスしてください。

https://mlcommons.org/en/storage-results-05/

https://mlcommons.org/en/inference-edge-31/

https://mlcommons.org/en/inference-datacenter-31/

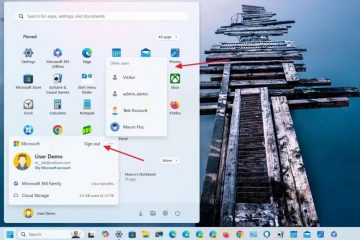

NVIDIA の優位性とインテルの追撃

大規模言語モデルのテストでは、NVIDIA の高度なチップが最上位の候補として浮上し、インテルのハードウェアがそれに続きます。 AI チップセットのパフォーマンスの中立的なベンチマークで知られる MLCommons は、新しい MLPerf Inference 3.1 ベンチマークの結果を発表しました。

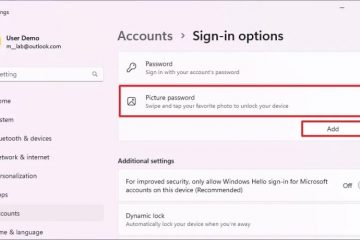

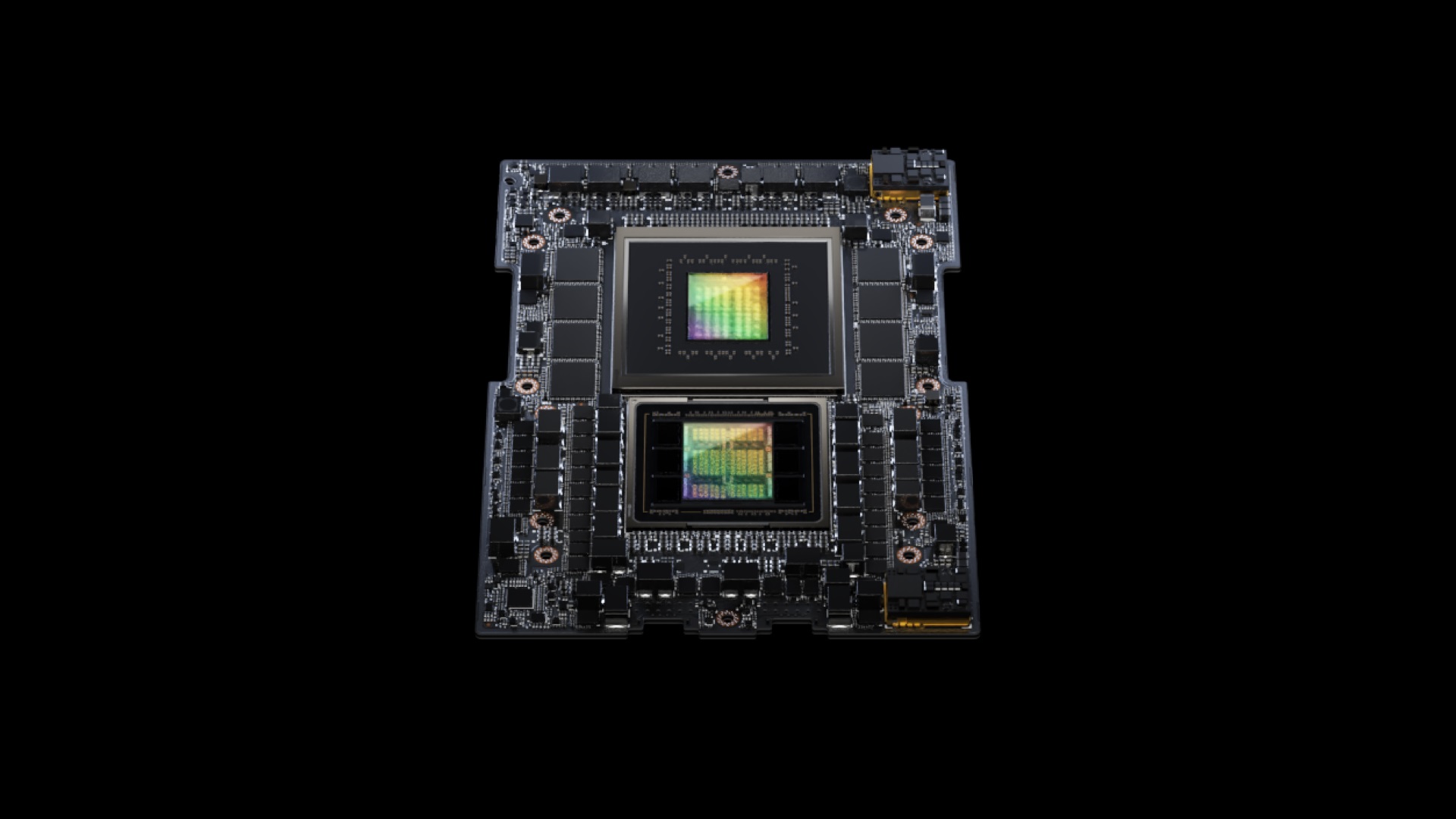

NVIDIA は、GH200 Grace Hopper スーパーチップ。Hopper グラフィック処理ユニットと Grace 中央処理装置を融合し、強化されたメモリ、帯域幅、およびデータ間のタスクシフト機能を提供します。 GPU と Arm ベースの CPU。このチップセットは、NVIDIA の HGX 100 システムのパフォーマンスを約 17% 上回りました。ただし、Intel の Habana Gaudi2 アクセラレータもそれほど遅れはなく、NVIDIA のシステムと比較してパフォーマンスの遅れはわずか 10% でした。

今週、Nvidia は、H100 AI GPU のパフォーマンスを効果的に 2 倍にする新しいソフトウェア アップデートを発表しました。今後数週間以内にリリース予定の同社の新しいオープンソース TensorRT-LLM ソフトウェアは、大幅なパフォーマンス向上を実証しました。

GPT-J 6B モデルを使用したテストでは、更新されたシステムは A100 と比較して 8 倍のパフォーマンス向上を示し、以前の 4 倍の利点から大幅に進歩しました。 。さらに、Meta の Llama2 LLM で評価した場合、TensorRT-LLM で強化された H100 は A100 を 4.6 倍上回り、アップデート前の 2.6 倍から顕著に改善されました。