10 月の M5 シリコンの発表に続き、Apple は、ローカル AI ワークロードにおける Nvidia の優位性に対抗するために設計された専用 GPU コンポーネントであるチップの「Neural Accelerator」のアーキテクチャ ブループリントをリリースしました。

今日の新しい技術レポートで詳しく説明されていますが、このアーキテクチャは更新された MLX 機械学習フレームワークを利用して、「最初のトークンまでの時間」(TTFT) で最大 4 倍の高速化を実現します。

この開示は、当初マーケティングの箇条書きであったものを文書化されたハードウェア機能に変換し、M5 の 153 GB/秒のメモリ帯域幅と特殊なマトリックス ユニットが、消費者向けデバイスでの大規模言語モデル (LLM) の実行を悩ませるメモリのボトルネックを解消するために特別に設計されていることを確認します。

M5 の内部: ニューラル アクセラレータ アーキテクチャ

Apple のエンジニアは、生のクロック速度だけに依存するのではなく、専用の「ニューラル アクセラレータ」を組み込むために M5 内の GPU コアを根本的に再設計しました。これらのユニットは、最新の生成 AI を支える密行列乗算演算を処理するために専用に構築されています。

M5 チップの発表において、幹部らはシリコンを飛躍的な進歩と位置づけましたが、技術的な詳細は Apple の公式技術レポートがリリースされるまで不透明なままでした。

更新された技術文書アクセラレータは、モデルがユーザーのプロンプトを処理する計算集約的な最初のステップである推論の「プレフィル」フェーズを特にターゲットにしていることを明確にしました。

発表時に、Apple のハードウェア テクノロジー担当シニア VP である Johny Srouji 氏は、この機能を構造的変化として位置づけ、「M5 は Apple シリコンの AI パフォーマンスにおける次の大きな飛躍をもたらします。GPU にニューラル アクセラレータを導入することで、M5 は大幅な向上を実現します」と述べました。

重要なのは、パフォーマンスの向上がすべてのタスクで均一ではないということです。新しいコンピューティング ユニットにより、プレフィル フェーズでは 4 倍の大幅な改善が見られますが、その後のトークン生成フェーズでは、データがシステム内を移動する速度によって依然として制約を受けます。公式テクニカル レポートで説明されているように:

「LLM 推論では、最初のトークンの生成は計算に依存し、ニューラル アクセラレータを最大限に活用します。後続のトークンの生成は、計算能力ではなくメモリ帯域幅によって制限されます。

この投稿でテストしたアーキテクチャでは、M5 はメモリ帯域幅が大きいため、M4 と比較して 19 ~ 27% のパフォーマンス向上を実現します。 (M4 は 120GB/秒、M5 は 153GB/秒で、28% 高い)

メモリ使用量に関しては、MacBook Pro 24GB は、BF16 精度で 8B または量子化された MoE 4 ビットで 30B を容易に保持でき、これらのアーキテクチャの両方で推論ワークロードを 18GB 未満に維持できます。」

このような差は、メモリの二重性を浮き彫りにします。 M5 のアップグレード パス。メモリ帯域幅は現在 153GB/s でクロックされており、M4 の 120GB/s と比較して 28% 増加しており、生成速度の 19 ~ 27% 向上が観測されたことと直接相関しています。

開発者にとって、これは、M5 が、初期処理時間が主なボトルネックとなっている複雑で長いコンテキストのプロンプトの処理に特に優れていることを意味します。 24 GB のユニファイド メモリ容量を備えたこのシステムは、BF16 精度の 8B パラメータ モデルや 4 ビット量子化の 30B Mixture of Experts (MoE) モデルなどの実質的なモデルを完全にデバイス上で実行できます。

Apple の研究チームによると、「ニューラル アクセラレータは、多くの機械学習ワークロードにとって重要な専用の行列乗算演算を提供し、さらに高速なモデル推論エクスペリエンスを可能にします」 Apple シリコン。」

シリコンのロックを解除: MLX フレームワークの進化

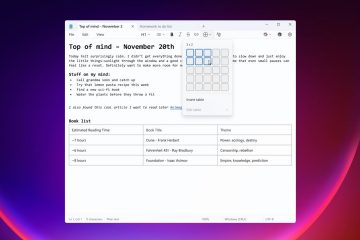

シリコン自体を超えて、ソフトウェアのストーリーはハードウェアの機能に合わせて進化してきました。新しいニューラル アクセラレータを利用するには、開発者は、ユニファイド メモリ アーキテクチャ向けに設計された Apple のオープンソース配列ライブラリである MLX フレームワークの バージョン 0.30.0 に更新する必要があります。

ドキュメントには、これらの機能を完全にサポートするには「macOS 26.2」が必要であると記載されており、これはおそらくバージョン番号を指すものと思われます。今後の macOS 16.2 (Tahoe) ベータ版の内部ビルドまたはタイプミスが原因です。このような前提条件は、OS カーネルとアクセラレータを駆動するメタル パフォーマンス シェーダとの間の緊密な結合を強調しています。

アップデートされたスタックにより、Apple は、「GPU ニューラル アクセラレータは、大規模な行列乗算を含む ML ワークロードで MLX と連携し、言語モデル推論における最初のトークンまでの時間の M4 ベースラインと比較して最大 4 倍の高速化を実現します。」と主張しています。

開発者は、次のことも活用できます。 MLX Swift を使用して、macOS から iOS まで、Apple エコシステム全体でネイティブに実行されるアプリケーションを構築します。クロスプラットフォーム互換性は重要な差別化要因として機能し、MacBook Pro 用に書かれたコードを最小限の変更で iPad Pro に展開できるようになります。 Apple のドキュメントには、この統合について詳しく説明されています。

「MLX はすべての Apple シリコン システムで動作し、最新の macOS ベータ リリースでは、新しい 14 インチ MacBook Pro に導入された新しい M5 チップのニューラル アクセラレータを利用できるようになりました。ニューラル アクセラレータは、多くの機械学習ワークロードにとって重要な専用の行列乗算演算を提供し、Apple シリコン上でさらに高速なモデル推論エクスペリエンスを可能にします。」

戦略的には、ソフトウェアの推進は、Apple が密かにサポートしてきた CUDA バックエンド イニシアチブを含む、より広範なイニシアチブと連携しています。 MLX コードの「一方向ブリッジ」を Nvidia ハードウェア上で実行できるようにすることで、Apple は自社のフレームワークを、必要に応じてデータセンター クラスターに拡張できる実行可能な開発環境として位置づけています。

ただし、主な焦点は依然としてローカル実行にあります。 Apple Silicon で外部 GPU サポートが欠如しているということは、開発者が内部ユニファイド メモリ アーキテクチャに完全に依存していることを意味し、パフォーマンスにとって MLX フレームワークの効率が重要になります。

「Mac クラスター」の破壊: データ センターへの挑戦

個々の M5 チップは大きなローカル パワーを提供しますが、オープンソース コミュニティでの新しい開発は、従来のデータ センター モデルに挑戦しています。 ExoLabs クラスタリング ソフトウェア などの新しいオープンソース ツールにより、ユーザーは Thunderbolt 5 経由で複数の Mac Studio をチェーンし、大規模なモデルを実行できる分散推論クラスタを作成できるようになりました。

このクラスタリング機能は、1 兆パラメータの MoE アーキテクチャである新しい Kim K2 Thinking モデルと同じくらい大きなモデルをサポートするように拡張できます。複数の M5 Ultra または Max チップのユニファイド メモリをプールすることで、これらのクラスタは単一コンシューマ GPU の VRAM 制限をバイパスできます。

Apple の研究者は、このアプローチの効率性を強調し、「M5 は、最初のトークンの生成までの時間を高密度 14B アーキテクチャで 10 秒未満、30B MoE で 3 秒未満に押し上げ、MacBook Pro 上のこれらのアーキテクチャに強力なパフォーマンスを提供します。」

電力効率に関する議論は、研究機関や小規模企業にとって特に説得力があります。 4 台の Mac Studio のクラスタの消費電力は 500 ワット未満で、同等の Nvidia H100 サーバー ラックに必要な電力のほんの一部です。

Thunderbolt 5 の遅延は Nvidia 独自の NVLink インターコネクトの速度には匹敵しませんが、このセットアップは、データ プライバシーを必要とし、クラウドベースの推論に依存できない組織に「ソブリン AI」ソリューションを提供します。このようなスーパーコンピューティング クラスの推論の民主化は、大規模なモデルをハイパースケール データセンターの外に展開する方法における大きな変化を表しています。