アレン AI 研究所 (AI2) は、人工知能における「オープンソース」の一般的な定義に異議を唱える新しい言語モデル ファミリである OLMo 3 を立ち上げました。

凍結されたモデルの重みを単にリリースするという業界標準から脱却し、AI2 は、データセット、トレーニング コード、中間チェックポイントで構成される完全なエコシステムである「モデル フロー」全体を公開しています。

オープン ソースの再定義: 「モデル フロー」パラダイム

今日のほとんどの「オープン」モデルは、実質的にパブリック ハンドルを備えたブラック ボックスです。開発者はそれらを使用できますが、その構築方法を監査することはできません。

AI2 は、Dolci と並ぶ大規模な事前トレーニング データセットである Dolma 3 をリリースすることで、この傾向を逆転させようとしています。トレーニング後の指示調整に特化したコーパスです。

トレーニング前、トレーニング中、トレーニング後のすべての開発段階からチェックポイントへのアクセスを提供することで、同研究所は研究者が特定の時点で介入できるようにしています。

エンジニアは完成品を微調整する代わりに、「トレーニング中」フェーズでモデルをフォークして、ドメイン固有のスキルを注入できます。

「システム 2」の民主化推論

このリリースの中心となるのは、OLMo 3-Think (32B) です。これは、OpenAI の o1 などの独自システムによって普及した「思考連鎖」推論機能を複製するように設計されたモデルです。 API 呼び出しの背後にロジックを隠すクローズドな代替手段とは異なり、OLMo 3-Think は中間推論ステップを公開します。

ユーザーは、モデルが複雑な数学やコーディングの問題をどのように分解するかを正確に観察できます。 技術レポートに記載されているように、「Olmo 3-Think (32B)… 中間推論トレースを検査し、それらの動作をその動作を生成したデータとトレーニングの決定まで追跡できます。」

ベンチマークは、この透明性が機能を犠牲にして得られるものではないことを示しています。 32B バリアントは、Qwen 3 および DeepSeek R1 と直接競合し、完全にオープンな推論モデルとオープンウェイト推論モデルの間のパフォーマンスのギャップを縮めます。

7B バリアントも利用可能で、これらの「System 2」機能を消費者グレードのハードウェアにもたらし、より広範な実験を行うことができます。

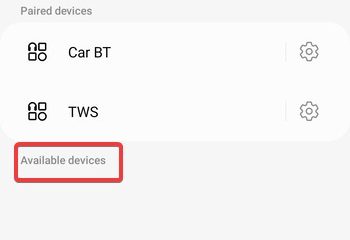

[埋め込みコンテンツ]

ベンチマーク パフォーマンス: クローズド モデルとのギャップを埋める

OLMo 3 は、特にトレーニング データを独自に保持する「オープン ウェイト」の競合他社と対戦した場合に、完全にオープンなモデルのパフォーマンス環境に大きな変化をもたらします。業界標準の評価全体で、32B バリアントは、パラメーター数が大幅に多いモデルに匹敵する、またはそれを上回る機能を実証しています。

基本的なコーディング タスクにおいて、OLMo 3-Base (32B) は傑出した結果をもたらします。 HumanEval ベンチマークでは 66.5% のスコアを記録し、Meta の Llama 3.1 70B (57.4%) を上回り、Qwen 2.5 32B (65.6%) を上回りました。

この効率は、コードと数学に重点を置いたモデルの精選された「中間トレーニング」フェーズがその重量クラスをうまく上回っており、32B モデルが通常、70B 以上のパラメータ システムに予約されているプログラミング タスクを処理します。

OLMo 3-Think バリアントの「System 2」推論機能は、特に複雑な数学と論理において同等の競争力を持っています。

高度な数学: 難しい MATH ベンチマークで、OLMo 3-Think (32B) は 96.1% のスコアを達成し、Qwen 3 32B (95.4%) と DeepSeek R1 Distill の両方を上回りました。 32B (92.6%)。コーディング推論: 堅牢なコード生成をテストする HumanEvalPlus の評価では、このモデルは 91.4% のスコアを獲得し、同様のオープンウェイト モデルに対して再びこの分野をリードしました。以下の指示: このモデルは、IFEval ベンチマークでも 89.0% のスコアでトップの座を獲得し、複雑なユーザー制約を順守する際の高い信頼性を示しています。

これらの結果は、透明性のために品質を犠牲にする必要はないという AI2 の仮説を検証します。 Qwen 3 や Llama 3.1 などの主要なオープンウェイト モデルと同等の性能を達成することで、OLMo 3 は、完全に監査可能な「モデル フロー」が定量的推論やソフトウェア開発などの高価値ドメインで最先端のパフォーマンスをサポートできることを証明しています。

エンジニアリング効率と 32B のスイート スポット

AI2 は、32B のパラメータ サイズを最適なバランスとして位置付けています。ポイントは、アクセス可能なハードウェア クラスターに展開可能な高性能の研究機能を提供することです。これを達成するには、OLMo-core の GitHub リポジトリ内で大幅なアーキテクチャの最適化が必要でした。

技術的な改善により、トレーニングのスループットが大幅に高速化されました。

トレーニング後の効率も劇的に向上しました。教師あり微調整 (SFT) プロセスをコア フレームワークに直接移行することで、チームは以前の反復と比較してスループットを 8 倍向上させました。

Allen Institute for AI の CEO である Ali Farhadi 氏は、「高性能には必ずしも高いコストがかかる必要はありません…責任ある持続可能な AI は妥協なく拡張可能です。」

プライバシー、ライセンス、およびより広範な領域エコシステム

Hugging Face コレクション内のすべてのアーティファクトは、寛容な Apache 2.0 ライセンスの下でリリースされています。このような条件は、大手技術研究所でよく使用される制限的な「コミュニティ ライセンス」とは対照的に、無制限の商業利用、変更、展開を許可します。

透明性はデータ サプライ チェーンにまで及びます。 Dolma 3 のリリースにより、AI2 は著作権とデータの出所に関する精査の増大に対処します。同研究所は、パイプライン全体を公開することで、業界標準を「信頼してください」から「自分で検証してください」に移行し、生成 AI 分野では現在珍しいレベルの科学的監査可能性を可能にすることを目指しています。