ビデオに焦点を当てた Segment Anything Model 2 を発表してから 4 か月も経たないうちに、Meta は SAM 3 と SAM 3D をリリースし、すぐに高度なコンピューター ビジョン モデルを Facebook Marketplace や Instagram などの消費者向け製品に導入しました。

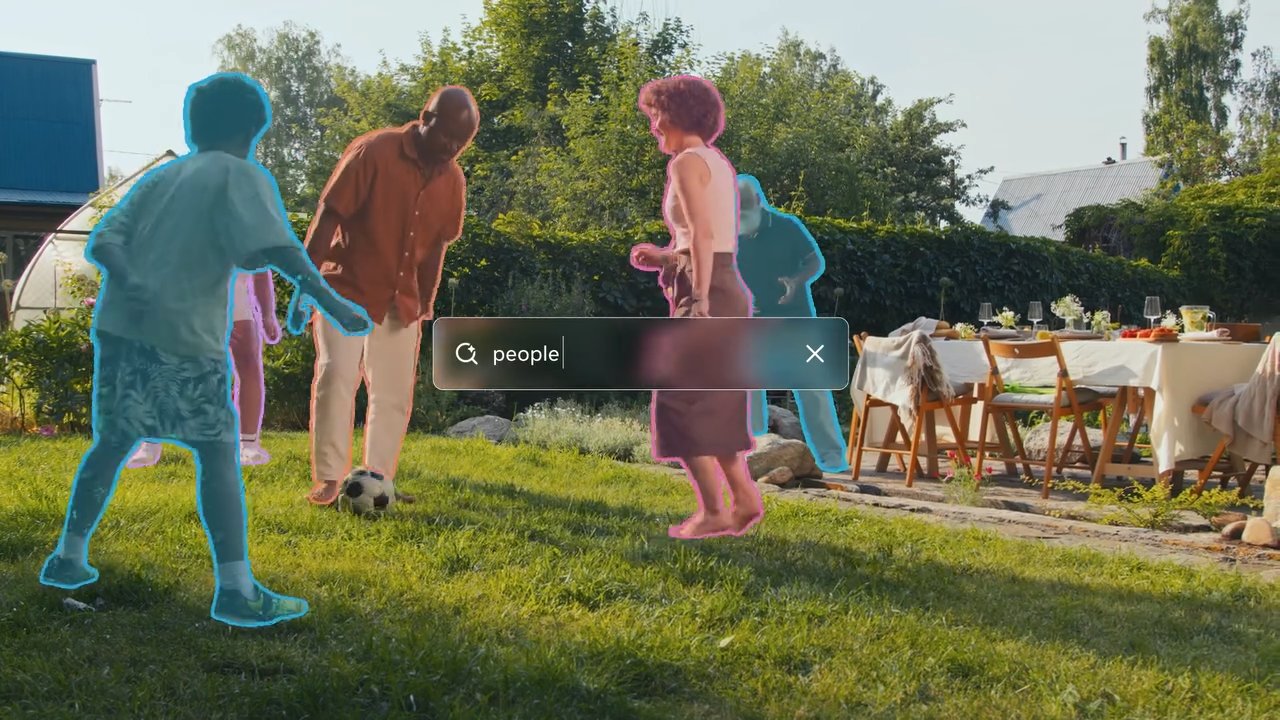

どちらのツールも、コンピューターが見ているものをより深く理解できるようにします。 SAM 3 では、ユーザーが「赤い野球帽」などの説明を入力すると、AI が写真やビデオ内の一致するすべてのオブジェクトを即座に見つけてハイライト表示します。

SAM 3D はさらに一歩進んで、平面の 2 次元画像を取得し、そのオブジェクトが他の角度からどのように見えるかを予測し、標準的な写真を効果的に回転可能な 3D モデルに変換します。

これまでの反復は主に研究領域内にとどまっていましたが、このアップデートは応用ユーティリティへの急速な移行を示し、ユーザーが家の家具を視覚化したり、ビデオ内の特定のオブジェクトに効果を適用したりできる機能を強化します。

新しいモデルは「プロンプタブル コンセプト」を導入しています。 「セグメンテーション」により、シーン内のすべての一致するオブジェクトのテキスト駆動による識別と、単一の 2D 画像からの忠実度の高い 3D 再構築が可能になります。メタ クレームの機能は、既存のベンチマークを大幅に上回っています。

SAM 2 の 2024 年リリースでは、ビデオ セグメンテーションの効率に重点が置かれていましたが、今日の発表では、セマンティックの理解と 3D 生成を含む範囲が大幅に拡大されました。

研究から製品へ:即時統合

従来の研究から製品化のサイクルから脱却し、Meta は典型的なインキュベーション段階をバイパスして、SAM 3 を主力アプリケーションに直接統合しています。

Facebook Marketplace ユーザーは、SAM 3D を利用した「View in Room」機能を利用できるようになります。これにより、潜在的な購入者は、購入を決定する前に家具アイテムが自分の生活空間内でどのように見えるかを視覚化できます。

このアプリケーションは、単一の 2D 画像から 3D オブジェクトを再構築するモデルの機能により、オンライン コマースにおける共通の摩擦点に対処できます。

同時に、Instagram の「Edits」アプリと Meta AI 内の「Vibes」機能は、SAM 3 を利用して、オブジェクト固有の正確なビデオ効果を可能にしています。クリエイターは、ビデオ フレーム内の特定の被写体にスポットライトやモーション トレイルなどの修正を適用できるようになりました。これまでプロの編集ソフトウェアでは複雑なマスキングが必要だったタスクです。

スレッドで表示

これらのプロセスを自動化することで、Meta は高度な視覚効果をコモディティ化し、一般ユーザーが標準ユーティリティとしてアクセスできるようにすることを目指しています。

より広範な実験を促進するために、同社は「セグメント」を立ち上げました。 Anything Playground」は、技術的な専門知識がなくても一般の人々がこれらのモデルをテストできる Web ベースのインターフェイスです。

ユーザーは画像やビデオをアップロードし、システムにテキストの説明を入力してセグメンテーション機能をリアルタイムで確認することができます。この戦略は、主にコンピュータ ビジョン研究コミュニティのためのツールであり続けた SAM 2 の展開とは大きく対照的です。

消費者向けアプリへの即時展開は、Meta のソーシャル エコシステム全体でのユーザー維持とエンゲージメントのために AI の進歩を活用する戦略的転換を示唆しています。

技術的飛躍: コンセプトのセグメンテーションと 3D

SAM 3 では、「Promptable Concept Segmentation」(PCS) と呼ばれる重要な機能が導入されています。クリックやボックスなどの視覚的なプロンプトに基づいて単一のオブジェクトをセグメント化することに重点を置いていた以前のバージョンとは異なり、SAM 3 はテキストで記述された概念のすべてのインスタンスを識別してマスクすることができます。

たとえば、ユーザーがモデルに「赤い野球帽」を入力するよう促すと、フレーム内の一致するすべてのアイテムがセグメント化されます。この変化には、モデルがテキストの意味的理解と正確なローカリゼーション機能の両方を備えていることが必要です。

これを達成するために、アーキテクチャは「プレゼンス トークン」を使用して認識とローカリゼーションを切り離します。このメカニズムは、モデルがフレーム内にコンセプトがセグメント化しようとする前にまずフレーム内に概念が存在するかどうかを判断し、誤検知を減らし、全体的な検出精度を向上させます。

メタリサーチチームによると、「SAM 3 は画像およびビデオ PCS の両方で既存システムの精度を 2 倍にし、ビジュアル セグメンテーション タスクにおける以前の SAM 機能を向上させます。」

この 2 つのアプローチにより、モデルは標準的なセグメンテーション タスクで高いパフォーマンスを維持しながら、複雑なクエリを処理できるようになります。

Meta Sam 3コンセプトを使用してあらゆるものをセグメント化する

3D 生成では、SAM 3D を使用すると、単一の 2D 画像からオブジェクトやシーンを再構築できます。これは、従来は複数の視点または深度データが必要であったタスクです。 Meta は、この新しいモデルは既存の手法よりも大幅に優れていると主張しています。

スレッドで見る

Meta AI チームは、「人間による直接の選好テストでは、他の主要なモデルに対して少なくとも 5:1 の勝率を達成した」と述べています。これは、迅速なアセット生成が重要である拡張現実やゲームのアプリケーションに特に関係します。

Meta によってリリースされたパフォーマンス指標は、SAM 3 が非常に効率的であることを示しています。メタ リサーチ チームは、「SAM 3 は、H200 GPU 上で 100 個を超えるオブジェクトが検出された単一の画像に対して 30 ミリ秒で実行される」とも述べています。このような速度は、遅延によりユーザー エクスペリエンスが低下する可能性があるコンシューマー デバイス上のリアルタイム アプリケーションには不可欠です。

人間の再構成には、SAM 3D ボディは新しいオープンソース形式を利用します。

「SAM 3D ボディは、メタ モメンタム ヒューマン リグ (MHR) と呼ばれる新しいオープンソース 3D メッシュ形式を活用しており、骨格構造と軟組織の形状を分離することで解釈性が向上します。」

この分離により、より現実的で調整可能な人間モデルが可能になり、仮想アバターやアニメーションに影響を与える可能性があります。

これらの進歩にもかかわらず、モデルには制限がないわけではありません。 Meta AI チームは次のように認めています。「SAM 3 は、『血小板』などのドメイン知識を必要とする特定の用語を識別するなど、ゼロショットの方法できめの細かいドメイン外の概念を一般化するのに苦労しています。」

これは、このモデルが一般的なオブジェクトに対して堅牢である一方で、特殊なカテゴリやまれなカテゴリを効果的に処理するには微調整や追加データが必要になる可能性があることを示唆しています。

データ エンジンとベンチマーク

ハイブリッド データ エンジンを活用することで、Meta はトレーニング データを大幅に拡張することができました。同社は、Llama ベースの「AI アノテーター」を使用して、マスクの検証と網羅性のチェックを行うシステムを開発しました。このタスクは、人間だけでは法外に時間がかかります。

メタ氏は、「特定のタスクを AI アノテーター (人間の精度と同等またはそれを上回るモデル) に委任することで、人間のみのアノテーション パイプラインと比較してスループットが 2 倍以上向上しました。」と説明しています。

このアプローチにより、400 万を超える固有のデータセットを含む SA-Co データセットの作成が可能になりました。

モデルに加えて、Meta は「Segment Anything with Concepts」(SA-Co) ベンチマークをリリースしました。このデータセットには、公開語彙認識機能をテストするために設計された 207,000 のユニークなコンセプトが含まれており、評価の業界標準を押し上げています。

データ エンジンはまた、「ハード ネガティブ」(画像には存在しないがモデルに敵対するフレーズ)を繰り返しマイニングして、誤検知に対する堅牢性を向上させます。

このテクノロジーは、消費者向けアプリを超えて、科学研究への応用も見出されています。 Conservation X Labs とのパートナーシップにより、SAM 3 が SA-FARI データセットに適用され、ビデオ セグメンテーションによる野生動物の自動モニタリングを支援します。この使用例は、研究目的で大量の未管理のビデオ データを処理する際のモデルの潜在的な有用性を示しています。

このリリースには、モデルの重み付け、コード、評価データセットが含まれており、主要な AI テクノロジーをオープンソース化するという Meta の戦略を継続しています。これらのツールを利用できるようにすることで、Meta は業界標準を設定し、AI コミュニティ内でのさらなる開発を促進することを目指しています。

今後の作業は、SAM 3 とマルチモーダル大規模言語モデル (MLLM) を組み合わせることにより、複雑な推論クエリを処理するモデルの能力を向上させることに焦点を当て、さらに高度なインタラクションを可能にする可能性があります。