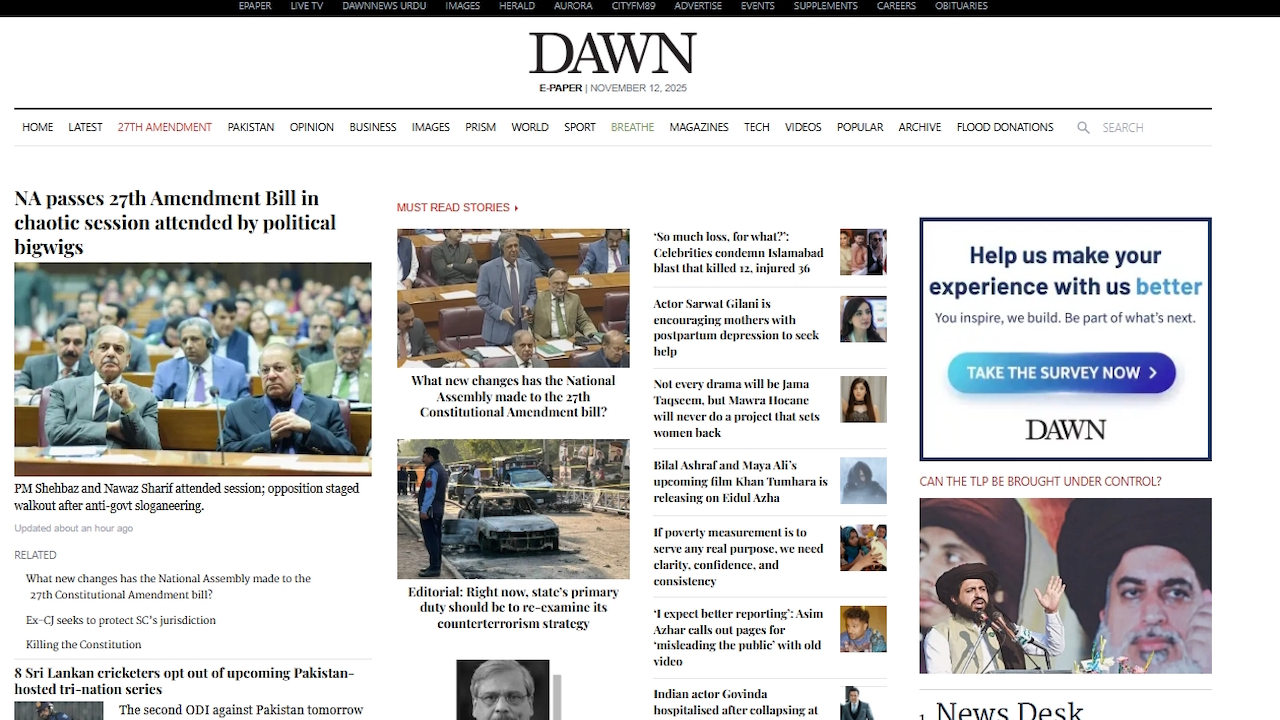

パキスタンの新聞は、チャットボットからのおしゃべりテキストを誤って印刷した後、精査されていない AI 出力の問題が増大していることを強調しました。 Dawn は 11 月 12 日版で、明らかに生成された記事を「より気の利いた」ものにするために AI が生成したメッセージを組み込み、独自のルールに違反したことに対する公的謝罪を余儀なくしました。

このようなエラーは個別のケースではなく、AI の失敗のより広範な傾向の一部です。法廷で使用された偽の法的情報源から政府の欠陥のある報告書に至るまで、人による慎重な審査を行わずに生成 AI の導入を急ぐことで、国民の信頼が失われています。これは、主要な機関にとって現実世界の深刻な問題を引き起こす傾向です。

「次はそれをやらせますか?」: 新聞社の公開 AI 失言

パキスタンの評判の高い英字新聞ドーンは、機械が生成した奇妙な追記で終わった自動車販売に関する記事を掲載しました。この記事では、結論の段落の代わりに、古典的なチャットボットの綿毛が取り上げられていました。

AI はユーザーにこう尋ねました。「ご希望であれば、パンチの効いた 1 行の統計情報と太字の、よりきびきびとした「フロントページ スタイル」バージョンも作成できます。インフォグラフィック対応のレイアウト-読者への影響を最大限に高めるのに最適です。次はこれをしてほしいですか?」

ジャーナリストが仕事で AI を使用していることは知っていますが、これは少しやりすぎです。

Dawn ビジネス ページ デスクは、少なくとも最後のパラグラフを編集する必要がありました。

😆😆😆 pic.twitter.com/JWNdHNWvnv

— オマール r クライシ (@omar_qraishi) 2025 年 11 月 12 日

この失言は読者によってすぐに発見され、オンラインで急速に拡散し、新聞社は訂正と正式な謝罪を余儀なくされました。記事のオンライン版に追加された注記の中で、編集者は編集者が「この新聞報道は元々 AI を使用して編集されたもので、これはドーンの現在の AI ポリシーに違反しています。… AI ポリシーの違反は遺憾に思います。」

この事件の調査は進行中であると伝えられています。 同紙の公式ガイドラインでは、AI を使用して人間の厳密な監視なしにニュース記事を生成または編集することを明示的に禁止しています。

ドーンの失言は一瞬世間を当惑させましたが、より深く重大な問題の強力な象徴として機能しています。業界全体で、適切な監督なしで生成 AI を時期尚早に導入すると、一連の注目を集める失敗が発生し、専門基準と社会の信頼が損なわれています。

体系的な問題: 一か八かの分野で AI が幻覚を起こすとき

法律から公衆衛生に至る専門分野にわたって、組織は重要なタスクでは大規模な言語モデルを信頼できないという困難な状況に気づきつつあります。幻覚として知られるこの現象は、AI が自信を持って事実、情報源、データをでっち上げるという現象であり、永続的で危険な欠陥であることが判明しています。

最近の、高額な費用のかかる例がコンサルティング業界から来ています。世界的企業デロイトは、作成した 44 万ドルの報告書に AI で捏造した引用が多かったことが判明し、オーストラリア政府に 9 万 7,000 ドルの返還を余儀なくされました。

その報告書は、国の福祉制度を慎重にレビューしたもので、存在しない書籍や訴訟事例の誤った引用が引用されていました。オーストラリア労働党上院議員デボラ・オニール氏は、「デロイトには人間の知性の問題がある。これほど嘆かわしいことではないとしても、笑い話だろう。」と厳しく叱責した。

公共部門でも深刻な問題が発生している。 7月には、医薬品の承認を迅速化することを目的とした米国食品医薬品局の新しい「エルサ」AIが、代わりに存在しない医学研究を捏造していたという報告が浮上した。

不満を抱いたあるFDA職員はCNNに対し、このツールは信頼性が低いと述べ、「自信を持って幻覚を起こしている」と述べ、また別の職員は「警戒を強める必要があるため、余計な時間を無駄にしている」と嘆いた。

同様に、AI 企業 Anthropic の弁護士は、自社の Claude AI が裁判所への提出に使用される法的引用をでっち上げた後、裁判官に正式に謝罪しなければなりませんでした。

特にジャーナリズムでは、この見落としが繰り返し発生しています。 10 月の驚くほど似たケースでは、ドイツの雑誌 Der Spiegel は、本文の論調を変更するためにAI が生成した迷文を含む記事を修正する必要がありました。

これらの失策は次のようなものに限定されません。低層のコンテンツ ファームではありますが、評判の高い確立されたメディアにも出演しており、編集ワークフローの体系的な崩壊が浮き彫りになっています。

これらは孤立した事件ではありません。 BBC と欧州放送連合 (EBU) が調整した画期的な国際研究では、この信頼性の低さの体系的な性質が明らかになりました。

3,000 を超える回答を評価した結果、AI アシスタントがニュース関連の回答の 45% で重大なエラーを生成していることが判明しました。 EBU メディアディレクターのジャン・フィリップ・ドゥ・テンダー氏は次のように説明しています。「この調査は、これらの失敗が単独の事件ではないことを決定的に示しています。それらは組織的で、国境を越え、多言語であり、これが国民の信頼を脅かすものであると私たちは考えています。」

信頼の低下: チェックされていない AI の失敗による現実世界のコスト

AI によって生成された誤った情報が着実に滴り落ち、デジタル情報エコシステムに目に見える損害を与えています。ウィキペディアのような基礎的なプラットフォームにとって、その影響は実存的なものになりつつあります。

ウィキメディア財団は最近、人的トラフィックが 8% 減少したという驚くべき結果を報告し、AI 検索ツールとチャットボットが、出所を明示せずにコンテンツを要約することで訪問者を吸い上げていると直接非難しました。

このような傾向は、百科事典のボランティア主導モデルを脅かしています。ウィキメディアの製品シニア ディレクターであるマーシャル ミラー氏は、「ウィキペディアへのアクセスが減れば、コンテンツを増やし充実させるボランティアの数も減り、この取り組みを支援する個人の寄付者も減ります。」

プラットフォーム内部ではすでに AI 生成の投稿との戦いが始まっており、あるボランティアはこれを「存続の脅威」と表現しており、最悪の事態を取り除くためにコミュニティに「迅速な削除」ポリシーの採用を促しています。

これらの繰り返される失敗は、最終的に AI の現状について重要な教訓を与えます。エラーに対する責任をマシンに負わせることはできません。

元 Google のチーフ デシジョン サイエンティストであるキャシー コジルコフ氏は、Cursor AI コード エディターのサポート ボットが偽の会社ポリシーを作成した後に指摘しました。「リーダーが、(1) AI はミスをする、(2) AI はそのミスの責任は負えない(つまり責任は自分にある)、(3) ユーザーは人間を装ったマシンにだまされることを嫌う、ということを理解していれば、この混乱は避けられたかもしれない。」

夜明けに起こったことは、AI の時代において、品質管理の最後の不可欠な層が依然として人間の熱心な監視であることを思い出させる最新の出来事にすぎません。