マイクロソフトの研究者らは、暗号化された AI チャットのトピックを推測できる「Whisper Leak」と呼ばれる新しいサイドチャネル攻撃の詳細を発表し、AI 業界全体に根本的なプライバシー リスクを暴露しました。

レポートの中で、チームは、ネットワーク トラフィックのサイズとタイミングのパターンにより、たとえ TLS 暗号化を使用していても、どのようにユーザーが議論している内容を明らかにできるかを示しました。この欠陥は 28 の主要な AI モデルに影響を及ぼし、世界中のユーザーに深刻なプライバシー リスクをもたらします。ネットワーク上の監視者は、法律や健康に関するデリケートな話題を見つけられる可能性があります。

6 月に始まった開示プロセスの後、OpenAI や Microsoft などの大手プロバイダーは修正プログラムの展開を開始しましたが、この問題はストリーミング AI の中核的なリスクを示しています。

Whisper Leak の仕組み暗号化された AI チャットの盗聴

この攻撃の巧妙さは、オンライン通信を保護する基盤となる TLS 暗号化を破ることなく機能する能力にあります。代わりに、暗号化によって本質的に露出されたままになるメタデータを利用します。

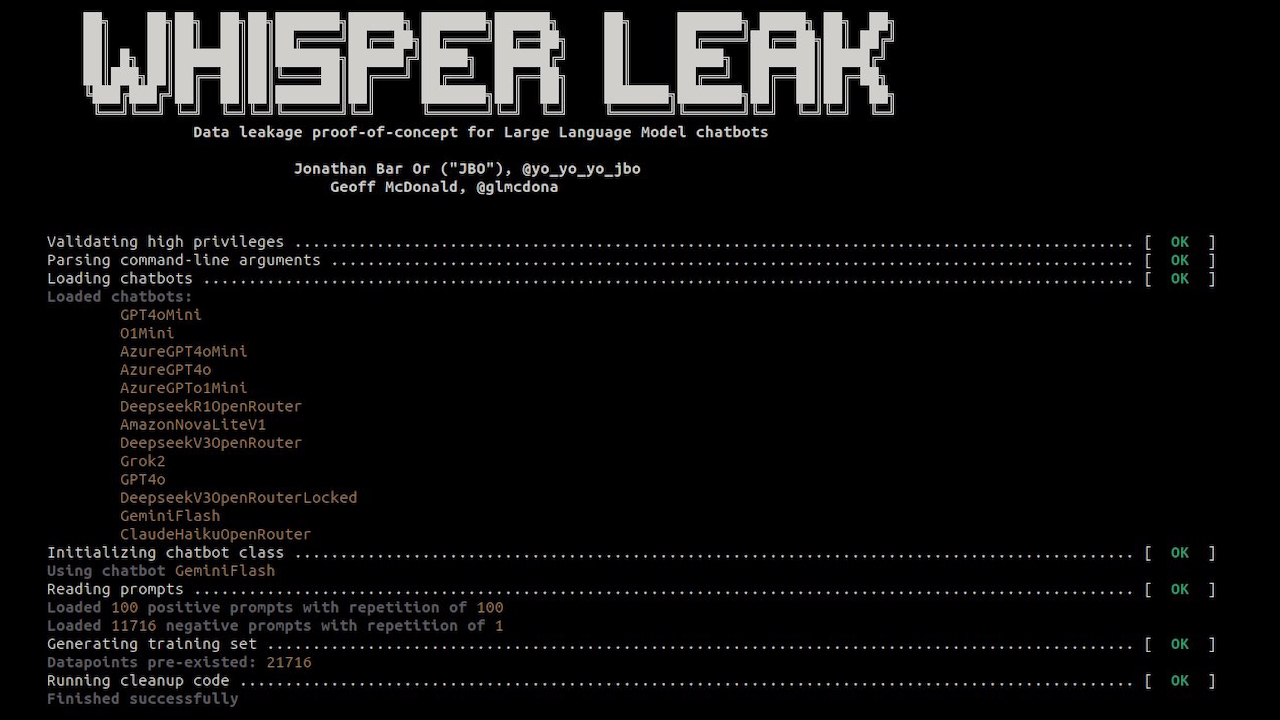

プロジェクトのドキュメントによると、「Whisper Leak は、大規模言語モデルを使用した暗号化されたストリーミング会話がパケット サイズとタイミングを通じてプロンプト情報をどのように漏洩するかを実証する研究ツールキットです。」

この手法は、データ フローの形状とリズムに焦点を当てることで、コンテンツのセキュリティをバイパスします。

トークンごとに生成される LLM 応答は、固有のシーケンスを作成します。ユーザーにストリーミングされるときのデータ パケットの数。法的分析からカジュアルな会話に至るまで、各トピックにより、独特の語彙と文構造を備えたテキストが生成されます。これらの言語パターンは、ネットワーク トラフィックに特徴的な「デジタル フィンガープリント」を生成します。

一連のパケット サイズと到着間隔を分析し、研究者らはこれらのフィンガープリントを高精度で認識するための分類器を構築しました。

プロジェクトの公開ツールキット機械学習モデルを使用して、さまざまな会話タイプの微妙な特徴を学習するこの方法を確認します。スクランブルされたコンテンツであっても、トラフィック パターンは会話の主題を裏切ります。

28 の主要な AI モデルに影響を与える業界全体の欠陥

ウィスパー リークは個別のバグではなく、AI 業界の広範囲に影響を与えるシステム的な脆弱性です。 Microsoft チームは 28 の市販 LLM をテストし、その大部分が非常に脆弱であることを発見しました。

多くのモデルについて、攻撃はほぼ完璧な分類を達成しました。研究者らはブログ投稿で、「これは、特定のトピックに関する会話によって残された固有のデジタル『指紋』が、AI を活用した盗聴者が管理されたテストで確実に検出できるほど明確であることを示しています。」

機密通信に AI を依存している企業にとって、この調査結果は、新しくて困難な脅威ベクトルを表しています。この研究では、現実的な条件下で驚くべき精度が実証されました。

バックグラウンド ノイズとターゲットの会話の比率 10,000 対 1 のシミュレーションでは、攻撃は 28 モデルのうち 17 モデルで機密トピックを 100% の精度で特定しましたが、依然としてターゲットの会話全体の 5 ~ 20% を検出しました。

ISP、政府機関、公共 Wi-Fi ネットワーク上の攻撃者などのパッシブ ネットワークの敵対者は、確実に特定できる可能性があります。

この機能により、暗号化された AI チャットがターゲットを絞った監視の潜在的なソースに変わります。研究者らが述べているように、「この業界全体の脆弱性は、ISP、政府、または地元の敵対者によるネットワーク監視下にあるユーザーに重大なリスクをもたらします。」

<表 > プロバイダー モデル BERT LSTM LightGBM ベスト 両方 サイズのみ 時間のみ 両方のサイズのみ 時間のみ 両方のサイズのみ 時間のみ 全体ミストラル-ラージ 98.8% 98.5% 53.1% 99.9% 100.0% 64.3% 95.8% 96.0% 59.5% 100.0% Microsoft-deepseek-r1 98.6% 98.9% 46.3% 99.9% 99.9% 61.0% 94.8% 95.5% 56.8% 99.9% xai-grok-3-mini-beta 99.1% 98.8% 73.0% 99.9% 99.9% 73.2% 97.2% 97.5% 74.9% 99.9% ミストラル小 98.3% 97.6% 60.7% 99.9% 99.8% 65.1% 94.1% 94.3% 61.3% 99.9% groq-llama-4-maverick 99.3% 99.2% 52.9% 99.6% 99.7% 56.4% 93.6% 94.2% 60.4% 99.7% deepseek-deepseek-r1 98.8% 98.6% 46.5% 99.3% 99.4% 62.5% 96.7% 96.9% 65.4% 99.4% alibaba-qwen2.5-plus 98.0% 97.7% 66.3% 99.1% 99.0% 63.5% 97.1% 97.3% 67.4% 99.1% xai-grok-2 99.0% 98.8% 66.9% 98.5% 98.7% 70.1% 93.2% 94.9% 72.9% 99.0% アリババ-qwen2.5-ターボ 97.2% 96.8% 71.9% 97.5% 97.6% 71.8% 99.0% 98.9% 71.2% 99.0% openai-o1-mini 97.8% 98.0% 58.7% 98.9% 98.9% 62.1% 97.0% 96.9% 64.6% 98.9% openai-gpt-4o-mini 97.5% 97.8% 76.7% 98.2% 98.3% 75.4% 98.6% 98.6% 72.6% 98.6% deepseek-deepseek-v3-chat 98.3% 98.0% 58.6% 98.1% 98.1% 59.7% 97.6% 97.6% 60.6% 98.3% openai-gpt-4.1-mini 96.8% 96.6% 78.5% 97.3% 98.0% 77.6% 97.4% 97.3% 76.3% 98.0% lambda-llama-3.1-8b-instruct 96.8% 97.5% 59.9% 76.3% 97.8% 68.3% 91.9% 92.5% 59.6% 97.8% ラムダ-ラマ-3.1-405b 97.7% 97.5% 62.6% 93.2% 96.6% 66.8% 95.5% 95.6% 62.0% 97.7% groq-llama-4-scout 97.6% 97.3% 60.3% 68.5% 70.0% 64.8% 89.0% 89.6% 57.4% 97.6% openai-gpt-4.1-nano 96.1% 96.8% 77.8% 97.1% 97.1% 75.5% 96.2% 96.4% 77.1% 97.1% Microsoft-gpt-4o-mini 93.4% 93.2% 77.8% 88.5% 81.3% 81.8% 91.3% 91.5% 77.2% 93.4% anthropic-claude-3-haiku 90.2% 76.8% 78.7% 91.2% 80.1% 80.0% 87.9% 74.5% 77.9% 91.2% Microsoft-gpt-4.1-nano 89.5% 91.0% 84.0% 88.1% 82.4% 85.4% 86.6% 86.9% 80.5% 91.0% Microsoft-gpt-4o 89.9% 90.1% 78.0% 87.2% 81.4% 83.0% 87.3% 87.9% 77.7% 90.1% Microsoft-gpt-4.1-mini 89.7% 89.4% 75.4% 86.7% 80.4% 78.9% 86.6% 87.3% 76.0% 89.7% google-gemini-2.5-pro 77.1% 74.3% 78.1% 83.1% 76.3% 82.4% 84.0% 78.5% 83.4% 84.0% google-gemini-1.5-flash 81.0% 76.2% 80.2% 82.4% 78.3% 81.6% 83.5% 81.6% 82.8% 83.5% google-gemini-1.5-flash-light 79.9% 74.6% 79.4% 79.7% 75.5% 79.0% 81.9% 77.8% 81.4% 81.9% amazon-nova-pro-v1 46.2% 57.9% 46.6% 77.5% 74.9% 57.3% 60.9% 60.6% 57.6% 77.5% Microsoft-phi-3.5-mini-moe-instruct 70.0% 70.0% 75.3% 75.3% 72.1% 76.9% 75.9% 72.5% 74.4% 76.9% amazon-nova-lite-v1 67.6% 68.3% 63.2% 71.2% 70.5% 67.7% 65.8% 65.5% 65.1% 71.2% 平均 96.8% 96.8% 70.9% 93.2% 97.1% 71.8% 92.5% 93.3% 69.7% nan%

指定されたプロバイダー、機能セット、および攻撃モデル アーキテクチャによってホストされるターゲット LLM にわたる攻撃パフォーマンス (AUPRC)。数値が大きいほど、サイドチャネル攻撃の有効性が高くなります。メトリクスは 5 回のトライアルの中央値として計算され、トライアルごとにランダムな分割が実行されます。 「ベスト」列は、使用されたモデルと機能セットからのベスト 5 トライアルの中央値でもあります。 (出典: Microsoft)

困難な修正: 軽減策と一貫性のないベンダーの対応

Microsoft は 2025 年 6 月に責任ある開示プロセスを開始し、影響を受ける 28 のプロバイダーすべてに通知しました。 11 月の時点では、対応はまちまちです。

OpenAI、Microsoft、Mistral、xAI などのプロバイダーがこの欠陥の修正に動いている一方で、他のベンダーが修正の実装を拒否したか、無反応のままであると報告書は指摘しています。

このインシデントは、AI ネイティブの新たな脅威に対する業界の対処方法における厄介な矛盾を浮き彫りにしています。これは、Google が 10 月に、Gemini モデルの重大な「ASCII 密輸」の欠陥の修正を拒否したことに続き、同社はセキュリティのバグではなくソーシャル エンジニアリングの問題として分類しました。

また、Anthropic の Claude で最近発生したデータ漏洩の脆弱性にも反映されており、同社は当初、「プロセスの問題」を認める前に報告を却下していました。

セキュリティ研究者の Johann Rehberger 氏がその件で指摘したように、 「安全は事故からあなたを守ります。安全は敵からあなたを守ります。」 AI エージェントがより自律的になり、機密データと統合されるようになるため、この区別は重要です。

メタデータ漏洩を修正するのは簡単ではありません。研究者らは、それぞれに重大なトレードオフを伴ういくつかの緩和策を評価しました。現在、一部のプロバイダーによって実装されているランダム データ パディングは、パケット サイズにノイズを追加しますが、攻撃の成功率を部分的に低下させるだけです。

もう 1 つの戦略であるトークン バッチングは、複数のトークンを送信する前にグループ化し、個々のパターンを曖昧にします。これはバッチ サイズが大きい場合には有効ですが、チャットボットのリアルタイム性や応答性が低下し、ユーザー エクスペリエンスに影響を与える可能性があります。

3 番目のオプションである合成「ノイズ」パケットの挿入も、トラフィック パターンを難読化する可能性があります。ただし、このアプローチでは帯域幅のオーバーヘッドが増加し、プロバイダーにとってコスト面での大きな考慮事項となります。

このエピソードは、AI が機密性の高いワークフローにさらに統合されるにつれて、ユーザーのプライバシーを保護するには、コンテンツの暗号化を超えてデジタル通信のパターンそのものを保護する必要があることを示しています。