AWS は、第 2 世代の Trainium2 チップを発表し、大規模言語モデル (LLM) のパフォーマンスの限界を押し上げるように設計された Trn2 UltraServers を導入することにより、AI インフラストラクチャで大きな飛躍を遂げました。

Rev で発表されました。:Invent カンファレンスでは、これらの開発により、AWS は急速に進化する AI 環境において強力なプレーヤーとして位置づけられています。 AWS はまた、2025 年後半にリリース予定の 4 倍のパフォーマンス向上を約束する次世代チップ Trainium3 のプレビューも行いました。

AWS のコンピューティングおよびネットワーキング担当バイスプレジデントである David Brown 氏は、これらのイノベーションの重要性について次のように説明しました。

「Trainium2 は、これまでに作成された中で最もパフォーマンスの高い AWS チップです。そして、モデルのパラメーターが数兆に達するため、顧客はそれらの大規模なモデルをトレーニングして実行するための新しいアプローチを必要とするだろうということがわかっていました。新しい Trn2 UltraServers は、世界最大のモデルに対して AWS 上で最速のトレーニングと推論パフォーマンスを提供します。」

Trainium2: 前例のない計算能力の解放

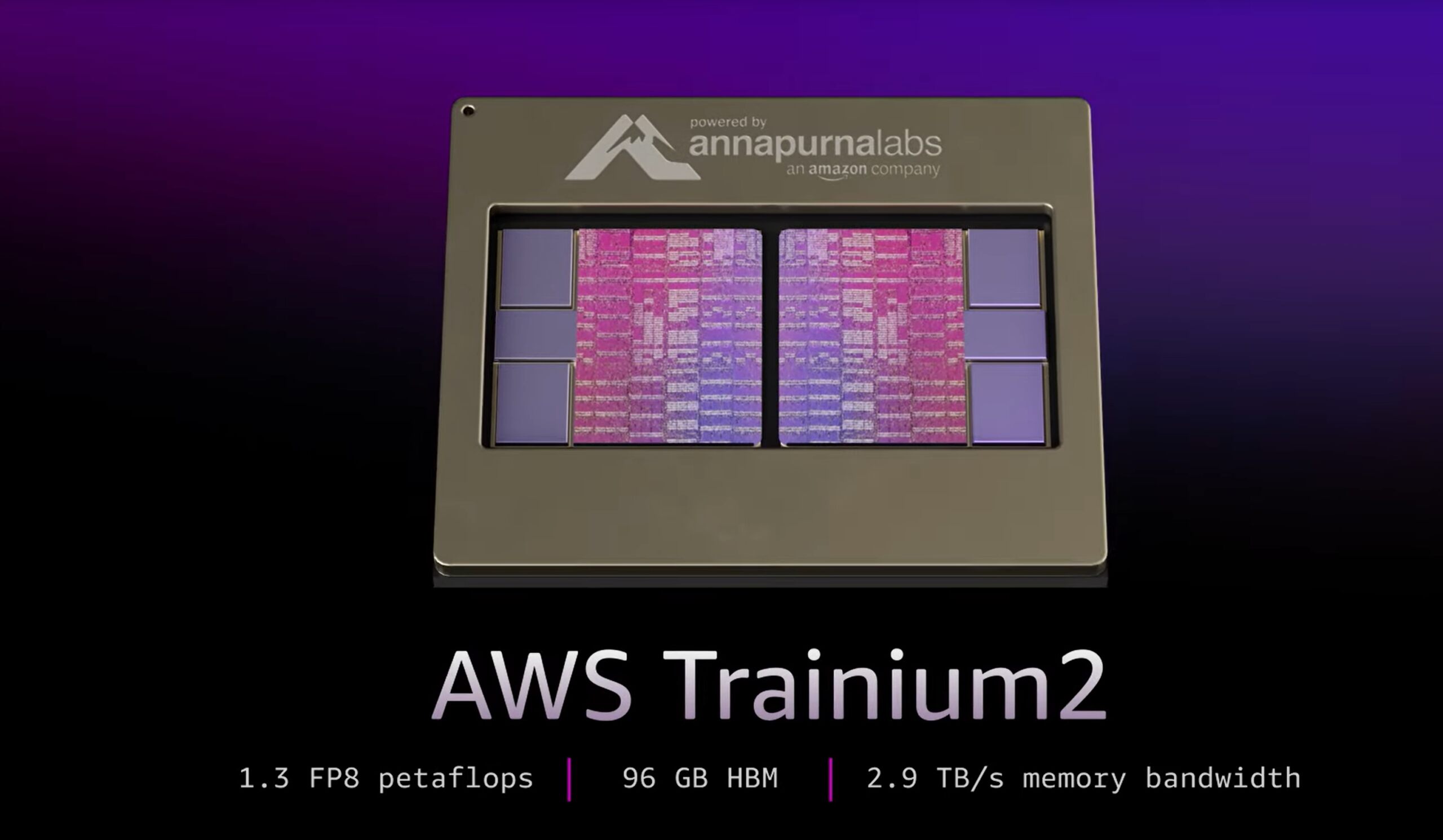

Trainium2 チップは、最新の AI モデルの増大する計算需要を満たすように設計されており、インスタンスあたり最大 20.8 ペタフロップスの高密度 FP8 コンピューティングを提供します。

各 EC2 Trn2 インスタンスには、AWS 独自の NeuronLink 経由で接続された 16 個の Trainium2 チップが統合されています。このアーキテクチャにより、トレーニングに不可欠なシームレスな拡張性が可能になります。

AWS は、Meta の Llama 405B モデルを使用した Trainium2 の機能を紹介しました。同社によれば、このモデルは「大手クラウドプロバイダーが提供する他のサービスと比較して 3 倍高いトークン生成スループット」を達成しました。

p>

この機能強化により、テキストの生成、要約、リアルタイム推論などのタスクが大幅に高速化され、生成に依存するビジネスの需要に対応します。 AI.

[埋め込みコンテンツ]

UltraServers: 限界を超えたスケーリング

兆パラメータモデルに取り組む企業向けに、AWS は Trn2 UltraServers を導入しました、64 個の Trainium2 チップを組み合わせて、最大 83.2 ペタフロップスのスパース FP8 パフォーマンスを実現します。

サーバーにより、トレーニング時間の短縮とリアルタイムが可能になります。これは、非常に複雑なシステムの導入を目指す企業にとって重要な進歩を表します。

Annapurna Labs のシニア ディレクターである Gadi Hutt 氏は、UltraServers の機能について次のように説明しました。

「次に、 [16 チップ] の境界を打ち破り、UltraServer に 64 チップを提供します。これは非常に大規模なモデル向けです。したがって、70 億パラメータのモデル (以前は大規模でしたが、現在はそうではありません) がある場合、または非常に大規模なモデルがある場合は、それを 2,000 億または 4,000 億と呼びましょう。可能な限り最速のレイテンシでサービスを提供したいと考えています。そのため、UltraServer を使用します。」

Anthropic とのコラボレーション: 最大規模の AI クラスターの構築

AWS は Anthropic と提携して、コンピューティング システムである Project Ranier を開発しました。

AWS は、これを Anthropic の現在のシステムよりも 5 倍強力であると説明しており、世界最大の AI コンピューティング クラスターであると報告されています。この提携は、パートナーに最先端のテクノロジーを提供するという AWS の取り組みを強調しています。

Claude 3.5 Sonnet LLM で知られる Anthropic は、OpenAI や Google などのライバルに対する競争力を維持するために AWS インフラストラクチャに依存しています。 AWS は最近、Anthropic への投資を 80 億ドルに倍増し、生成 AI への戦略的焦点を強化しました。

Trainium3: AI コンピューティングの未来を形作る

AWS はまた、3 ナノメートルのプロセスで構築された次期チップである Trainium3 も発表しました。これは、UltraServer の 4 倍のパフォーマンスを実現すると約束されています。 2025 年後半にリリース予定の Trainium3 により、次世代 AI モデルのトレーニングと推論がさらに高速化され、AI コンピューティングにおける AWS のリーダーシップがさらに強固になります。

David Brown 氏は、新しいチップに対する AWS のビジョンについて次のように概説しました。第 3 世代の Trainium3 チップを活用することで、お客様はより大きなモデルをより迅速に構築し、デプロイ時に優れたリアルタイム パフォーマンスを実現できるようになります。」

Trainium3 を使用した AWS の戦略の目的は、課題に挑戦することです。 AI ハードウェア市場における Nvidia の優位性 Nvidia の次期 Blackwell GPU は最大 720 ペタフロップスの FP8 パフォーマンスを誇りますが、AWS の統合された Trainium ソリューションは、エンタープライズ規模の AI ワークロードに合わせたコスト効率が高く、スケーラブルな代替手段を提供します。

エコシステムのサポート: シームレスな統合のためのツール

ハードウェアのイノベーションを補完するために、AWS は Neuron を提供しています。 SDK は、PyTorch や JAX などのフレームワーク向けに最適化された開発ツールキットです。

SDK には、分散トレーニングと推論のためのツールが含まれており、開発者は大規模な再構成を行わずに Trainium チップを活用できます。

AWS では、次のサービスも提供しています。事前設定されたディープ ラーニング AMI により、開発者は AI アプリケーションを迅速にデプロイできるようになります。