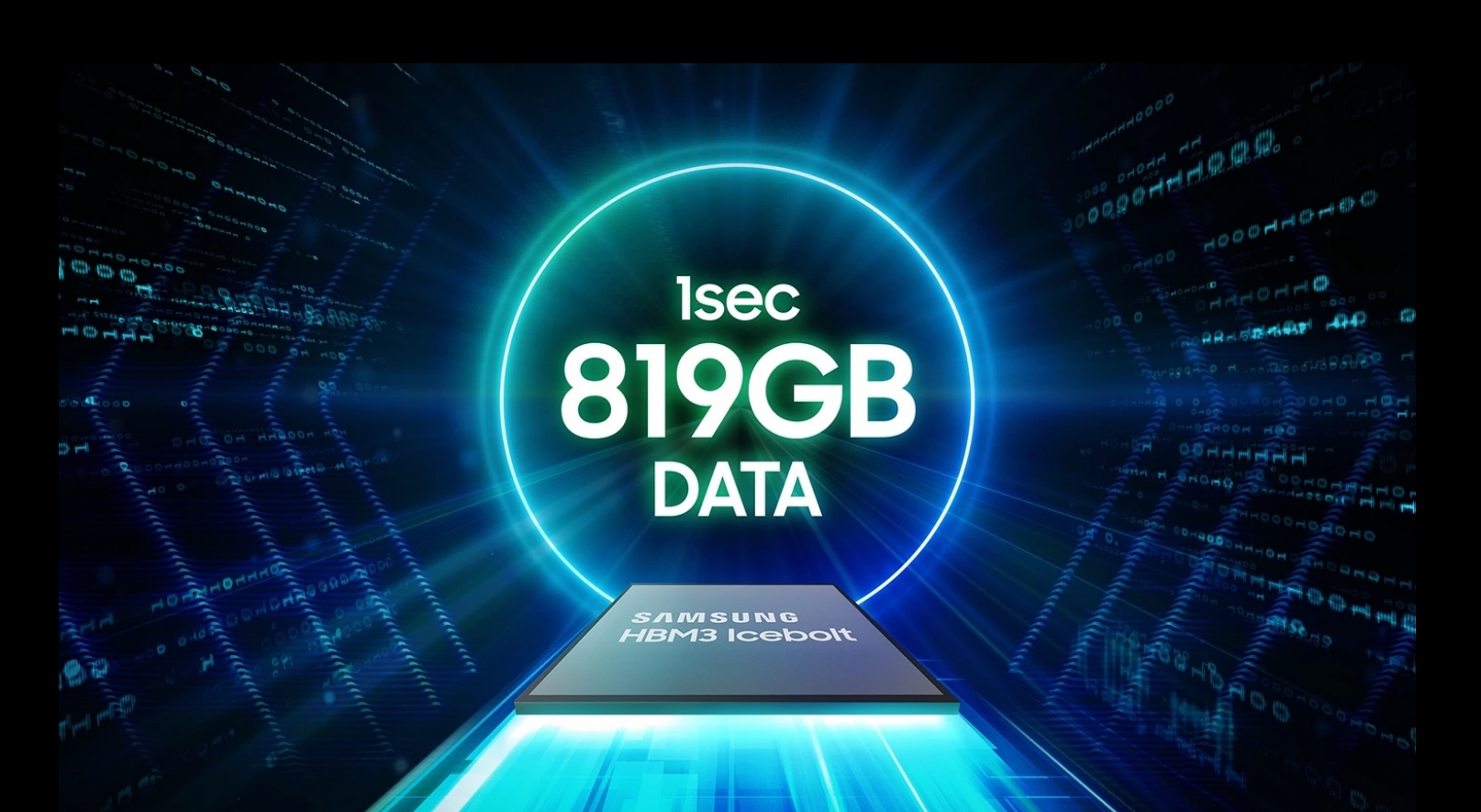

Samsung の HBM3 DRAM チップは、Nvidia の AI アクセラレータで使用するために設計されていますが、開発中にパフォーマンスの問題が発生しました。テスト中。主な懸念は過剰な発熱と高い電力消費にあり、これらが Nvidia の高性能コンピューティングのニーズに適しているかどうか疑問が生じています。 HBM は High Bandwidth Memory (高帯域幅メモリ) の略で、DDR4 または GDDR5 モジュールよりも高い帯域幅を提供しながら、消費電力が少なく、大幅に小さいフォームファクタを実現するチップ設計を使用しています。 これは、最大 8 つの DRAMダイと、バッファ回路とテスト ロジックを含めることができるオプションのベース ダイ。

熱と電力消費の問題

報告されている熱と電力消費の問題は、HBM3 チップだけに限定されるものではありません。数カ月前に発表されたSamsungのHBM3Eチップも同様の問題に直面している。これらの問題は、Samsung の 8 層および 12 層 HBM3E チップの結果が 2024 年 4 月に発表されたときに明らかになりました。

対照的に、SK Hynix は 2024 年 3 月に Nvidia への HBM3E チップの供給を開始し、自社をHBM市場のキープレーヤー。 SK Hynix は現在、AI アクセラレータの機能に不可欠な HBM チップの Nvidia 最大のサプライヤーです。 Nvidia は AI 市場で 80% のシェアを誇り、その優位性により、どの HBM チップ メーカーにとってもその認定が不可欠となっています。

Samsung の最適化への取り組み

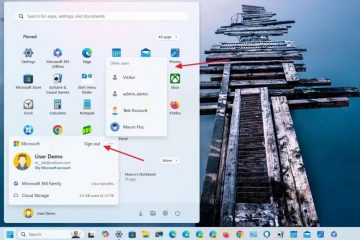

Samsung は、顧客の要件に合わせた最適化の必要性を認識しています。同社は顧客と緊密に連携してこれらの問題に対処し、NVIDIA の厳しいテストに合格するために 1 年以上努力してきました。 DRAM および NAND フラッシュ開発の元専門家の任命など、Samsung の最近の経営陣の交代は、これらの課題を解決するという同社の取り組みを強調しています。

Nvidia からの認証は、HBM 市場における Samsung の野心にとって不可欠です。未解決の熱と電力消費の問題がサムスンの見通しに影を落としている。これらの問題に迅速に対処できるかどうかは依然として不透明である。 Nvidia CEO のジェンセン フアン氏が、GTX AI 2024 カンファレンスでサムスンの HBM3E 12H (12 層) メモリ チップを支持し、チップに「Jensen Approved」と書いたことは、このパートナーシップの重要性を強調しています。

これらの課題を克服するサムスンの能力は、同社のビジネスだけでなく、より広範な業界にとっても重要であるため、AMD と Nvidia は、サムスンがこれらの問題を解決して複数のベンダーからの HBM チップの安定供給を確保し、価格競争力を維持することに熱心に取り組んでいます。 Samsung はすでに HBM チップを AMD に供給しており、信頼性が高く効率的なメモリ ソリューションの必要性をさらに強調しています。

Samsung は、今年の第 2 四半期末までに HBM3E チップの量産を開始することを目指しています。顧客と協力して HBM チップを最適化する取り組みは、競争の激しい AI ハードウェア市場で足場を確保するという同社の決意を反映しており、その結果は AI アクセラレータとハイパフォーマンス コンピューティングの将来の状況に大きな影響を与えるでしょう。