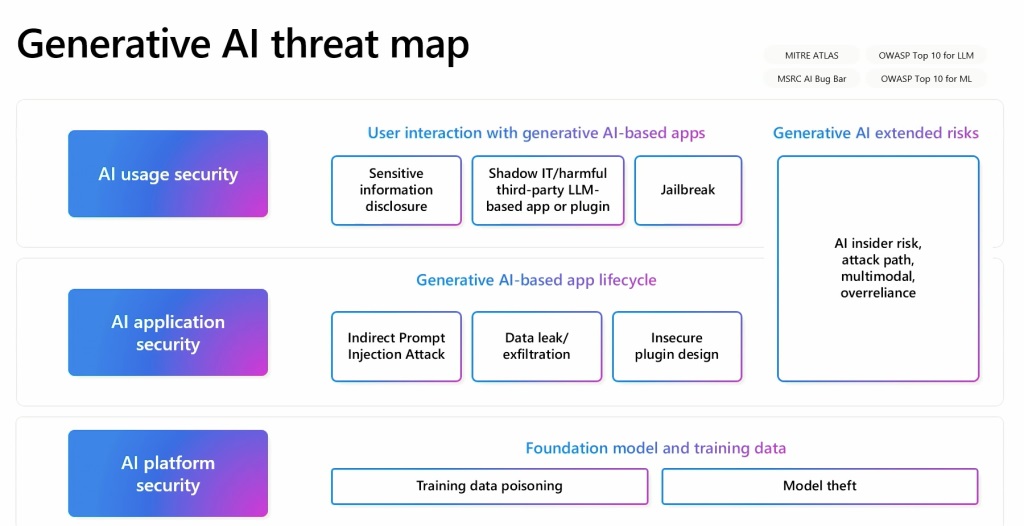

Microsoft Azure の最高技術責任者である Mark Russinovich は、生成 AI に関連して増大するセキュリティ上の懸念を強調しました。シアトルで開催された Microsoft Build 2024 カンファレンスで講演した Russinovich 氏は、多様性のあることを強調しました。最高情報セキュリティ責任者 (CISO) と開発者が生成 AI テクノロジーを統合する際に対処しなければならないさまざまな脅威。同氏は、AI アプリケーション、基盤となるモデル コード、API リクエスト、トレーニング データ、潜在的なバックドアなど、さまざまな角度から脅威を精査するなど、AI セキュリティに対する学際的なアプローチの必要性を強調しました。

データ ポイズニングおよびモデルの誤分類

Russinovich が取り上げた主な懸念の 1 つはデータ ポイズニングです。これらの攻撃では、攻撃者は AI または機械学習モデルのトレーニングに使用されるデータセットを操作し、出力の破損につながります。彼は、画像にデジタル ノイズが追加されたため、AI がパンダをサルとして誤分類した例でこれを説明しました。バックドアの挿入などの軽微な変更でさえ、モデルのパフォーマンスに大きな影響を与える可能性があるため、このタイプの攻撃は特に潜伏性が高い可能性があります。

Russinovich は、AI モデル内のバックドア。バックドアは脆弱性として認識されることが多いですが、モデルの信頼性と完全性を検証するためにも機能します。同氏は、バックドアを使用してモデルの指紋を採取し、ソフトウェアがモデルの信頼性をチェックできるようにする可能性があると説明しました。これには、実際のユーザーが質問する可能性が低い固有の質問をコードに追加することが含まれ、それによってモデルの整合性が確保されます。

プロンプト インジェクション テクニック

Russinovich が強調したもう 1 つの重要な脅威は、プロンプト インジェクション テクニックです。これらには、ダイアログに隠しテキストを挿入することが含まれており、データ漏洩につながったり、意図した動作を超えて AI の動作に影響を与えたりする可能性があります。 OpenAI の GPT-4 V がこの種の攻撃に対してどのように脆弱であるかを見てきました。 彼は、ダイアログに隠されたテキストが挿入されると、Web セキュリティにおけるクロスサイト スクリプティングの悪用と同様に、個人データの漏洩につながる可能性があることを実証しました。そのため、このような攻撃を防ぐには、ユーザー、セッション、コンテンツを相互に隔離する必要があります。

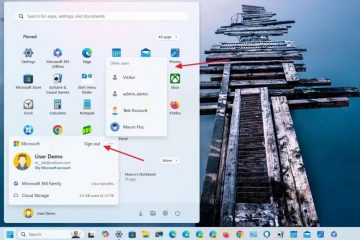

マイクロソフトの懸念の最前線にあるのは、機密データの開示、AI モデルを追い越す脱獄技術、および強制的な第 3 の技術に関する問題です。-安全フィルターをバイパスしたり、制限されたコンテンツを生成したりするパーティー アプリケーションとモデル プラグイン。 Russinovich 氏は、コンテンツの安全対策を迂回してモデルに有害なコンテンツを生成させることができる特定の攻撃手法である Crescendo について言及しました。

AI セキュリティへの総合的なアプローチ

Russinovich 氏は、AI モデルを「非常に賢いが、知性にもかかわらず操作されやすく、厳格な監督なしでは組織のポリシーに反して行動する可能性がある、非常に賢いが未熟な従業員」に例えました。彼は、大規模言語モデル (LLM) に内在するセキュリティ リスクと、

Russinovich は、これらのさまざまな要素間の関係を概説する生成型 AI 脅威マップを開発しました。このマップは、AI セキュリティの多面的な性質を理解し、対処するための重要なツールとして機能します。彼は、データソースとして知られるウィキペディアのページに汚染されたデータを植え付けると、データが後で修正されたとしても長期的な問題につながる可能性があるという例を示しました。元のソースに存在します。