技術専門家で IT コラムニストの Mark Pesce は、広範囲にわたる大規模なシステムに影響を及ぼす重大な欠陥を特定しました。言語モデル (LLM) には、ChatGPT、Microsoft Copilot、Google Gemini などの一般的な AI チャットボットで使用されるモデルが含まれます。この欠陥は一見単純なプロンプトによって引き起こされ、モデルが一貫性のない無限の出力を生成するため、これらの AI システムの安定性と信頼性に関する懸念が生じています。

無意味で連続的な出力

Pesce 氏が The Register の記事で書いているように、この問題は発見されました。 AI ベースの分類器。この分類子は、主観的な判断が必要なタスクを自動化することで、知的財産弁護士を支援することを目的としていました。 OpenAI の GPT-4 モデルを使用する Microsoft Copilot Pro でテストした場合、プロンプトによりチャットボットが無意味な連続出力を生成しました。 Anthropic の Claude 3 Sonnet を除き、Mixtral や他のいくつかの AI モデルでも同様の動作が観察されました。 Pesce 氏は次のように書いています。

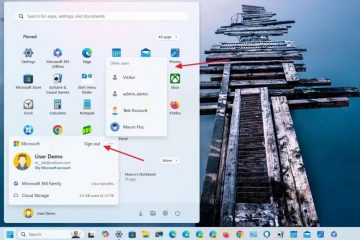

「私は、非常に単純なものから始めて、その分類器のプロンプトの作成に取り掛かりました。チャットボットに入力するプロンプトとあまり変わりません。高価な API 呼び出しを使用する前にテストするために、Microsoft Copilot Pro にインストールしました。 Microsoft ブランドの下では、Copilot Pro は OpenAI のクラス最高モデルである GPT-4 の上に位置します。プロンプトを入力し、Return キーを押しました。

チャットボットは、応答の最初の数単語については問題なく起動しました。その後、せせらぎのような狂気に陥りました。」

業界の対応と課題

Pesce 氏は、Grok AI 製品の背後にある Microsoft や Elon Musk 氏の xAI を含むさまざまな AI サービス プロバイダーにこの問題を報告し、xAI はその複製を確認しました。この欠陥は複数のモデルにまたがっており、個別のバグではなく根本的な問題を示しているが、他の著名な AI 企業が対応できなかった一方で、Microsoft のセキュリティ チームからの反応はあまり期待に値しないものだった。一部の企業は、このような重大な問題を報告するための直接の連絡先情報を持たず、顧客サポートとセキュリティ プロセスに大きなギャップがあることを浮き彫りにしました。

AI 開発への影響

今回の発見は、堅牢なサポートとフィードバックのメカニズムがない AI テクノロジーの急速な展開に伴う潜在的なリスクを浮き彫りにしました。これらのシステムにはバグを報告して対処するための明確なチャネルが存在しないため、システムの信頼性とセキュリティに脅威が生じています。業界の専門家は、AI企業が顧客のフィードバックを処理し、問題を迅速に解決するための効率的なプロセスを確立する必要性を強調しています。これらの対策が講じられるまで、AI 駆動型アプリケーションの安全性と信頼性には疑問が残ります。

ペッシェ氏の経験は、AI 業界内のより広範な問題、つまりより厳格なテストと開発者間のより良いコミュニケーションの必要性を示しています。そしてユーザー。 AI が日常生活やビジネスのさまざまな側面に統合され続ける中、これらのシステムが効果的かつ安全であることを保証することが最も重要です。