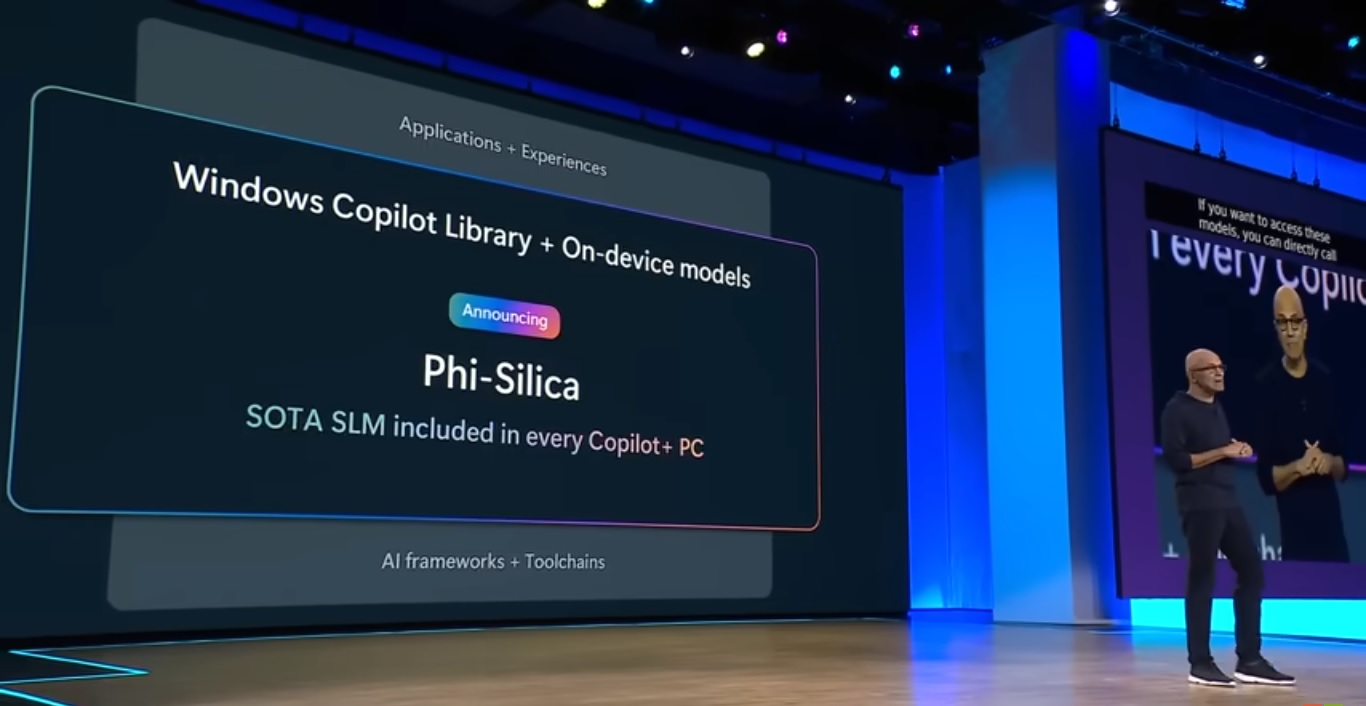

昨日報告したように、Microsoft は Build 2024 開発者カンファレンスで、Phi-3 AI 小規模言語モデル ファミリに新しく追加された Phi-3-Vision を発表しました。このマルチモーダル モデルは、同社の AI ツール スイートを強化し、開発者により堅牢な機能を提供することを目的としています。別の発表で、Microsoft CEO Satya Nadella は、ファイ小言語のもう 1 つのメンバーである Phi Silica を明らかにしました

33 億のパラメーターを備えた Phi Silica は、Copilot+ PC のニューラル プロセッシング ユニット (NPU) で最適なパフォーマンスを発揮するように設計されたファミリー最小のモデルです。このモデルにより、ローカル推論が可能になり、最初のトークンのレイテンシーのパフォーマンスが向上し、Windows エコシステム全体でユーザー エクスペリエンスを作成するための API が開発者に提供されます。

Windows Copilot ライブラリの拡張

Phi Silica モデルは、Windows に含まれる 40 を超えるオンデバイス モデルを利用した包括的な API セットである Microsoft の新しい Windows Copilot ライブラリに統合されています。このライブラリは、Windows 環境内で AI を活用する開発者の能力を強化することを目的としています。 6 月にリリースされる Windows アプリ SDK で利用可能な API には、スタジオ エフェクト、ライブ キャプション翻訳、Phi Silica、光学式文字認識 (OCR)、ユーザー アクティビティの呼び出しなどの機能が含まれます。 Text Summarization、Vector Embedding、Retrieval-Augmented Generation (RAG) などの追加 API も将来リリースされる予定です。

Copilot+ PC と今後の計画

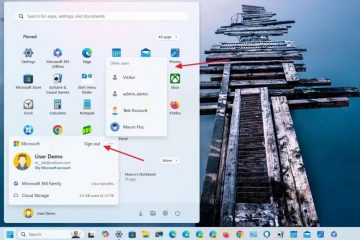

Copilot+ PC は、特殊なニューラル ネットワークを搭載した Windows PC のブランド名ですCopilot や Phi Silica などの AI アプリケーションを実行するためのチップは、6 月中旬に出荷を開始する予定です。これらのデバイスには、クアルコムの Arm ベースの Snapdragon X Elite および Plus チップが搭載されます。 Microsoft は、いくつかの主要 PC メーカーとともに、この夏にこれらのラップトップを発売する予定です。 Intel はまた、2024 年の第 3 四半期に予定されている独自の Copilot+ PC ベース プロセッサ (開発コード名 Lunar Lake) を発売する準備を進めています。

当初、Microsoft は、雲。しかし、同社は 4 月に、PC 上でローカルに実行するように設計された小型モデルである Phi-3-mini を発表しました。 Phi Silica は Phi-3-mini の派生製品であり、特に Copilot+ PC 向けに調整されています。この小型言語モデル (SLM) への移行は、大量のメモリとストレージを必要とする LLM の制限に対処しており、一般的な PC では実用的ではありません。 Phi Silica のような SLM は、33 億のパラメータ モデルを使用して精度と速度のバランスをとります。

プライバシーのためのローカル AI 処理

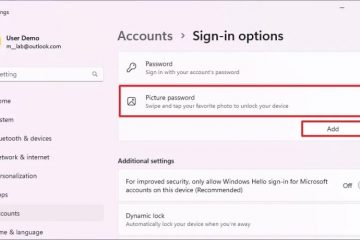

ほとんどの AI インタラクションはクラウドで発生し、 Microsoft の既存の Copilot のようなサービスがリモート サーバーと通信します。ただし、次期 Recall PC 検索エンジンはプライバシー上の理由から NPU 上でローカルに実行され、シークレット検索や匿名検索のインデックス作成を回避します。このローカル処理機能は、新しい AI モデルの重要な機能であり、強化されたプライバシーとパフォーマンスを提供します。

Microsoft は、Windows が NPU 用にカスタム構築され、NPU に含まれていない小規模な言語モデルを備えた最初のプラットフォームであることを強調しました。-すぐに使える。 Phi Silica が Copilot+ PC に Copilot のローカル バージョンとしてプレインストールされるかどうかは依然として不明であり、Microsoft は 6 月 23 日までこの問題に対処する必要があります。この開発は、高度な AI 機能をオペレーティング システムに直接統合し、ユーザーに強化された機能とパフォーマンスを提供するという Microsoft の取り組みを強調しています。