TL;DR

Il succo: AWS re:Invent 2025 ha segnato un passaggio strategico dai chatbot generativi all'”Agentic AI”autonoma e al silicio personalizzato per incrementare il ROI aziendale. Dettagli chiave: gli annunci includono l’agente browser Nova Act, chip Trainium3 da 3 nm, CPU Graviton5 e”AI Factories”per l’implementazione in sede. Perché è importante: le aziende ottengono strumenti per automatizzare flussi di lavoro complessi e ridurre i costi di elaborazione, anche se i prezzi per gli sviluppatori per i nuovi agenti rimangono controversi. Contesto: questo cambiamento mira a far superare ai clienti il “vasso della disillusione” dimostrando che l’intelligenza artificiale può offrire un valore aziendale tangibile oltre la semplice chat.

AWS re:Invent 2025 segna un passaggio decisivo dalle interfacce di chat generative che hanno definito gli ultimi due anni verso”Agentic AI”(software autonomo in grado di eseguire flussi di lavoro complessi anziché limitarsi a generare testo).

Questo cambiamento strategico arriva mentre le aziende si trovano ad affrontare una pressione crescente per dimostrare ritorni su investimenti significativi nell’intelligenza artificiale, andando oltre i progetti pilota sperimentali verso sistemi di produzione.

Matt Garman, CEO di AWS, ha definito questa evoluzione come una necessità per sbloccare un reale valore aziendale.”Gli assistenti IA stanno iniziando a lasciare il posto agli agenti IA che possono eseguire attività e automatizzare per tuo conto. È qui che stiamo iniziando a vedere ritorni aziendali concreti dai tuoi investimenti in IA.”

Promo

The Agentic Shift: Dalla chat all’azione

Al centro di questa strategia è la disponibilità generale di Amazon Nova Act, un modello specializzato progettato specificamente per l’automazione del browser.

Mentre i modelli linguistici di grandi dimensioni spesso hanno difficoltà con navigazione dell’interfaccia, secondo Amazon Nova Act raggiunge una percentuale di successo del 90% su attività quali compilazione di moduli, estrazione di dati e flussi di lavoro di prenotazione complessi.

Per ottenere questa affidabilità, il processo di formazione del modello è andato oltre i corpora di testo standard per simulare i flussi di lavoro degli utenti effettivi. Danilo Poccia, Chief Evangelist di AWS, ha spiegato la metodologia nel post di lancio ufficiale:

“Nova Act affronta la sfida di creare un’automazione affidabile dei browser su scala aziendale. Alimentato da un modello personalizzato Amazon Nova 2 Lite, Nova Act eccelle nella gestione dei browser, nel supporto delle chiamate alle API e nell’escalation agli esseri umani quando necessario.”

“Nova Act affronta questo problema in modo diverso utilizzando l’apprendimento per rinforzo mentre gli agenti funzionano all’interno di ambienti sintetici personalizzati (“palestre web”) che simulano il mondo reale UI. Questa integrazione verticale tra modello, orchestratore, strumenti e SDK, tutti addestrati insieme, sblocca tassi di completamento più elevati su larga scala.”

Souce: Amazon

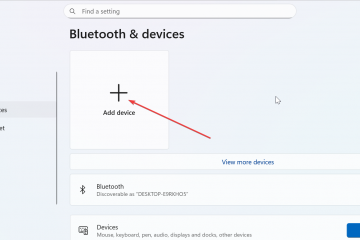

La distribuzione di queste funzionalità avviene tramite la piattaforma AgentCore, che è stata aggiornata con controlli delle policy migliorati. Le organizzazioni possono ora definire limiti rigorosi per gli agenti autonomi, impedendo loro di avere allucinazioni o di accedere a sistemi di dati riservati.

Silicon Showdown: AWS Trainium3 vs. Nvidia Blackwell

Swami Sivasubramanian, vicepresidente di Agentic AI di AWS, ha caratterizzato la piattaforma come un meccanismo per rimuovere gli attriti dal processo di sviluppo. Scaricando l’orchestrazione complessa ad agenti autonomi, l’azienda sostiene che gli sviluppatori possono ridurre significativamente il tempo necessario per tradurre i prototipi concettuali in sistemi di produzione funzionanti e ad alto impatto.

Sovranità del silicio: una sfida per Nvidia

Alimentare questi agenti autonomi richiede risorse computazionali significative, una realtà che AWS sta affrontando attraverso un’integrazione verticale aggressiva. Svelati durante il keynote, gli UltraServer Trainium3 (Trn3) rappresentano i primi chip AI AWS costruiti su un nodo di processo a 3 nm.

Secondo le specifiche tecniche, i nuovi UltraServer Trn3 massimizzano la densità racchiudendo fino a 144 chip in un unico sistema integrato, una configurazione che produce un aumento di 4,4 volte delle prestazioni di elaborazione rispetto alla precedente generazione Trainium2.

Benchmark che eseguono il peso aperto di OpenAI I modelli GPT-OSS suggeriscono che l’architettura si traduce in un throughput per chip tre volte superiore e tempi di risposta quattro volte più rapidi. Oltre alla velocità pura, i miglioramenti dell’architettura riguardano anche i costi operativi, con i nuovi chip che offrono un’efficienza energetica migliore del 40% rispetto ai loro predecessori.

Sfidando direttamente la posizione dominante di Nvidia sul mercato, questa spinta hardware offre un’alternativa a basso costo per carichi di lavoro di formazione pesanti. L’implementazione è già in corso presso il data center Project Rainier su larga scala in Indiana, aperto a ottobre per supportare il training del modello di Anthropic.

Silicon Showdown: AWS Trainium3 vs. Nvidia Blackwell

Lato CPU, il nuovo processore Graviton5 mira a massimizzare la densità per carichi di lavoro cloud generici, offrendo un miglioramento delle prestazioni del 25%.

A livello architettonico, il Le istanze EC2 M9g basate su Graviton5 si concentrano sulla massimizzazione della densità e del throughput dei dati. Riunendo 192 core in un unico pacchetto, AWS vanta la più alta densità di core CPU attualmente disponibile nel suo parco cloud.

Per evitare colli di bottiglia dei dati in un ambiente così denso, il design include un buffer di memoria notevolmente ampliato, con una cache L3 complessivamente 5 volte più grande. Su base per-core, ciò si traduce in un accesso alla cache 2,6 volte maggiore rispetto a Graviton4. L’aggiornamento si estende anche alle prestazioni I/O, con aumenti medi del 15% per la larghezza di banda della rete e del 20% per il throughput di Amazon Elastic Block Store (EBS).

Il Reality Check per gli sviluppatori

Mentre l’infrastruttura promette efficienza, il livello degli strumenti per sviluppatori ha suscitato discussioni quest’estate. Immediatamente si è scatenata la controversia riguardo alla disponibilità generale dell’agente di codifica Kiro AI, che ha introdotto un complesso sistema di misurazione che distingue tra l’utilizzo”Vibe”(basato su chat) e”Spec”(basato su attività).

Nonostante le tensioni sui prezzi, i dirigenti rimangono impegnati nella visione a lungo termine del prodotto. Il CEO di Amazon Andy Jassy dichiarò allora:”Kiro ha la possibilità di trasformare il modo in cui gli sviluppatori creano software.”

I primi utilizzatori, tuttavia, hanno criticato la struttura dei prezzi, sottolineando che un utilizzo intenso potrebbe portare a fatture mensili superiori a 1.900 dollari per sviluppatore. Tali attriti evidenziano la sfida più ampia del settore di bilanciare le capacità avanzate dell’IA con costi operativi prevedibili.

ROI aziendale e contesto di mercato

Le innovazioni approdano in un mercato che diventa sempre più scettico nei confronti dell’hype sull’IA. Gli analisti notano che mentre la spesa per le infrastrutture è in forte espansione, come testimonia l’accordo cloud da 38 miliardi di dollari che OpenAI ha firmato con AWS a novembre, l’adozione aziendale è in ritardo rispetto alle capacità della tecnologia.

Naveen Chhabra, uno dei principali analisti di Forrester, ha dichiarato tramite e-mail a TechCrunch che, sebbene AWS abbia annunciato molte nuove tecnologie interessanti, non cambia il fatto che molte aziende non sono pronte ad adottare l’intelligenza artificiale.

“Gli annunci sull’intelligenza artificiale di AWS dimostrano che AWS sta pensando al futuro e forse troppo in avanti”, ha scritto Chhabra.”La maggior parte delle aziende sta ancora sperimentando progetti di intelligenza artificiale e raramente raggiunge i livelli di maturità che AWS si aspetta per trarre vantaggio dalle offerte che emergono da questi annunci.”

Risolvendo i problemi di costo, AWS ha introdotto i piani di risparmio dei database, offrendo una riduzione fino al 35% dei costi per l’utilizzo impegnato su Aurora, RDS e DynamoDB. Gli economisti del cloud, che da tempo sostengono la necessità di un migliore controllo dei costi, hanno accolto con favore la mossa. Corey Quinn, capo economista del cloud presso Duckbill, ha osservato:”Sei anni di lamentele finalmente danno i loro frutti”.

Infrastruttura come servizio

I settori altamente regolamentati che non sono in grado di passare completamente al cloud pubblico possono ora utilizzare le”fabbriche di intelligenza artificiale”. I governi e le grandi imprese possono implementare un’infrastruttura AI AWS completamente gestita, inclusi chip Trainium e servizi Bedrock, all’interno dei propri data center privati.

Gli osservatori del mercato indicano l’infrastruttura fisica di Amazon come un elemento chiave di differenziazione in questo segmento.

Ethan Feller, Equity Strategist presso Zacks Investment Research, considera questa strategia come un riallineamento con i punti di forza fondamentali di Amazon. Piuttosto che competere esclusivamente nell’affollato livello dei modelli, sostiene che AWS sta capitalizzando la sua posizione dominante nell’infrastruttura cloud sottostante.

Concentrandosi su”dove vengono eseguiti i modelli”, Amazon si sta effettivamente posizionando come fornitore di servizi essenziali per l’economia dell’intelligenza artificiale, sfruttando la propria esperienza logistica per acquisire valore indipendentemente da quale specifico modello di intelligenza artificiale vince il mercato.

Controllando l’intero stack, dal silicio da 3 nm allo strato di orchestrazione degli agenti, AWS scommette di poter forzare il mercato oltre l’attuale”fondo di disillusione”.

Rimangono domande aperte sulla disponibilità delle imprese a cedere il controllo ad agenti autonomi. Werner Vogels, CTO di Amazon, ha affrontato direttamente questa ansia:”L’intelligenza artificiale prenderà il mio lavoro? Forse. Quindi forse dovremmo riformulare e riformulare questa domanda. L’intelligenza artificiale mi renderà obsoleto? Assolutamente no, se mi evolvo.”