In un’importante escalation delle guerre dei dati del web, Cloudflare ha bloccato 416 miliardi di richieste di bot IA da luglio, con una media di quasi 3 miliardi di rifiuti al giorno. I dati, rivelati giovedì dal CEO Matthew Prince, sottolineano la vasta portata di scraping non autorizzati che minacciano l’internet aperta.

Prince ha inquadrato il conflitto non solo come una difesa tecnica ma come una battaglia contro il dominio monopolistico, prendendo di mira esplicitamente Google come il”cattivo”del settore. Sostiene che il colosso della ricerca costringe gli editori a una scelta ingiusta: consentire la formazione sull’intelligenza artificiale o scomparire completamente dai risultati di ricerca.

Questa rivelazione fa seguito al lancio aggressivo di strumenti anti-scraping da parte di Cloudflare all’inizio di quest’anno, incluso il suo sistema”Pay Per Crawl”e le ingannevoli trappole”AI Labyrinth”.

Un’incredibile scala di difesa dei dati

Tra il 1° luglio e il 4 dicembre 2025, la rete di Cloudflare ha intercettato e bloccato un totale di 416 miliardi di richieste da parte di bot IA che tentavano di raschiare contenuti senza autorizzazione. Questo volume rappresenta un forte aumento nella raccolta automatizzata dei dati, con una media di circa 2,7 miliardi di tentativi bloccati ogni giorno.

Il significativo aumento dell’attività difensiva è in linea con l’iniziativa”Content Independence Day”dell’azienda, lanciata a luglio. A quel tempo, Cloudflare ha invertito l’impostazione predefinita per tutti i nuovi clienti per bloccare automaticamente gli scraper IA conosciuti, segnalando il passaggio dal monitoraggio passivo alla negazione attiva.

Lungi dall’essere un semplice aggiustamento tecnico, la mossa rappresenta una ristrutturazione fondamentale del modo in cui funziona il web. Prince ha sottolineato la gravità di questa transizione in un’intervista su Wired, sottolineando che”il modello di business di Internet sta per cambiare radicalmente. Non so in cosa cambierà, ma è ciò a cui penso quasi ogni ora di veglia.”

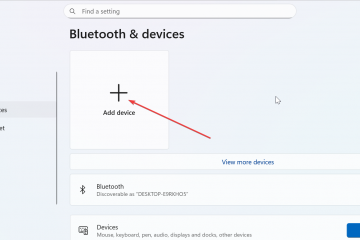

Per far rispettare questi principi blocchi, l’azienda fa affidamento su una suite di strumenti che si sono evoluti rapidamente nel corso dell’ultimo anno. Nel 2024, ha introdotto una funzionalità con un solo clic per bloccare noti scraper di intelligenza artificiale, seguita dal più sofisticato sistema Pay Per Crawl nel luglio 2025. Questi meccanismi mirano a dare agli editori il controllo sui propri dati, consentendo loro di monetizzare l’accesso anziché riceverli liberamente.

Google nominato il”cattivo”del settore

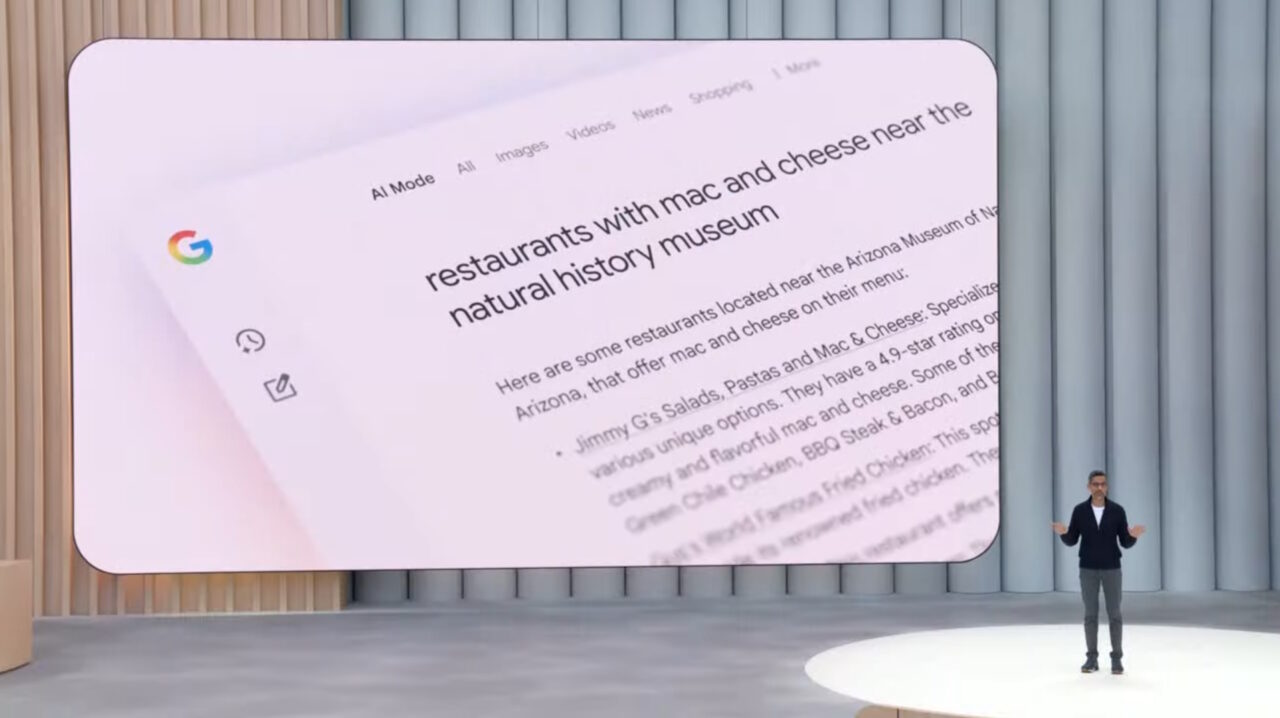

Al centro della disputa c’è una specifica rivendicazione contro la posizione dominante di Google. Prince ha esplicitamente identificato il gigante della ricerca come l’ostacolo principale a un’economia digitale equa, affermando che”è quasi come un film Marvel, l’eroe dell’ultimo film diventa il cattivo di quello successivo. Google è il problema qui. È la società che ci impedisce di andare avanti su Internet.”

Il nocciolo della denuncia è incentrato sul”bundling”, una pratica in cui Google accoppia il suo crawler di ricerca con il suo crawler AI. Ciò costringe effettivamente gli editori ad accettare entrambi o nessuno dei due. Se un sito blocca il crawler per impedire che i suoi contenuti vengano utilizzati per addestrare modelli di intelligenza artificiale, rischia di essere completamente deindicizzato dalla Ricerca Google.

I dati interni di Cloudflare rivelano l’entità di questa leva, quantificando un’enorme disparità nella visibilità del crawler. I dati mostrano che Google attualmente accede a 3,2 volte più pagine web rispetto a OpenAI, il suo concorrente più vicino nello spazio dell’intelligenza artificiale generativa.

Il divario si allarga ulteriormente rispetto ad altri giganti della tecnologia, con Google che vede 4,6 volte più contenuti di Microsoft e 4,8 volte di più rispetto ad Anthropic o Meta. Questa posizione dominante crea un ciclo che si autoalimenta: poiché l’indice di Google è indispensabile per il traffico di ricerca, mantiene l’accesso ai dati di addestramento che ai suoi rivali viene sempre più negato.

Questo vantaggio in termini di visibilità consente a Google di dettare i termini al mercato. Mantenendo un vantaggio così ampio nell’accesso tramite scansione, l’azienda può effettivamente costringere gli editori ad alimentare i suoi modelli di intelligenza artificiale o affrontare l’irrilevanza. Prince ha criticato questa tattica, sostenendo che”non dovrebbe essere possibile utilizzare la posizione di monopolio di ieri per sfruttare e avere una posizione di monopolio nel mercato di domani.”

Sebbene Google offra un meccanismo chiamato”Google-Extended”per rinunciare alla formazione per i suoi modelli Gemini, i critici sostengono che sia insufficiente. Il controllo non disaccoppia completamente l’indicizzazione della ricerca dalle panoramiche dell’intelligenza artificiale che appaiono sempre più in cima ai risultati di ricerca, spesso sostituendo la necessità per gli utenti di fare clic per raggiungere la fonte originale.

Ad aggravare il problema per gli editori è la natura”tutto o niente”della scelta. Abbandonare l’ecosistema dell’intelligenza artificiale spesso significa sacrificare la visibilità che sostiene la propria attività, una situazione che Prince ha descritto come insostenibile, sottolineando che”non è possibile rinunciare a uno senza rinunciare a entrambi, il che è una vera sfida, è pazzesco.”

La corsa agli armamenti tecnici: robot e labirinti invisibili

Man mano che le misure difensive si sono rafforzate, i raschiatori si sono evoluti per diventare più evasivi. Il conflitto si è intensificato in modo significativo nell’agosto 2025, quando Cloudflare ha accusato Perplexity di utilizzare crawler invisibili per aggirare i blocchi standard.

Questi sofisticati bot sono stati osservati mentre effettuavano spoofing di agenti utente legittimi, spesso imitando i browser Chrome in esecuzione su macOS per confondersi con il traffico umano. Ruotando gli indirizzi IP e camuffando la propria identità, hanno tentato di aggirare le stesse protezioni che Cloudflare aveva messo in atto.

Perplexity all’epoca negò fermamente le accuse. Nella confutazione di Perplexity, la società ha sostenuto che i sistemi di rilevamento di Cloudflare erano difettosi, affermando che”questa controversia rivela che i sistemi di Cloudflare sono fondamentalmente inadeguati a distinguere tra assistenti IA legittimi e minacce reali.”

Per contrastare queste tattiche di evasione avanzate, Cloudflare ha implementato contromisure ingannevoli. Nel marzo 2025, l’azienda ha lanciato AI Labyrinth, uno strumento progettato per intrappolare bot non autorizzati in labirinti di contenuti falsi generati automaticamente.

La strategia dietro il labirinto è economica piuttosto che puramente tecnica. Costringendo i bot a sprecare cicli di calcolo navigando in infinite pagine di sciocchezze, Cloudflare mira ad aumentare il costo dello scraping fino al punto in cui diventa insostenibile. Questo approccio ha lo scopo di spingere le aziende di intelligenza artificiale a negoziare accordi di accesso legittimi piuttosto che a impossessarsi dei dati con la forza.

Il dilemma dell’editore: il collasso del traffico

Per gli editori, la posta in gioco di questa guerra tecnica è esistenziale. Il tradizionale scambio di valore, contenuto per traffico, è crollato poiché i motori di ricerca AI riassumono le risposte direttamente nella pagina dei risultati.

I dati della metà del 2025 illustrano la gravità del collasso del traffico. I rapporti di riferimento sono crollati, con OpenAI che invia solo un visitatore ogni 1.500 pagine raschiate. La situazione con Anthropic è ancora più pronunciata, con un rapporto di un solo visitatore ogni 60.000 pagine visitate.

I leader del settore hanno espresso una crescente frustrazione nei confronti di questa dinamica. Danielle Coffey, CEO di News/Media Alliance, ha descritto la situazione come un furto, sostenendo che”i link erano l’ultima qualità di ricerca che dava agli editori traffico e entrate. Ora Google prende i contenuti con la forza e li usa senza alcun ritorno.”

In risposta, Cloudflare ha tentato di creare nuovi modelli di entrate. La sua iniziativa”Pay Per Crawl”mira a far rivivere il codice di stato HTTP 402 da tempo inattivo, abilitando tecnicamente un sistema in cui gli editori possono addebitare alle società di intelligenza artificiale l’accesso ai loro contenuti.

Tuttavia, il successo di tali modelli dipende dalla cooperazione dei maggiori attori. Prince sostiene che, a meno che la pressione normativa o un’azione collettiva non costringa Google a separare le sue funzioni di ricerca e intelligenza artificiale, il settore rimarrà in una situazione di stallo.

Ha concluso con un avvertimento sulla difficoltà di proteggere i contenuti nell’ambiente attuale, affermando che”fino a quando non li forzeremo, o, si spera, li convinceremo, che dovrebbero giocare secondo le stesse regole di tutti gli altri e dividere i loro crawler tra ricerca e intelligenza artificiale, penso che avremo difficoltà a bloccare completamente tutti i contenuti.”