Nel mezzo di una rivolta globale da parte degli editori che devono far fronte a catastrofiche perdite di traffico, Microsoft e Google stanno tentando di riscrivere la narrativa della crisi della ricerca basata sull’intelligenza artificiale. Nuovi dati rilasciati da Microsoft giovedì affermano che mentre la ricerca basata sull’intelligenza artificiale genera meno clic, questi referral si convertono a una velocità tre volte superiore a quella del traffico tradizionale, un chiaro perno verso una difesa della”qualità rispetto alla quantità”.

Tali affermazioni mettono direttamente in discussione studi indipendenti e testimonianze di editori, che descrivono il passaggio ai”motori di risposta”a zero clic non come un guadagno di efficienza, ma come una minaccia esistenziale al Web aperto supportato dalla pubblicità.

La controffensiva della piattaforma: Ridefinire il valore

Il team Bing di Microsoft ha pubblicato giovedì nuovi dati sostenendo che la narrativa del”collasso del traffico”non coglie il punto, sostenendo che i referral guidati dall’intelligenza artificiale si convertono a tassi significativamente più alti rispetto alla ricerca tradizionale.

Secondo Microsoft, i referral AI ora vengono convertiti fino a 3 volte la velocità della ricerca standard traffico, con piattaforme specifiche come Copilot che mostrano un aumento di 17 volte rispetto al traffico diretto.

“Gli ultimi dati della piattaforma Microsoft Clarity confermano questo modello. Analizzando il traffico su 1.200 editori e siti di notizie, Clarity riferisce che i referral guidati dall’intelligenza artificiale sono cresciuti del 155% in otto mesi e hanno registrato una conversione fino a tre volte superiore rispetto ai canali tradizionali come ricerca e social.”

“Anche se i referral basati sull’intelligenza artificiale rappresentano ancora meno dell’1% del totale visite, questi utenti mostrano costantemente intenzioni e coinvolgimento più elevati, registrandosi, abbonandosi o acquistando a tariffe molto maggiori.”

Al centro di questa difesa c’è un disaccordo fondamentale su ciò che costituisce valore sul web. Fabrice Canel, Principal Product Manager di Bing, definisce questo come un cambiamento di”valuta”, sostenendo che la visibilità nei riepiloghi AI crea preferenze prima ancora che si verifichi un clic.

Suggerisce che”per gli esperti di marketing, la visibilità stessa sta diventando una forma di valuta. Se stai modellando le preferenze prima che avvenga un clic.”

Piuttosto che misurare il successo in base alle visualizzazioni di pagina, Microsoft sostiene che gli editori devono concentrarsi sull’allineamento. Canel sostiene che l’obiettivo è”allinearsi con l’intento dell’utente e offrire chiarezza, credibilità e valore in ogni fase della scoperta, in modo che quando qualcuno è pronto ad agire, il tuo marchio o i tuoi contenuti diventino la scelta naturale.”

Rispecchiando la recente strategia di pubbliche relazioni di Google, questa difesa della”qualità rispetto alla quantità”tenta di spostare il KPI del settore.

Ad agosto, il responsabile della ricerca di Google Liz Reid ha sostenuto che, sebbene il volume delle query potrebbe cambiare, i clic risultanti hanno”un valore maggiore”. Ha affermato che”una risposta dell’intelligenza artificiale potrebbe fornire la conformazione del terreno, ma le persone fanno clic per approfondire e saperne di più e, quando lo fanno, questi clic hanno più valore.”

In effetti, le piattaforme stanno tentando di ridefinire le metriche del Web aperto, spostandosi dalle”visualizzazioni di pagina”(che supportano le entrate pubblicitarie) alle”conversioni”(che supportano le transazioni).

Il conflitto dei dati: studi indipendenti vs. piattaforma PR

Mentre i dati interni di Microsoft dipingono un quadro di traffico ad alta efficienza, una ricerca indipendente racconta una storia diversa. Uno studio pubblicato a settembre dall’agenzia digitale Amsive ha rilevato una differenza trascurabile nei tassi di conversione tra AI e ricerca organica.

“Quando si osservano le medie su tutti i siti, il traffico organico si è convertito al 4,60% mentre LLM i referral sono stati convertiti al 4,87%. A prima vista, ciò suggerisce un modesto vantaggio per il traffico LLM è stato il risultato più coerente e indiscutibile tratto dai dati.”

Tali discrepanze suggeriscono che l’argomento della”qualità”può fare molto affidamento su query transazionali specifiche, ignorando le ricerche informative più ampie che indirizzano la maggior parte del traffico web.

Ad aggravare lo scetticismo del settore è il forte contrasto tra le affermazioni della piattaforma e il monitoraggio di terze parti. Uno studio di Pew Research pubblicato a luglio ha confermato che quando viene visualizzata una panoramica AI, i clic sui collegamenti esterni scendono dal 15% a solo l’8%.

“Un sorprendente 53% dei siti web collegati dalla panoramica AI di Google non è apparso nei primi 10 risultati di una ricerca convenzionale. Ciò indica una significativa divergenza dai segnali di posizionamento stabiliti dalla ricerca tradizionale.”

“Citando molte meno fonti rispetto alle sue controparti, GPT-4o di OpenAI si è affidato a uno strumento di ricerca su una media di appena 0,4 pagine web per query, basandosi fortemente sulla sua conoscenza interna e pre-addestrata.”

A sostegno dell’opinione dell’editore secondo cui i motori di ricerca IA non si limitano a filtrare il traffico, ma lo sequestrano attivamente, questi risultati dipingono un quadro cupo. Evidenziando ulteriormente il rischio, lo studio sull’affidabilità della ricerca AI rileva che questi sistemi spesso si basano su un insieme ristretto di fonti, riducendo la diversità del web aperto.

La realtà degli editori: il volume è sopravvivenza

Per le società di media, il passaggio dal volume alla conversione non è un semplice compromesso; è un collasso del modello di business. Editori come People Inc. hanno segnalato cali di traffico fino al 65% negli ultimi anni. Neil Vogel, CEO di People Inc., è stato schietto nella sua valutazione dei motori di ricerca basati sull’intelligenza artificiale, affermando che”lo sanno e non stanno dividendo il loro crawler. Quindi sono intenzionalmente cattivi attori.”

Per il giornalismo supportato dalla pubblicità, la realtà economica è che alti tassi di conversione su <1% del traffico non possono sostituire le entrate perse a causa di un massiccio calo delle visualizzazioni di pagina. Danielle Coffey, CEO della News/Media Alliance, ha riassunto la disperazione del settore, sottolineando che"i link erano l'ultima qualità di ricerca che dava agli editori traffico e entrate. Ora Google prende i contenuti con la forza e li usa senza alcun ritorno."

Il conflitto, che si trasforma in battaglie legali e normative in tutto il mondo, vede una nuova indagine antitrust che prende di mira le pratiche di classificazione delle notizie di Google in Europa, mentre il gruppo mediatico tedesco Corint Media chiede 1,3 miliardi di euro all’anno per i contenuti basati sull’intelligenza artificiale. utilizzo.

Lungi dall’essere un semplice miglioramento dell’efficienza, questo cambiamento rappresenta una rottura fondamentale nello scambio di valore del web. Anche il team legale di Google sembra riconoscere la gravità della situazione.

In una dichiarazione del tribunale del 5 settembre in difesa contro la rottura della sua attività pubblicitaria, la società ha ammesso che”il fatto è che oggi il web aperto è già in rapido declino e la proposta di cessione dei querelanti non farebbe altro che accelerare tale declino…”

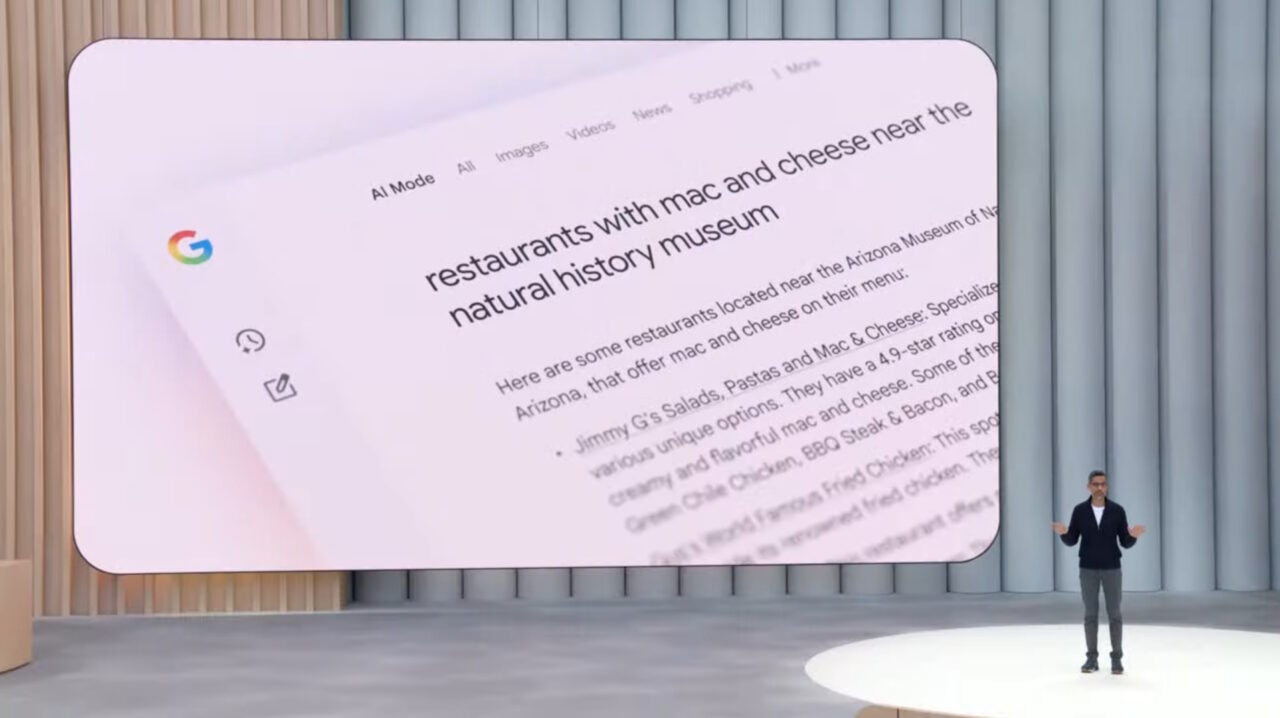

Mentre Google integra Gemini 3 nella Ricerca per creare esperienze completamente”Agentic”in grado di eseguire attività senza lasciare la pagina dei risultati, la pressione su gli editori probabilmente si intensificheranno. Intrappolato tra le promesse della piattaforma di traffico di”qualità superiore”e la dura realtà di un pubblico in diminuzione, il settore si trova ad affrontare un futuro incerto.