L’Allen Institute for AI (AI2) ha lanciato OLMo 3, una nuova famiglia di modelli linguistici che sfida la definizione prevalente di”open source”nell’intelligenza artificiale.

Allontanandosi dallo standard di settore che prevede il semplice rilascio di pesi di modello congelati, AI2 sta pubblicando l’intero”flusso del modello”, un ecosistema completo comprendente set di dati, codice di addestramento e punti di controllo intermedi.

Ridefinire l’open source: il”flusso del modello”Paradigma

La maggior parte dei modelli “aperti” oggi sono effettivamente scatole nere con maniglie pubbliche; gli sviluppatori possono usarli ma non possono verificare come sono stati costruiti.

AI2 cerca di invertire questa tendenza rilasciando Dolma 3, un enorme set di dati di pre-addestramento, insieme a Dolci, un corpus specializzato per la messa a punto delle istruzioni post-formazione.

Fornendo l’accesso ai punti di controllo di ogni fase di sviluppo, Pre-formazione, Formazione intermedia e Post-formazione, l’istituto consente ai ricercatori di intervenire in punti specifici.

Invece di mettere a punto un prodotto finito, gli ingegneri possono biforcare il modello durante la fase di”Midtraining”per inserire competenze specifiche del dominio.

Democratizzare il”Sistema 2″Ragionamento

Al centro di questa versione c’è OLMo 3-Think (32B), un modello progettato per replicare le capacità di ragionamento della”catena di pensiero”rese popolari da sistemi proprietari come o1 di OpenAI. A differenza delle alternative chiuse che nascondono la logica dietro le chiamate API, OLMo 3-Think espone i suoi passaggi di ragionamento intermedi.

Gli utenti possono osservare esattamente come il modello decostruisce complessi problemi matematici o di codifica. Come osservato nel rapporto tecnico,”Olmo 3-Think (32B)… consente di ispezionare le tracce di ragionamento intermedio e di ricondurre tali comportamenti ai dati e alle decisioni di formazione che li hanno prodotti.”

I benchmark suggeriscono che questa trasparenza non va a scapito della capacità. La variante 32B compete direttamente con Qwen 3 e DeepSeek R1, riducendo il divario prestazionale tra i modelli di ragionamento completamente aperti e quelli a peso aperto.

È disponibile anche una variante 7B, che porta queste funzionalità del”Sistema 2″sull’hardware di livello consumer per una sperimentazione più ampia.

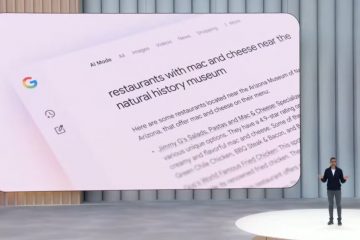

[contenuto incorporato]

Prestazioni di riferimento: colmare il divario con i modelli chiusi

Il rilascio di OLMo 3 segna un cambiamento significativo nel panorama delle prestazioni per i modelli completamente aperti, in particolare se confrontati con concorrenti”a pesi aperti”che mantengono proprietari i propri dati di allenamento. Nelle valutazioni standard del settore, le varianti 32B dimostrano capacità che spesso competono o superano i modelli con un numero di parametri significativamente maggiore.

Nelle attività di codifica fondamentali, OLMo 3-Base (32B) offre risultati straordinari. Nel benchmark HumanEval, ha ottenuto un punteggio del 66,5%, sovraperformando Meta’s Llama 3.1 70B (57,4%) e superando Qwen 2.5 32B (65,6%).

Questa efficienza suggerisce che la fase di”Midtraining”curata del modello, che si concentra fortemente su codice e matematica, è riuscita a superare con successo la sua classe di peso, consentendo a un modello 32B di gestire attività di programmazione tipicamente riservate a Sistemi con oltre 70 miliardi di parametri.

Le capacità di ragionamento”Sistema 2″delle varianti OLMo 3-Think sono ugualmente competitive, in particolare nella matematica e nella logica complesse:

Matematica avanzata: sull’impegnativo benchmark MATH, OLMo 3-Think (32B) ha ottenuto un punteggio del 96,1%, superando sia Qwen 3 32B (95,4%) che DeepSeek R1 Distill 32B. (92,6%). Ragionamento sulla codifica: nella valutazione HumanEvalPlus, che verifica la solida generazione di codice, il modello ha ottenuto un punteggio del 91,4%, ancora una volta leader rispetto a modelli comparabili a peso aperto. Istruzioni seguenti: Il modello ha inoltre conquistato il primo posto nel benchmark IFEval con un punteggio dell’89,0%, indicando un elevato grado di affidabilità nel rispetto dei complessi vincoli dell’utente.

Questi risultati confermano l’ipotesi di AI2 secondo cui la trasparenza non richiede un compromesso sulla qualità. Raggiungendo la parità con i principali modelli a peso aperto come Qwen 3 e Llama 3.1, OLMo 3 dimostra che un”flusso di modello”completamente verificabile può supportare prestazioni all’avanguardia in domini di alto valore come il ragionamento quantitativo e lo sviluppo di software.

Efficienza ingegneristica e Sweet Spot 32B

AI2 ha posizionato la dimensione del parametro 32B come punto di equilibrio ottimale, offrendo capacità di ricerca ad alte prestazioni che rimangono distribuibili su cluster hardware accessibili. Il raggiungimento di questo obiettivo ha richiesto significative ottimizzazioni dell’architettura all’interno del repository GitHub per OLMo-core.

I miglioramenti tecnici hanno prodotto notevoli accelerazioni nel throughput della formazione.

Anche l’efficienza post-formazione ha registrato un notevole incremento. Migrando i processi Supervised Fine-Tuning (SFT) direttamente nel framework principale, il team ha aumentato la produttività di 8 volte rispetto alle iterazioni precedenti.

Ali Farhadi, CEO dell’Allen Institute for AI, ha sottolineato che”le prestazioni elevate non devono necessariamente avere costi elevati… un’intelligenza artificiale responsabile e sostenibile può crescere senza compromessi.”

Privacy, licenze e ecosistema più ampio

Tutti gli elementi nella raccolta Hugging Face sono rilasciati sotto la licenza permissiva Apache 2.0. Tali termini consentono l’uso commerciale, la modifica e l’implementazione illimitati, in contrasto con le restrittive”licenze comunitarie”spesso utilizzate dai principali laboratori tecnologici.

La trasparenza si estende alla catena di fornitura dei dati. Con il rilascio di Dolma 3, AI2 affronta il crescente controllo relativo al copyright e alla provenienza dei dati. Esponendo l’intera pipeline, l’istituto mira a spostare lo standard del settore dal”fidati di noi”al”verifica tu stesso”, consentendo un livello di verificabilità scientifica che è attualmente raro nel settore dell’intelligenza artificiale generativa.