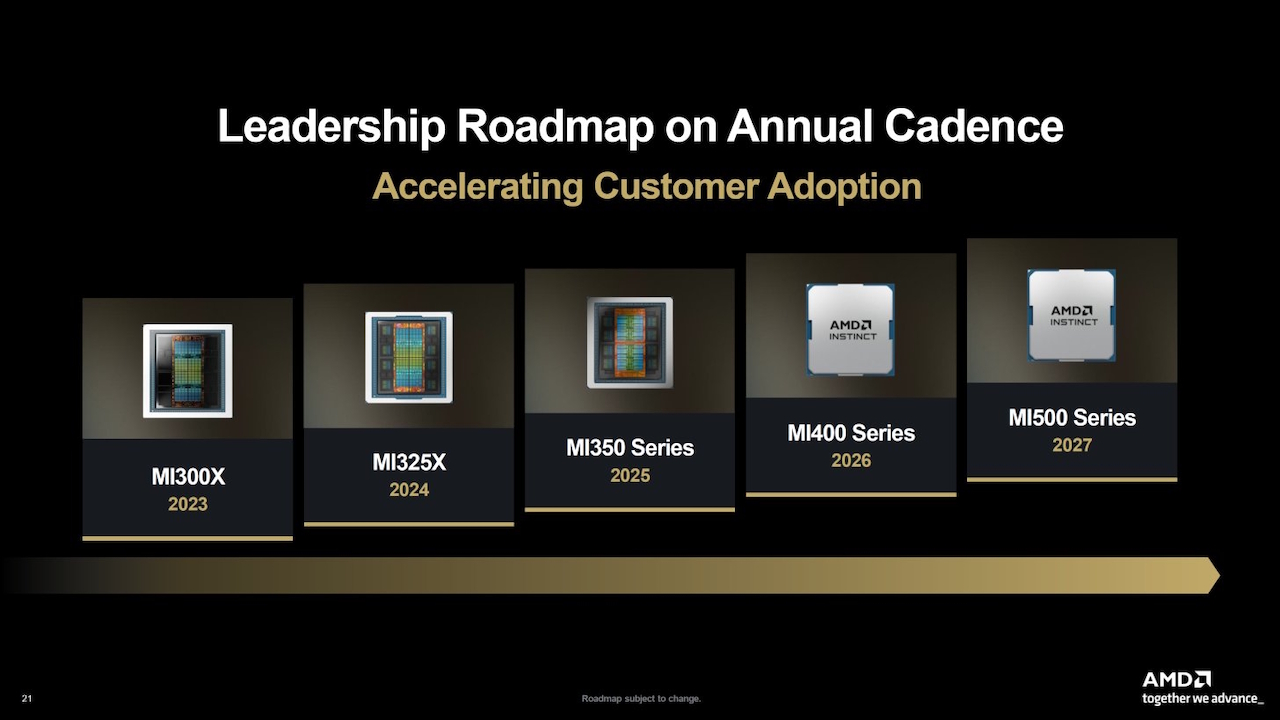

Nella battaglia per il dominio del computing ad alte prestazioni, AMD ha presentato ufficialmente il suo acceleratore Instinct MI430X, un sistema da 432 GB progettato per ancorare la prossima generazione di supercomputer occidentali.

Rivelato questa settimana, il nuovo chip sfrutta l’enorme larghezza di banda della memoria HBM4 per prendere di mira l’infrastruttura”AI sovrana”, garantendo implementazioni chiave negli Stati Uniti e in Europa. Dando priorità ai sistemi exascale sostenuti dal governo rispetto alle vendite aziendali generali, AMD sta aprendo un fronte strategico contro il leader di mercato Nvidia, la cui stessa tabella di marcia si trova ad affrontare ostacoli geopolitici in Cina.

Il settore sta correndo per rompere la morsa di Nvidia, con Microsoft che sviluppa strumenti per colmare il divario del software CUDA. L’ultima mossa di AMD formalizza la sua risposta hardware a questa sfida, offrendo un’alternativa architettonica distinta per le nazioni che cercano di controllare il proprio destino dell’IA.

HBM4 e la larghezza di banda di 19,6 TB/s Leap

AMD ha presentato ufficialmente questa settimana l’Instinct MI430X, posizionandolo come il fiore all’occhiello della sua prossima serie MI400. Al centro della nuova architettura c’è l’integrazione della memoria HBM4, che aumenta la capacità fino a ben 432 GB per acceleratore.

A guidare questo enorme balzo in avanti nel throughput è un’esplosione generazionale nella larghezza di banda della memoria, che raggiunge i 19,6 TB/s. Tale cifra rappresenta un aumento di oltre 3,2 volte rispetto ai 6,0 TB/s dell’attuale MI325X, risolvendo il principale collo di bottiglia per l’addestramento di modelli linguistici di grandi dimensioni.

Mahesh Balasubramanian, Direttore senior del marketing dei prodotti GPU per data center di AMD, ha dichiarato in un post sul blog ufficiale secondo cui il nuovo chip”inaugura una nuova era di prestazioni ed efficienza per l’intelligenza artificiale su larga scala e l’elaborazione ad alte prestazioni (HPC).”

Costruito sull’architettura”Next-Gen CDNA”, ampiamente definita come CDNA 5, il silicio è ottimizzato specificamente per la convergenza dei carichi di lavoro di calcolo ad alte prestazioni (HPC) e IA. A differenza dei chip puramente incentrati sull’intelligenza artificiale che sacrificano la precisione a favore della velocità, l’MI430X mantiene il”vero supporto FP64 basato su hardware, un requisito fondamentale per le simulazioni scientifiche che richiedono un’accuratezza a doppia precisione.

Balasubramanian ha osservato che”costruite sull’architettura AMD CDNA di nuova generazione e supportano 432 GB di memoria HBM4 e 19,6 TB/s di larghezza di banda della memoria, queste GPU offrono straordinarie capacità di elaborazione”, sottolineando il duplice uso natura del progetto.

AMD sta posizionando il dispositivo come un motore unificato per”fabbriche di intelligenza artificiale”, in grado di gestire simultaneamente addestramento, inferenza e modellazione tradizionale senza richiedere cluster separati.

L’efficienza energetica rimane un pilastro centrale del progetto, sebbene i dati specifici del TDP (Thermal Design Power) fossero notevolmente assenti dalla divulgazione. Il passaggio all’HBM4 segnala un picco nella complessità della produzione, che probabilmente richiede tecniche di packaging avanzate per gestire la densità termica degli stack di memoria.

Il perno dell'”intelligenza artificiale sovrana”: proteggere i supercomputer dell’Occidente

Commercializzando il chip sotto lo stendardo dell'”intelligenza artificiale sovrana”, AMD sta esplicitamente prendendo di mira progetti infrastrutturali finanziati dal governo negli Stati Uniti e in Europa. Un approccio così mirato ha già assicurato all’MI430X un posto in”Discovery”, il prossimo supercomputer dell’Oak Ridge National Laboratory (ORNL).

Secondo l’annuncio dell’ORNL, la consegna di Discovery è prevista nel 2028, evidenziando i lunghi tempi di consegna inerenti agli appalti su scala governativa. Balasubramanian ha spiegato che”Discovery consentirà ai ricercatori statunitensi di addestrare, mettere a punto e implementare modelli di intelligenza artificiale su larga scala, facendo avanzare al contempo l’elaborazione scientifica nella ricerca energetica, nella scienza dei materiali e nell’intelligenza artificiale generativa.”

In Europa, il chip alimenterà”Alice Recoque”, il primo sistema francese di classe exascale, costruito in collaborazione con Eviden. Un annuncio di una partnership strategica ha confermato che il sistema utilizzerà la piattaforma BullSequana XH3500, combinando l’MI430X con le CPU EPYC”Venice”di prossima generazione di AMD.

Concentrarsi sui contratti governativi occidentali fornisce un livello minimo di ricavi stabile, che isola AMD dalla volatilità del mercato spot aziendale. Dal punto di vista geopolitico, ciò contrasta nettamente con la situazione in Cina, dove Pechino ha bandito i chip stranieri dai progetti statali, escludendo di fatto AMD e Nvidia da quel mercato sovrano.

Contemporaneamente, il governo degli Stati Uniti ha approvato recenti approvazioni per il Medio Oriente, creando una complessa mappa geopolitica in cui i mercati”sovrani”sono strettamente delineati da alleanze.

La realtà del mercato: il divario temporale e il CUDA Moat

Sebbene le specifiche siano impressionanti, la finestra di lancio del 2026 pone la serie MI400 in rotta di collisione con la futura architettura”Rubin”di Nvidia piuttosto che con l’odierna Blackwell. R

Le date di consegna del supercomputer Discovery sono fissate al 2028, suggerendo un ritardo significativo tra la disponibilità del silicio e l’implementazione operativa su larga scala. Il software rimane l’ostacolo principale, con l’ecosistema CUDA di Nvidia che funge ancora da fossato difensivo del settore.

I rapporti suggeriscono che Microsoft sta sviluppando strumenti di traduzione per colmare questa lacuna, consentendo al codice CUDA di essere eseguito in modo nativo sull’hardware AMD senza riscrittura. Tuttavia, il colosso di Redmond sta anche proteggendo le sue scommesse concedendo in licenza l’IP personalizzato del silicio di OpenAI, segnalando che non farà affidamento esclusivamente su AMD per rompere la presa di Nvidia.

I mercati del silicio dei commercianti vengono anche schiacciati da Google, che recentemente ha reso il suo Ironwood TPU generalmente disponibile per i clienti cloud.

A complicare il panorama competitivo è l’ascesa di attori non tradizionali. Il CEO di Nvidia Jensen Huang ha avvertito che”è sciocco sottovalutare la potenza della Cina e l’incredibile spirito competitivo di Huawei. Questa è un’azienda con una tecnologia straordinaria”, riconoscendo che il mercato si sta fratturando in feudi regionali.

Per i clienti aziendali, la scelta tra l’ecosistema aperto di AMD e lo stack integrato di Nvidia spesso si riduce alla”flessibilità dell’infrastruttura”rispetto alla facilità d’uso immediata. Con l’MI430X, AMD scommette che la larghezza di banda grezza e la convalida governativa saranno sufficienti per far pendere l’ago della bilancia.