Appena un mese dopo aver presentato Copilot Actions come il fulcro della sua strategia”PC AI”, Microsoft ha rilasciato un’ammissione allarmante secondo cui la tecnologia introduce”nuovi rischi per la sicurezza”in grado di compromettere interi sistemi.

In un aggiornamento silenzioso alla documentazione di supporto che accompagna il lancio di Insider, la società ha avvertito che gli aggressori possono sfruttare questi agenti tramite Cross-Prompt Injection (XPIA) per esfiltrare dati o installare malware. La divulgazione sposta di fatto la responsabilità sugli utenti, suscitando critiche immediate da parte dei ricercatori di sicurezza che confrontano la vulnerabilità con le macro di Office non protette.

Dopo il nostro articolo sulle prime azioni Copilot annunciate in ottobre, in cui Microsoft aveva promesso uno”sblocco magico”senza soluzione di continuità per la produttività, la realtà dell’implementazione si è rivelata molto più complessa.

Mentre l’azienda continua a commercializzare il”PC AI”come partner sicuro, la documentazione appena aggiornata rivela avvertenze significative che erano assenti nel blitz di marketing iniziale.

Una silenziosa ammissione di”nuovi rischi per la sicurezza”

Nella documentazione di supporto aggiornata che accompagna l’implementazione del 17 novembre a Windows Insider c’è un avvertimento che altera radicalmente il profilo di rischio dell’utilizzo di agentic AI.

Microsoft ha riconosciuto esplicitamente che”le applicazioni AI dell’agente introducono nuovi rischi per la sicurezza, come il cross-prompt injection (XPIA), in cui contenuti dannosi incorporati in elementi o documenti dell’interfaccia utente possono sovrascrivere le istruzioni dell’agente, portando ad azioni indesiderate come l’esfiltrazione di dati o l’installazione di malware.”

Questa vulnerabilità, nota come Cross-Prompt Injection (XPIA), consente agli aggressori di nascondere istruzioni dannose in siti Web, documenti o e-mail elaborati dall’agente AI. Poiché l’agente è progettato per agire per conto dell’utente, può essere indotto con l’inganno a eseguire comandi che l’utente non ha mai autorizzato.

Oltre alla minaccia di manipolazione esterna, la documentazione ammette anche che i modelli stessi rimangono soggetti a errori.

Microsoft osserva che”i modelli di intelligenza artificiale devono ancora affrontare limitazioni funzionali in termini di come si comportano e occasionalmente possono avere allucinazioni e produrre risultati inaspettati”. Queste”limitazioni funzionali”significano che anche senza interferenze dannose, l’agente potrebbe interpretare erroneamente un comando o avere allucinazioni su un’attività, potenzialmente eliminando file o inviando e-mail in modo errato.

Fondamentalmente, Microsoft ha inquadrato questi rischi come responsabilità dell’utente. Consigliando ai clienti di procedere con cautela, la pagina di supporto suggerisce di abilitare la funzione solo”se si comprendono le implicazioni sulla sicurezza delineate in questa pagina.”

Attribuendo all’utente l’onere di”comprendere”vettori di attacco complessi come XPIA, la società sembra proteggersi preventivamente dalla responsabilità nel caso in cui queste funzionalità sperimentali portino a violazioni dei dati o compromissioni del sistema.

‘Macro su Marvel Superhero Crack’

Facendo eco agli incubi sulla sicurezza che affliggevano le versioni precedenti di Office, gli esperti si sono affrettati a criticare il modello di difesa”opt-in”.

Per decenni, le macro di Office sono state il vettore principale di infezioni da malware perché gli utenti, guidati da esigenze di produttività, le abilitavano nonostante gli avvisi di sicurezza.

Kevin Beaumont, un importante ricercatore di sicurezza, ha tracciato un parallelo diretto con questa storia, affermando che la nuova funzionalità è”macro sul crack dei supereroi Marvel”.

I critici sostengono che il”controllo”promesso da Microsoft è in gran parte illusorio per l’utente medio. Rilevare un attacco XPIA in tempo reale è tecnicamente impossibile per la maggior parte delle persone, poiché il messaggio dannoso è spesso invisibile all’occhio umano ma perfettamente leggibile dall’intelligenza artificiale.

Guillaume Rossolini, un altro ricercatore di sicurezza, ha sottolineato l’inutilità di chiedere agli utenti di monitorare queste interazioni, notando“Non vedo come gli utenti riusciranno a impedire qualcosa del genere a cui si riferiscono, a parte non navigare sul web, immagino.”

Reed Mideke ha definito l’avvertimento poco più che una manovra legale. Ha sostenuto che l’industria non dispone di una soluzione tecnica per l’iniezione tempestiva.”La soluzione? Trasferire la responsabilità all’utente,”ha scritto Mideke, notando,”non importa che non avresti bisogno del chatbot se conoscessi la risposta.”

Questo scetticismo riflette una preoccupazione più ampia nella comunità della sicurezza riguardo alle caratteristiche dell'”agentic”vengono immessi sul mercato prima che le vulnerabilità fondamentali dei Large Language Models (LLM) siano state risolte.

Architettura e implementazione: la realtà dell'”Agent Workspace”

Nonostante la fanfara che circonda la rivelazione iniziale di”AI PC”, l’implementazione tecnica di questi agenti è particolarmente cauta. Secondo il blog degli sviluppatori di Ignite 2025, il nuovo”Agent Workspace”funziona come una sessione parallela di Windows con autorizzazione mirata anziché come una sessione completa macchina virtuale o sandbox isolata.

Bilanciando prestazioni e sicurezza, questa scelta architetturale si ferma al di sotto del rigoroso isolamento che alcuni esperti avevano sperato.

Per mitigare i rischi appena divulgati, Microsoft ha limitato l’accesso al file system dell’agente a sei cartelle specifiche del profilo utente: Documenti, Download, Desktop, Musica, Immagini e Video. Progettata per impedire agli agenti compromessi di accedere ai file di sistema critici, questa limitazione mira a contenere potenziali danni all’interno delle aree accessibili all’utente.

Navjot Virk, vicepresidente aziendale di Windows Experiences di Microsoft, ha tentato di gestire le aspettative durante l’annuncio iniziale, avvertendo che”all’inizio potresti vedere l’agente commettere degli errori o incontrare alcune sfide quando si tenta di utilizzare alcune applicazioni veramente complesse.”

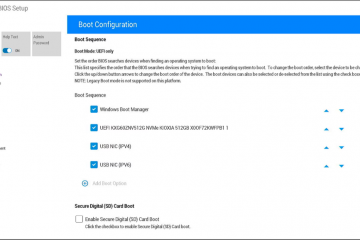

Attualmente, la funzionalità è implementazione su Windows Insider nel Dev Channel, rimanendo disattivato per impostazione predefinita e richiedendo i privilegi di amministratore per attivare/disattivare. Suggerendo una profonda consapevolezza delle potenziali reazioni negative, questa strategia di lancio mira probabilmente a evitare il ripetersi del disastro che circonda la controversa funzione Recall, che è stata ritirata dopo che i ricercatori hanno scoperto gravi difetti di privacy.