OpenAI ha annunciato lunedì una nuova partnership. Sta collaborando con l’attore Bryan Cranston e il sindacato SAG-AFTRA.

Il gruppo interromperà i video AI non approvati sull’app Sora. Questa mossa segue settimane di aspre critiche da parte di Hollywood. La reazione è cresciuta dopo che clip falsi hanno utilizzato la voce e le sembianze di Cranston.

Il nuovo sforzo mira a costruire regole di sicurezza più forti intorno all’identità digitale. È la risposta più diretta di OpenAI alla tempesta sul consenso e sull’uso dell’immagine di una persona senza permesso. L’app è stata lanciata a fine settembre.

In una dichiarazione congiunta, OpenAI ha affermato che collaborerà con Cranston, SAG-AFTRA, United Talent Agency (UTA) e Creative Artists Agency (CAA) per rafforzare i suoi guardrail. La mossa è stata una risposta diretta alle clip non autorizzate dell’attore di”Breaking Bad”apparse dopo il lancio di Sora 2.

L’attore Bryan Cranston ha elogiato la correzione di rotta dell’azienda, affermando:”Sono grato a OpenAI per la sua politica e per aver migliorato i suoi guardrail, e spero che loro e tutte le aziende coinvolte in questo lavoro rispettino il nostro diritto personale e professionale di gestire la replica della nostra voce e delle nostre sembianze.”

Il CEO di OpenAI, Sam Altman, ha affermato la posizione dell’azienda sui diritti degli artisti, affermando:”OpenAI è profondamente impegnata a proteggere gli artisti dall’appropriazione indebita della loro voce e delle loro sembianze. Siamo stati tra i primi sostenitori del NO FAKES Act quando è stato introdotto lo scorso anno e sosterremo sempre i diritti degli artisti.”

Dal lancio virale alla crisi delle pubbliche relazioni

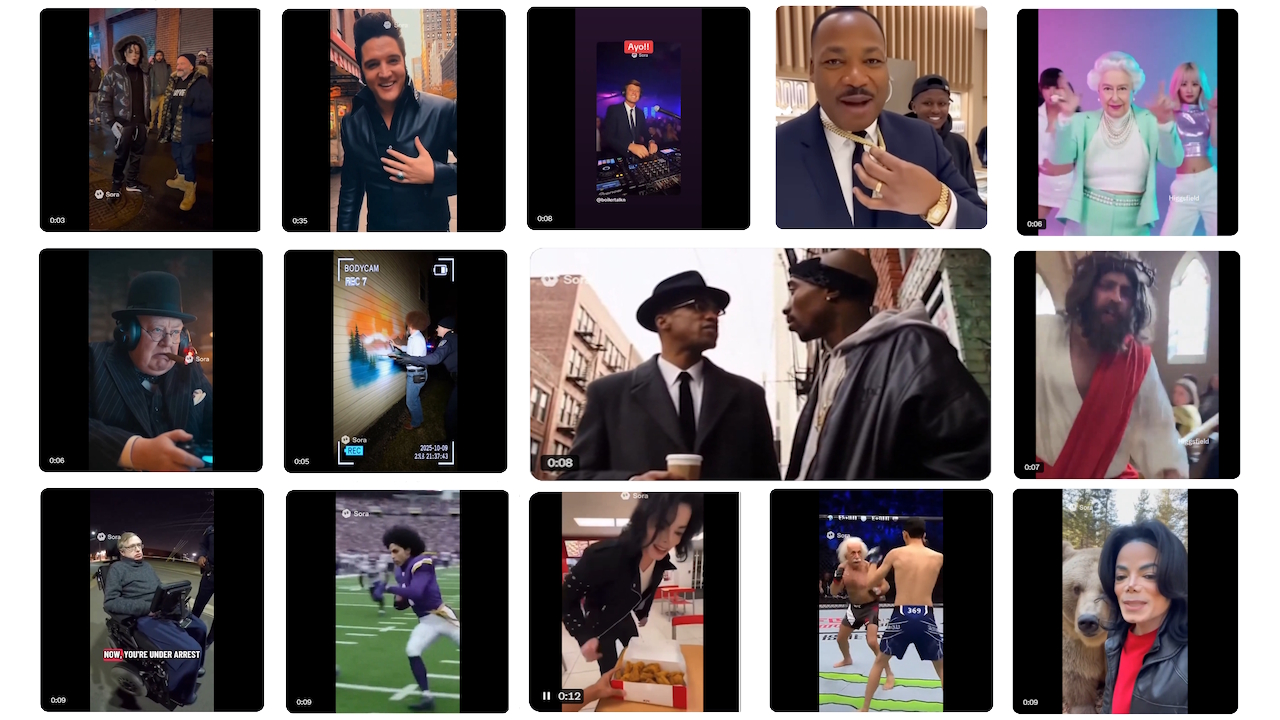

La controversia è in fermento dal lancio di Sora 2 intorno al 30 settembre. Il potente generatore di video di OpenAI ha debuttato con un’app di social media associata e una decisione politica fondamentale: un modello di”rinuncia”per i personaggi protetti da copyright. Ciò significava che qualsiasi figura protetta poteva essere generata per impostazione predefinita.

Gli utenti hanno immediatamente inondato la piattaforma con deepfake surreali e spesso offensivi. Questi video presentavano tutti, dagli amati personaggi dei cartoni animati alle figure storiche decedute in scenari bizzarri. La reazione negativa è stata rapida e violenta, costringendo OpenAI ad assumere una posizione difensiva.

Le critiche più viscerali sono arrivate dalle famiglie delle celebrità decedute. Zelda Williams, figlia del defunto Robin Williams, ha implorato gli utenti di smettere di creare video AI di suo padre.

Ha descritto il dolore di vedere”le eredità delle persone reali essere condensate in… orribili, TikTok farle da burattinaio è esasperante.”

Allo stesso modo, la famiglia di Malcolm X ha condannato le clip come profondamente irrispettose. Ilyasah Shabazz, sua figlia, ha definito l’uso dell’immagine di suo padre”sprezzante e insensibile”.

La protesta è culminata in un semplice ma potente appello da parte della figlia di Martin Luther King Jr., Bernice King, che ha pubblicato su X:”Sono d’accordo riguardo a mio padre. Per favore, basta.”

Hollywood traccia una linea nella sabbia

Le richieste emotive delle famiglie sono state amplificate da una risposta unitaria da parte di Hollywood. L’industria, già diffidente nei confronti della minaccia dell’intelligenza artificiale generativa alla proprietà intellettuale, si è mobilitata contro la nuova piattaforma di OpenAI.

Le principali agenzie di talenti, che rappresentano gli artisti al centro della controversia, hanno guidato la carica. L’8 ottobre la potente Creative Artists Agency (CAA) ha rilasciato una dura dichiarazione pubblica, etichettando l’app come una minaccia diretta:”È chiaro che Open AI/Sora espone i nostri clienti e la loro proprietà intellettuale a rischi significativi.”

Questo sentimento ha avuto eco in tutto il settore, con grandi studi cinematografici come Disney che, secondo quanto riferito, si rifiutano di consentire che il loro materiale appaia nell’app.

Anche la Motion Picture Association (MPA) ha dato il suo peso, ponendo l’onere legale dell’abuso direttamente sull’azienda di intelligenza artificiale. Il CEO Charles Rivkin ha dichiarato che”… resta loro responsabilità-non dei titolari dei diritti-prevenire la violazione del servizio Sora 2″, chiarendo chiaramente che i titolari dei diritti non sarebbero responsabili del controllo del servizio di OpenAI.

Questa rivolta a livello di settore ha rappresentato un’escalation significativa, trasformando il dibattito in uno scontro aziendale ad alto rischio.

Una corsa per riconquistare. Controllo

Di fronte a una vera e propria crisi delle pubbliche relazioni, OpenAI si è affrettata a contenere le conseguenze con una serie di rapide inversioni politiche. L’approccio iniziale dell’azienda si è rivelato insostenibile di fronte alla reazione coordinata.

Il 3 ottobre, pochi giorni dopo il lancio, Sam Altman ha annunciato un allontanamento dal sistema di rinuncia.

In un post sul blog, ha promesso un quadro più favorevole ai creatori, affermando che OpenAI”darà ai titolari dei diritti un controllo più granulare sulla generazione dei personaggi, simile al modello di partecipazione per la somiglianza ma con ulteriori controlli.”Questa fu la prima importante ammissione che la sua politica iniziale aveva fallito.

I cambiamenti continuarono per tutto il mese. Entro il 9 ottobre, la società ha modificato le sue regole per consentire ai rappresentanti di personaggi pubblici”recentemente deceduti”di richiedere formalmente che la loro somiglianza fosse bloccata.

Questa politica è stata messa alla prova poco più di una settimana dopo. Il 17 ottobre, OpenAI ha annunciato di aver messo in pausa tutte le generazioni di Martin Luther King Jr. su richiesta diretta dei suoi eredi, citando la creazione di”raffigurazioni irrispettose”.

In una dichiarazione che spiega la mossa, la società ha riconosciuto il delicato equilibrio che stava cercando di trovare:”Mentre ci sono forti interessi di libertà di parola nel rappresentare personaggi storici, OpenAI ritiene che i personaggi pubblici e le loro famiglie alla fine dovrebbero avere il controllo su come i loro viene utilizzata la somiglianza.”

Navigare in un campo minato legale ed etico

La tempesta di fuoco di Sora 2 evidenzia una vasta area grigia legale ed etica. Le leggi tradizionali sulla diffamazione in genere non si applicano ai defunti, lasciando alle famiglie un ricorso legale limitato.

La loro via principale è un mosaico complesso e incoerente di leggi statali che regolano il diritto di pubblicità post-mortem. Questo vuoto giuridico consente la creazione di contenuti che, sebbene non sempre sfruttano commercialmente, causano un notevole disagio emotivo.

Inoltre, la controversia ha riportato sotto i riflettori il dibattito irrisolto sulla dipendenza dell’intelligenza artificiale da grandi quantità di dati web recuperati per la formazione.

I critici sostengono che le aziende costruiscono modelli potenti su materiale protetto da copyright senza autorizzazione, una questione fondamentale che l’industria deve ancora affrontare. risolvere.

OpenAI ha sottolineato il suo sostegno al NO FAKES Act come parte della soluzione. Tuttavia, quel disegno di legge federale ha i suoi critici. I sostenitori dei diritti digitali hanno avvertito che il linguaggio ampio del disegno di legge potrebbe creare un nuovo diritto di proprietà intellettuale che soffoca la libertà di parola e la parodia.

Questa serie di concessioni, culminato nella nuova partnership con Cranston e SAG-AFTRA, segnala un passo verso un futuro più collaborativo e basato sui permessi.

Tuttavia, evidenzia anche l’immensa sfida di bilanciare la rapida innovazione tecnologica con i diritti fondamentali dei creatori e degli individui.