L’AI Safety Index 2024 appena pubblicato dal Future of Life Institute (FLI) ha rivelato gravi carenze nelle pratiche di sicurezza dell’IA in sei aziende leader, tra cui Meta, OpenAI e Google DeepMind.

L’intelligenza artificiale L’indice di sicurezza ha classificato Anthropic al primo posto con un voto”C”, ma il resto delle società-Meta, OpenAI, Google DeepMind, xAI e Zhipu AI-hanno ricevuto punteggi tristi, con Meta che ha fallito

I risultati sottolineano l’urgente necessità di una governance e di una gestione del rischio più forti in un settore che corre per sviluppare sistemi di intelligenza artificiale sempre più avanzati.

Il presidente della FLI Max Tegmark ha descritto senza mezzi termini la situazione a IEEE Spectrum:”Sento che i leader di queste aziende sono intrappolati in una corsa verso il basso da cui nessuno di loro può uscire, non importa quanto siano di buon cuore.”

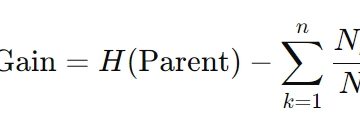

I FLI ha valutato le aziende in sei categorie, tra cui valutazione del rischio, governance e strategie di sicurezza esistenziale. Nonostante l’attenzione del settore sullo sviluppo di sistemi potenti, il rapporto evidenzia un divario significativo tra capacità tecnologiche e misure di sicurezza efficaci.

Anthropic guida il gruppo con una”C”mediocre

Anthropic è emerso come il best performer nell’indice, anche se il suo voto”C”indica che c’è ancora un sostanziale margine di miglioramento. La”politica di scalabilità responsabile”dell’azienda si è distinta come un esempio positivo.

Questa politica richiede che tutti i modelli siano sottoposti a rigorose valutazioni del rischio per identificare e mitigare i danni catastrofici prima dell’implementazione. Inoltre, Anthropic ha costantemente ottenuto ottimi risultati sui risultati consolidati parametri di riferimento in materia di sicurezza, guadagnandosi una”B-“nella categoria relativa alla lotta ai danni attuali, il punteggio più alto in quell’area.

Nonostante le sue prestazioni relativamente elevate, Anthropic è stata anche criticata per la sua mancanza di una strategia globale per gestire i rischi esistenziali, tema condiviso da tutte le aziende valutate.

Fonte: iniziativa FutureOfLife

I revisori hanno notato che sebbene Anthropic, OpenAI e Google DeepMind abbiano articolato approcci iniziali alla sicurezza esistenziale, questi sforzi rimangono preliminari e insufficienti per affrontare la portata della sfida.

Meta ottiene un punteggio di”F”man mano che aumentano le preoccupazioni sulla sicurezza

All’estremità opposta dello spettro, Meta ha ricevuto un voto negativo per la sua governance inadeguata e le sue pratiche di sicurezza. Il rapporto ha identificato importanti lacune nella trasparenza, nei quadri di responsabilità e nelle strategie di sicurezza esistenziale di Meta. L’assenza di misure di sicurezza significative ha sollevato preoccupazioni sulla capacità dell’azienda di gestire i rischi associati ai suoi sviluppi di intelligenza artificiale.

La scarsa performance di Meta. evidenzia una questione più ampia all’interno del settore. Nonostante investimenti significativi nella ricerca sull’intelligenza artificiale, molte aziende non hanno dato priorità alle strutture di governance necessarie per garantire che le loro tecnologie siano sicure e allineate ai valori sociali. Questa mancanza di priorità è esacerbata da un ambiente competitivo che premia rapidamente implementazione rispetto alla cautela.

Trasparenza: un punto debole persistente

La trasparenza è stata un’altra area critica in cui le aziende hanno sottoperformato. Solo xAI e Zhipu AI hanno completato i questionari di sicurezza personalizzati inviati da FLI, ottenendo punteggi leggermente più alti in questa categoria.

Le altre società non hanno fornito approfondimenti dettagliati sulle loro pratiche di sicurezza interne, sottolineando ulteriormente l’opacità che spesso circonda lo sviluppo dell’intelligenza artificiale.

In risposta al rapporto, Google DeepMind ha pubblicato una dichiarazione in difesa del suo approccio, in cui si afferma:”Sebbene l’Indice incorpori alcuni degli sforzi di sicurezza dell’intelligenza artificiale di Google DeepMind e rifletta i parametri di riferimento adottati dal settore, il nostro L’approccio globale alla sicurezza dell’IA va oltre ciò che viene catturato.”

Tuttavia, i revisori non sono rimasti convinti, sottolineando che senza una maggiore trasparenza è impossibile valutare se queste affermazioni si traducono in azioni significative.

Max Tegmark ha sottolineato l’importanza della pressione esterna, notando,”Se un’azienda non sente la pressione esterna per soddisfare i requisiti di sicurezza standard, poi altre persone in azienda ti vedrà semplicemente come un fastidio, qualcuno che sta cercando di rallentare le cose e gettare ghiaia nei macchinari. Ma se questi ricercatori sulla sicurezza si ritrovano improvvisamente responsabili di migliorare la reputazione dell’azienda, otterranno risorse, rispetto e influenza.”

Strategie per il rischio esistenziale: un fallimento comune

Uno dei risultati più preoccupanti dell’Indice è stato il fallimento universale delle aziende nello sviluppare solide strategie di rischio esistenziale, mentre la maggior parte delle aziende aspira pubblicamente a creare sistemi di intelligenza artificiale generale (AGI) capaci di capacità cognitive a livello umano-nessuno l’ha fatto ha ideato piani globali per garantire che questi sistemi rimangano allineati ai valori umani.

Tegmark ha sottolineato la gravità di questo problema, affermando,”La verità è che nessuno sa come controllare una nuova specie molto più intelligente di noi.”

Stuart Russell ha fatto eco a questo sentimento, avviso,”Man mano che questi sistemi diventano più grandi, è possibile che l’attuale direzione tecnologica non possa mai supportare le necessarie garanzie di sicurezza.”

La mancanza di strategie concrete di sicurezza esistenziale è stata particolarmente preoccupante date le crescenti capacità dei sistemi di intelligenza artificiale. I revisori hanno sottolineato che senza quadri chiari, i rischi posti dall’AGI potrebbero aumentare rapidamente.

Storia dell’AI Safety Index

L’AI Safety Index si basa su precedenti Iniziative FLI, compresa la ampiamente discussa”lettera di pausa”del 2023 che richiedeva un interruzione temporanea dello sviluppo di sistemi avanzati di intelligenza artificiale per stabilire robusti protocolli di sicurezza.

La lettera, firmata da oltre 33.700 persone, tra cui nomi di alto profilo come Elon Musk e Steve Wozniak, è stata infine ignorata dalle aziende. L’indice 2024 rappresenta l’ultimo sforzo di FLI per responsabilizzare il settore valutando pubblicamente le aziende in base alle loro pratiche di sicurezza.

Secondo Stuart Russell, professore di informatica alla UC Berkeley e uno dei revisori del rapporto,”I risultati suggeriscono che, sebbene esista un Molte attività delle aziende di intelligenza artificiale che rientrano nella categoria”sicurezza”non sono ancora molto efficaci. Nessuna delle attività attuali fornisce alcun tipo di garanzia quantitativa di sicurezza.”

L’indice mira a promuovere la trasparenza, responsabilizzare i team di sicurezza interni e incoraggiare la supervisione esterna per prevenire rischi potenzialmente catastrofici.

Un appello per una supervisione normativa

Il rapporto FLI si conclude con un appello per quadri normativi più forti per colmare le lacune identificate nell’Indice. Tegmark ha proposto la creazione di un organismo di supervisione simile il cibo degli Stati Uniti e Drug Administration (FDA) per valutare i sistemi di intelligenza artificiale prima che vengano implementati.

Un’agenzia di questo tipo potrebbe imporre standard di sicurezza obbligatori, spostando le pressioni competitive del settore dal dare priorità alla velocità a dare priorità alla sicurezza.

Turing. Il vincitore del premio Yoshua Bengio, un altro membro del panel dell’Index, ha sostenuto questa proposta, affermando:”Valutazioni come questa evidenziano le pratiche di sicurezza e incoraggiano aziende ad adottare approcci più responsabili.”Bengio ha sostenuto che una supervisione indipendente è essenziale per garantire che le aziende non perseguano scorciatoie nel perseguimento del dominio del mercato.

Come è stato compilato l’indice

The 2024 AI Safety Index è stato sviluppato attraverso un meticoloso processo di valutazione guidato da un gruppo di sette esperti indipendenti, tra cui Bengio, Russell e il fondatore di Encode Justice, Sneha Revanur.

Il panel ha valutato le aziende in base a 42 indicatori che abbracciano sei categorie: valutazione del rischio, danni attuali, trasparenza, governance, sicurezza esistenziale e comunicazione.

La metodologia ha combinato dati pubblici, come documenti politici, documenti di ricerca e rapporti di settore, con risposte a un questionario personalizzato. Tuttavia, la partecipazione limitata delle aziende a questo processo ha sottolineato le sfide legate al raggiungimento della trasparenza nel settore.

David Krueger, membro del panel e ricercatore sull’intelligenza artificiale, ha osservato:”È terrificante che proprio le aziende i cui leader prevedono l’intelligenza artificiale possano e l’umanità non ha alcuna strategia per evitare un simile destino.”

Implicazioni per il futuro della governance dell’IA

L’indice di sicurezza dell’intelligenza artificiale del 2024 dipinge un quadro preoccupante dello stato attuale della governance dell’IA. Mentre aziende come Anthropic stanno facendo passi da gigante, i risultati complessivi rivelano una mancanza di preparazione nel gestire i rischi posti dalle tecnologie avanzate di intelligenza artificiale.

Il rapporto richiede un’azione urgente stabilire protocolli di sicurezza e controlli normativi più forti per garantire che lo sviluppo dell’intelligenza artificiale sia in linea con gli interessi della società.

Come ha osservato Tegmark ,”Senza pressioni esterne e standard solidi, la corsa allo sviluppo dell’intelligenza artificiale potrebbe portare a conseguenze catastrofiche.”