AWS ha compiuto un passo significativo nell’infrastruttura AI svelando i suoi chip Trainium2 di seconda generazione e introducendo gli UltraServer Trn2, progettati per ampliare i confini delle prestazioni del Large Language Model (LLM).

Annunciato in occasione della conferenza stampa:Invent, questi sviluppi posizionano AWS come un attore formidabile nel panorama dell’intelligenza artificiale in rapida evoluzione. AWS ha inoltre presentato in anteprima Trainium3, un chip di prossima generazione che promette un aumento delle prestazioni quadruplicato, il cui rilascio è previsto per la fine del 2025.

David Brown, Vice Presidente di Compute and Networking presso AWS, ha descritto l’importanza di queste innovazioni:

“Trainium2 è il chip AWS con le prestazioni più elevate creato fino ad oggi. E con modelli che si avvicinavano a trilioni di parametri, sapevamo che i clienti avrebbero avuto bisogno di un nuovo approccio per addestrare ed eseguire questi enormi modelli. I nuovi Trn2 UltraServer offrono le prestazioni di addestramento e inferenza più veloci su AWS per i modelli più grandi del mondo.”

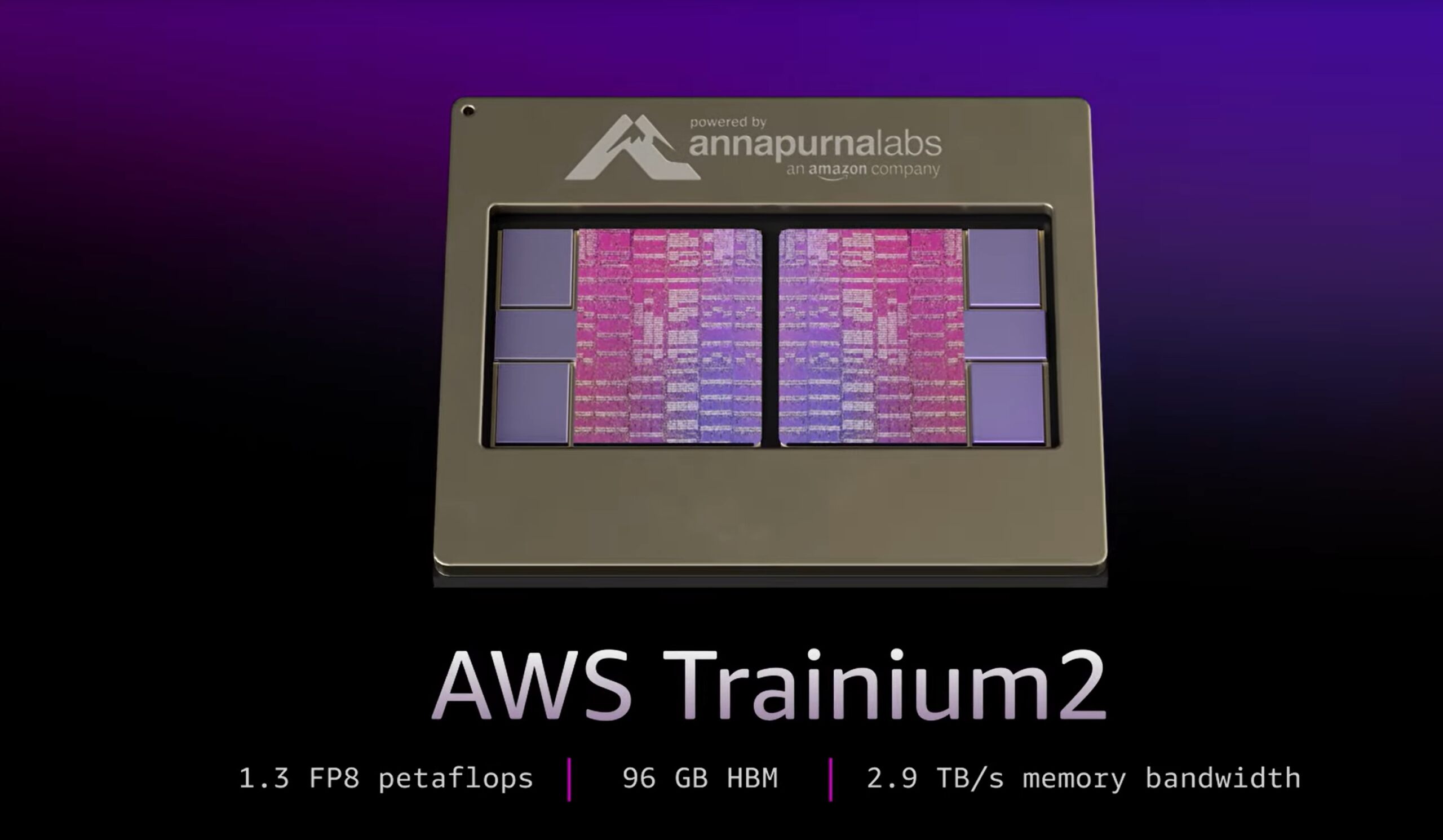

Trainium2: sfruttare una potenza di elaborazione senza precedenti

I chip Trainium2 sono progettati per soddisfare le crescenti esigenze computazionali dei moderni modelli di intelligenza artificiale, offrendo fino a 20,8 petaflop di elaborazione FP8 densa per istanza.

Ogni istanza EC2 Trn2 integra 16 chip Trainium2 collegati tramite NeuronLink proprietario di AWS interconnessione, che garantisce comunicazioni a bassa latenza e larghezza di banda elevata. Questa architettura consente una scalabilità senza soluzione di continuità, fondamentale per la formazione e l’implementazione espansiva LLM.

AWS ha presentato le capacità di Trainium2 con il modello Llama 405B di Meta, che ha raggiunto”un throughput di generazione di token tre volte superiore rispetto ad altre offerte disponibili dei principali fornitori di servizi cloud”, secondo l’azienda.

Questo miglioramento accelera in modo significativo attività come la generazione di testo, il riepilogo e l’inferenza in tempo reale, rispondendo alle esigenze delle aziende che si affidano all’intelligenza artificiale generativa.

[contenuti incorporati]

UltraServer: scalabilità oltre i limiti

Per le aziende che affrontano modelli da trilioni di parametri, AWS ha introdotto gli UltraServer Trn2, che combinano 64 chip Trainium2 per fornire fino a 83,2 petaflop di prestazioni sparse FP8.

I server consentono tempi di formazione più rapidi e inferenza in tempo reale per modelli di intelligenza artificiale ultra-grandi, rappresentando un progresso fondamentale per le aziende che mirano a implementare soluzioni altamente complesse sistemi.

Gadi Hutt, direttore senior presso Annapurna Labs, ha spiegato le capacità degli UltraServer:

“Successivamente, superiamo il limite dei [16 chip] e forniamo 64 chip nell’UltraServer, e questo è per modelli estremamente grandi. Quindi, se abbiamo un modello da 7 miliardi di parametri, che una volta era grande, ma non più, o un modello estremamente grande, chiamiamolo 200 miliardi o 400 miliardi. Desideri pubblicare con la latenza più rapida possibile. Quindi utilizzi UltraServer.”

Collaborazione con Anthropic: creazione del più grande cluster di intelligenza artificiale

AWS ha collaborato con Anthropic per sviluppare Project Ranier, un sistema di elaborazione cluster che conterrà centinaia di migliaia di chip Trainium2.

AWS lo descrive come cinque volte più potente degli attuali sistemi di Anthropic e, secondo quanto riferito, è il più grande cluster di elaborazione AI del mondo data. Questa collaborazione sottolinea l’impegno di AWS nel fornire ai propri partner tecnologie all’avanguardia.

Anthropic, nota per il suo Claude 3.5 Sonnet LLM, si affida all’infrastruttura AWS per mantenere un vantaggio competitivo rispetto a rivali come OpenAI e Google. AWS ha recentemente raddoppiato il suo investimento in Anthropic portandolo a 8 miliardi di dollari, rafforzando la sua attenzione strategica all’intelligenza artificiale generativa.

Trainium3: Shaping the Future of AI Compute

AWS ha inoltre annunciato Trainium3, il suo prossimo chip basato su un processo a tre nanometri, che promette di fornire prestazioni quattro volte superiori a quelle degli UltraServer. Il lancio è previsto per la fine del 2025, Trainium3 consentirà addestramento e inferenza ancora più rapidi per modelli IA di prossima generazione, consolidando ulteriormente la leadership di AWS nel calcolo IA.

David Brown ha delineato la visione di AWS per il nuovo chip:”Con il nostro chip Trainium3 di terza generazione, consentiremo ai clienti di costruire modelli più grandi più velocemente e di fornire prestazioni in tempo reale superiori durante la loro implementazione.”

La strategia di AWS con Trainium3 mira a sfidare Il dominio di Nvidia nel mercato dell’hardware AI. Mentre le prossime GPU Blackwell di Nvidia vantano fino a 720 petaflop di prestazioni FP8, le soluzioni Trainium integrate di AWS offrono un’alternativa conveniente e scalabile su misura per carichi di lavoro AI su scala aziendale.

Supporto dell’ecosistema: strumenti per un’integrazione perfetta

Per integrare le sue innovazioni hardware, AWS fornisce Neuron SDK, un kit di strumenti di sviluppo ottimizzato per framework come PyTorch e JAX.

L’SDK include strumenti per l’addestramento e l’inferenza distribuiti, consentendo agli sviluppatori di sfruttare i chip Trainium senza una riconfigurazione estesa.

AWS offre anche AMI di deep learning preconfigurate, garantendo che gli sviluppatori possano implementare rapidamente le loro applicazioni IA.