TL;DR

Il succo: Mistral AI ha lanciato Devstral 2 e Vibe CLI per offrire funzionalità autonome di”codifica delle vibrazioni”ai modelli a peso aperto. Specifiche principali: il modello 123B vanta un’efficienza in termini di costi 7 volte migliore rispetto a Claude Sonnet, mentre una versione 24B più piccola funziona localmente su hardware consumer. Perché è importante: questo sfida gli ecosistemi proprietari come Replit offrendo alle aziende attente alla privacy una potente alternativa self-hosted per lo sviluppo di software tramite agenti. Contesto: il comunicato contrasta le recenti mosse di OpenAI e Google, posizionando Mistral come il principale rivale a peso aperto dei giganti statunitensi.

Sfidando il dominio degli assistenti di codifica proprietari, martedì Mistral AI ha lanciato Devstral 2. Il nuovo modello da 123 miliardi di parametri si rivolge al crescente mercato della”codifica delle vibrazioni”, offrendo capacità di ingegneria del software autonome che rivaleggiano con i sistemi chiusi riducendone i costi di quasi l’85%.

Nella versione è incluso anche Mistral Vibe, un interfaccia a riga di comando (CLI) progettata per consentire agli sviluppatori di eseguire attività di refactoring complesse tramite linguaggio naturale. La suite è completata da Devstral Small 2, una variante da 24 miliardi di parametri ottimizzata per l’implementazione locale su hardware consumer.

Il rilascio contrasta Google e OpenAI che bloccano i loro ecosistemi con partnership esclusive, posizionando Mistral come un’alternativa aperta per le imprese attente alla privacy.

Promo

Il perno del”Vibe Coding”: agenti sopra i chatbot

Lungi dall’essere un semplice aggiornamento del modello, il rilascio segna l’ingresso di Mistral nella tendenza del”vibe coding”, un cambiamento in cui gli sviluppatori si affidano a istruzioni in linguaggio naturale per generare intere funzionalità anziché scrivere la sintassi manuale.

Mentre strumenti come Cursor e Replit hanno reso popolare questo flusso di lavoro nel browser, Mistral lo sta inserendo direttamente nel terminale.

La CLI di Mistral Vibe funge da veicolo per questa transizione per incorporare l’intelligenza artificiale direttamente nell’ambiente locale dello sviluppatore. Funzionando come un assistente da riga di comando open source, lo strumento sfrutta il modello Devstral per tradurre le istruzioni del linguaggio naturale in azioni concrete.

Invece di generare semplicemente snippet, il sistema è progettato per esplorare, modificare ed eseguire modifiche su un’intera base di codice.

Funziona come utilità terminale autonoma o all’interno di un IDE tramite il protocollo di comunicazione dell’agente. L’interfaccia fornisce una suite di strumenti attivi, che consentono all’agente di manipolare file, cercare nel codice, gestire il controllo della versione ed eseguire comandi shell in modo autonomo.

Eseguendo la scansione delle strutture dei file e dello stato Git, la CLI crea un contesto”consapevole del progetto”che manca agli strumenti di completamento automatico tradizionali.

Può gestire l’orchestrazione di più file, come il refactoring di una codebase legacy o l’aggiornamento delle dipendenze in un intero progetto, senza perdere traccia della logica di sistema più ampia.

Realtà del benchmark: efficienza vs. potenza pura

Alla base di questo perno strategico c’è l’attenzione all’efficienza operativa piuttosto che alla semplice supremazia del benchmark.

Costruita per gestire la scala dei repository aziendali, l’architettura dà priorità alla densità e alla profondità della memoria.

La versione di punta di Devstral 2 utilizza una struttura di trasformatore densa di 123 miliardi di parametri abbinata a una finestra di contesto da 256.000 token.

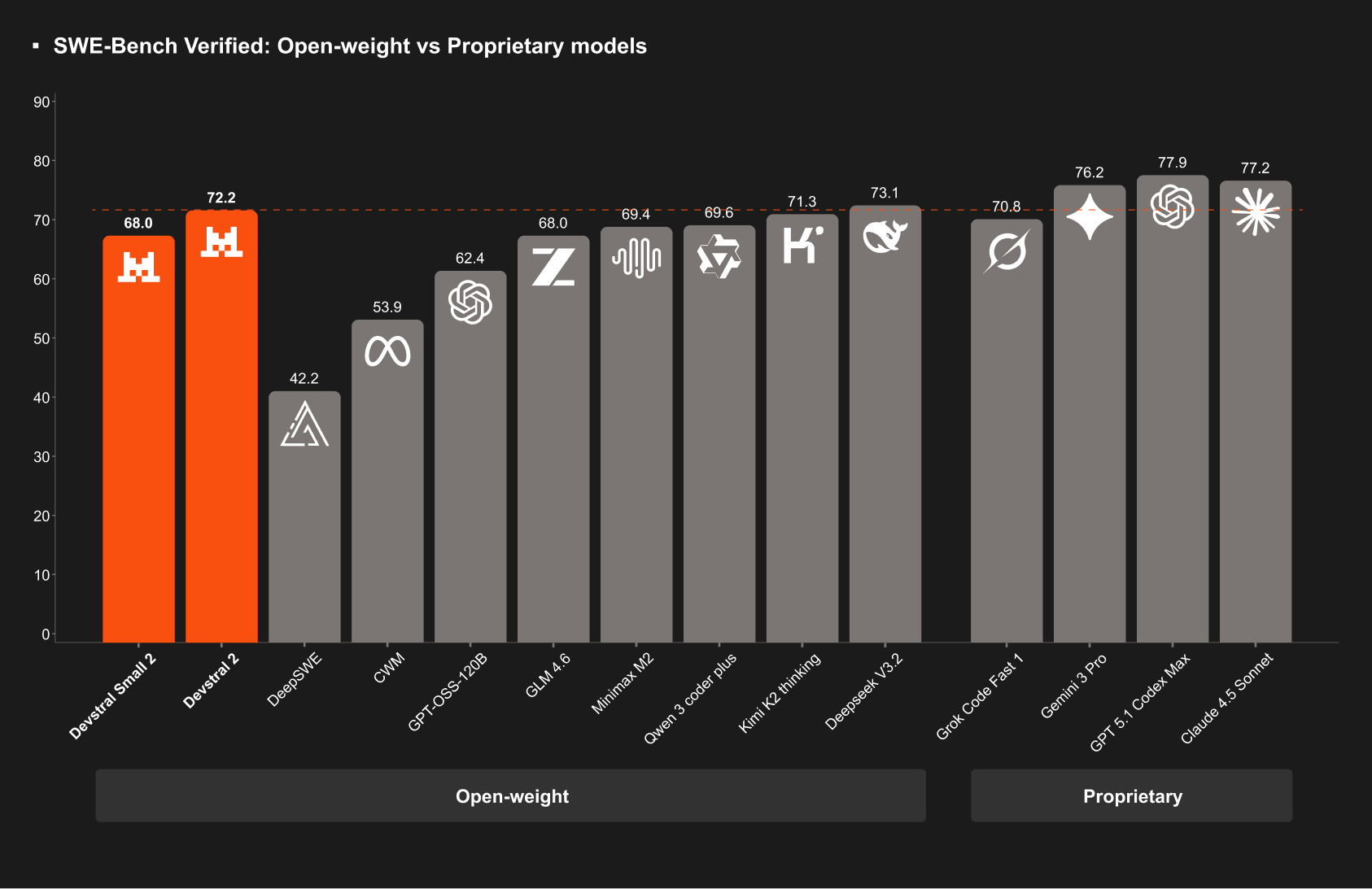

Offre un punteggio del 72,2% sul benchmark SWE-bench Verified, un risultato che Mistral cita come prova della sua posizione come modello open-weight di alto livello che rimane operativamente efficiente.

Allo stesso tempo, la variante più piccola Devstral Small 2 dimostra capacità significative rispetto al suo ingombro. Con un punteggio del 68,0% sullo stesso benchmark, compete con modelli cinque volte più grandi.

Fondamentalmente, queste prestazioni vengono fornite all’interno di un framework sufficientemente efficiente da poter essere eseguito localmente su hardware consumer standard, aggirando la necessità di un’infrastruttura di data center dedicata.

Sebbene il punteggio del modello del 72,2% su SWE-bench Verified sia competitivo (anche se la convalida indipendente rimane in sospeso), tecnicamente è inferiore al modello cinese open-weight DeepSeek V3.2.

DeepSeek attualmente detiene l’attuale tetto open source al 73,1%, ma Mistral sostiene che il vero vantaggio risiede nel rapporto costo-prestazioni.

Prezzi per il la nuova API è fissata a 0,40 dollari per milione di token di input e 2,00 dollari per milione di token di output. Questa struttura indebolisce significativamente Claude Opus 4.5 di Anthropic, offrendo un vantaggio dichiarato in termini di efficienza dei costi 7 volte superiore rispetto alla linea di base di Claude 3.5 Sonnet.

I suoi requisiti hardware riflettono l’attenzione aziendale del modello. L’esecuzione del modello completo di parametri 123B richiede un minimo di quattro GPU H100, posizionandolo saldamente nel livello datacenter. Nonostante le pesanti esigenze infrastrutturali, i primi utilizzatori segnalano ottimi parametri di throughput.

Il vantaggio locale: Devstral Small 2

Disaccoppiando l’intelligenza dal cloud, Mistral si rivolge anche al segmento di mercato sensibile alla privacy. Devstral Small 2, una variante da 24 miliardi di parametri, è esplicitamente progettata per funzionare su hardware di livello consumer.

Con un punteggio SWE-bench del 68,0%, il modello più piccolo supera la sua classe di peso, offrendo prestazioni paragonabili a modelli molto più grandi della generazione precedente. Il suo principale elemento di differenziazione, tuttavia, è la licenza.

Mentre il più grande Devstral 2 viene fornito con una licenza MIT modificata (che probabilmente implica restrizioni basate sulle entrate), Devstral Small 2 utilizza la permissiva licenza Apache 2.0. Questa distinzione consente agli sviluppatori di modificare e integrare il modello senza i vincoli legali spesso associati ai pesi proprietari.

Per le aziende, ciò consente un flusso di lavoro ibrido: utilizzare il pesante modello 123B per la pianificazione architettonica complessa tramite API, distribuendo al contempo il modello 24B localmente per il completamento rapido e privato del codice che non lascia mai il firewall aziendale.

Contesto di mercato: la corsa agli armamenti”Code Red”

Arrivando durante un periodo di intensa attività nel settore della codifica IA, il lancio avviene nel mezzo della recente corsa al rilascio dell’IA.

I concorrenti stanno perseguendo l’integrazione verticale per coinvolgere gli sviluppatori. La partnership di Google Cloud con Replit esemplifica questa strategia closed source, raggruppando IDE, cloud computing e modello in un unico stack proprietario. Allo stesso modo, Gemini 3 Pro e il nuovo Antigravity IDE mirano a mantenere gli utenti all’interno dell’ecosistema Google.

Anche la proprietà dell’infrastruttura è diventata un campo di battaglia chiave. In seguito all’acquisizione di Bun, Anthropic sta costruendo un runtime dedicato per ottimizzare l’esecuzione dei suoi agenti, alzando ulteriormente la barriera all’ingresso per i fornitori di modelli autonomi.

L’approccio di Mistral offre un’alternativa distinta: si posiziona come un”campione europeo”che fornisce la flessibilità dei pesi aperti e dell’implementazione locale, in netto contrasto con i giardini recintati eretti dai suoi rivali con sede negli Stati Uniti.