TL;DR

Il succo: Google sta testando un’interfaccia”Search Live”che visualizza schede di citazioni visive in tempo reale durante le risposte vocali alle conversazioni. Dettagli chiave: Basata su Gemini 3, la funzionalità fa emergere i collegamenti alla fonte mentre l’intelligenza artificiale parla per consentire la verifica immediata delle affermazioni. Perché è importante: questo aggiornamento mira a correggere il”divario di fiducia”causato dalle allucinazioni dell’intelligenza artificiale e ad affrontare le preoccupazioni dei publisher sul traffico a zero clic.

Colmando il divario tra la ricerca vocale conversazionale e l’attribuzione sul web, Google sta testando una nuova interfaccia che sovrappone schede di citazioni visive durante le risposte parlate in tempo reale. La funzionalità sperimentale, individuata nella modalità AI dell’azienda, mira a mitigare la natura di”scatola nera”delle interazioni audio.

Emergendo collegamenti sorgente mentre l’intelligenza artificiale parla, l’aggiornamento affronta le critiche persistenti riguardanti le”allucinazioni”, in cui i modelli inventano fatti, e l’erosione del traffico degli editori. Integra le funzionalità di conversazione di Gemini Live direttamente nel prodotto di ricerca principale.

Visualizzazione della voce: come funziona la nuova interfaccia

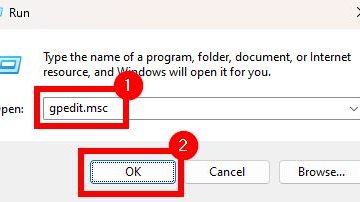

Individuato dall’esperto SEO Sachin Patel durante un test A/B, l’aggiornamento incorpora la funzionalità Cerca in tempo reale direttamente nell’interruttore standard della modalità AI presente nell’app Google.

A differenza dei precedenti assistenti vocali che spesso funzionano come”scatole nere”opache, questa interfaccia genera schede di citazione visive in tempo reale. Mentre l’intelligenza artificiale fornisce una risposta, sullo schermo vengono visualizzati i collegamenti alle fonti pertinenti, consentendo agli utenti di verificare immediatamente affermazioni specifiche.

È nuovo in modalità Ai (la mia domanda è: cos’è il SEO) @brodieseo @rustybrick @gaganghotra_ pic.twitter.com/3N5hXtKmdm

— Sachin Patel (@SachuPatel53124) Dicembre 6, 2025

All’interno, il sistema sfrutta le capacità multimodali dell’integrazione Gemini 3 recentemente implementata. Questo aggiornamento del modello è stato progettato per gestire query complesse in più passaggi che richiedono la sintesi di informazioni provenienti da fonti disparate.

Promo

I dirigenti hanno notato un cambiamento nel modo in cui gli utenti interagiscono con questi modelli più capaci. Come ha osservato in precedenza Hema Budaraju, Senior Director of Product di Google,”con la modalità AI, stiamo già vedendo le persone approfondire argomenti complessi e porre domande quasi tre volte più a lungo rispetto alle ricerche tradizionali.”

Lo spostamento di questa funzionalità dall’app Gemini autonoma all’ambiente di ricerca ad alto traffico segnala un importante cambiamento strategico. Tenta di normalizzare l’intelligenza artificiale conversazionale come metodo di ricerca principale piuttosto che come novità.

Il divario di fiducia: mitigare le allucinazioni

La ricerca vocale ha storicamente sofferto di una mancanza di attribuzioni chiare. Gli utenti in genere ricevono una risposta sintetizzata senza sapere da dove hanno avuto origine le informazioni, rendendo difficile la verifica.

Strategicamente, l’integrazione segue il lancio del motore di ragionamento Deep Think di Google. Questa architettura consente al modello di fermarsi e ragionare prima di rispondere, una capacità che Demis Hassabis, CEO di Google DeepMind, ha descritto come”il modello più avanzato di Google per attività complesse”in grado di”comprendere vasti set di dati, affrontando problemi provenienti da diverse fonti di informazione”.

Nonostante questi progressi, l’affidabilità rimane un ostacolo fondamentale per un’adozione diffusa. Una ricerca indipendente suggerisce che i risultati della ricerca generativa spesso divergono in modo significativo dalle classifiche tradizionali.

Un recente studio sull’affidabilità ha quantificato questa discrepanza, rilevando che il 53% dei siti web collegati dalla panoramica AI di Google non è apparso nei primi 10 risultati di una ricerca convenzionale. Ciò indica una divergenza significativa rispetto ai segnali di ranking stabiliti dalla ricerca tradizionale.

Tali risultati evidenziano il”gap di fiducia”che le carte visive mirano a colmare. Visualizzando le fonti specifiche utilizzate per generare una risposta, Google sta tentando di dimostrare che la sua intelligenza artificiale sta basando le sue risposte su contenuti web reali piuttosto che su fatti inventati.

La guerra degli editori: traffico contro risposte

Per le società di media, il passaggio alla ricerca vocale”agente”rappresenta una potenziale minaccia per il traffico dei referral. Gli editori temono che le risposte vocali esaustive eliminino la necessità di fare clic, anche se è visibile una scheda di citazione.

Le piattaforme stanno contrastando questa narrativa tentando di ridefinire il valore di un’interazione di ricerca. Sostengono che, sebbene il volume possa diminuire, l’intento del traffico rimanente è più elevato.

Microsoft è stata particolarmente esplicita riguardo a questo cambiamento nei parametri. Fabrice Canel, Principal Product Manager di Bing, ha affermato che”per gli esperti di marketing, la visibilità stessa sta diventando una forma di valuta. Se si modellano le preferenze prima ancora che avvenga un clic.”

Sia Microsoft che Google hanno rilasciato dati affermando che i tassi di conversione dichiarati dai referral AI sono fino a 3 volte superiori rispetto al traffico di ricerca tradizionale.

I dirigenti dei media non sono convinti di questa difesa della”qualità rispetto alla quantità”. Molti vedono lo scraping dei propri dati per la formazione sull’intelligenza artificiale come una violazione fondamentale dello scambio di valori del web.