Mentre metteva pubblicamente in guardia sull'”irrazionalità”del mercato dell’intelligenza artificiale, la leadership di Google ha ordinato in privato un’aggressiva espansione dell’infrastruttura per raddoppiare la capacità di servizio dell’intelligenza artificiale ogni sei mesi.

Secondo una presentazione vista da CNBC questa settimana, la direttiva mira ad un aumento su scala di 1.000 volte entro cinque anni per supportare l'”era dell’inferenza”ad alta intensità di calcolo.

Consegnato dal vicepresidente delle infrastrutture Amin Vahdat, questo mandato interno è in netto contrasto con i recenti commenti del CEO Sundar Pichai a un’intervista con la BBC su una potenziale bolla.

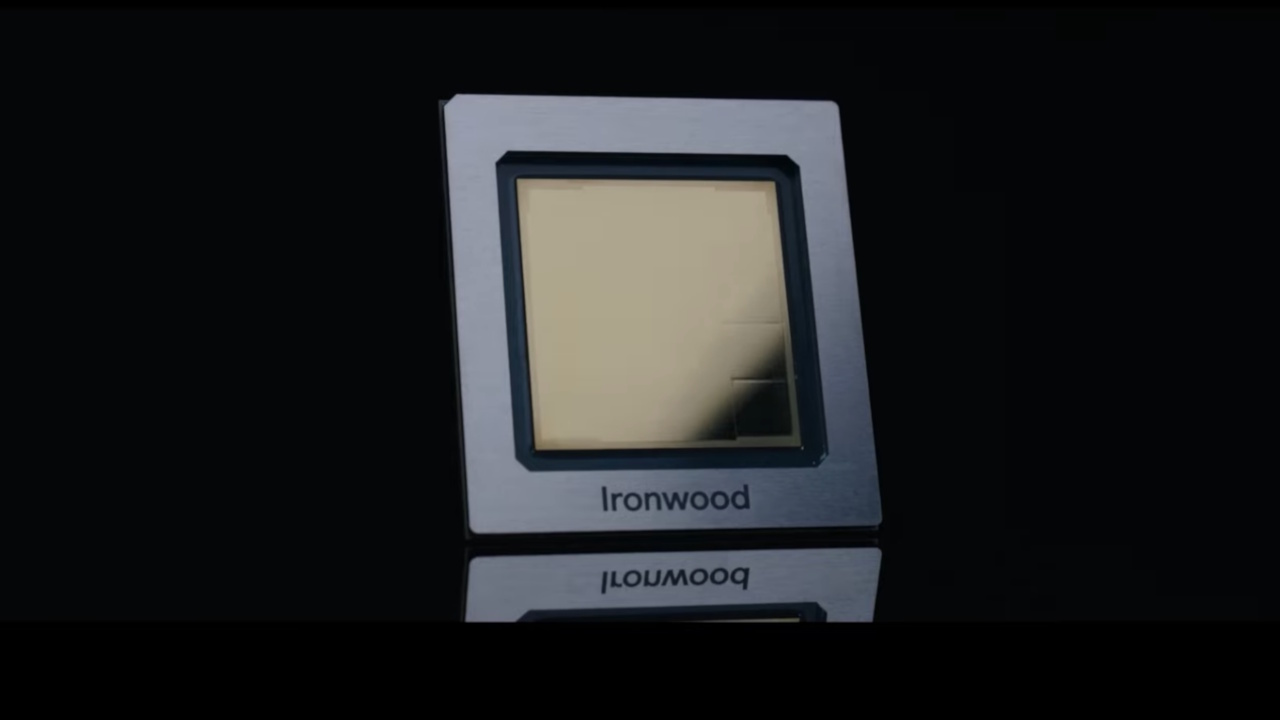

Spinta dal timore esistenziale di sottoinvestire, la strategia si basa su silicio personalizzato come i chip Ironwood TPU di Google per evitare che i costi aumentino vertiginosamente insieme alla crescita della capacità.

Il mandato 1.000x: all’interno della War Room di Google

I dettagli emersi dall’incontro collettivo del 6 novembre dipingono il quadro di un’azienda che opera su basi di guerra.

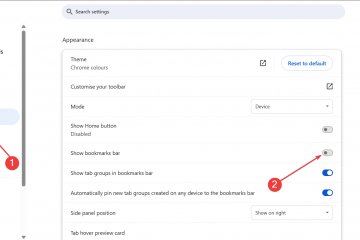

Il vicepresidente delle infrastrutture Amin Vahdat ha presentato una tabella di marcia intitolata”Infrastruttura AI”che definisce i requisiti di crescita esponenziale necessari per tenere il passo con la domanda. Esplicitamente, la direttiva impone a Google di raddoppiare la propria capacità di servizio di intelligenza artificiale ogni sei mesi per mantenere la propria posizione competitiva.

Le proiezioni a lungo termine mirano a uno sconcertante aumento di 1.000 volte della capacità entro soli quattro-cinque anni. A guidare questa accelerazione non è l’addestramento dei modelli, che storicamente ha consumato la maggior parte delle risorse di calcolo, ma un passaggio fondamentale verso”l’era dell’inferenza”.

Modelli come Gemini 3 Pro lanciato di recente richiedono una potenza di calcolo massiccia e continua per eseguire attività di ragionamento ed eseguire codice.

Vahdat ha avvertito che”la competizione nell’infrastruttura di intelligenza artificiale è la parte più critica e anche la parte più costosa della corsa all’intelligenza artificiale.”

Questo sentimento è stato rafforzato dal CEO Sundar Pichai, che ha citato le opportunità mancate con lo strumento di generazione video dell’azienda, Veo, a causa di limitazioni hardware. Pichai ha ammesso che, nonostante la forte crescita del cloud,”quei numeri sarebbero stati molto migliori se avessimo avuto più risorse di calcolo.”

Lungi dal ridimensionare di fronte allo scetticismo del mercato, il tono interno inquadra il 2026 come un anno”intenso”di”alti e bassi”. Il messaggio della leadership è chiaro: il vincolo principale alla crescita non è più la capacità del software, ma la disponibilità fisica dell’elaborazione.

Il Silicon Shield: Ironwood, Axion e la trappola dell’efficienza

Ridimensionare la capacità di 1.000 volte utilizzando hardware standard sarebbe finanziariamente rovinoso. La strategia di Google si basa sul disaccoppiamento dei guadagni in termini di prestazioni dagli aumenti lineari dei costi. Vahdat ha delineato i requisiti tecnici:

“Google deve essere in grado di fornire 1.000 volte più capacità, elaborazione e reti di archiviazione sostanzialmente allo stesso costo e, sempre di più, con la stessa potenza, lo stesso livello di energia”, ha affermato Vahdat.”

Alla base di questa massiccia espansione c’è una realtà economica semplice ma brutale: l’efficienza è l’unica via verso la sostenibilità. La dipendenza dal TPU Ironwood, entrato in disponibilità generale solo di recente, è centrale in questa strategia.

Dichiarando un miglioramento delle prestazioni di picco 10 volte rispetto al v5p, questo chip di settima generazione offre prestazioni per watt 2 volte superiori rispetto alla precedente generazione Trillium.

I carichi di lavoro generici vengono scaricati sulle nuove CPU Axion basate su Arm per liberare energia e margine termico per le attività di intelligenza artificiale. Trasferendo i lavori di elaborazione standard su processori più efficienti, Google mira a massimizzare l’energia disponibile per i suoi TPU assetati di energia.

Adottando una filosofia di”co-progettazione”, gli ingegneri integrano il software direttamente con l’architettura hardware. La ricerca di Google DeepMind informa la progettazione del chip, consentendo all’azienda di ottenere vantaggi dove l’hardware standard non può. Vahdat ha osservato che”non sarà facile, ma attraverso la collaborazione e la co-progettazione ci arriveremo”.

Incombe tuttavia la”trappola dell’efficienza”. Il paradosso di Jevons suggerisce che man mano che l’elaborazione diventa più efficiente, la domanda aumenterà fino a consumare il surplus, annullando i risparmi sui costi. Se il costo dell’inferenza dovesse diminuire, si prevede che il volume delle query, guidate da flussi di lavoro agenti e dal ragionamento”Deep Think”, esploderà, mantenendo elevato il consumo energetico totale.

Il paradosso della bolla: scommettere contro l'”irrazionalità”

In mezzo al crescente scetticismo esterno riguardo al ritorno sull’investimento (ROI) per l’intelligenza artificiale generativa, questa aggressiva espansione interna procede.

In un’intervista con la BBC, Pichai ha ammesso che ci sono”elementi di irrazionalità”nell’attuale valutazione di mercato dell’intelligenza artificiale. Nonostante questa cautela pubblica, Alphabet ha aumentato le previsioni di spesa in conto capitale per il 2025 a 93 miliardi di dollari, con un”aumento significativo”previsto per il 2026.

I dipendenti hanno sfidato direttamente la leadership su questa disconnessione durante la sessione di domande e risposte. Una domanda riguardava specificamente la tensione tra l’impennata della spesa e il timore di una correzione del mercato:

“Tra importanti investimenti nell’alluminio e discorsi di mercato su un potenziale scoppio della bolla dell’alluminio, come possiamo pensare di garantire sostenibilità e redditività a lungo termine se il mercato dell’alluminio non matura come previsto?”

La difesa di Pichai si basa sul bilancio dell’azienda. Ha sostenuto:”Siamo in una posizione migliore per resistere, sai, ai fallimenti, rispetto ad altre aziende.”

In via difensiva, la logica presuppone che il rischio di sottoinvestire – e potenzialmente diventare irrilevante – sia esistenziale, mentre investire eccessivamente è semplicemente costoso.

Tale ragionamento attualmente guida l’attuale AI Capex Boom, in cui la costruzione di infrastrutture si è staccata dalla realtà dei ricavi immediati. Google sta effettivamente scommettendo di poter sopravvivere alla concorrenza in una guerra di logoramento ad alta intensità di capitale.

La realtà del mercato: il dilemma del prigioniero dell’intelligenza artificiale

Collettivamente, secondo dati citati dalla CNBC. Il CEO di Nvidia Jensen Huang questa settimana ha rifiutato esplicitamente la narrativa della”bolla”, citando una domanda tangibile, una visione da cui Google deve difendersi.

Il concorrente OpenAI sta affrontando le proprie difficoltà. Una nota interna di Sam Altman emersa questa settimana suggerisce che il leader del settore è sempre più alle prese con le realtà economiche del ridimensionamento. Ciò crea un’apertura affinché Google possa sfruttare la sua integrazione verticale.

Spostare il collo di bottiglia dalla disponibilità dei dati alla pura velocità e ai costi di generazione dei token è l'”età dell’inferenza”. Il vantaggio specifico di Google risiede nel suo stack di silicio personalizzato, che gli consente potenzialmente di resistere a una guerra dei prezzi schiacciante dei margini meglio di quelli che fanno affidamento esclusivamente sull’hardware Nvidia.

I recenti lanci di prodotti, come Gemini 3 Pro e Gemini 3 Pro Image, spingono ulteriormente questa domanda. In definitiva, il risultato dipende dal fatto che funzionalità premium come”Deep Think”e flussi di lavoro agenti possano generare entrate più velocemente rispetto al deprezzamento dell’hardware.

Nonostante i costi sconcertanti coinvolti, Google sembra finora impegnata in una strategia”costruiscilo e arriveranno”.