Meno di quattro mesi dopo aver presentato il suo Segment Anything Model 2 incentrato sui video, Meta ha rilasciato SAM 3 e SAM 3D, implementando immediatamente i modelli avanzati di visione artificiale in prodotti di consumo come Facebook Marketplace e Instagram.

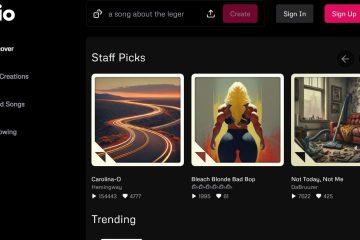

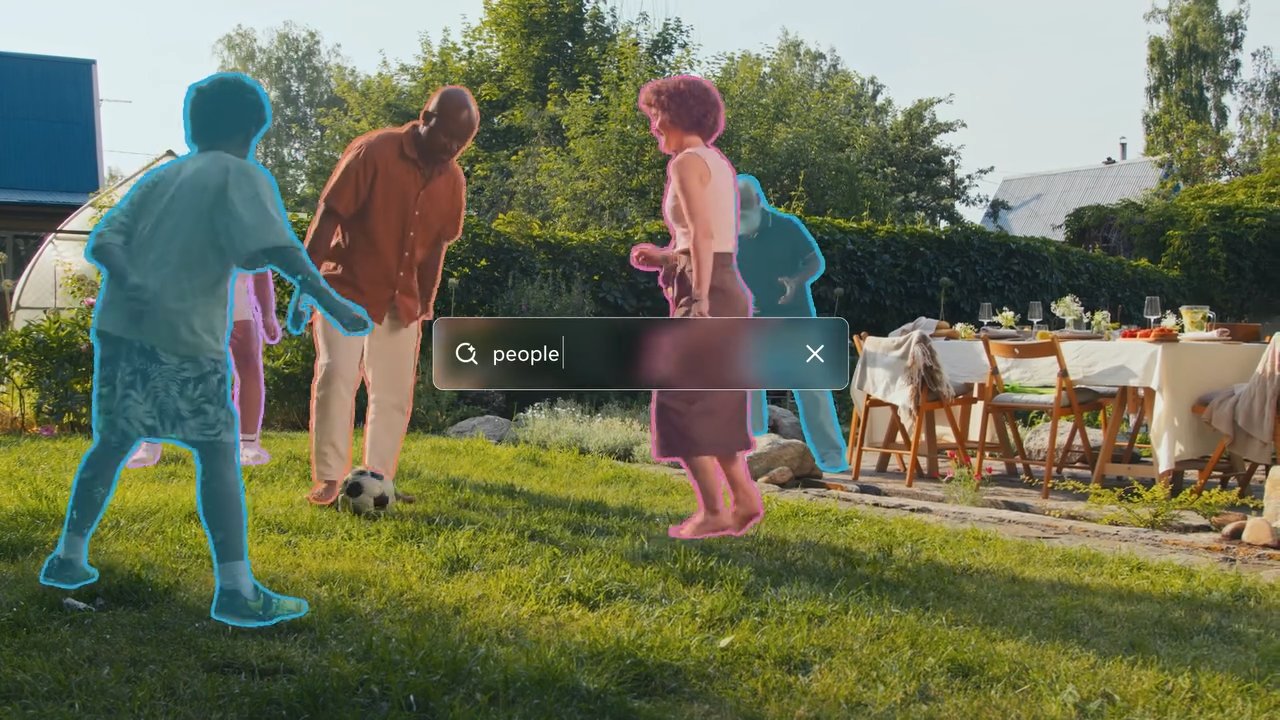

Entrambi gli strumenti offrono ai computer una comprensione molto migliore di ciò che stanno guardando. SAM 3 consente agli utenti di digitare una descrizione e fare in modo che l’intelligenza artificiale trovi ed evidenzi immediatamente ogni oggetto corrispondente in una foto o in un video.

SAM 3D fa un ulteriore passo avanti prendendo un’immagine piatta bidimensionale e prevedendo come apparirà l’oggetto da altre angolazioni, trasformando efficacemente una foto standard in un modello 3D ruotabile.

Mentre le iterazioni precedenti sono rimaste in gran parte nell’ambito della ricerca, questo aggiornamento segna un rapido passaggio all’utilità applicata, potenziando funzionalità che consentono agli utenti di visualizzare i mobili nelle loro case o applicare effetti a oggetti specifici nei video.

I nuovi modelli introducono”Promptable Concept”Segmentazione”, che consente l’identificazione basata su testo di tutti gli oggetti corrispondenti in una scena e la ricostruzione 3D ad alta fedeltà da singole immagini 2D: le funzionalità dichiarate da Meta superano i benchmark esistenti con un ampio margine.

La versione del 2024 di SAM 2 si concentrava fortemente sull’efficienza della segmentazione video, ma l’annuncio di oggi amplia significativamente l’ambito per includere la comprensione semantica e la generazione 3D.

Dalla ricerca al prodotto: immediato Integrazione

Rompendo dal tradizionale ciclo dalla ricerca al prodotto, Meta sta bypassando la tipica fase di incubazione per integrare SAM 3 direttamente nelle sue applicazioni di punta.

Gli utenti di Facebook Marketplace ora incontreranno una funzionalità”Visualizza in camera”basata su SAM 3D, che consente ai potenziali acquirenti di visualizzare come apparirebbero i mobili all’interno dei propri spazi abitativi prima di impegnarsi in un acquisto.

Questa applicazione sfrutta la capacità di ricostruzione del modello Oggetti 3D da singole immagini 2D, che affrontano un punto di attrito comune nel commercio online.

Contemporaneamente, l’app”Modifiche”di Instagram e la funzione”Vibes”all’interno di Meta AI utilizzano SAM 3 per abilitare effetti video precisi e specifici per l’oggetto. I creatori possono ora applicare modifiche come l’illuminazione o le tracce di movimento a soggetti specifici all’interno di un fotogramma video, attività che in precedenza richiedevano un mascheramento complesso in un software di editing professionale.

Visualizzazione sui thread

Automando questi processi, Meta mira a mercificare gli effetti visivi avanzati, rendendoli accessibili come utilità standard per gli utenti occasionali.

Per facilitare una sperimentazione più ampia, l’azienda ha lanciato il programma”Segment Anything”Playground”, un’interfaccia basata sul web che consente al pubblico di testare questi modelli senza competenze tecniche.

Gli utenti possono caricare immagini o video e richiedere al sistema descrizioni di testo per vedere le capacità di segmentazione in tempo reale. Questa strategia è in netto contrasto con il lancio di SAM 2, che è rimasto principalmente uno strumento per la comunità di ricerca sulla visione artificiale.

L’implementazione immediata nelle app consumer suggerisce un perno strategico per sfruttare i progressi dell’intelligenza artificiale per la fidelizzazione e il coinvolgimento degli utenti nell’ecosistema sociale di Meta.

Salto tecnico: segmentazione dei concetti e 3D

SAM 3 introduce una funzionalità significativa denominata”Promptable Concept Segmentation”(PCS). A differenza dei suoi predecessori, che si concentravano sulla segmentazione di singoli oggetti in base a suggerimenti visivi come clic o caselle, SAM 3 può identificare e mascherare tutte le istanze di un concetto descritto dal testo.

Ad esempio, un utente può richiedere al modello”berretto da baseball rosso”e segmenterà ogni elemento corrispondente nel frame. Questo cambiamento richiede che il modello possieda sia la comprensione semantica del testo che precise capacità di localizzazione.

Per raggiungere questo obiettivo, l’architettura disaccoppia il riconoscimento dalla localizzazione utilizzando un”token di presenza”. Questo meccanismo determina innanzitutto se un concetto esiste all’interno del frame prima che il modello tenti di segmentarlo, riducendo i falsi positivi e migliorando la precisione di rilevamento complessiva.

Secondo il Meta Research Team,”SAM 3 raddoppia la precisione dei sistemi esistenti sia nel PCS di immagini che video e migliora le precedenti capacità SAM nelle attività di segmentazione visiva.”

Questo duplice approccio consente al modello di gestire query complesse mantenendo prestazioni elevate nelle attività di segmentazione standard.

Meta Sam 3 Segment Anything with Concetti

Nella generazione 3D, SAM 3D consente la ricostruzione di oggetti e scene da una singola immagine 2D, un’attività che tradizionalmente richiedeva più punti di vista o dati di profondità. Meta afferma che questo nuovo modello supera in modo significativo i metodi esistenti.

Il team Meta AI rileva che”nei test sulle preferenze umane testa a testa, raggiunge almeno un tasso di vincita di 5:1 rispetto ad altri modelli leader.”Ciò è particolarmente rilevante per le applicazioni nella realtà aumentata e nei giochi, dove la generazione rapida di risorse è fondamentale.

Visualizza sui thread

Le metriche sulle prestazioni rilasciate da Meta indicano che SAM 3 è altamente efficiente. Il Meta Research Team afferma inoltre che”SAM 3 funziona in 30 millisecondi per una singola immagine con più di 100 oggetti rilevati su una GPU H200.”Tale velocità è essenziale per le applicazioni in tempo reale sui dispositivi consumer, dove la latenza può peggiorare l’esperienza dell’utente.

Per la ricostruzione umana, SAM 3D Body utilizza un nuovo formato open source.

“SAM 3D Body… sfrutta un nuovo formato mesh 3D open source chiamato Meta Momentum Human Rig (MHR), che offre una migliore interpretabilità separando la struttura scheletrica e la forma dei tessuti molli.”

Questa separazione consente di più modelli umani realistici e adattabili, che potrebbero avere implicazioni per avatar virtuali e animazioni.

Nonostante questi progressi, il modello non è privo di limitazioni. Il team Meta AI ammette che”SAM 3 fatica a generalizzare concetti fuori dominio a grana fine in modo zero-shot, come identificare termini specifici che richiedono la conoscenza del dominio come”piastrina”..”

Ciò suggerisce che, sebbene il modello sia robusto per oggetti comuni, potrebbe richiedere una messa a punto o dati aggiuntivi per gestire in modo efficace categorie specializzate o rare.

Data Engine e benchmarking

Sfruttando un motore di dati ibrido, Meta è stata in grado di ridimensionare in modo significativo i propri dati di addestramento. L’azienda ha sviluppato un sistema utilizzando”annotatori IA”basati su Llama per verificare le maschere e controllarne l’esaustività, un compito che sarebbe proibitivamente lento per i soli esseri umani.

Meta spiega che”delegando determinati compiti agli annotatori IA-modelli che corrispondono o superano la precisione umana-più che raddoppiamo la produttività rispetto a una pipeline di annotazioni riservata esclusivamente agli esseri umani.”

Questo approccio ha consentito la creazione del set di dati SA-Co, che contiene oltre 4 milioni di concetti unici e 52 milioni di maschere, fornendo un ricco terreno di allenamento per i nuovi modelli.

Oltre ai modelli, Meta ha rilasciato il benchmark”Segment Anything with Concepts”(SA-Co). Questo set di dati comprende 207.000 concetti unici progettati per testare le capacità di riconoscimento del vocabolario aperto, spingendo lo standard di settore per la valutazione.

Il motore di dati inoltre estrae in modo iterativo gli”hard negatives”(frasi che non esistono in un’immagine ma sono contraddittorie per il modello) per migliorare la robustezza contro i falsi positivi.

Oltre alle app consumer, la tecnologia sta trovando applicazioni nella ricerca scientifica. Una partnership con Conservation X Labs ha applicato SAM 3 al set di dati SA-FARI, aiutando nel monitoraggio automatizzato della fauna selvatica attraverso la segmentazione video. Questo caso d’uso dimostra la potenziale utilità del modello nell’elaborazione di grandi volumi di dati video non curati per scopi di ricerca.

La versione include pesi del modello, codice e set di dati di valutazione, continuando la strategia di Meta di open source delle principali tecnologie IA. Rendendo disponibili questi strumenti, Meta mira a stabilire standard di settore e a incoraggiare l’ulteriore sviluppo all’interno della comunità dell’intelligenza artificiale.

Il lavoro futuro si concentrerà sul miglioramento della capacità del modello di gestire query di ragionamento complesse combinando SAM 3 con Multimodal Large Language Models (MLLM), consentendo potenzialmente interazioni ancora più sofisticate.