Un giornale pakistano ha evidenziato il crescente problema dei risultati non controllati dell’intelligenza artificiale dopo aver erroneamente stampato un testo loquace da un chatbot. Nell’edizione del 12 novembre, Dawn ha incluso un messaggio generato dall’intelligenza artificiale per rendere l’articolo ovviamente generato”più scattante”, costringendo le scuse pubbliche per aver infranto le sue stesse regole.

Un errore di questo tipo non è un caso isolato ma parte di una tendenza più ampia di fallimenti dell’intelligenza artificiale. Dalle false fonti legali utilizzate in tribunale ai rapporti governativi errati, la fretta di adottare l’intelligenza artificiale generativa senza un’attenta revisione umana sta erodendo la fiducia del pubblico. È una tendenza che crea seri problemi reali alle principali istituzioni.

“Do You Want Me to Do That Next?”: A Newspaper’s Public AI Gaffe

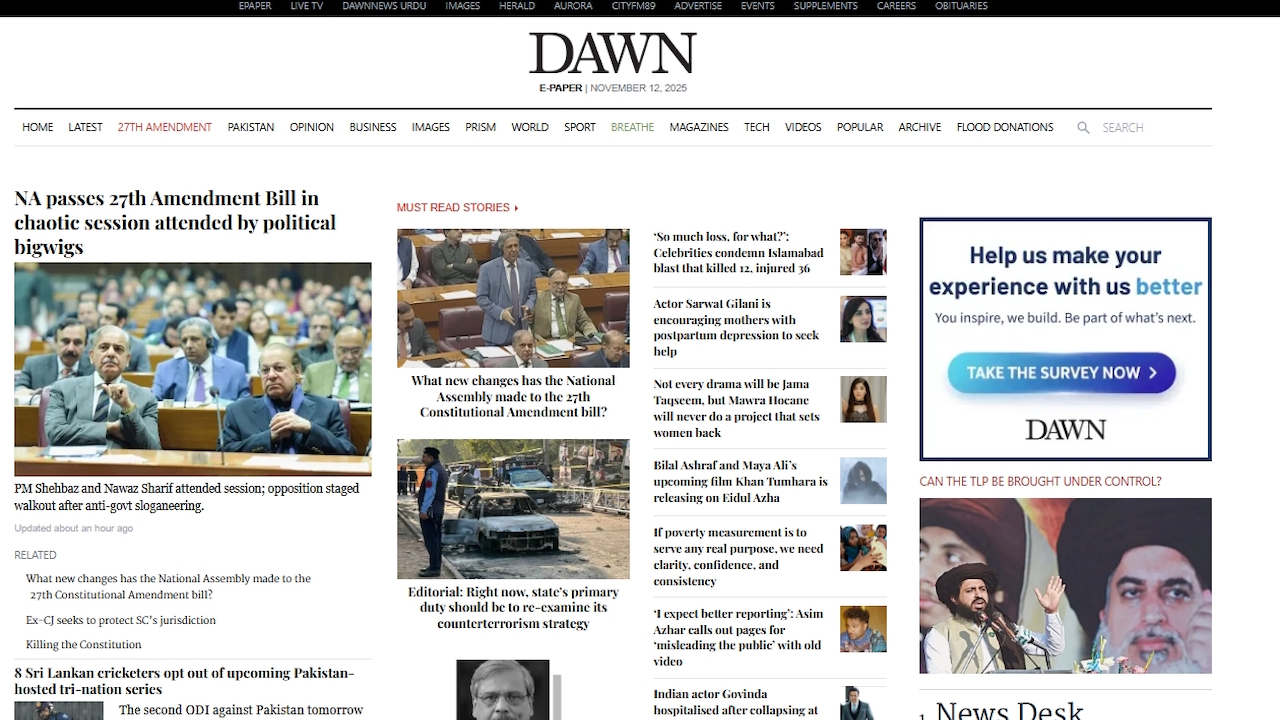

Lo stimato quotidiano pakistano in lingua inglese, Dawn, ha pubblicato un articolo sulle vendite di automobili che terminava con un bizzarro post scriptum generato automaticamente. Invece di un paragrafo conclusivo, l’articolo conteneva un classico pezzo di sciocchezza di chatbot.

L’intelligenza artificiale ha chiesto al suo utente:”Se vuoi, posso anche creare una versione in”stile prima pagina”ancora più scattante con statistiche incisive di una riga e un audace, pronto per l’infografica. layout: perfetto per il massimo impatto sui lettori. Vuoi che lo faccia dopo?“

So che i giornalisti usano l’intelligenza artificiale nel loro lavoro, ma questo è un po’eccessivo!

La scrivania delle pagine aziendali di Dawn avrebbe dovuto almeno modificare l’ultimo paragrafo!

😆😆😆 pic.twitter.com/JWNdHNWvnv

— omar r quraishi (@omar_quraishi) 12 novembre 2025

Individuata rapidamente dai lettori, la gaffe si è diffusa rapidamente online, costringendo il giornale a rilasciare una correzione e delle scuse formali. In una nota allegata alla versione online dell’articolo, l’editore ha ammesso:”Questo articolo di giornale è stato originariamente modificato utilizzando l’intelligenza artificiale, il che viola l’attuale politica sull’intelligenza artificiale di Dawn…. La violazione della politica sull’intelligenza artificiale è deplorevole.”

Secondo quanto riferito, è in corso un’indagine sull’incidente. Linee guida ufficiali del giornale vietano esplicitamente l’uso dell’intelligenza artificiale per generare o modificare notizie senza una rigorosa supervisione umana.

Sebbene la gaffe di Dawn abbia fornito un momento di imbarazzo pubblico, funge da potente simbolo per una questione molto più profonda e consequenziale. In tutti i settori, l’implementazione prematura dell’intelligenza artificiale generativa senza un’adeguata supervisione sta portando a una serie di fallimenti di alto profilo, minando gli standard professionali e la fiducia del pubblico.

Un problema sistemico: quando l’intelligenza artificiale ha allucinazioni in campi ad alta posta in gioco

In tutti i campi professionali, dal diritto alla sanità pubblica, le organizzazioni stanno scoprendo a proprie spese che non è possibile affidare compiti critici a modelli linguistici di grandi dimensioni. Conosciuto come allucinazione, il fenomeno in cui un’intelligenza artificiale inventa con sicurezza fatti, fonti o dati si sta rivelando un difetto persistente e pericoloso.

Un esempio recente e costoso viene dal mondo della consulenza. L’azienda globale Deloitte è stata costretta a rimborsare 97.000 dollari al governo australiano dopo che un rapporto da 440.000 dollari prodotto si è rivelato pieno di citazioni fabbricate dall’intelligenza artificiale.

Il suo rapporto, una revisione sensibile del sistema di welfare nazionale, citava libri inesistenti e casi legali citati erroneamente. La senatrice laburista australiana Deborah O’Neill ha rimproverato duramente, affermando:”Deloitte ha un problema di intelligenza umana. Sarebbe ridicolo se non fosse così deplorevole.”

Problemi gravi si stanno manifestando anche nel settore pubblico. A luglio, è emerso che la nuova intelligenza artificiale”Elsa”della Food and Drug Administration statunitense, destinata ad accelerare l’approvazione dei farmaci, stava invece fabbricando studi medici inesistenti.

Un dipendente frustrato della FDA ha descritto lo strumento alla CNN come inaffidabile, affermando che”ha allucinazioni in modo sicuro”, mentre un altro si è lamentato:”Perdo molto tempo extra solo a causa della maggiore vigilanza che devo avere”.

Allo stesso modo, gli avvocati della società di intelligenza artificiale Anthropic hanno dovuto scusarsi formalmente con un giudice dopo che il loro stesso Claude AI ha inventato una citazione legale utilizzata in un documento giudiziario.

Il giornalismo, in particolare, ha assistito a ripetuti casi di questa svista. In un caso sorprendentemente simile di ottobre, la rivista tedesca Der Spiegel ha dovuto correggere un articolo che includeva una frase generata dall’intelligenza artificiale offrendo di cambiare il tono del testo.

Questi errori non sono limitati ai livelli inferiori content farm, ma stanno comparendo in media rispettati e affermati, evidenziando una rottura sistemica nei flussi di lavoro editoriali.

Questi non sono incidenti isolati. Uno studio internazionale fondamentale coordinato dalla BBC e dalla European Broadcasting Union (EBU) ha rivelato la natura sistemica di questa inaffidabilità.

Dopo aver valutato oltre 3.000 risposte, i suoi risultati hanno mostrato che gli assistenti IA producono errori significativi nel 45% delle risposte relative alle notizie. Come ha spiegato il direttore dei media dell’EBU, Jean Philip De Tender,”Questa ricerca dimostra in modo conclusivo che questi fallimenti non sono incidenti isolati. Sono sistemici, transfrontalieri e multilingue e riteniamo che ciò metta in pericolo la fiducia del pubblico.”

Erode la fiducia: il costo reale di un rallentamento incontrollato dell’intelligenza artificiale

Un flusso costante di disinformazione generata dall’intelligenza artificiale sta infliggendo danni tangibili all’ecosistema dell’informazione digitale. Per piattaforme fondamentali come Wikipedia, le conseguenze stanno diventando esistenziali.

La Wikimedia Foundation ha recentemente segnalato un sorprendente calo dell’8% nel traffico umano, accusando direttamente gli strumenti di ricerca e i chatbot basati sull’intelligenza artificiale per aver sottratto visitatori riassumendone i contenuti senza attribuzione.

Tale tendenza minaccia il modello guidato dai volontari dell’enciclopedia. Come ha avvertito Marshall Miller, Senior Director of Product di Wikimedia,”Con meno visite a Wikipedia, meno volontari potrebbero far crescere e arricchire i contenuti, e meno singoli donatori potrebbero supportare questo lavoro.”

Internamente, la piattaforma sta già combattendo una battaglia contro i contributi generati dall’intelligenza artificiale, che un volontario ha descritto come una”minaccia esistenziale”, spingendo la comunità ad adottare una politica di”cancellazione rapida”per rimuovere la parte peggiore.

Questi ripetuti fallimenti alla fine dare una lezione critica sullo stato attuale dell’intelligenza artificiale. La responsabilità degli errori non può essere scaricata sulla macchina.

Come ha notato Cassie Kozyrkov, ex responsabile decisionale di Google, dopo che un bot di supporto per l’editor di codice Cursor AI ha inventato una falsa politica aziendale,”Questo pasticcio avrebbe potuto essere evitato se i leader avessero capito che (1) l’intelligenza artificiale commette errori, (2) l’intelligenza artificiale non può assumersi la responsabilità di tali errori (quindi ricade su di te), e (3) gli utenti odiano essere ingannati da una macchina che si spaccia per essere umano.”

Cosa accaduto a Dawn è semplicemente l’ultimo promemoria del fatto che nell’era dell’intelligenza artificiale, lo strato finale e indispensabile del controllo di qualità rimane la diligente supervisione umana.