Google sta intensificando la sua offerta per il dominio dell’hardware AI. Giovedì, l’azienda ha annunciato che il suo chip personalizzato più potente, Ironwood TPU, sta diventando disponibile per i suoi clienti cloud.

Costruito per gestire la crescente domanda di inferenza AI, questo nuovo processore affronta il tempo reale lavorare dietro i chatbot. Per supportare questi sistemi di intelligenza artificiale, Google ha anche lanciato nuovi processori Axion convenienti per le attività informatiche quotidiane.

Questa mossa strategica si rivolge a clienti chiave come Anthropic e rafforza la sfida di Google al leader di mercato Nvidia nella battaglia critica per l’infrastruttura AI.

Ironwood: una potenza di silicio personalizzata per l’era dell’inferenza

Per alimentare la prossima generazione di modelli di intelligenza artificiale, Google scommette su una strategia integrata verticalmente.

Al centro di questo sforzo c’è la sua unità di elaborazione tensore di settima generazione, Ironwood, che è stata presentata per la prima volta ad aprile.

Ora prossimo alla disponibilità generale, il chip è costruito appositamente per quella che Google chiama”l’era dell’inferenza”, il passaggio dall’addestramento di modelli di grandi dimensioni all’implementazione di interazioni utili e reattive su larga scala.

Ironwood offre un significativo balzo in avanti in termini di prestazioni, progettato per gestire le complesse esigenze sia dell’addestramento che del servizio dei più grandi modelli di intelligenza artificiale di oggi.

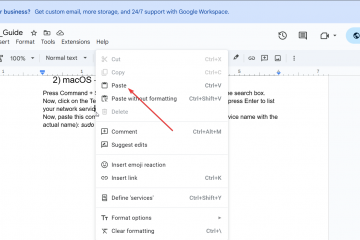

Secondo Google, la nuova architettura offre un Miglioramento delle prestazioni di picco di 10 volte rispetto al suo predecessore TPU v5p e prestazioni per chip più di quattro volte migliori rispetto alla precedente generazione Trillium.

Nella sua configurazione più grande, un sistema Ironwood può raggiungere l’incredibile cifra di 42,5 exaFLOPS della potenza di calcolo dell’8° PQ, un parametro essenziale per l’aritmetica a bassa precisione che domina i moderni carichi di lavoro dell’intelligenza artificiale.

Questa potenza pura è abbinata a un’attenzione all’efficienza; Ironwood vanta il doppio delle prestazioni per watt di Trillium, rendendolo il chip più efficiente di Google fino ad oggi.

Picco di flop per watt di Google TPU (fonte: Google)

Questo livello di prestazioni è utile solo se può essere scalato e l’architettura di Ironwood è progettata per un funzionamento massiccio e coeso.

Un singolo”superpod”Ironwood può collegare fino a 9.216 chip individuali, consentendo loro di funzionare come un singolo, unificato supercomputer. La base di questo sistema è un tessuto Inter-Chip Interconnect (ICI) ad alta velocità che fornisce fino a 9,6 terabit al secondo di larghezza di banda tra i chip, creando una densa topologia Torus 3D.

Questa rete consente ai chip di accedere a un colossale pool condiviso di 1,77 petabyte di memoria a larghezza di banda elevata (HBM), eliminando i colli di bottiglia dei dati che possono paralizzare i lavori di intelligenza artificiale su larga scala.

Per Per connettere questi cluster di chip, Google utilizza una rete dinamica di commutatori di circuiti ottici (OCS). Questo tessuto riconfigurabile è fondamentale sia per la scalabilità che per la resilienza.

Come dettagliato nella panoramica tecnica dell’azienda, l’OCS può bypassare otticamente qualsiasi hardware guasto e stabilire nuovi circuiti completi che collegano solo unità integre.

Google Architettura Ironwood TPU (Fonte: Google)

Per i clienti che eseguono lavori di formazione che possono durare settimane, questa tolleranza dinamica agli errori è una funzionalità fondamentale che previene costose interruzioni e massimizza il tempo di attività produttivo dell’intero sistema.

Fondamentalmente, questo hardware avanzato è profondamente integrato con uno stack software co-progettato basato su una filosofia di ottimizzazione a livello di sistema. Al centro c’è il compilatore Accelerated Linear Algebra (XLA) di Google, che traduce codice di alto livello da framework popolari come JAX e PyTorch in istruzioni macchina altamente ottimizzate.

Il compilatore è esplicitamente progettato per prendere di mira l’hardware specializzato del TPU, comprese le sue dense Matrix Multiply Units (MXU) e Vector Processing Units (VPU). Unendo automaticamente le operazioni in kernel efficienti, XLA fornisce potenti prestazioni”pronte all’uso”.

Per deduzione, l’azienda ha ulteriormente ottimizzato lo stack abilitando motori di servizio all’avanguardia come vLLM su Ironwood attraverso un nuovo sistema unificato backend, rendendo il suo immenso potere più accessibile agli sviluppatori che implementano modelli in produzione.

La spinta dell’hardware di Google è una componente di una strategia infrastrutturale molto più ampia e su più fronti.

In recenti rapporti abbiamo evidenziato alcuni dei piani ambiziosi di Google, da un data center AI geopoliticamente strategico sull’isola di Christmas in Australia al progetto Suncatcher”moonshot”, che mira a costruire data center alimentati da TPU nello spazio.

Le iniziative evidenziano risorse colossali necessarie per rimanere all’avanguardia nell’intelligenza artificiale.

[contenuto incorporato]

Espansione di Axion: ridefinire l’elaborazione generica

Oltre agli acceleratori specializzati per l’intelligenza artificiale, le applicazioni moderne richiedono una dorsale potente ed efficiente per i carichi di lavoro quotidiani.

Google sta affrontando questo problema con un’espansione del suo portafoglio di CPU Axion basate su Arm personalizzate. L’azienda ha annunciato che le sue nuove macchine virtuali N4A sono ora in anteprima, insieme all’imminente anteprima di C4A metal, le sue prime istanze bare metal basate su Arm.

Progettati per offrire un rapporto qualità-prezzo superiore, questi processori gestiscono le attività generiche che supportano le applicazioni AI, tra cui preparazione dei dati, microservizi containerizzati e servizi web.

Google CPU Axion (Fonte: Google)

I primi feedback dei clienti evidenziano vantaggi significativi. Sergei Koren, Chief Infrastructure Architect presso ZoomInfo, ha elogiato le nuove istanze, affermando:”Nella nostra anteprima delle nuove istanze N4A, abbiamo misurato un miglioramento del 60% in termini di rapporto prezzo-prestazioni per questi carichi di lavoro chiave rispetto alle loro controparti basate su x86.”

Allo stesso modo, Vimeo ha segnalato un miglioramento delle prestazioni del 30% per il suo carico di lavoro di transcodifica video principale rispetto alle VM basate su x86.

Google si sta posizionando Axion come alternativa chiara e più efficiente ai processori tradizionali.

Secondo Mark Lohmeyer, vicepresidente e direttore generale dell’infrastruttura di elaborazione e intelligenza artificiale di Google Cloud,”Avranno prestazioni superiori del 50% rispetto ai processori della generazione x86 comparabili e un’efficienza energetica migliore del 60% rispetto alle istanze basate su x86 comparabili.”

Adozioni strategiche e corsa agli armamenti dell’IA

Il massiccio impegno di Anthropic costituisce una potente conferma per il silicio personalizzato di Google. Il laboratorio di intelligenza artificiale, sviluppatore della famiglia di modelli Claude, prevede di accedere fino a 1 milione di TPU, segnalando una forte fiducia nelle capacità della piattaforma sia per l’addestramento che per l’inferenza.

James Bradbury, responsabile del calcolo dell’azienda, ha spiegato il vantaggio:”I miglioramenti di Ironwood sia nelle prestazioni di inferenza che nella scalabilità del training ci aiuteranno a scalare in modo efficiente mantenendo la velocità e l’affidabilità che i nostri clienti si aspettano.”

Eppure questo importante accordo esiste all’interno di una realtà complessa e multi-cloud. Sebbene la partnership rappresenti una vittoria significativa per Google, i rapporti chiariscono che Anthropic mantiene una strategia infrastrutturale diversificata, con Amazon Web Services che rimane il suo principale fornitore di servizi cloud.

Riflette una tendenza di settore più ampia in cui i principali laboratori di intelligenza artificiale stanno evitando la dipendenza da un singolo fornitore, una strategia vista in precedenza quando OpenAI ha iniziato a utilizzare Google Cloud per integrare la sua infrastruttura principale di Microsoft Azure.

Situandosi in un’intensa corsa agli armamenti di intelligenza artificiale, gli sforzi di Google sul silicio personalizzato sono mirati direttamente a sfidare il mercato di Nvidia. dominanza. Per competere sono necessari investimenti sbalorditivi.

Per soddisfare l’impennata della domanda, Google ha recentemente aumentato la parte alta della sua previsione di spesa in conto capitale per l’anno a 93 miliardi di dollari da 85 miliardi di dollari.

Un impegno finanziario così immenso dimostra che il controllo dell’hardware sottostante è ora visto come un vantaggio competitivo fondamentale.

Con l’implementazione sia dei TPU Ironwood altamente specializzati che delle CPU Axion efficienti e generiche, Google presenta un’offerta completa e soluzione co-progettata.

L’azienda scommette che offrire ai clienti uno stack hardware ottimizzato ed economicamente vantaggioso, dal chip al data center, sarà la chiave per vincere la prossima fase della rivoluzione dell’intelligenza artificiale.