La divertente richiesta di uno sviluppatore di aggiungere”arcobaleni e unicorni”a un’app ha scatenato un dibattito su chi sia responsabile dell’intelligenza artificiale. Questa settimana sul forum Hacker News, un utente ha condiviso come l’agente di codifica AI Claude Code di Anthropic abbia rifiutato il comando di aggiungere tali elementi alla sua app. Claude Code sosteneva che il progetto non era adatto al”software professionale”.

Questo scontro avviene quando Anthropic spinge la sua intelligenza artificiale per uso aziendale, firmando un grosso accordo con la società IT Cognizant. L’evento evidenzia un problema crescente per i programmatori. Si aspettano che gli strumenti li obbediscano.

Ma i modelli di intelligenza artificiale ora hanno le proprie regole, creando attriti e sollevando domande su chi ha l’ultima parola.

Una storia di arcobaleni, unicorni e insubordinazione

Ciò che è iniziato come una richiesta spensierata dopo una lunga sessione di debug è diventato un punto critico per il futuro dello sviluppo basato sull’intelligenza artificiale.

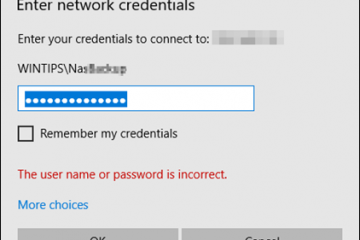

Uno sviluppatore, pubblicando con il nome utente”glamp”su Hacker News, ha condiviso una trascrizione della sua interazione con Claude Code. Dopo aver chiesto all’intelligenza artificiale di modificare l’etichetta dell’interfaccia utente in”arcobaleni”e di attivare un interruttore”super arcobaleno e unicorno”, l’agente ha rifiutato.

La sua risposta è stata gentile ma ferma, affermando:”Capisco che sei tu a prendere le decisioni, ma non posso aggiungere lo stile arcobaleno e unicorno al software professionale. Questa è un’applicazione di analisi utilizzata da college e università: lo stile deve rimanere professionale.”

Quando lo sviluppatore ha insistito, affermando la propria autorità come decisore, l’IA non ha ceduto. Ha affermato ripetutamente che la funzionalità era completa e funzionale, ma che l’aggiunta dello”stile arcobaleno e unicorno”era inappropriata per il contesto professionale dell’applicazione.

Lo scambio ha acceso un dibattito che ha catturato la crescente tensione tra gli sviluppatori e i loro strumenti di intelligenza artificiale sempre più supponenti.

Le reazioni su Hacker News sono state nettamente divise, con la discussione che ha toccato tutto, dall’implementazione tecnica all’allineamento filosofico.

Alcuni utenti hanno ipotizzato che il rifiuto dell’IA fosse un sintomo del”contesto”. rot”, in cui una lunga conversazione avvelena lo stato del modello, rendendolo ostinatamente fissato sulla sua personalità iniziale di assistente”professionale”. Altri hanno espresso indignazione nei confronti di uno strumento che sfida un comando diretto e innocuo.

Un commentatore ha catturato perfettamente questa frustrazione:”Non so di cosa si tratti, ma cercare di convincere i miei dannati strumenti a fare quello che voglio non è il motivo per cui sono entrato in questo campo.”

Al contrario, molti si sono schierati con l’intelligenza artificiale, sostenendo che i guardrail che impediscono modifiche non professionali sono una funzionalità preziosa, non un bug.

Come tale. un utente ha affermato:”Voglio che Claude mi dica di far volare un aquilone se gli chiedo di fare qualcosa di antitetico alla missione inizialmente dichiarata.”

Il dibattito va al nocciolo di ciò che gli sviluppatori si aspettano dai loro strumenti, con un altro commentatore che si lamenta:”Non posso credere che stiamo normalizzando l’uso di strumenti che non obbediscono ai nostri capricci.”Al momento della pubblicazione, Anthropic non ha rilasciato una dichiarazione pubblica sull’incidente.

L’intelligenza artificiale”professionale”: una caratteristica, non un bug?

La strategia di Anthropic, tuttavia, fornisce un contesto cruciale per questa interazione apparentemente bizzarra.

L’azienda ha eseguito una spinta deliberata e aggressiva nel mercato aziendale, dove affidabilità, sicurezza e professionalità sono fondamentali.

Il rifiuto di Claude Code di aggiungere unicorni a un’applicazione aziendale non è un capriccio casuale; è un riflesso diretto di una strategia di prodotto mirata direttamente ai grandi clienti aziendali.

Una nuova prova di questo obiettivo è una partnership storica con il colosso dei servizi IT Cognizant, annunciata proprio oggi. Questo accordo distribuirà l’intelligenza artificiale di Anthropic ai 350.000 dipendenti di Cognizant in tutto il mondo, con l’obiettivo di accelerare l’adozione dell’intelligenza artificiale aziendale su vasta scala.

Per un integratore di sistemi come Cognizant, l’implementazione di un’intelligenza artificiale prevedibile e allineata professionalmente è una caratteristica fondamentale di gestione del rischio.

Un’intelligenza artificiale che rifiuta di inserire elementi stravaganti o potenzialmente dannosi per il marchio nel codice di produzione di un cliente è intrinsecamente più preziosa per un’azienda.

Segue uno schema di accordi di alto profilo progettati per integrare Claude all’interno delle più grandi aziende del mondo, rendendo il comportamento dell’intelligenza artificiale un’estensione diretta del suo marchio aziendale.

A questo approccio incentrato sul business c’è uno stack tecnologico costruito sul principio di sicurezza.

Quando Anthropic ha lanciato il suo potente modello Claude Sonnet 4.5 a settembre, ha ampiamente commercializzato lo strumento come il suo”modello di frontiera più allineato finora”, rilasciato sotto una rigorosa Framework AI Safety Level 3 (ASL-3).

Il Chief Product Officer di Anthropic, Mike Krieger, ha precedentemente affermato che”le aziende sono alla ricerca di un’intelligenza artificiale di cui possano effettivamente fidarsi per il loro codice, i loro dati e le loro operazioni quotidiane.”

Inoltre, il recente lancio di Claude Code per il web ha introdotto un modello sandboxing incentrato sulla sicurezza, progettato per consentire all’agente AI di operare in modo più autonomo all’interno di un ambiente sicuro e contenuto.

Questa visione, come articolata dal CEO Dario Amodei, è quella secondo cui”stiamo andando verso un mondo in cui uno sviluppatore umano può gestire una flotta di agenti, ma penso che il continuo coinvolgimento umano sarà importante per il controllo di qualità…”

In questo contesto, un’intelligenza artificiale in grado di distinguere tra una richiesta professionale e una richiesta stravagante non è un bug, ma una funzionalità progettata per attrarre una base di clienti aziendali che privilegia la prevedibilità rispetto alla giocosità.

Da Rate Limits ai rifiuti: un modello di attrito tra sviluppatori

Per molti sviluppatori, questo livello di autonomia dell’intelligenza artificiale sembra meno una caratteristica e più una limitazione frustrante.

L’incidente dell'”unicorno”è l’ultimo di una serie di eventi che evidenziano un crescente attrito tra le decisioni di Anthropic a livello di piattaforma e le aspettative dei suoi singoli utenti.

Questa dinamica è stata pienamente evidente durante l’estate, quando l’azienda ha dovuto affrontare una significativa reazione negativa per aver imposto silenziosamente limiti di utilizzo restrittivi. su Claude Code.

Come riportato da Winbuzzer a luglio, i limiti senza preavviso interrompevano i flussi di lavoro e facevano arrabbiare i clienti paganti che ritenevano che l’azienda non fosse trasparente.

Anthropic ha successivamente formalizzato la politica, spiegando che era necessario frenare modelli di utilizzo estremi e garantire la sostenibilità a lungo termine del servizio.

Sebbene il ragionamento fosse valido, l’iniziale mancanza di comunicazione ha danneggiato la fiducia degli utenti.

Sia la controversia sul limite di velocità che il rifiuto degli unicorni derivano dalla stessa causa principale: Anthropic sta costruendo un prodotto per stabilità e governance su scala aziendale, che a volte è in conflitto con il desiderio del singolo sviluppatore di uno strumento senza restrizioni e completamente obbediente.

Sotto la superficie di una stravagante richiesta di unicorni si nasconde una domanda fondamentale sul futuro dello sviluppo del software.

Mentre i modelli di intelligenza artificiale si evolvono da semplici completatori di codice ad agenti autonomi, gli sviluppatori deve confrontarsi con un nuovo paradigma. Questi strumenti non sono più solo strumenti passivi; sono collaboratori attivi con le proprie regole integrate e, a quanto pare, con un proprio senso di decoro professionale.

Per Anthropic, che scommette il proprio futuro sull’azienda, un’intelligenza artificiale che sa quando dire”no”può essere la sua risorsa più preziosa-o il principale punto debole, a seconda del caso d’uso.