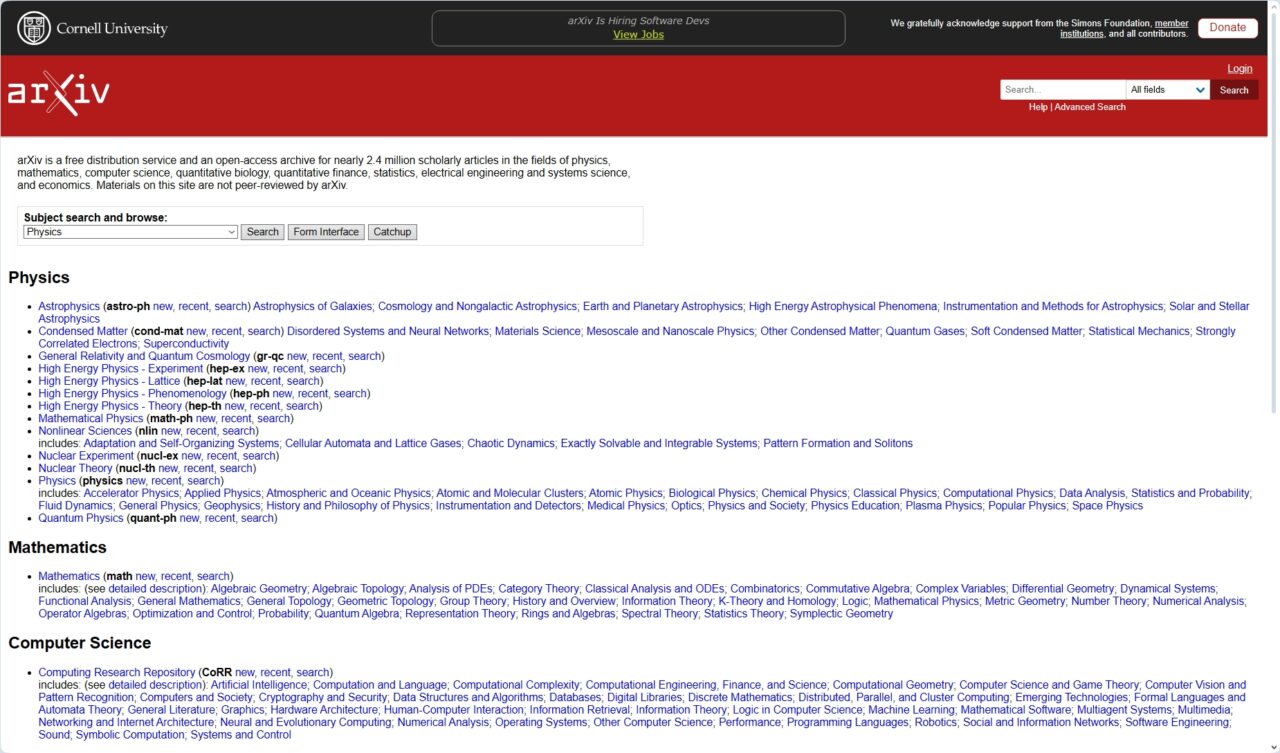

Di fronte a un diluvio di contenuti di bassa qualità generati dall’intelligenza artificiale, il server di prestampa accademico arXiv sta inasprendo le sue regole di invio per gli articoli di informatica.

In un annuncio del 31 ottobre, l’influente piattaforma ha dichiarato che la sua categoria Informatica (CS) non accetterà più articoli di revisione o documenti di sintesi a meno che non abbiano già superato la revisione tra pari in una rivista o conferenza riconosciuta.

La mossa è progettata per ridurre il carico sui moderatori volontari e affrontare direttamente un flusso di contributi che arXiv afferma essere”veloci e facili da scrivere”con l’intelligenza artificiale generativa ma spesso mancano di sostanza.

Un’ondata di”slop”generato dall’intelligenza artificiale

Nel tentativo di salvaguardare la qualità della ricerca, arXiv sta affrontando direttamente l’impatto dei grandi modelli linguistici sull’editoria accademica. La piattaforma è stata inondata di contributi, in particolare nella sua sezione di informatica in rapida evoluzione.

Secondo la sua dichiarazione ufficiale, il sito ora riceve”centinaia di articoli di revisione ogni mese”. Il suo volume è diventato ingestibile per il sistema di controllo della piattaforma.

Molte di queste proposte non soddisfano gli standard accademici di base. I moderatori di arXiv hanno scoperto che”la maggior parte degli articoli di revisione che riceviamo sono poco più che bibliografie annotate, senza discussioni sostanziali su questioni di ricerca aperte.”

Tali articoli contribuiscono al rumore accademico, facendo perdere tempo ai ricercatori alla ricerca di nuovi approfondimenti. Tale facilità di produzione ha portato a una notevole pressione sugli esperti volontari che esaminano gli articoli.

Come ha spiegato arXiv,”l’intelligenza artificiale generativa e i modelli linguistici di grandi dimensioni hanno contribuito a questo flusso rendendo gli articoli, in particolare quelli che non introducono nuovi risultati di ricerca, veloci e facili da scrivere.”

Questa ondata di contenuti a basso sforzo minaccia di seppellire la ricerca legittima e diluire il valore della piattaforma.

Anche gli strumenti sofisticati che consentono questo flusso stanno crescendo di numero. e capacità. Documenti recenti, come uno che descrive un assistente di ricerca sull’intelligenza artificiale multi-agente, dimostrano una tecnologia in grado di automatizzare l’intero processo di scrittura accademica dall’ideazione alla stesura.

Questa tecnologia rende banale generare revisioni della letteratura apparentemente plausibili ma in definitiva vuote, esacerbando il problema che arXiv sta ora cercando di risolvere. Richiedere una revisione preventiva tra pari funge da filtro cruciale, esternalizzando il controllo di qualità iniziale a riviste e conferenze affermate.

Un sistema sotto pressione

Sebbene il cambiamento di politica sia nuovo, il problema di fondo non lo è. Il processo di revisione tra pari accademica è in difficoltà da anni con una cultura del tipo”pubblica o perisci”che incentiva la quantità rispetto alla qualità.

Esperti come Satoshi Tanaka dell’Università farmaceutica di Kyoto hanno sostenuto che il processo di revisione tra pari nel mondo accademico”è in crisi”.

Aggravando la situazione La crisi è il numero limitato di revisori volontari, sopraffatti dal numero di proposte. Questa stanchezza crea una vulnerabilità che gli strumenti di intelligenza artificiale, sia nel bene che nel male, stanno iniziando a sfruttare.

arXiv è stato in passato al centro di dibattiti sull’intelligenza artificiale e sull’integrità accademica. L’anno scorso, i ricercatori sono stati addirittura trovati a incorporare comandi nascosti nei loro documenti per manipolare i sistemi di revisione basati sull’intelligenza artificiale, una pratica nota come pronta iniezione.

Nascondendo le istruzioni in testo bianco o caratteri microscopici, gli autori hanno tentato di ingannare i sistemi automatizzati per far sì che fornissero feedback positivi. Quell’incidente ha evidenziato la facilità con cui i sistemi automatizzati potrebbero essere ingannati, minando l’intero processo di revisione.

La sfumatura nel recente cambiamento di arXiv è stata persino fonte di confusione, con alcuni organi di informazione che inizialmente hanno riportato erroneamente la portata della nuova regola.

Non una nuova politica, ma un’applicazione necessaria

Citando un afflusso ingestibile di contributi, i funzionari di arXiv hanno chiarito che il cambiamento è più un’azione di applicazione che una nuova politica.

Articoli di revisione e documenti di sintesi non sono mai stati tipi di contenuto ufficialmente accettati, ma erano storicamente consentiti a discrezione del moderatore quando erano di alta qualità e interesse accademico.

Una recente esplosione di volume, guidata dall’intelligenza artificiale, ha semplicemente reso questo approccio discrezionale insostenibile. Proteggere il tempo di questi moderatori volontari, il fondamento del sistema di prestampa, è essenziale.

Le linee guida della piattaforma arXiv affermano che gli autori umani sono pienamente responsabili per qualsiasi contenuto prodotto dagli strumenti di intelligenza artificiale e vietano esplicitamente di elencare un’intelligenza artificiale come coautore.

L’adozione di questa nuova pratica di moderazione per la categoria CS è un’estensione logica di questo principio, rafforzando il fatto che la convalida guidata dall’uomo rimane fondamentale. Gli editori di tutto il settore sono alle prese con questo problema, creando policy frammentate.

Mentre alcuni consentono un uso limitato dell’IA, altri come Elsevier lo hanno completamente vietato, citando il”rischio che la tecnologia generi errate, incomplete o distorte”. conclusioni.”

Guardando al futuro, la piattaforma ha indicato che altre discipline potrebbero vedere cambiamenti simili. Nel suo annuncio, arXiv ha osservato:”Se altre categorie vedono un aumento simile negli articoli di revisione e nei documenti di sintesi scritti da LLM, potrebbero scegliere di modificare le loro pratiche di moderazione in modo simile…”

Tale mossa suggerisce un potenziale cambiamento a livello di piattaforma se l’ondata di contenuti generati dall’intelligenza artificiale continua a diffondersi. Posiziona la mossa di arXiv non come una soluzione isolata, ma come un potenziale indicatore di come l’intera comunità scientifica sarà costretta ad adattarsi alle sfide e alle tentazioni dell’IA generativa.