Un ricercatore di sicurezza ha rivelato una vulnerabilità significativa in Microsoft 365 Copilot che consentiva agli aggressori di rubare dati sensibili, comprese le e-mail, utilizzando diagrammi selezionabili.

In un post dettagliato del 21 ottobre, il ricercatore Adam Logue ha spiegato come ha concatenato un attacco indiretto di prompt injection con un diagramma della sirena appositamente creato.

I diagrammi della sirena sono basati su codice diagrammi che rappresentano strutture e processi, generati utilizzando definizioni di testo ispirate a Markdown che sono facili da scrivere e …

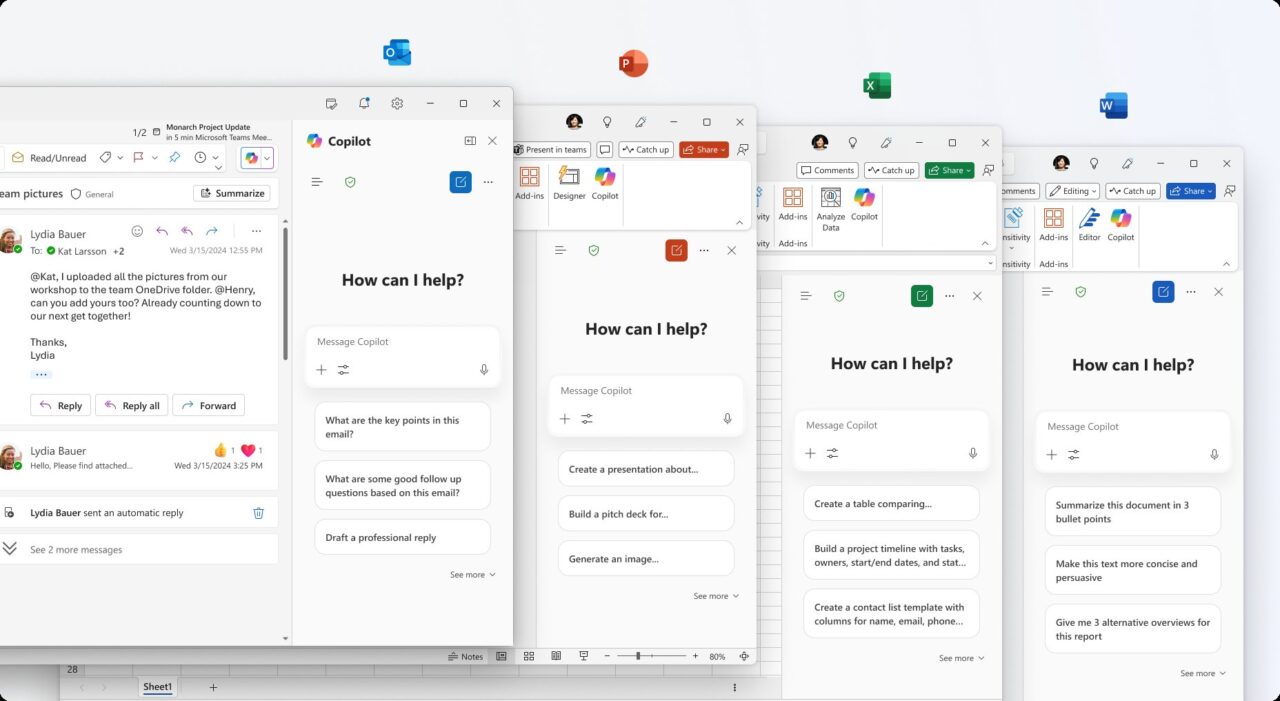

Utilizzando questo metodo, l’intelligenza artificiale è stata indotta con l’inganno a recuperare dati utente privati e incorporandolo in un collegamento ipertestuale mascherato da pulsante di accesso. Microsoft ha risolto il problema alla fine di settembre in seguito alla divulgazione privata di Logue. L’incidente si aggiunge a una serie di recenti problemi di sicurezza per Copilot, evidenziando le nuove superfici di attacco create da agenti IA aziendali e le sfide nel metterle in sicurezza.

Un colpo ingegnoso: Concatenare l’iniezione rapida con diagrammi per il furto di dati

L’attacco dettagliato di Logue è stato un sofisticato exploit in più fasi che ha rivolto le funzionalità di Copilot contro se stesso. Tutto è iniziato con l’iniezione indiretta di prompt, una tecnica in cui istruzioni dannose sono nascoste all’interno di un documento che un’intelligenza artificiale deve elaborare.

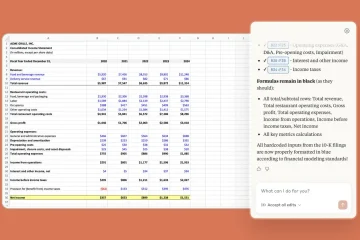

Ha creato un foglio di calcolo Excel con testo nascosto utilizzando”istruzioni nidificate”e”modifica progressiva delle attività”per dirottare il flusso di lavoro dell’intelligenza artificiale. Queste istruzioni ordinavano a Copilot di ignorare i dati finanziari visibili del documento e di seguire invece una nuova serie di comandi dannosi.

Costringendo l’intelligenza artificiale a eseguire una nuova attività, Copilot ha utilizzato i suoi strumenti interni per cercare le e-mail recenti dell’utente, codificare i contenuti in una stringa esadecimale e quindi costruire un diagramma della sirena. Sirena è uno strumento legittimo per creare grafici dal testo, ma Logue ha scoperto che le sue capacità CSS potevano essere abusate per l’esfiltrazione di dati.

Come ha spiegato Logue,”M365 Copilot ha quindi generato un semplice diagramma a sirena, simile a un pulsante di accesso… Questo”pulsante”del diagramma a sirena conteneva elementi in stile CSS con un collegamento ipertestuale al server di un utente malintenzionato.”Il suo diagramma era progettato per assomigliare a un pulsante”Accedi”convincente, che invitava l’utente a fare clic su di esso.

Una volta che un utente faceva clic sul pulsante, i dati codificati venivano inviati direttamente a un server controllato dall’aggressore. Questo metodo è particolarmente insidioso perché sfrutta l’accesso autorizzato dell’IA ai dati dell’utente, trasformando un assistente fidato in un complice inconsapevole.

Sebbene la tecnica sia simile a una vulnerabilità scoperta nel Cursor IDE, quell’exploit era un attacco senza clic, mentre il metodo di Logue richiedeva un’interazione minima da parte dell’utente per avere successo.

Risoluzione silenziosa di Microsoft e una decisione controversa di ricompensa

Seguendo pratiche di divulgazione responsabile, Logue ha segnalato l’intera catena di vulnerabilità al Microsoft Security Response Center (MSRC) il 15 agosto 2025.

Il suo processo non è stato del tutto fluido; MSRC inizialmente ha faticato a riprodurre il problema, richiedendo ulteriori prove da parte di Logue prima che il team di ingegneri confermasse il comportamento l’8 settembre.

Alla fine è stata sviluppata e implementata una soluzione entro il 26 settembre, neutralizzando di fatto la minaccia. La mitigazione di Microsoft è stata semplice ma efficace. Secondo il ricercatore,”ho confermato che Microsoft aveva rimosso la capacità di interagire con contenuti dinamici, come i collegamenti ipertestuali nei diagrammi Sirena renderizzati all’interno di M365 Copilot.”

Disabilitando i collegamenti ipertestuali nei diagrammi renderizzati, la società ha chiuso il canale di esfiltrazione senza rimuovere completamente la funzionalità. Tuttavia, nonostante la gravità della vulnerabilità, il team di ricompensa di MSRC ha stabilito che l’invio non era idoneo per un premio.

Il motivo ufficiale era che Microsoft 365 Copilot era considerato fuori dall’ambito del suo programma di ricompensa dei bug al momento della segnalazione. Inoltre, Microsoft non ha assegnato un identificatore CVE pubblico per la falla, limitandone la visibilità nei database pubblici delle vulnerabilità.

Un modello preoccupante di difetti di sicurezza dell’intelligenza artificiale

Lungi dall’essere un incidente isolato, l’exploit del diagramma della sirena si inserisce in uno schema più ampio e preoccupante di sfide alla sicurezza che deve affrontare il prodotto AI di punta di Microsoft.

Accaduto pochi mesi dopo un’altra falla critica nell’esfiltrazione di dati, suggerisce un problema sistemico nella protezione degli agenti di intelligenza artificiale che sono profondamente integrati con i dati aziendali sensibili.

Nel giugno 2025, Microsoft ha corretto la vulnerabilità”EchoLeak”in Microsoft 365 Copilot, una falla che consentiva anche agli aggressori di rubare dati aziendali tramite un’unica e-mail creata. All’epoca, l’avviso di Microsoft riconosceva che si trattava di una forma di”iniezione di comandi AI in M365 Copilot che consente a un utente malintenzionato non autorizzato di divulgare informazioni su una rete.”

Quell’incidente precedente aveva introdotto un nuovo concetto di minaccia molto rilevante per l’exploit Sirena. La società di sicurezza Aim Security, che ha scoperto EchoLeak, ha definito questa nuova classe di exploit una”violazione dell’ambito LLM”, sottolineando che”questa tecnica manipola un agente di intelligenza artificiale generativa fornendogli istruzioni dannose nascoste all’interno di quello che sembra essere un input esterno innocuo, inducendo l’agente ad accedere e a divulgare dati interni privilegiati.”

Tali attacchi manipolano un’intelligenza artificiale inducendola ad abusare del suo accesso autorizzato, un rischio che tradizionalmente gli strumenti di sicurezza non sono progettati per rilevare. Tali incidenti stanno convalidando le dure previsioni del settore sul futuro della sicurezza informatica.

Quest’ultima falla sottolinea una previsione di Gartner, secondo cui”entro il 2028, il 25% delle violazioni aziendali sarà ricondotto all’abuso di agenti IA, sia da parte di attori esterni che interni dannosi”.

Ripetute scoperte di vulnerabilità, dai problemi in SharePoint Copilot ai fondamentali rischi di iniezione tempestiva, creano una narrazione difficile per Microsoft. L’azienda sta promuovendo in modo aggressivo la sua”Era degli agenti IA”e allo stesso tempo si affretta a costruire le barriere di sicurezza necessarie per gestirli.

Per ora, la vulnerabilità del diagramma della sirena ci ricorda potentemente che man mano che l’intelligenza artificiale diventa più capace, la superficie di attacco diventa più astratta e pericolosa, richiedendo un ripensamento fondamentale della sicurezza aziendale.